>本文探讨了小语言模型(SLM)在实体提取,至关重要的自然语言处理(NLP)任务中的功能。 它比较了Gemma 2b,Llama 3.2(1B和3B版本)的性能,以及QWEN 7B在识别和分类的实体,例如人,组织和位置在非结构化文本中。 这篇文章强调了SLM的优势而不是传统方法,强调了它们的上下文理解和效率。

>将SLM用于实体提取的核心优势是它们解释围绕单词的上下文的能力,与基于规则或旧的机器学习方法相比,更准确的实体识别。这种上下文意识大大降低了由模棱两可的术语引起的错误。>

>本文提供了每个SLM的详细概述:

-

gemma 2b:

一个Google开发的模型,具有20亿个参数,8192令牌上下文长度和仅解码器的变压器体系结构。 它的培训数据包括Web文档,代码和数学文本。> - LLAMA 3.2(1b&3b):

Meta的多语言模型,分别提供123亿和32亿参数的版本。 两者都拥有128,000个令牌的上下文长度,并针对多语言对话进行了优化。

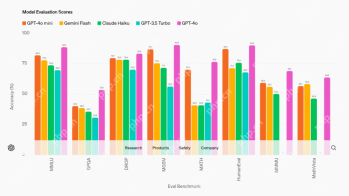

> QWEN 7B:使用Google Colab和Ollama进行的实际演示展示了实施和评估过程。 本文详细介绍了所涉及的步骤:安装库,运行Ollama,获取数据并调用模型。 每个模型的样本输出都在视觉上呈现。> 描述了一个严格的评估框架,重点是不同类别(项目,公司,人)的实体提取的准确性。 比较表总结了每个模型的性能,揭示了Gemma 2b是最准确的总体,尽管Llama 3.2 3b显示了识别人的力量。

>结论重申了SLM在实体提取中的出色表现,强调了上下文理解和适应性的重要性。 本文以FAQ部分结束,介绍了有关SLM的常见问题和讨论的具体模型。

以上是Gemma 2B vs Llama 3.2 vs Qwen 7b的详细内容。更多信息请关注PHP中文网其他相关文章!

如何使用LM Studio在本地运行LLM? - 分析VidhyaApr 19, 2025 am 11:38 AM

如何使用LM Studio在本地运行LLM? - 分析VidhyaApr 19, 2025 am 11:38 AM轻松在家运行大型语言模型:LM Studio 使用指南 近年来,软件和硬件的进步使得在个人电脑上运行大型语言模型 (LLM) 成为可能。LM Studio 就是一个让这一过程变得轻松便捷的优秀工具。本文将深入探讨如何使用 LM Studio 在本地运行 LLM,涵盖关键步骤、潜在挑战以及在本地拥有 LLM 的优势。无论您是技术爱好者还是对最新 AI 技术感到好奇,本指南都将提供宝贵的见解和实用技巧。让我们开始吧! 概述 了解在本地运行 LLM 的基本要求。 在您的电脑上设置 LM Studi

盖伊·佩里(Guy Peri)通过数据转换帮助麦考密克的未来Apr 19, 2025 am 11:35 AM

盖伊·佩里(Guy Peri)通过数据转换帮助麦考密克的未来Apr 19, 2025 am 11:35 AM盖伊·佩里(Guy Peri)是麦考密克(McCormick)的首席信息和数字官。尽管他的角色仅七个月,但Peri正在迅速促进公司数字能力的全面转变。他的职业生涯专注于数据和分析信息

迅速工程中的情感链是什么? - 分析VidhyaApr 19, 2025 am 11:33 AM

迅速工程中的情感链是什么? - 分析VidhyaApr 19, 2025 am 11:33 AM介绍 人工智能(AI)不仅要理解单词,而且要理解情感,从而以人的触感做出反应。 这种复杂的互动对于AI和自然语言处理的快速前进的领域至关重要。 Th

12个最佳数据科学工作流程的AI工具-Analytics VidhyaApr 19, 2025 am 11:31 AM

12个最佳数据科学工作流程的AI工具-Analytics VidhyaApr 19, 2025 am 11:31 AM介绍 在当今以数据为中心的世界中,利用先进的AI技术对于寻求竞争优势和提高效率的企业至关重要。 一系列强大的工具使数据科学家,分析师和开发人员都能构建,Depl

AV字节:OpenAI的GPT-4O Mini和其他AI创新Apr 19, 2025 am 11:30 AM

AV字节:OpenAI的GPT-4O Mini和其他AI创新Apr 19, 2025 am 11:30 AM本周的AI景观爆炸了,来自Openai,Mistral AI,Nvidia,Deepseek和Hugging Face等行业巨头的开创性发行。 这些新型号有望提高功率,负担能力和可访问性,这在TR的进步中推动了

报告发现,困惑的Android应用程序有安全缺陷。Apr 19, 2025 am 11:24 AM

报告发现,困惑的Android应用程序有安全缺陷。Apr 19, 2025 am 11:24 AM但是,该公司的Android应用不仅提供搜索功能,而且还充当AI助手,并充满了许多安全问题,可以将其用户暴露于数据盗用,帐户收购和恶意攻击中

每个人都擅长使用AI:关于氛围编码的想法Apr 19, 2025 am 11:17 AM

每个人都擅长使用AI:关于氛围编码的想法Apr 19, 2025 am 11:17 AM您可以查看会议和贸易展览中正在发生的事情。您可以询问工程师在做什么,或咨询首席执行官。 您看的任何地方,事情都以惊人的速度发生变化。 工程师和非工程师 有什么区别

火箭发射模拟和分析使用Rocketpy -Analytics VidhyaApr 19, 2025 am 11:12 AM

火箭发射模拟和分析使用Rocketpy -Analytics VidhyaApr 19, 2025 am 11:12 AM模拟火箭发射的火箭发射:综合指南 本文指导您使用强大的Python库Rocketpy模拟高功率火箭发射。 我们将介绍从定义火箭组件到分析模拟的所有内容

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

SublimeText3汉化版

中文版,非常好用

EditPlus 中文破解版

体积小,语法高亮,不支持代码提示功能

Atom编辑器mac版下载

最流行的的开源编辑器

禅工作室 13.0.1

功能强大的PHP集成开发环境