jina嵌入式V2:革命性的长期文本嵌入

当前的文本嵌入模型(例如BERT)受到512 token处理限制的限制,从而阻碍了他们的冗长文档的性能。 这种限制通常会导致背景损失和不准确的理解。 Jina Embeddings V2通过支持8192代币,保留关键环境并显着提高所处理信息在广泛文本中的准确性和相关性,从而超过了这一限制。这代表了处理复杂文本数据的重大进步。关键学习点

- 在处理长文档时,了解传统模型等传统模型的局限性。

- >学习Jina嵌入式V2如何通过其8192 token的容量和高级体系结构来克服这些限制。

- 在法律研究,内容管理和生成AI中发现现实世界的应用 >在使用拥抱的面部图书馆将Jina Embeddings V2整合到项目中的实用经验。

- >本文是数据科学博客马拉松的一部分。

表

嵌入长文档的挑战建筑创新和培训方法

性能评估- 现实世界应用

- 模型比较

- 使用Jina Embeddings v2与拥抱的脸

- 结论

- 常见问题

- 嵌入长文档的挑战

- > 处理长文件在自然语言处理(NLP)中提出了重大挑战。传统方法在细分市场中处理文本,导致上下文截断和碎片嵌入,这些嵌入方式歪曲了原始文档。这将导致:

增加的计算需求

更高的内存消耗降低了需要全面了解文本的任务的性能

-

Jina Embeddings V2通过将令牌限制提高到

- ,无需过度细分并维护文档的语义完整性。

- 建筑创新和培训方法

- Jina Embeddings V2通过最先进的创新增强了Bert的功能:

- >带有线性偏见(alibi)的注意:

- 封闭式线性单元(GLU):

glu,以提高变压器效率而闻名,用于进料层中。 Geglu和Reglu等变体用于根据模型大小来优化性能。 > 优化培训: -

>预读:

- >使用蒙版语言建模(MLM)在巨大的清洁爬行语料库(C4)上进行训练。

- > 与文本对进行微调:对语义上相似的文本对的嵌入。 硬性负面微调:

- 通过纳入挑战性的分心示例来改善排名和检索。 >记忆效率训练:

- 混合精度训练和激活检查点等技术可确保对较大批量尺寸的可伸缩性,对于对比度学习至关重要。

- 在软玛克斯操作之前,

m ,使其计算多样化。 该模型使用编码器变体,其中所有令牌彼此参与,与语言建模中使用的因果变体不同。

- >在诸如nordationqa之类的任务中擅长,其中完整的文档上下文至关重要。> 长文档处理:

- 即使使用8192 token序列也保持MLM精度。

-

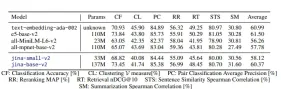

此图表比较跨检索和聚类任务的嵌入模型性能。

>现实世界应用程序

- >法律和学术研究:

是搜索和分析法律文件和学术论文的理想选择。 内容管理系统: - 有效的标记,聚类和大型文档存储库的检索。 >生成ai:

- >增强了AI生成的摘要和及时的基于及时的模型。 >电子商务: >改进产品搜索和推荐系统。

- > 模型比较

Jina Embeddings V2不仅在处理长序列方面,而且在与OpenAI的Text-ex-embedding-dada-002等专有模型竞争中脱颖而出。 它的开源性质可确保可访问性。

使用jina嵌入式v2与拥抱的脸步骤1:安装

>步骤2:使用jina嵌入与变压器

!pip install transformers !pip install -U sentence-transformers

输出:

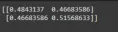

import torch from transformers import AutoModel from numpy.linalg import norm cos_sim = lambda a, b: (a @ b.T) / (norm(a) * norm(b)) model = AutoModel.from_pretrained('jinaai/jina-embeddings-v2-base-en', trust_remote_code=True) embeddings = model.encode(['How is the weather today?', 'What is the current weather like today?']) print(cos_sim(embeddings, embeddings))处理长序列:

>步骤3:使用jina嵌入与句子转换器

embeddings = model.encode(['Very long ... document'], max_length=2048)

(提供了使用库的类似代码,以及设置的说明。)>

结论sentence_transformersmax_seq_length Jina Embeddings V2是NLP的重大进步,有效地解决了处理长文件的局限性。 它的功能改善了现有的工作流,并解锁了使用长形式文本的新可能性。

Jina Embeddings V2是NLP的重大进步,有效地解决了处理长文件的局限性。 它的功能改善了现有的工作流,并解锁了使用长形式文本的新可能性。

键外观(原始结论中总结了关键点)>

>常见问题

(汇总了常见问题的答案)

注意:图像以其原始格式和位置保留。 - >法律和学术研究:

绩效评估

Jina Embeddings V2在各种基准测试中实现最新性能,包括大量的文本嵌入基准(MTEB)和新的长期数据集。 关键结果包括:

分类:

亚马逊极性和有毒对话分类等任务中的最高准确性。

在分组相关文本(PatentClustering和WikicitiesClustering)中优于竞争者。

- 检索:

以上是Jina Embeddings V2:处理长文件很容易的详细内容。更多信息请关注PHP中文网其他相关文章!

个人黑客将是一只非常凶猛的熊May 11, 2025 am 11:09 AM

个人黑客将是一只非常凶猛的熊May 11, 2025 am 11:09 AM网络攻击正在发展。 通用网络钓鱼电子邮件的日子已经一去不复返了。 网络犯罪的未来是超个性化的,利用了容易获得的在线数据和AI来制作高度针对性的攻击。 想象一个知道您的工作的骗子

教皇狮子座XIV揭示了AI如何影响他的名字选择May 11, 2025 am 11:07 AM

教皇狮子座XIV揭示了AI如何影响他的名字选择May 11, 2025 am 11:07 AM新当选的教皇狮子座(Leo Xiv)在对红衣主教学院的就职演讲中,讨论了他的同名人物教皇里奥XIII的影响,他的教皇(1878-1903)与汽车和汽车和汽车公司的黎明相吻合

Fastapi -MCP初学者和专家教程-Analytics VidhyaMay 11, 2025 am 10:56 AM

Fastapi -MCP初学者和专家教程-Analytics VidhyaMay 11, 2025 am 10:56 AM本教程演示了如何使用模型上下文协议(MCP)和FastAPI将大型语言模型(LLM)与外部工具集成在一起。 我们将使用FastAPI构建一个简单的Web应用程序,并将其转换为MCP服务器,使您的L

dia-1.6b tts:最佳文本到二元格生成模型 - 分析vidhyaMay 11, 2025 am 10:27 AM

dia-1.6b tts:最佳文本到二元格生成模型 - 分析vidhyaMay 11, 2025 am 10:27 AM探索DIA-1.6B:由两个本科生开发的开创性的文本对语音模型,零资金! 这个16亿个参数模型产生了非常现实的语音,包括诸如笑声和打喷嚏之类的非语言提示。本文指南

AI可以使指导比以往任何时候都更有意义May 10, 2025 am 11:17 AM

AI可以使指导比以往任何时候都更有意义May 10, 2025 am 11:17 AM我完全同意。 我的成功与导师的指导密不可分。 他们的见解,尤其是关于业务管理,构成了我的信念和实践的基石。 这种经验强调了我对导师的承诺

AI发掘了采矿业的新潜力May 10, 2025 am 11:16 AM

AI发掘了采矿业的新潜力May 10, 2025 am 11:16 AMAI 增强型矿业设备 矿业作业环境恶劣且危险重重。人工智能系统通过将人类从最危险的环境中移除并增强人类能力,帮助提高整体效率和安全性。人工智能越来越多地用于为矿业作业中使用的自动驾驶卡车、钻机和装载机提供动力。 这些 AI 驱动的车辆能够在危险环境中精确作业,从而提高安全性和生产力。一些公司已经开发出用于大型矿业作业的自动驾驶采矿车辆。 在挑战性环境中运行的设备需要持续维护。然而,维护会使关键设备离线并消耗资源。更精确的维护意味着昂贵且必要的设备的正常运行时间增加以及显着的成本节约。 AI 驱动

为什么AI代理会触发25年来最大的工作场所革命May 10, 2025 am 11:15 AM

为什么AI代理会触发25年来最大的工作场所革命May 10, 2025 am 11:15 AMSalesforce首席执行官Marc Benioff预测了由AI代理商驱动的巨大的工作场所革命,这是Salesforce及其客户群中已经进行的转型。 他设想从传统市场转变为一个较大的市场,重点是

随着AI采用的飙升,人力资源将摇滚我们的世界May 10, 2025 am 11:14 AM

随着AI采用的飙升,人力资源将摇滚我们的世界May 10, 2025 am 11:14 AM人力资源中AI的崛起:与机器人同事一起导航劳动力 将人工智能集成到人力资源(HR)不再是未来派的概念。它正在迅速成为新现实。 这种转变影响了人力资源专业人员和员工,DEM

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

SublimeText3汉化版

中文版,非常好用

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

SecLists

SecLists是最终安全测试人员的伙伴。它是一个包含各种类型列表的集合,这些列表在安全评估过程中经常使用,都在一个地方。SecLists通过方便地提供安全测试人员可能需要的所有列表,帮助提高安全测试的效率和生产力。列表类型包括用户名、密码、URL、模糊测试有效载荷、敏感数据模式、Web shell等等。测试人员只需将此存储库拉到新的测试机上,他就可以访问到所需的每种类型的列表。

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

Jina Embeddings V2是NLP的重大进步,有效地解决了处理长文件的局限性。 它的功能改善了现有的工作流,并解锁了使用长形式文本的新可能性。

Jina Embeddings V2是NLP的重大进步,有效地解决了处理长文件的局限性。 它的功能改善了现有的工作流,并解锁了使用长形式文本的新可能性。