如何在3分钟内在本地运行QWEN2.5型号?

- Joseph Gordon-Levitt原创

- 2025-03-07 09:48:11631浏览

> QWEN2.5-MAX:一种经济高效的,类人类的推理大语言模型

> AI景观嗡嗡作响,具有强大的,具有成本效益的模型,例如DeepSeek,Mistral Small 3和Qwen2.5最大。 尤其是QWEN2.5-MAX作为一个有效的专家(MOE)模型,甚至在某些基准测试中表现优于DeepSeek V3。它的高级体系结构和大规模的培训数据集(多达18万亿个代币)正在为性能设定新的标准。本文探讨了QWEN2.5-MAX的架构,其竞争优势以及与DeepSeek V3相比的潜力。我们还将指导您在本地运行QWEN2.5型号。

键qwen2.5模型特征:

- 多语言支持:支持超过29种语言。

- 扩展上下文:处理最高128K令牌的长上下文。

- 增强功能:在编码,数学,指导下和结构化数据理解方面的显着改进。

>目录表:

- 键qwen2.5模型特征

- >与ollama一起使用qwen2.5> > qwen2.5:7b推理

- > qwen2.5编码:3b推理

- 结论

首先,安装ollama:linux/ubuntu用户:

curl -fsSL https://ollama.com/install.sh | sh

>

> qwen2.5:7b推理:

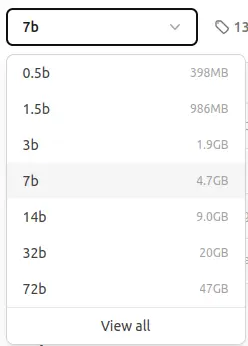

ollama pull qwen2.5:7b>

命令将下载该模型。 您会看到与此类似的输出:pull

<code>pulling manifest pulling 2bada8a74506... 100% ▕████████████████▏ 4.7 GB ... (rest of the output) ... success</code>

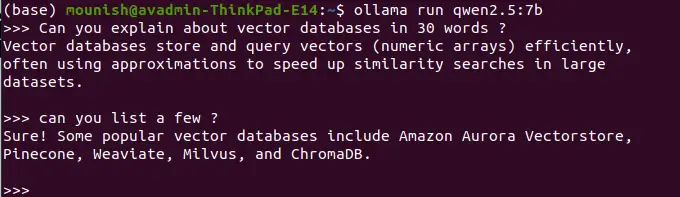

ollama run qwen2.5:7b

>示例查询:

>示例查询:

>用30个单词定义矢量数据库。

<code>Vector databases efficiently store and query numerical arrays (vectors), often using approximations for fast similarity searches in large datasets.</code>提示:

列出一些示例。>

<code>Popular vector databases include Pinecone, Weaviate, Milvus, ChromaDB, and Amazon Aurora Vectorstore.</code>(按CTRL D到退出)

> 注意:本地运行的型号缺乏实时访问和Web搜索功能。 例如:

提示:>今天的日期是什么?>

<code>Today's date is unavailable. My knowledge is not updated in real-time.</code>

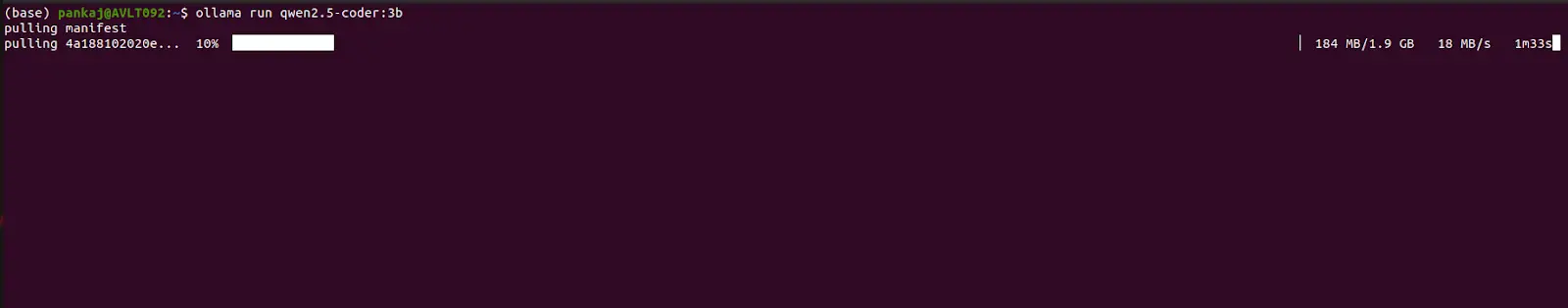

> QWEN2.5编码:3B推理:

> QWEN2.5编码:3B推理:

和

>命令中替换

qwen2.5-coder:3bqwen2.5:7b pull

run>示例编码提示:

提示:>提供fibonacci序列的Python代码。

(输出:fibonacci序列的Python代码将在此处显示) >提示:

使用Python函数创建一个简单的计算器。>(输出:将在此处显示一个简单计算器的Python代码)

结论:本指南演示了如何使用Ollama在本地运行QWEN2.5模型,突出了QWEN2.5-MAX的优势:128K上下文长度,多语言支持和增强的功能。 尽管本地执行可以提高安全性,但它牺牲了实时信息访问。 Qwen2.5在效率,安全性和性能之间提供了令人信服的平衡,使其成为各种AI应用程序的DeepSeek V3的强大替代品。 有关通过Google Colab访问QWEN2.5-MAX的更多信息可在单独的资源中获得。

以上是如何在3分钟内在本地运行QWEN2.5型号?的详细内容。更多信息请关注PHP中文网其他相关文章!