DeepSeek推出了FlashMLA

- Joseph Gordon-Levitt原创

- 2025-03-03 18:10:10306浏览

DeepSeek开创性的开源版本:CUDA内核加速LLMS。 这种优化的多立体注意(MLA)解码内核(专为料斗GPU设计)显着提高了AI模型托管的速度和效率。 关键改进包括BF16支持和分类的KV缓存(64座尺寸),从而产生了令人印象深刻的性能基准。

? #opensourceweek的第一天:flashmlaDeepSeek自豪地推出了Flashmla,这是霍珀GPU的高效MLA解码内核。针对可变长度序列进行了优化,现在正在生产中。

✅bf16支持

✅分页kv缓存(块尺寸64)3000 GB/S内存和580个TFLOPS…

- DeepSeek(@Deepseek_ai)2025年2月24日

密钥功能:

bf16精度:

在保持数值稳定性的同时启用有效的计算。- >分类的KV缓存(64块尺寸):提高记忆效率并降低潜伏期,尤其是大型模型至关重要的。

- 使用CUDA 12.6,在H800 SXM5 GPU上,这些优化在计算结合的方案中最多可实现3000 GB/S内存带宽和580个TFLOPS。 这显着改善了AI推理性能。 以前在DeepSeek模型中使用,FlashMLA现在加速了DeepSeek AI的R1 V3。

目录的表:

什么是flashmla?

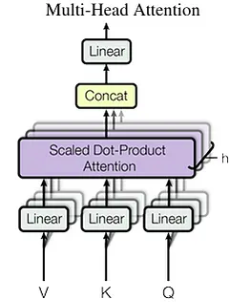

了解多头潜在注意力(MLA) 标准的多头注意力限制

- MLA的内存优化策略

-

- 键值缓存和自动回归解码

- kV缓存力学

- 解决内存挑战

> flashmla在deepseek模型中的作用 -

- > nvidia hopper体系结构

- 绩效分析和含义

- 结论

- 什么是flashmla?

- FlashMLA是为Nvidia Hopper GPU构建的高度优化的MLA解码内核。 它的设计优先考虑速度和效率,反映了DeepSeek对可扩展AI模型加速的承诺。

>

霍普体系结构GPU(例如H800 SXM5)> cuda 12.3

> pytorch 2.0

- 性能基准:

- > flashmla演示了出色的性能:

- > 内存带宽:

这种出色的性能使FlashMLA非常适合要求AI工作负载。

了解多头潜在注意(MLA)- 使用DeepSeek-v2引入的

标准多头注意力限制:

> MHA的KV高速缓存以序列长度线性缩放,为长序列创建一个存储器瓶颈。 缓存大小的计算为:

(其中是注意头的数量,而seq_len * n_h * d_h是头维)。n_h

d_h

MLA将密钥和值压缩到较小的潜在向量(

)中,将KV高速缓存大小降低到 >(其中

>(其中

c_tseq_len * d_c>键值缓存和自动回归解码d_c

kV缓存可以加速自回旋解码。 但是,这增加了内存使用量。

解决内存挑战:

>诸如多Query注意(MQA)和分组 - 问题注意(GQA)等技术减轻与KV缓存相关的内存问题。

> flashmla在DeepSeek模型中的作用:> FlashMLA

Powers DeepSeek的R1和V3型号,实现了有效的大规模AI应用程序。> nvidia hopper体系结构

Nvidia Hopper是一种专为AI和HPC工作负载而设计的高性能GPU架构。 它的创新(例如变压器引擎和第二代MIG)可实现出色的速度和可扩展性。

>性能分析和含义

FlashMLA可实现BF16矩阵乘法的580个TFLOPS,是H800 GPU的理论峰的两倍以上。 这证明了GPU资源的高效利用。

结论

FlashMLA代表了AI推理效率的重大进步,尤其是对于Hopper GPU。 它的MLA优化,结合BF16支持和分页的KV缓存,可提供显着的性能。 这使大规模的AI模型更容易访问和成本效益,为模型效率树立了新的基准。>

以上是DeepSeek推出了FlashMLA的详细内容。更多信息请关注PHP中文网其他相关文章!