本地微调 DeepSeek 类模型面临着计算资源和专业知识不足的挑战。为了应对这些挑战,可以采用以下策略:模型量化:将模型参数转换为低精度整数,减少内存占用。使用更小的模型:选择参数量较小的预训练模型,便于本地微调。数据选择和预处理:选择高质量的数据并进行适当的预处理,避免数据质量不佳影响模型效果。分批训练:对于大数据集,分批加载数据进行训练,避免内存溢出。利用 GPU 加速:利用独立显卡加速训练过程,缩短训练时间。

DeepSeek本地微调:挑战与策略

DeepSeek本地微调并非易事。它需要强大的计算资源和扎实的专业知识。简单来说,直接在你的电脑上微调一个大型语言模型,就像想用家用烤箱烤一头牛一样——理论上可行,但实际上充满挑战。

为什么这么难?DeepSeek这类模型通常参数量巨大,动辄数十亿甚至上百亿。这直接导致了对内存和显存的极高需求。即使你的电脑配置强劲,也可能面临内存溢出或显存不足的问题。我曾经尝试在一个配置还算不错的台式机上微调一个相对较小的模型,结果卡了半天,最后还是失败了。 这可不是简单的“等久一点”就能解决的。

那么,有哪些策略可以尝试呢?

1. 模型量化: 这是个好办法。将模型参数从高精度浮点数转换为低精度整数(例如INT8),可以显著减少内存占用。很多深度学习框架都提供了量化工具,但要注意的是,量化会带来精度损失,你需要权衡精度和效率。 想象一下,把一张高分辨率的图片压缩成低分辨率,虽然文件小了,但细节也丢失了。

2. 使用更小的模型: 与其尝试微调一个庞然大物,不如考虑使用预训练好的、参数量较小的模型。 这些模型虽然能力不如大型模型,但更易于在本地环境中进行微调,而且训练速度更快。就像用小锤子敲钉子,虽然可能慢一些,但更灵活,也更容易控制。

3. 数据选择和预处理: 这可能是最重要的步骤之一。 你需要选择高质量、与你的任务相关的训练数据,并进行合理的预处理。 脏数据就像给模型喂毒药,只会让结果更糟糕。 记得要清洗数据,处理缺失值和异常值,并进行必要的特征工程。我曾经见过一个项目,因为数据预处理不到位,导致模型效果极差,最后不得不重新收集和清洗数据。

4. 分批训练: 如果你的数据量很大,可以考虑分批训练,每次只加载一部分数据到内存中进行训练。这有点像分期付款,虽然时间长一些,但避免了资金链断裂(内存溢出)。

5. 利用GPU加速: 如果你的电脑有独立显卡,务必充分利用GPU加速训练过程。这就像给你的烤箱加了个超级助燃器,能大大缩短烹饪时间。

最后,我想强调的是,本地微调DeepSeek这类大型模型的成功率并不高,需要根据你的实际情况和资源选择合适的策略。 与其盲目追求在本地微调大型模型,不如先评估你的资源和目标,选择更务实的方法。 也许云计算才是更合适的方案。 毕竟,有些事情,还是交给专业人士来做更好。

以上是deepseek怎么本地微调的详细内容。更多信息请关注PHP中文网其他相关文章!

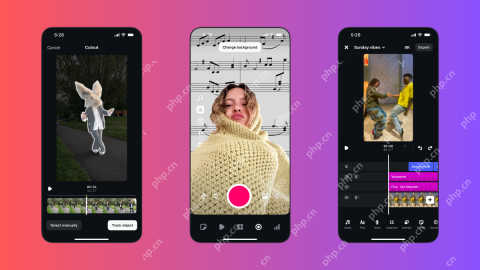

Instagram刚刚启动了其版本的CapcutApr 30, 2025 am 10:25 AM

Instagram刚刚启动了其版本的CapcutApr 30, 2025 am 10:25 AMInstagram 正式推出 Edits 视频编辑应用,抢占移动视频编辑市场。此次发布距离 Instagram 首次宣布该应用已过去三个月,距离二月份 Edits 原定发布日期也已过去两个月。 Instagram 向 TikTok 发起挑战 Instagram 自建视频编辑器意义重大。Instagram 不再仅仅是一个查看个人和公司发布的照片和视频的应用:Instagram Reels 现在已成为其核心功能。短视频风靡全球(甚至 LinkedIn 也推出了短视频功能),Instagram 也不例

国际象棋课来DuolingoApr 24, 2025 am 10:41 AM

国际象棋课来DuolingoApr 24, 2025 am 10:41 AMDuolingo以其语言学习平台而闻名,正在扩大其产品! 本月晚些时候,iOS用户将无缝地集成到熟悉的Duolingo界面中,可以访问新的国际象棋课程。 这些课程是为初学者设计的

蓝色检查验证即将到达蓝调Apr 24, 2025 am 10:17 AM

蓝色检查验证即将到达蓝调Apr 24, 2025 am 10:17 AM蓝军回应了Twitter的过去:介绍官方验证 分散的社交媒体平台Bluesky通过引入正式验证过程来反映Twitter的过去。 这将补充现有的自我验证Optio

Google照片现在允许您将标准照片转换为Ultra HDRApr 24, 2025 am 10:15 AM

Google照片现在允许您将标准照片转换为Ultra HDRApr 24, 2025 am 10:15 AMUltra HDR:Google Photos的新图像增强 Ultra HDR是一种尖端的图像格式,可提供出色的视觉质量。 像标准HDR一样,它包含更多数据,从而产生更明亮的高光,更深的阴影和更丰富的颜色。 关键差异

您应该尝试使用Instagram的新'混合”功能来定制卷轴feedApr 23, 2025 am 11:35 AM

您应该尝试使用Instagram的新'混合”功能来定制卷轴feedApr 23, 2025 am 11:35 AMInstagram和Spotify现在提供个性化的“混合”功能,以增强社交共享。 仅通过移动应用程序访问Instagram的混合物,为个人或组聊天创建自定义的每日卷轴供稿。 Spotify的混合镜子

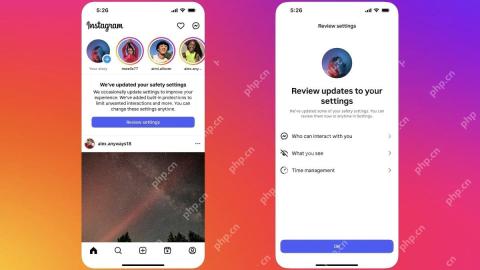

Instagram正在使用AI自动注册未成年人进入'青少年帐户”Apr 23, 2025 am 10:00 AM

Instagram正在使用AI自动注册未成年人进入'青少年帐户”Apr 23, 2025 am 10:00 AMMeta正在打击未成年Instagram用户。 在去年引入“青少年帐户”(对18岁以下用户的限制)之后,Meta将这些限制扩展到Facebook和Messenger,现在正在增强其

我应该用代理商做淘宝吗?Apr 22, 2025 pm 12:04 PM

我应该用代理商做淘宝吗?Apr 22, 2025 pm 12:04 PM导航对淘宝:为什么像Buckydrop这样的淘宝代理商对全球购物者至关重要 大型中国电子商务平台淘国的普及,对非中国发言人或中国以外的人提出了挑战。 语言障碍,付款c

如何避免在淘宝上购买假产品?Apr 22, 2025 pm 12:03 PM

如何避免在淘宝上购买假产品?Apr 22, 2025 pm 12:03 PM在广阔的淘宝市场上航行需要警惕对伪造商品的警惕。 本文提供了实用的技巧,可帮助您识别和避免使用假产品,从而确保安全而令人满意的购物体验。 仔细检查卖方faybac

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

WebStorm Mac版

好用的JavaScript开发工具

记事本++7.3.1

好用且免费的代码编辑器

DVWA

Damn Vulnerable Web App (DVWA) 是一个PHP/MySQL的Web应用程序,非常容易受到攻击。它的主要目标是成为安全专业人员在合法环境中测试自己的技能和工具的辅助工具,帮助Web开发人员更好地理解保护Web应用程序的过程,并帮助教师/学生在课堂环境中教授/学习Web应用程序安全。DVWA的目标是通过简单直接的界面练习一些最常见的Web漏洞,难度各不相同。请注意,该软件中

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

SublimeText3汉化版

中文版,非常好用