我最近尝试实现一个基于 DQN 的国际象棋代理。

现在,任何知道 DQN 和国际象棋如何工作的人都会告诉你这是一个愚蠢的想法。

确实如此,但作为一个初学者,我仍然很喜欢它。在这篇文章中,我将分享我在这方面工作时学到的见解。

了解环境。

在开始实现 Agent 本身之前,我必须熟悉将要使用的环境,并在其之上制作一个自定义包装器,以便它可以在训练期间与 Agent 交互。

-

我使用了 kaggle_environments 库中的国际象棋环境。

from kaggle_environments import make env = make("chess", debug=True)

-

我还使用了 Chessnut,这是一个轻量级的 Python 库,可以帮助解析和验证国际象棋游戏。

from Chessnut import Game initial_fen = env.state[0]['observation']['board'] game=Game(env.state[0]['observation']['board'])

在此环境中,板的状态以 FEN 格式存储。

它提供了一种紧凑的方式来表示棋盘上的所有棋子和当前活跃的玩家。但是,由于我计划将输入提供给神经网络,因此我必须修改状态的表示。

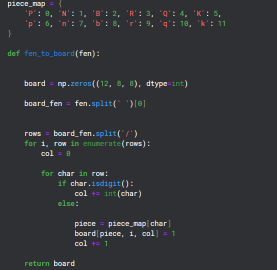

将 FEN 转换为矩阵格式

由于棋盘上有 12 种不同类型的棋子,因此我创建了 12 个 8x8 网格通道来表示棋盘上每种类型的状态。

为环境创建一个包装器

class EnvCust:

def __init__(self):

self.env = make("chess", debug=True)

self.game=Game(env.state[0]['observation']['board'])

print(self.env.state[0]['observation']['board'])

self.action_space=game.get_moves();

self.obs_space=(self.env.state[0]['observation']['board'])

def get_action(self):

return Game(self.env.state[0]['observation']['board']).get_moves();

def get_obs_space(self):

return fen_to_board(self.env.state[0]['observation']['board'])

def step(self,action):

reward=0

g=Game(self.env.state[0]['observation']['board']);

if(g.board.get_piece(Game.xy2i(action[2:4]))=='q'):

reward=7

elif g.board.get_piece(Game.xy2i(action[2:4]))=='n' or g.board.get_piece(Game.xy2i(action[2:4]))=='b' or g.board.get_piece(Game.xy2i(action[2:4]))=='r':

reward=4

elif g.board.get_piece(Game.xy2i(action[2:4]))=='P':

reward=2

g=Game(self.env.state[0]['observation']['board']);

g.apply_move(action)

done=False

if(g.status==2):

done=True

reward=10

elif g.status == 1:

done = True

reward = -5

self.env.step([action,'None'])

self.action_space=list(self.get_action())

if(self.action_space==[]):

done=True

else:

self.env.step(['None',random.choice(self.action_space)])

g=Game(self.env.state[0]['observation']['board']);

if g.status==2:

reward=-10

done=True

self.action_space=list(self.get_action())

return self.env.state[0]['observation']['board'],reward,done

这个包装器的目的是为代理提供奖励策略以及用于在训练期间与环境交互的步骤函数。

Chessnut 有助于获取信息,例如当前棋盘状态下可能的合法走法,以及在游戏过程中识别将死者。

我尝试制定奖励政策,为将死并消灭敌方棋子给予正分,而为输掉比赛给予负分。

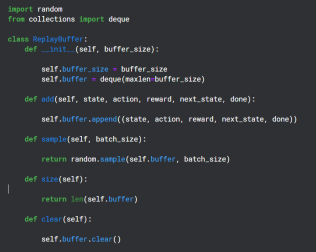

创建重播缓冲区

重播缓冲区在训练期间用于保存 Q 网络输出的(状态、动作、奖励、下一个状态),并在以后随机用于目标网络的反向传播

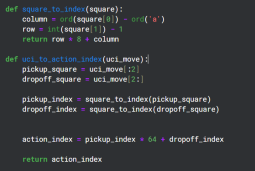

辅助功能

Chessnut 以 UCI 格式返回合法动作,看起来像“a2a3”,但是为了与神经网络交互,我使用基本模式将每个动作转换为不同的索引。总共有 64 个方块,所以我决定为每个动作设置 64*64 个唯一索引。

我知道并非所有 64*64 的棋步都是合法的,但我可以使用 Chessnut 来处理合法性,而且模式足够简单。

神经网络结构

from kaggle_environments import make

env = make("chess", debug=True)

该神经网络使用卷积层接收 12 个通道输入,并使用有效的动作索引来过滤奖励输出预测。

实施代理

from Chessnut import Game initial_fen = env.state[0]['observation']['board'] game=Game(env.state[0]['observation']['board'])

这显然是一个非常基本的模型,实际上不可能表现良好(而且也没有),但它确实帮助我理解了 DQN 如何更好地工作。

以上是使用 DQN 构建国际象棋代理的详细内容。更多信息请关注PHP中文网其他相关文章!

Python vs. C:了解关键差异Apr 21, 2025 am 12:18 AM

Python vs. C:了解关键差异Apr 21, 2025 am 12:18 AMPython和C 各有优势,选择应基于项目需求。1)Python适合快速开发和数据处理,因其简洁语法和动态类型。2)C 适用于高性能和系统编程,因其静态类型和手动内存管理。

Python vs.C:您的项目选择哪种语言?Apr 21, 2025 am 12:17 AM

Python vs.C:您的项目选择哪种语言?Apr 21, 2025 am 12:17 AM选择Python还是C 取决于项目需求:1)如果需要快速开发、数据处理和原型设计,选择Python;2)如果需要高性能、低延迟和接近硬件的控制,选择C 。

达到python目标:每天2小时的力量Apr 20, 2025 am 12:21 AM

达到python目标:每天2小时的力量Apr 20, 2025 am 12:21 AM通过每天投入2小时的Python学习,可以有效提升编程技能。1.学习新知识:阅读文档或观看教程。2.实践:编写代码和完成练习。3.复习:巩固所学内容。4.项目实践:应用所学于实际项目中。这样的结构化学习计划能帮助你系统掌握Python并实现职业目标。

最大化2小时:有效的Python学习策略Apr 20, 2025 am 12:20 AM

最大化2小时:有效的Python学习策略Apr 20, 2025 am 12:20 AM在两小时内高效学习Python的方法包括:1.回顾基础知识,确保熟悉Python的安装和基本语法;2.理解Python的核心概念,如变量、列表、函数等;3.通过使用示例掌握基本和高级用法;4.学习常见错误与调试技巧;5.应用性能优化与最佳实践,如使用列表推导式和遵循PEP8风格指南。

在Python和C之间进行选择:适合您的语言Apr 20, 2025 am 12:20 AM

在Python和C之间进行选择:适合您的语言Apr 20, 2025 am 12:20 AMPython适合初学者和数据科学,C 适用于系统编程和游戏开发。1.Python简洁易用,适用于数据科学和Web开发。2.C 提供高性能和控制力,适用于游戏开发和系统编程。选择应基于项目需求和个人兴趣。

Python与C:编程语言的比较分析Apr 20, 2025 am 12:14 AM

Python与C:编程语言的比较分析Apr 20, 2025 am 12:14 AMPython更适合数据科学和快速开发,C 更适合高性能和系统编程。1.Python语法简洁,易于学习,适用于数据处理和科学计算。2.C 语法复杂,但性能优越,常用于游戏开发和系统编程。

每天2小时:Python学习的潜力Apr 20, 2025 am 12:14 AM

每天2小时:Python学习的潜力Apr 20, 2025 am 12:14 AM每天投入两小时学习Python是可行的。1.学习新知识:用一小时学习新概念,如列表和字典。2.实践和练习:用一小时进行编程练习,如编写小程序。通过合理规划和坚持不懈,你可以在短时间内掌握Python的核心概念。

Python与C:学习曲线和易用性Apr 19, 2025 am 12:20 AM

Python与C:学习曲线和易用性Apr 19, 2025 am 12:20 AMPython更易学且易用,C 则更强大但复杂。1.Python语法简洁,适合初学者,动态类型和自动内存管理使其易用,但可能导致运行时错误。2.C 提供低级控制和高级特性,适合高性能应用,但学习门槛高,需手动管理内存和类型安全。

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

Video Face Swap

使用我们完全免费的人工智能换脸工具轻松在任何视频中换脸!

热门文章

热工具

SublimeText3 英文版

推荐:为Win版本,支持代码提示!

mPDF

mPDF是一个PHP库,可以从UTF-8编码的HTML生成PDF文件。原作者Ian Back编写mPDF以从他的网站上“即时”输出PDF文件,并处理不同的语言。与原始脚本如HTML2FPDF相比,它的速度较慢,并且在使用Unicode字体时生成的文件较大,但支持CSS样式等,并进行了大量增强。支持几乎所有语言,包括RTL(阿拉伯语和希伯来语)和CJK(中日韩)。支持嵌套的块级元素(如P、DIV),

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

Atom编辑器mac版下载

最流行的的开源编辑器