忘掉炒作吧;人工智能在哪里创造真正的价值?让我们利用边缘计算来利用人工智能的力量,打造快速、安全、可靠的智能用户体验。

推荐无处不在,每个人都知道,使网络体验更加个性化可以使其更具吸引力和成功。 我的亚马逊主页知道我喜欢家居用品、厨具,现在还喜欢夏季服装:

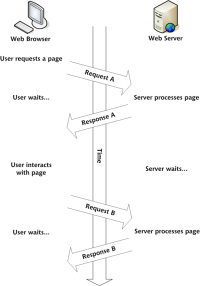

如今,大多数平台都让您在快速或个性化之间做出选择。在 Fastly,我们认为您和您的用户应该同时拥有两者。 如果您的网络服务器每次生成一个页面时,它只适合一个最终用户,您就无法从缓存中受益,而这正是像 Fastly 这样的边缘网络所擅长的。

那么如何从边缘缓存中受益,同时使内容个性化? 我们之前写过很多关于如何将复杂的客户端请求分解为多个较小的、可缓存的后端请求的文章,您可以在我们的开发人员中心的个性化主题中找到教程、代码示例和演示。

但是如果您想更进一步并在边缘生成个性化数据怎么办? “边缘”——处理您网站流量的 Fastly 服务器,是距离最终用户最近的点,且仍在您的控制范围内。一个制作特定于某个用户的内容的好地方。

“为你”用例

产品推荐本质上是短暂的,特定于单个用户,并且可能会经常变化。 但它们也不需要持续存在——我们通常不需要知道我们向每个人推荐了什么,只需要知道特定算法是否比其他算法实现了更好的转换。 一些推荐算法需要访问大量状态数据,例如哪些用户与您最相似以及他们的购买或评分历史记录,但通常这些数据很容易批量预生成。

基本上,生成推荐通常不会创建事务,不需要在数据存储中加任何锁,并且会利用当前用户会话中立即可用的输入数据或在离线构建过程中创建的输入数据。

听起来我们可以在边缘生成推荐!

一个现实世界的例子

我们来看看纽约大都会艺术博物馆的网站:

大都会博物馆收藏的 500,000 件左右的藏品中,每一件都有一个包含图片和相关信息的页面。 它还具有相关对象的列表:

这似乎使用了相当简单的分面系统来生成这些关系,向我展示同一艺术家的其他艺术品,或博物馆同一翼中的其他物体,或者也是由纸制成或源自同一翼的其他物体时间段。

这个系统的好处(从开发人员的角度来看!)是,由于它仅基于一个输入对象,因此可以预先生成到页面中。

如果我们想通过基于最终用户浏览大都会网站时的个人浏览历史记录(而不仅仅是基于这个对象)的一系列推荐来增强这一点,该怎么办?

添加个性化推荐

我们可以通过很多方法来做到这一点,但我想尝试使用语言模型,因为人工智能正在正在发生,而且它与大都会现有的相关艺术品机制似乎非常不同工作。 计划如下:

- 下载大都会博物馆的开放获取收藏数据集。

- 通过语言模型运行它以创建向量嵌入 - 适合机器学习任务的数字列表。

- 为生成的 50 万个向量(代表大都会艺术博物馆的艺术品)构建一个高性能相似性搜索引擎,并将其加载到 KV 存储中,以便我们可以从 Fastly Compute 中使用它。

完成所有这些后,当您浏览大都会博物馆的网站时,我们应该能够:

- 在 cookie 中跟踪您访问过的艺术品。

- 查找这些艺术品对应的向量。

- 计算代表您的浏览兴趣的平均向量。

- 将其插入我们的相似性搜索引擎以查找最相似的艺术品。

- 从 Met 的对象 API 加载有关这些艺术品的详细信息,并通过个性化推荐来增强页面。

瞧,个性化推荐:

好的,让我们来分解一下。

创建数据集

Met 的原始数据集是一个包含很多列的 CSV,如下所示:

Object Number,Is Highlight,Is Timeline Work,Is Public Domain,Object ID,Gallery Number,Department,AccessionYear,Object Name,Title,Culture,Period,Dynasty,Reign,Portfolio,Constituent ID,Artist Role,Artist Prefix,Artist Display Name,Artist Display Bio,Artist Suffix,Artist Alpha Sort,Artist Nationality,Artist Begin Date,Artist End Date,Artist Gender,Artist ULAN URL,Artist Wikidata URL,Object Date,Object Begin Date,Object End Date,Medium,Dimensions,Credit Line,Geography Type,City,State,County,Country,Region,Subregion,Locale,Locus,Excavation,River,Classification,Rights and Reproduction,Link Resource,Object Wikidata URL,Metadata Date,Repository,Tags,Tags AAT URL,Tags Wikidata URL 1979.486.1,False,False,False,1,,The American Wing,1979,Coin,One-dollar Liberty Head Coin,,,,,,16429,Maker," ",James Barton Longacre,"American, Delaware County, Pennsylvania 1794–1869 Philadelphia, Pennsylvania"," ","Longacre, James Barton",American,1794 ,1869 ,,http://vocab.getty.edu/page/ulan/500011409,https://www.wikidata.org/wiki/Q3806459,1853,1853,1853,Gold,Dimensions unavailable,"Gift of Heinz L. Stoppelmann, 1979",,,,,,,,,,,,,,http://www.metmuseum.org/art/collection/search/1,,,"Metropolitan Museum of Art, New York, NY",,, 1980.264.5,False,False,False,2,,The American Wing,1980,Coin,Ten-dollar Liberty Head Coin,,,,,,107,Maker," ",Christian Gobrecht,1785–1844," ","Gobrecht, Christian",American,1785 ,1844 ,,http://vocab.getty.edu/page/ulan/500077295,https://www.wikidata.org/wiki/Q5109648,1901,1901,1901,Gold,Dimensions unavailable,"Gift of Heinz L. Stoppelmann, 1980",,,,,,,,,,,,,,http://www.metmuseum.org/art/collection/search/2,,,"Metropolitan Museum of Art, New York, NY",,,

很简单,可以将其转换为两列,一个 ID 和一个字符串:

id,description 1,"One-dollar Liberty Head Coin; Type: Coin; Artist: James Barton Longacre; Medium: Gold; Date: 1853; Credit: Gift of Heinz L. Stoppelmann, 1979" 2,"Ten-dollar Liberty Head Coin; Type: Coin; Artist: Christian Gobrecht; Medium: Gold; Date: 1901; Credit: Gift of Heinz L. Stoppelmann, 1980" 3,"Two-and-a-Half Dollar Coin; Type: Coin; Medium: Gold; Date: 1927; Credit: Gift of C. Ruxton Love Jr., 1967"

现在我们可以使用 Hugging Face AI 工具集中的 Transformer 包,并生成每个描述的嵌入。 我们使用sentence-transformers/all-MiniLM-L12-v2模型,并使用主成分分析(PCA)将结果向量减少到5维。 这会给你类似的东西:

[

{

"id": 1,

"vector": [ -0.005544120445847511, -0.030924081802368164, 0.008597176522016525, 0.20186401903629303, 0.0578165128827095 ]

},

{

"id": 2,

"vector": [ -0.005544120445847511, -0.030924081802368164, 0.008597176522016525, 0.20186401903629303, 0.0578165128827095 ]

},

…

]

我们有 50 万个这样的数据集,因此不可能将整个数据集存储在边缘应用程序的内存中。 我们希望对这些数据进行自定义类型的相似性搜索,这是传统键值存储所不提供的。由于我们正在构建实时体验,因此我们也确实希望避免一次搜索 50 万个向量。

那么,让我们对数据进行分区。 我们可以使用 KMeans 聚类对彼此相似的向量进行分组。 我们将数据分成 500 个不同大小的簇,并为每个簇计算一个称为“质心向量”的中心点。 如果您以二维方式绘制此向量空间并放大,它可能看起来有点像这样:

红十字是每个向量簇的数学中心点,称为质心。它们可以像我们 50 万向量空间的寻路器一样工作。例如,如果我们想找到与给定向量 A 最相似的 10 个向量,我们可以首先寻找最近的质心(500 个质心),然后仅在其相应的簇内进行搜索——这是一个更易于管理的区域!

现在我们有 500 个小数据集和一个将质心点映射到相关数据集的索引。 接下来,为了实现实时性能,我们想要预编译搜索图,这样我们就不需要在运行时初始化和构造它们,并且可以使用尽可能少的CPU时间。 一种非常快速的最近邻算法是分层可导航小世界(HNSW),它有一个纯 Rust 实现,我们用它来编写我们的边缘应用程序。 因此,我们编写了一个小型独立 Rust 应用程序来为每个数据集构建 HNSW 图结构,然后使用 bincode 将实例化结构的内存导出到二进制 blob。

现在,这些二进制 blob 可以加载到 KV 存储中,针对集群索引进行键控,并且集群索引可以包含在我们的边缘应用程序中。

这种架构允许我们按需将部分搜索索引加载到内存中。而且由于我们永远不需要一次搜索超过几千个向量,因此我们的搜索将始终廉价且快速。

构建边缘应用程序

我们在边缘运行的应用程序需要处理多种类型的请求:

- HTML 页面: 我们从 metmuseum.org 获取这些页面并转换响应以添加额外的前端 <script>和<风格>标签,这样我们就可以注入一些我们自己的前端处理和内容</script>

- 这些额外标签引用的 Fastly 脚本和样式资源,我们可以直接从边缘应用程序的二进制文件中提供这些资源。

- 推荐端点,生成并返回推荐 ** 所有其他(非 HTML)请求: 图像以及大都会艺术博物馆自己的脚本和样式表,我们直接从其域代理,无需更改。

我们最初用 JavaScript 构建了这个应用程序,但最终将推荐部分移植到 Rust,因为我们喜欢即时距离的 HNSW 实现。

客户端 JavaScript 做了一些有趣的事情:

- 使用 IntersectionObserver,当用户将页面向下滚动到相关对象部分时,我们会触发一个事件。这是一个超级高效的 API,比使用 onscroll 等旧方法要好得多。

- 获取我们的特别推荐 API 端点(然后我们可以在边缘处理并返回对象信息)

- 使用客户端函数内置的模板编写一些 HTML

- 将该 HTML 附加到页面并将交叉观察器移动到新元素,以便当您滚动浏览建议时,我们会不断加载更多内容。

这样,我们可以在不调用我们的推荐算法的情况下提供主要的 HTML 有效负载,但推荐的提供速度足够快,我们可以在您滚动时加载它们,并且当您到达它们时它们几乎肯定会在那里。

我喜欢以这种方式做事,因为尽快向用户提供第一个首屏视图绝对是最重要的。 除非滚动才能看到的任何内容都可以稍后加载,特别是如果它是复杂的个性化内容 - 如果用户不打算滚动,则生成它是没有意义的。

结束语

因此,现在您拥有两全其美的优势:能够提供高度个性化的内容,几乎不需要对源进行任何阻塞提取,并且经过优化的 HTML 有效负载的渲染速度非常快,使您的应用程序能够有效地享受无限的可扩展性和近乎完美的性能。完美的恢复能力。

这不是一个完美的解决方案。 如果 Fastly 提供更多更高级别的功能来通过查询机制而不是简单的键查找来公开边缘数据(让我们知道这是否对您有帮助!),并且这种特定机制有明显的缺陷 - 如果我对以下方面有单独的兴趣两个或更多非常不同的东西(比如 19 世纪的油画和古罗马双耳瓶)我会得到建议,这将是这些之间的理论语义“中间点”,而不是一个非常有用的结果。

不过,希望这证明了一个原则,即弄清楚如何在边缘进行工作通常会在可扩展性、性能和弹性方面带来巨大的好处。

让我们知道您在community.fastly.com 上构建了什么!

以上是在 Fastly 上使用 AI 构建'为您”推荐!的详细内容。更多信息请关注PHP中文网其他相关文章!

在JavaScript中替换字符串字符Mar 11, 2025 am 12:07 AM

在JavaScript中替换字符串字符Mar 11, 2025 am 12:07 AMJavaScript字符串替换方法详解及常见问题解答 本文将探讨两种在JavaScript中替换字符串字符的方法:在JavaScript代码内部替换和在网页HTML内部替换。 在JavaScript代码内部替换字符串 最直接的方法是使用replace()方法: str = str.replace("find","replace"); 该方法仅替换第一个匹配项。要替换所有匹配项,需使用正则表达式并添加全局标志g: str = str.replace(/fi

构建您自己的Ajax Web应用程序Mar 09, 2025 am 12:11 AM

构建您自己的Ajax Web应用程序Mar 09, 2025 am 12:11 AM因此,在这里,您准备好了解所有称为Ajax的东西。但是,到底是什么? AJAX一词是指用于创建动态,交互式Web内容的一系列宽松的技术。 Ajax一词,最初由Jesse J创造

10个JQuery Fun and Games插件Mar 08, 2025 am 12:42 AM

10个JQuery Fun and Games插件Mar 08, 2025 am 12:42 AM10款趣味横生的jQuery游戏插件,让您的网站更具吸引力,提升用户粘性!虽然Flash仍然是开发休闲网页游戏的最佳软件,但jQuery也能创造出令人惊喜的效果,虽然无法与纯动作Flash游戏媲美,但在某些情况下,您也能在浏览器中获得意想不到的乐趣。 jQuery井字棋游戏 游戏编程的“Hello world”,现在有了jQuery版本。 源码 jQuery疯狂填词游戏 这是一个填空游戏,由于不知道单词的上下文,可能会产生一些古怪的结果。 源码 jQuery扫雷游戏

jQuery视差教程 - 动画标题背景Mar 08, 2025 am 12:39 AM

jQuery视差教程 - 动画标题背景Mar 08, 2025 am 12:39 AM本教程演示了如何使用jQuery创建迷人的视差背景效果。 我们将构建一个带有分层图像的标题横幅,从而创造出令人惊叹的视觉深度。 更新的插件可与JQuery 1.6.4及更高版本一起使用。 下载

如何在浏览器中优化JavaScript代码以进行性能?Mar 18, 2025 pm 03:14 PM

如何在浏览器中优化JavaScript代码以进行性能?Mar 18, 2025 pm 03:14 PM本文讨论了在浏览器中优化JavaScript性能的策略,重点是减少执行时间并最大程度地减少对页面负载速度的影响。

Matter.js入门:简介Mar 08, 2025 am 12:53 AM

Matter.js入门:简介Mar 08, 2025 am 12:53 AMMatter.js是一个用JavaScript编写的2D刚体物理引擎。此库可以帮助您轻松地在浏览器中模拟2D物理。它提供了许多功能,例如创建刚体并为其分配质量、面积或密度等物理属性的能力。您还可以模拟不同类型的碰撞和力,例如重力摩擦力。 Matter.js支持所有主流浏览器。此外,它也适用于移动设备,因为它可以检测触摸并具有响应能力。所有这些功能都使其值得您投入时间学习如何使用该引擎,因为这样您就可以轻松创建基于物理的2D游戏或模拟。在本教程中,我将介绍此库的基础知识,包括其安装和用法,并提供一

使用jQuery和Ajax自动刷新DIV内容Mar 08, 2025 am 12:58 AM

使用jQuery和Ajax自动刷新DIV内容Mar 08, 2025 am 12:58 AM本文演示了如何使用jQuery和ajax自动每5秒自动刷新DIV的内容。 该示例从RSS提要中获取并显示了最新的博客文章以及最后的刷新时间戳。 加载图像是选择

热AI工具

Undresser.AI Undress

人工智能驱动的应用程序,用于创建逼真的裸体照片

AI Clothes Remover

用于从照片中去除衣服的在线人工智能工具。

Undress AI Tool

免费脱衣服图片

Clothoff.io

AI脱衣机

AI Hentai Generator

免费生成ai无尽的。

热门文章

热工具

SublimeText3 Mac版

神级代码编辑软件(SublimeText3)

适用于 Eclipse 的 SAP NetWeaver 服务器适配器

将Eclipse与SAP NetWeaver应用服务器集成。

MinGW - 适用于 Windows 的极简 GNU

这个项目正在迁移到osdn.net/projects/mingw的过程中,你可以继续在那里关注我们。MinGW:GNU编译器集合(GCC)的本地Windows移植版本,可自由分发的导入库和用于构建本地Windows应用程序的头文件;包括对MSVC运行时的扩展,以支持C99功能。MinGW的所有软件都可以在64位Windows平台上运行。

Dreamweaver CS6

视觉化网页开发工具

WebStorm Mac版

好用的JavaScript开发工具