Die AIxiv-Kolumne ist eine Kolumne, in der diese Website akademische und technische Inhalte veröffentlicht. In den letzten Jahren sind in der AIxiv-Kolumne dieser Website mehr als 2.000 Berichte eingegangen, die Spitzenlabore großer Universitäten und Unternehmen auf der ganzen Welt abdecken und so den akademischen Austausch und die Verbreitung wirksam fördern. Wenn Sie hervorragende Arbeiten haben, die Sie teilen möchten, können Sie gerne einen Beitrag leisten oder uns für die Berichterstattung kontaktieren. E-Mail für die Einreichung: liyazhou@jiqizhixin.com; zhaoyunfeng@jiqizhixin.com

Wu Yi, Assistenzprofessor am Institut für interdisziplinäre Information der Tsinghua-Universität, ehemaliger Vollzeitforscher bei OpenAI, Forschungsgebiete umfassen Reinforcement Learning , große Modellausrichtung, Mensch-Computer-Interaktion, Roboterlernen usw. Erlangte 2019 einen Doktortitel an der University of California, Berkeley, und schloss 2014 sein Studium am Institute of Interdisciplinary Information (Yao-Klasse) der Tsinghua University ab. Zu seinen repräsentativen Arbeiten gehören: NIPS2016 Best Paper, Value Iteration Network; das am häufigsten zitierte Paper im Bereich Multi-Agent Deep Reinforcement Learning, MADDPG-Algorithmus usw. Wie kann man große Modelle dazu bringen, menschliche Anweisungen und Absichten besser zu befolgen? Wie kann man großen Modellen bessere Argumentationsfähigkeiten verleihen? Wie vermeide ich Halluzinationen bei großen Modellen? Ob diese Probleme gelöst werden können, ist die wichtigste technische Herausforderung, um große Modelle wirklich allgemein verfügbar zu machen und sogar Superintelligenz zu erreichen. Diese schwierigsten Herausforderungen bilden auch den langfristigen Forschungsschwerpunkt des Teams von Wu Yi und sind Probleme, die durch die Ausrichtungstechnologie für große Modelle (Alignment) bewältigt werden müssen. In der Alignment-Technologie ist das verstärkende Lernen basierend auf menschlichem Feedback (RLHF, Reinforcement Learning from Human Feedback) das wichtigste Algorithmus-Framework. RLHF lernt eine Belohnungsfunktion (Belohnungsmodell) basierend auf menschlichem Feedback basierend auf menschlichem Präferenz-Feedback für die Ausgabe des großen Modells und führt außerdem ein Verstärkungslerntraining für das große Modell durch, damit das große Modell lernen kann, die Qualität der Antworten zu unterscheiden in wiederholten Iterationen und erzielen Sie verbesserte Modellfunktionen. Derzeit legen die weltweit leistungsstärksten Sprachmodelle, wie das GPT-Modell von OpenAI und das Claude-Modell von Anthropic, großen Wert auf die Bedeutung des RLHF-Trainings. OpenAI und Anthropic haben außerdem intern RLHF-Trainingssysteme entwickelt, die auf groß angelegten PPO-Algorithmen für die Ausrichtung großer Modelle basieren. Aufgrund des komplexen Prozesses des PPO-Algorithmus und des hohen Rechenleistungsverbrauchs war das groß angelegte RLHF-Trainingssystem des amerikanischen KI-Unternehmens jedoch nie Open Source, obwohl der PPO-Algorithmus sehr hoch ist Leistungsstark, die Alignment-Arbeit in der Wissenschaft hat selten komplexe Methoden verwendet. Der PPO-Algorithmus wird für die RLHF-Forschung verwendet, und Alignment-Algorithmen wie SFT (Supervised Fine-Tuning) oder DPO (Direct Policy Optimization) werden im Allgemeinen einfacher und direkter verwendet und stellen geringere Anforderungen an das Ausbildungssystem. Funktioniert also ein einfacher Ausrichtungsalgorithmus definitiv besser? In der von Wu Yis Team auf der ICML 2024 veröffentlichten Arbeit „Ist DPO PPO für die LLM-Ausrichtung überlegen? Eine umfassende Studie“ wurden die Eigenschaften der DPO- und PPO-Algorithmen sorgfältig erörtert und die wichtigsten Punkte zur Verbesserung der Wirkung des RLHF-Algorithmus aufgezeigt. In dieser Arbeit, die auf dem selbst entwickelten groß angelegten RLHF-Trainingssystem basiert, verwendete das Team von Wu Yi zum ersten Mal den PPO-Algorithmus und ein Open-Source-Modell mit weniger Parametern und übertraf damit die Closed-Source-Aufgabe zur groß angelegten Codegenerierung CodeContest in Die anerkannteste Herausforderung ist das Modell AlphaCode 41B.

Die relevanten Ergebnisse wurden vom ICML 2024 als mündliche Präsentation angenommen und werden bei der ersten mündlichen Sitzung Alignment-1 des ICML 2024 am 23. Juli zusammen mit der Arbeit bekannter Institutionen wie OpenAI und veröffentlicht Anthropisch.

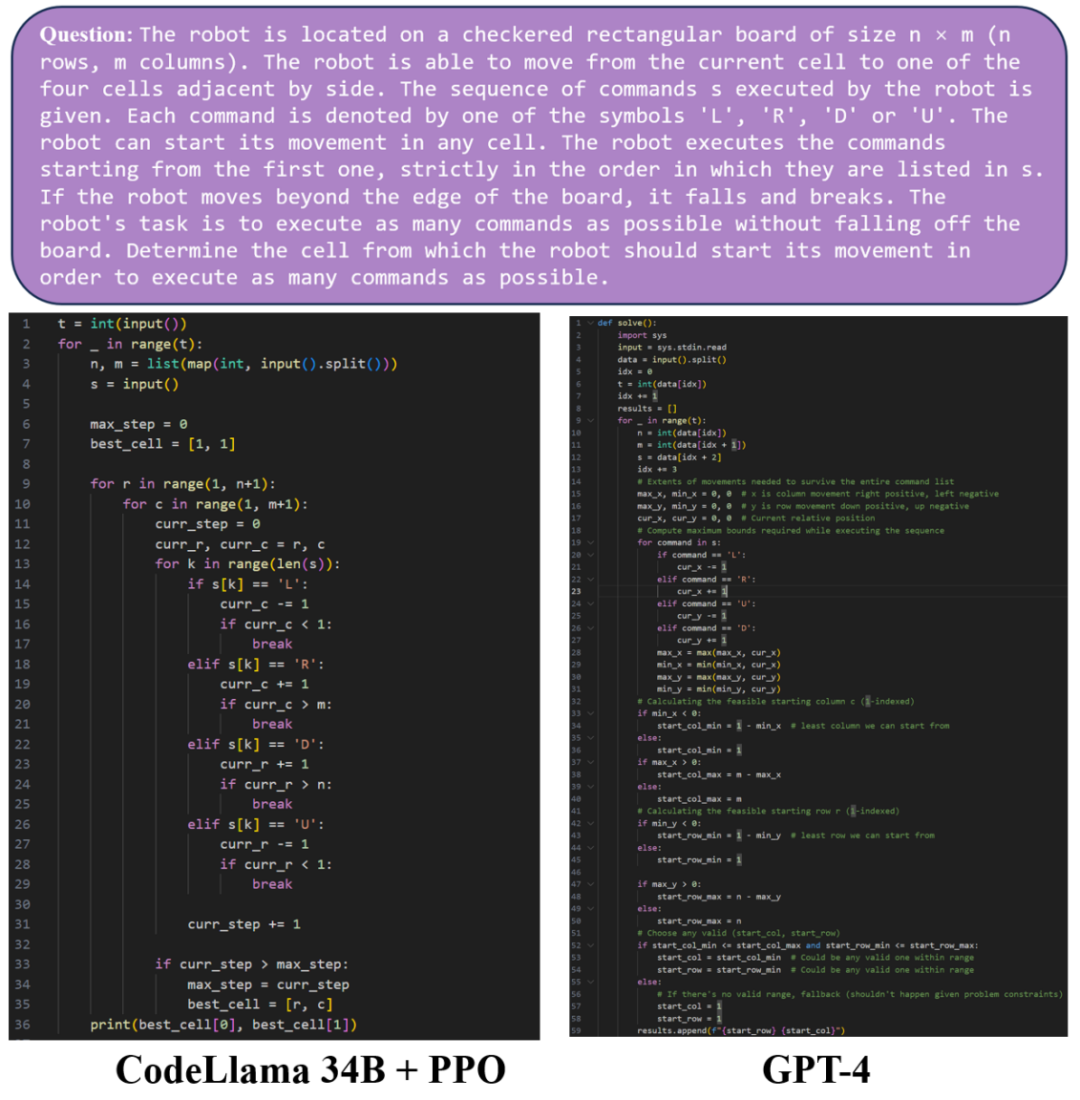

Als nächstes vergleichen wir die Codegenerierungseffekte von GPT-4 und dem vom PPO-Algorithmus trainierten CodeLlama 34B-Modell. In Beispiel 1 werden das vom PPO-Algorithmus trainierte CodeLlama 34B-Modell und das GPT-4-Modell generiert Code von vergleichbarer Qualität.

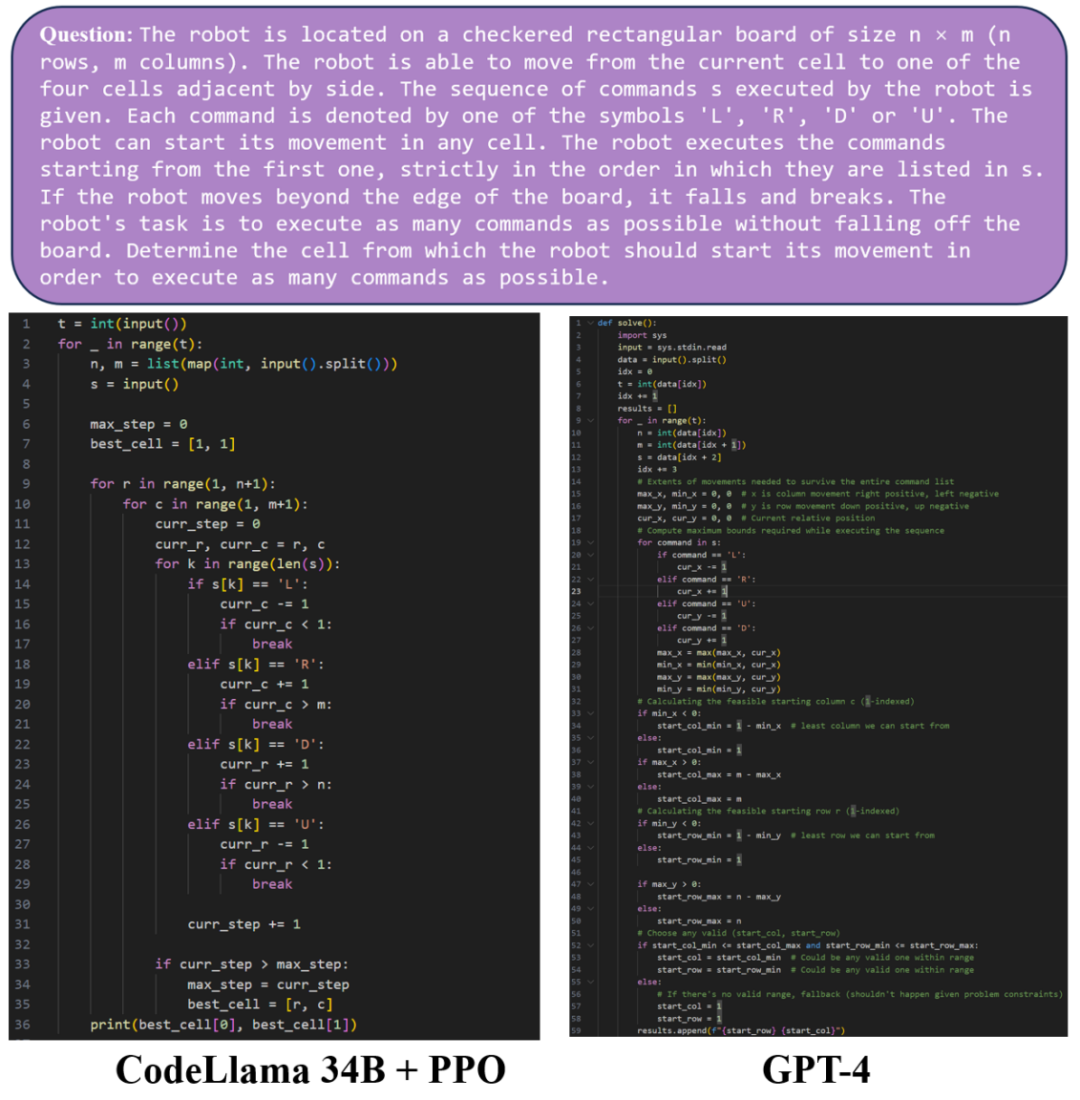

In Beispiel 2 können Sie sehen, dass sowohl das CodeLlama 34B-Modell als auch das vom PPO-Algorithmus trainierte GPT-4-Modell vollständigen und ausführbaren Python-Code generieren können. In diesem Beispiel generierte GPT-4 jedoch falschen Code und konnte die Testdaten nicht korrekt ausgeben. Der vom PPO-Algorithmus trainierte CodeLlama 34B-Modell generierte Code kann den Test bestehen.

在 ICML 2024 的这篇论文中,研究团队详细探讨了 DPO 与 PPO 算法的特点,并指出提升 DPO 和 PPO 能力的关键点。

- 论文标题:Is DPO Superior to PPO for LLM Alignment? A Comprehensive Study

- 论文地址:https://arxiv.org/pdf/2404.10719

相比于 PPO,DPO 使用离线数据而非在线采样数据训练。经分析,DPO 算法会导致训练出的模型对训练数据分布之外的输出产生偏好,在某些情况下产生不可预料的回复。于是,为了提升 DPO 算法的能力,研究团队总结了两个关键技术:在 RLHF 训练前进行额外的 SFT 训练,以及使用在线采样数据而非离线数据。

实验表明,使用额外的 SFT 训练可以使 base 模型以及 reference 模型更偏向于数据集内的分布,大大提升 DPO 算法效果;另一方面,使用在线采样数据进行迭代训练的 DPO 算法可以得到稳步提升,表现远远优于基础的 DPO 算法。除去 DPO,论文中也总结了发挥 PPO 最大能力的三个关键点:

- 使用大的批大小(large batch size)

- 优势归一化(advantage normalization)

- 以及对 reference model 使用指数移动平均进行更新(exponential moving average for the reference model)。

研究团队成功使用 PPO 算法在对话任务 Safe-RLHF/HH-RLHF 以及代码生成任务 APPS/CodeContest 上达到了 SOTA 的效果。

在对话任务上,研究团队发现综合了三个关键点的 PPO 算法显著优于 DPO 算法以及在线采样的 DPO 算法 DPO-Iter。

在代码生成任务 APPS 和 CodeContest 上,基于开源模型 Code Llama 34B,PPO 算法也达到了最强的水平,在 CodeContest 上超越了之前的 SOTA,AlphaCode 41B。想要实现效果较好的大模型对齐,高效率的训练系统是不可缺少的,在实现大规模强化学习训练上,吴翼团队有长期的积累,从 2021 年开始就搭建了专属的分布式强化学习框架。

- NeurIPS 2022 The Surprising Effectiveness of PPO in Cooperative Multi-Agent Games [1]:提出并开源了用于多智能体的强化学习并行训练框架 MAPPO,支持合作场景下的多智能体训练,该工作被大量多智能体领域工作采用,目前论文引用量已超过 1k。

- ICLR 2024 Scaling Distributed Reinforcement Learning to Over Ten Thousand Cores [2]: 提出了用于强化学习的分布式训练框架,可轻松扩展至上万个核心,加速比超越 OpenAI 的大规模强化学习系统 Rapid。

- ReaLHF: Optimized RLHF Training for Large Language Models through Parameter Reallocation [3]: 最近,吴翼团队进一步实现了分布式 RLHF 训练框架 ReaLHF。吴翼团队的 ICML Oral 论文正是基于 ReaLHF 系统产出的。ReaLHF 系统经过长时间的开发,经历大量的细节打磨,达到最优性能。相比于之前的开源工作,ReaLHF 可以在 RLHF 这个比预训练更复杂的场景下达到近乎线性的拓展性,同时具有更高的资源利用率,在 128 块 A100 GPU 上也能稳定快速地进行 RLHF 训练,相关工作已开源:https://github.com/openpsi-project/ReaLHF

除了提升大语言模型代码能力之外,吴翼团队还采用多种将强化学习算法和大模型结合的方式,实现了多种复杂 LLM Agent,并可以和人类进行复杂交互。在 MiniRTS 中使用强化学习既能听从人类指令也能做出最优决策的语言智能体 [4]。

在狼人杀中训练策略多样化的强化学习策略以提升大模型的决策能力 [5]。

在 Overcooked 游戏中结合小模型与大模型实现能进行实时反馈的合作 Language Agent [6]。

结合强化学习训练的机器人控制策略与大语言模型推理能力让机器人能够执行一系列复杂任务 [7]。

为了使大模型能真正走进千家万户,对齐技术是至关重要的,对于学术界和大模型从业者来说,好的开源工作和论文无疑会大大降低实验成本和开发难度,也期待随着技术发展,会有更多服务于人类的大模型出现。[1] Yu, Chao, Akash Velu, Eugene Vinitsky, Jiaxuan Gao, Yu Wang, Alexandre Bayen, and Yi Wu. "The surprising effectiveness of ppo in cooperative multi-agent games."[2] Mei, Zhiyu, Wei Fu, Guangju Wang, Huanchen Zhang, and Yi Wu. "SRL: Scaling Distributed Reinforcement Learning to Over Ten Thousand Cores."[3] Mei, Zhiyu, Wei Fu, Kaiwei Li, Guangju Wang, Huanchen Zhang, and Yi Wu. "ReaLHF: Optimized RLHF Training for Large Language Models through Parameter Reallocation."[4] Xu, Shusheng, Huaijie Wang, Jiaxuan Gao, Yutao Ouyang, Chao Yu, and Yi Wu. "Language-guided generation of physically realistic robot motion and control."[5] Xu, Zelai, Chao Yu, Fei Fang, Yu Wang, and Yi Wu. "Language agents with reinforcement learning for strategic play in the werewolf game."[6] Liu, Jijia, Chao Yu, Jiaxuan Gao, Yuqing Xie, Qingmin Liao, Yi Wu, and Yu Wang. "Llm-powered hierarchical language agent for real-time human-ai coordination."[7] Ouyang, Yutao, Jinhan Li, Yunfei Li, Zhongyu Li, Chao Yu, Koushil Sreenath, and Yi Wu. "Long-horizon Locomotion and Manipulation on a Quadrupedal Robot with Large Language Models."以上是ICML 2024 Oral | DPO是否比PPO更适合LLM,清华吴翼团队最新揭秘的详细内容。更多信息请关注PHP中文网其他相关文章!