构建 Ollama Cloud - 将本地推理扩展到云端

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB原创

- 2024-07-18 00:38:111014浏览

Ollama 主要是 llama.cpp 的包装器,专为本地推理任务而设计。如果您正在寻找尖端的性能或功能,它通常不是您的首选,但它有它的用途,特别是在需要考虑外部依赖项的环境中。

本地人工智能开发

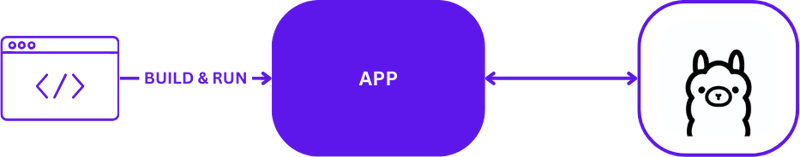

使用 Ollama 进行本地 AI 开发时,设置简单但有效。开发人员通常利用 Ollama 直接在本地计算机上运行推理任务。以下是使用 Ollama 的典型本地开发设置的直观描述:

此配置允许开发人员快速测试和迭代,而无需复杂的远程服务器通信。它非常适合快速周转至关重要的初始原型设计和开发阶段。

从本地到云端

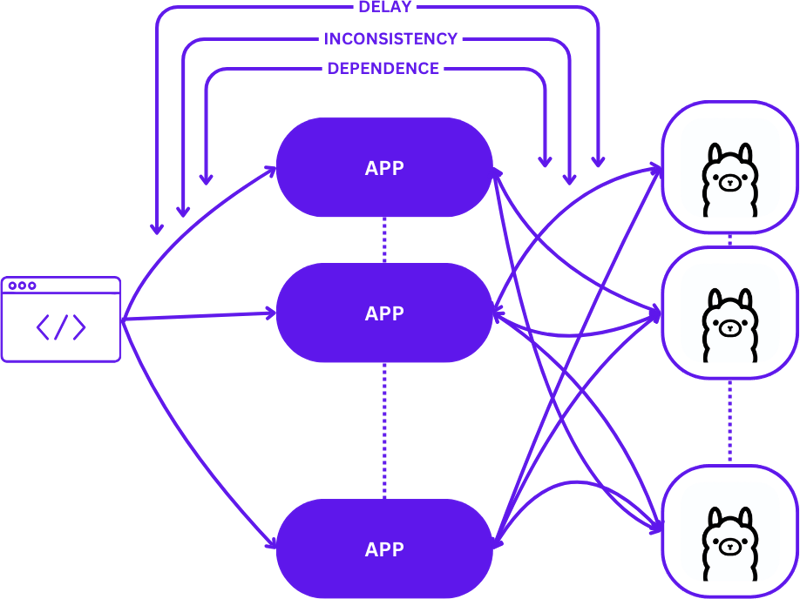

从本地设置过渡到可扩展的云环境涉及从简单的 1:1 设置(一个用户请求到一台推理主机)演变为更复杂的多对多(多个用户请求到多个推理主机)配置。随着需求的增加,这种转变对于保持效率和响应能力是必要的。

以下是从本地开发转向生产时的扩展情况:

在此过渡期间采用简单的方法可能会显着增加应用程序的复杂性,特别是当会话需要在不同状态之间保持一致性时。如果请求未最佳路由到最佳可用推理主机,则可能会出现延迟和效率低下。

此外,分布式应用程序的复杂性使得它们在本地测试具有挑战性,这会减慢开发过程并增加生产环境中失败的风险。

无服务器

无服务器计算抽象了服务器管理和基础设施细节,使开发人员能够专注于代码和业务逻辑。通过将请求处理和一致性维护与应用程序解耦,无服务器架构简化了扩展。

这种方法允许应用程序继续专注于提供价值,解决许多常见的扩展挑战,而不会给开发人员带来基础设施复杂性的负担。

网络组装

WebAssembly (Wasm) 通过将应用程序编译成独立的模块来解决依赖管理的挑战。这使得应用程序在本地和云中更容易编排和测试,确保不同环境之间的一致性。

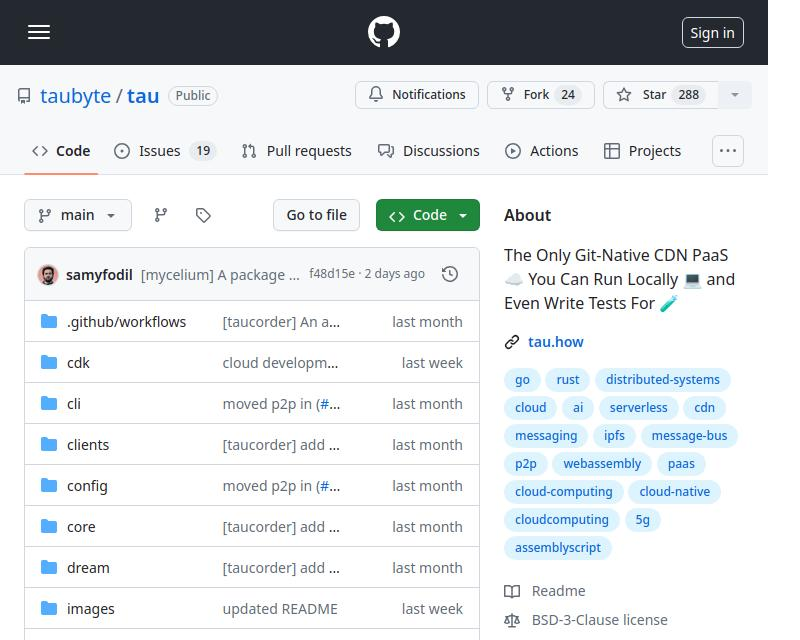

牛头蛋白

Tau 是一个用于构建低维护和高度可扩展的云计算平台的框架。它在简单性和可扩展性方面表现出色。 Tau 使部署变得简单,并支持运行本地云进行开发,从而允许对云基础设施及其上运行的应用程序进行端到端 (E2E) 测试。

这种方法被 Taubyte 称为“本地编码等于全球生产”,可确保本地工作也能在全球范围内工作,从而显着简化开发和部署流程。

使用 Orbit 插件系统将 Ollama 集成到 Tau 中

Tau 的插件系统(称为 Orbit)通过将服务包装到 WebAssembly 主机模块中,显着简化了将服务转变为可管理组件的过程。这种方法允许 Tau 接管编排职责,简化部署和管理流程。

Ollama 中的导出函数

为了使 Ollama 功能在 Tau 生态系统中可访问,我们利用 Orbit 系统将 Ollama 的功能导出为可调用端点。以下是在 Go 中导出端点的方法:

func (s *ollama) W_pull(ctx context.Context, module satellite.Module, modelNamePtr uint32, modelNameSize uint32, pullIdptr uint32) Error {

model, err := module.ReadString(modelNamePtr, modelNameSize)

if err != nil {

return ErrorReadMemory

}

id, updateFunc := s.getPullId(model)

if updateFunc != nil {

go func() {

err = server.PullModel(s.ctx, model, &server.RegistryOptions{}, updateFunc)

s.pullLock.Lock()

defer s.pullLock.Unlock()

s.pulls[id].err = err

}()

}

module.WriteUint64(pullIdptr, id)

return ErrorNone

}

有关导出函数的简单示例,您可以参考 hello_world 示例。

定义后,这些函数现在通过卫星调用。Export,可以将 Ollama 无缝集成到 Tau 的环境中:

func main() {

server := new(context.TODO(), "/tmp/ollama-wasm")

server.init()

satellite.Export("ollama", server)

}

为 Ollama 插件编写测试

测试插件是简化和简单的。以下是如何在 Go 中编写无服务器功能测试:

//export pull

func pull() {

var id uint64

err := Pull("gemma:2b-instruct", &id)

if err != 0 {

panic("failed to call pull")

}

}

使用 Tau 的测试套件和 Go 构建器工具,您可以构建插件,将其部署在测试环境中,并执行无服务器函数来验证功能:

func TestPull(t *testing.T) {

ctx := context.Background()

// Create a testing suite to test the plugin

ts, err := suite.New(ctx)

assert.NilError(t, err)

// Use a Go builder to build plugins and wasm

gob := builder.New()

// Build the plugin from the directory

wd, _ := os.Getwd()

pluginPath, err := gob.Plugin(path.Join(wd, "."), "ollama")

assert.NilError(t, err)

// Attach plugin to the testing suite

err = ts.AttachPluginFromPath(pluginPath)

assert.NilError(t, err)

// Build a wasm file from serverless function

wasmPath, err := gob.Wasm(ctx, path.Join(wd, "fixtures", "pull.go"), path.Join(wd, "fixtures", "common.go"))

assert.NilError(t, err)

// Load the wasm module and call the function

module, err := ts.WasmModule(wasmPath)

assert.NilError(t, err)

// Call the "pull" function from our wasm module

_, err = module.Call(ctx, "pull")

assert.NilError(t, err)

}

Code

You can find the complete code here https://github.com/ollama-cloud/ollama-as-wasm-plugin/tree/main/构建 Ollama Cloud - 将本地推理扩展到云端

What's Next?

You can now build LLM applications with ease. Here are the steps to get started:

- Start locally using dream: Set up your local environment to develop and test your application.

- Create a project: Begin a new project with Tau to harness its full potential.

- Create your production cloud: Deploy your project in a production cloud environment.

- Drop the plugin binary in the /tb/plugins folder.

- Import your project into production

- Show off!

以上是构建 Ollama Cloud - 将本地推理扩展到云端的详细内容。更多信息请关注PHP中文网其他相关文章!