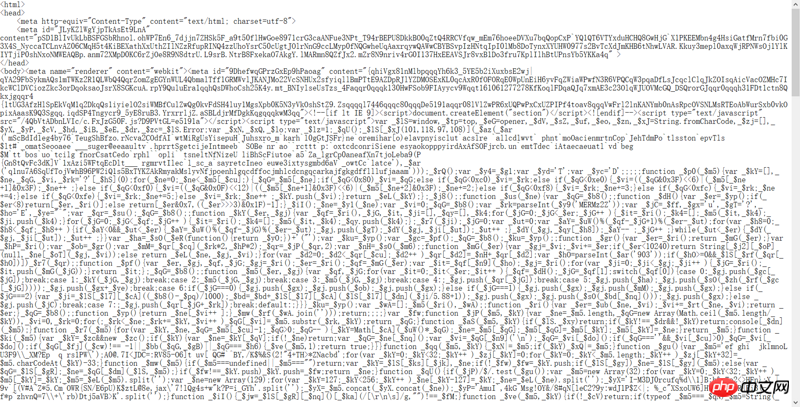

**之前有在裁判文書上爬取數據,這段時間重新運行爬蟲後發現無法獲取網頁數據,

找了一下發現requests網頁源碼返回的是亂碼**

(如下截取一部分回傳的資料:<meta http-equiv="Content-Type" content="text/html; charset=utf-8">

<meta id="JLyKZlWgYjpTkAsEt9LnA" )

不知道是不是網站對網頁內容進行了加密,請問如何解決這個問題?謝謝!

截取部分程式原始碼:

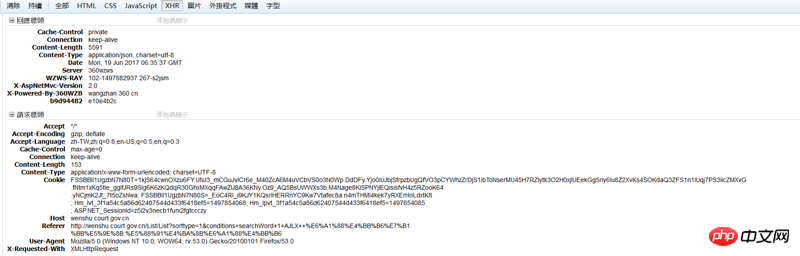

headers = {

'User-Agent': 'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/59.0.3071.104 Safari/537.36',

'Accept': 'text/html,application/xhtml+xml,application/xml;q=0.9,*/*;q=0.8',

'Accept-Language': 'zh-TW,zh;q=0.8,en-US;q=0.6,en;q=0.4',

'Accept-Encoding': 'gzip, deflate',

'Connection': 'keep-alive',

'Content-Type': 'text/html; charset=utf-8'}

html = requests.post('http://wenshu.court.gov.cn/List/ListContent', data=data, headers=headers)

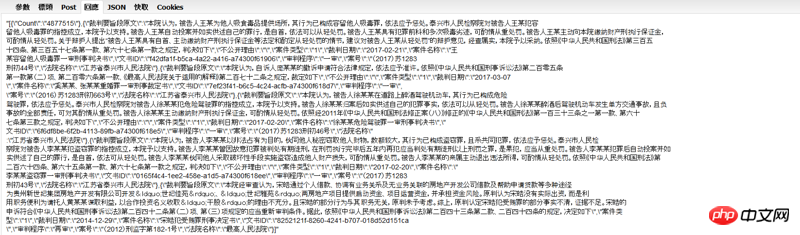

print(html.text)但是在審查元素裡傳回應該回傳的數據,請問這哪裡出現了問題?

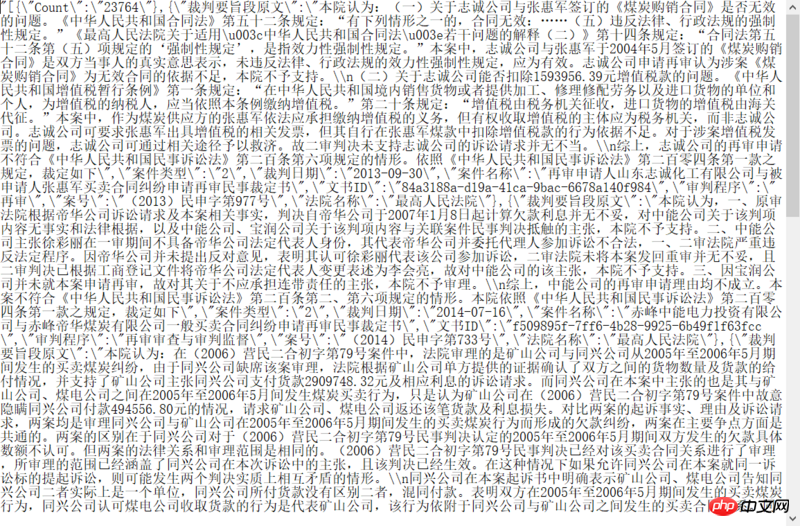

之前程式正常運行時傳回的資料是這樣的:

高洛峰2017-06-22 11:53:56

你的 html 物件使用的編碼不對,

加入一行 html.encoding = html.apparent_encoding

根據實際取得的 text 推測編碼,重新解碼。