最新中文大模式評測出爐,騰訊混元居卓越領導者象限

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2024-05-06 21:13:321396瀏覽

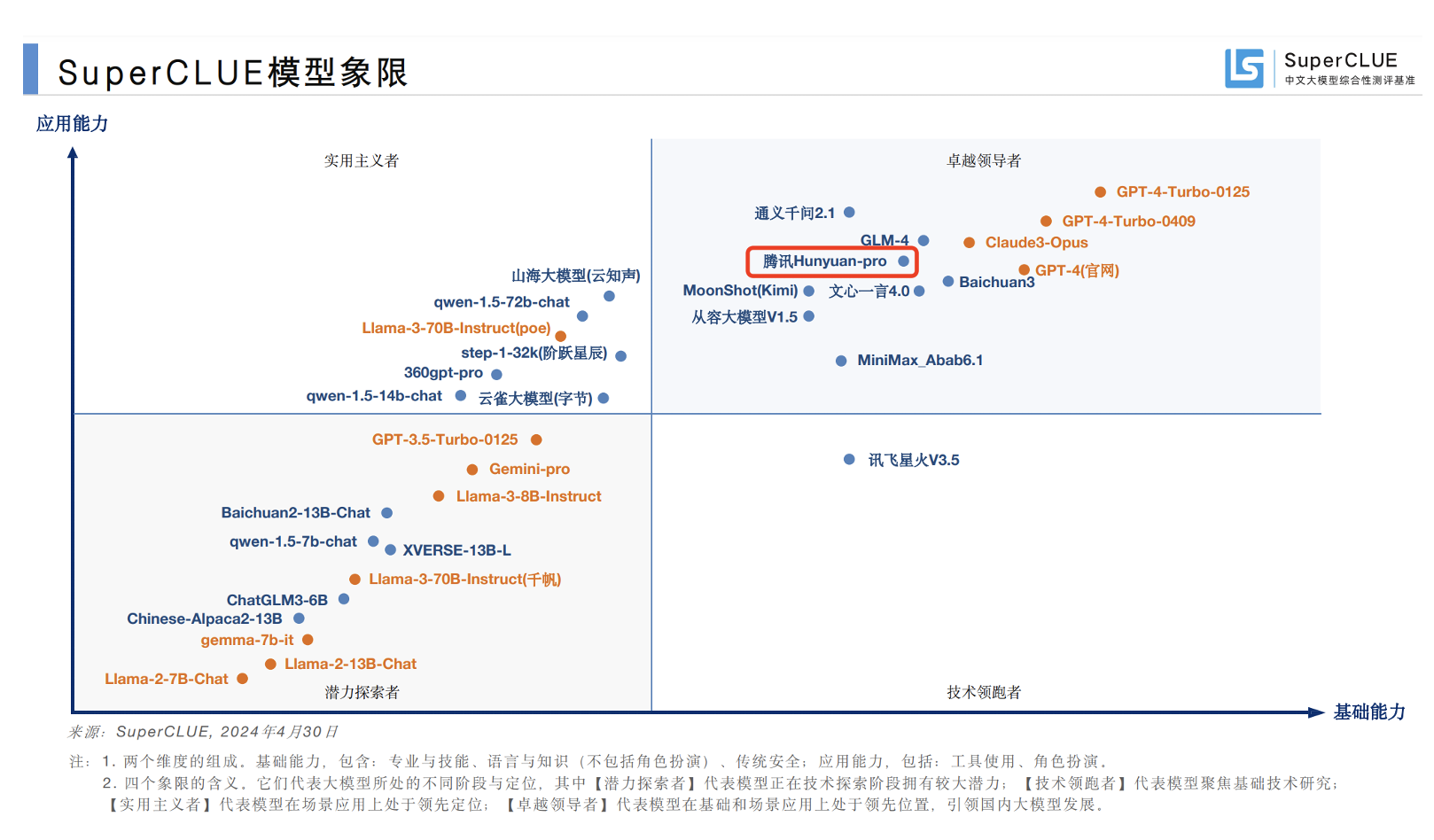

記者5月6日報道,國內權威的大模型評測機構SuperCLUE最新發布了《中文大模型基準測試2024年度第4季報告》。其中,騰訊混元大模型位列國內大模型第一梯隊,基礎和場景應用上均處於領先位置,位於卓越領導者象限。

SuperCLUE是國內權威的通用大模型綜合性評估基準,它前身是知名的第三方中文語言理解測試基準CLUE(The Chinese Language Understanding Evaluation)。 SuperCLUE基於通用大模型在學術、產業和用戶面的廣泛應用,構建了多層次、多維度的綜合性評估基準,由十大基礎任務組成,包括邏輯推理、代碼、語言理解、長文本、角色扮演等。

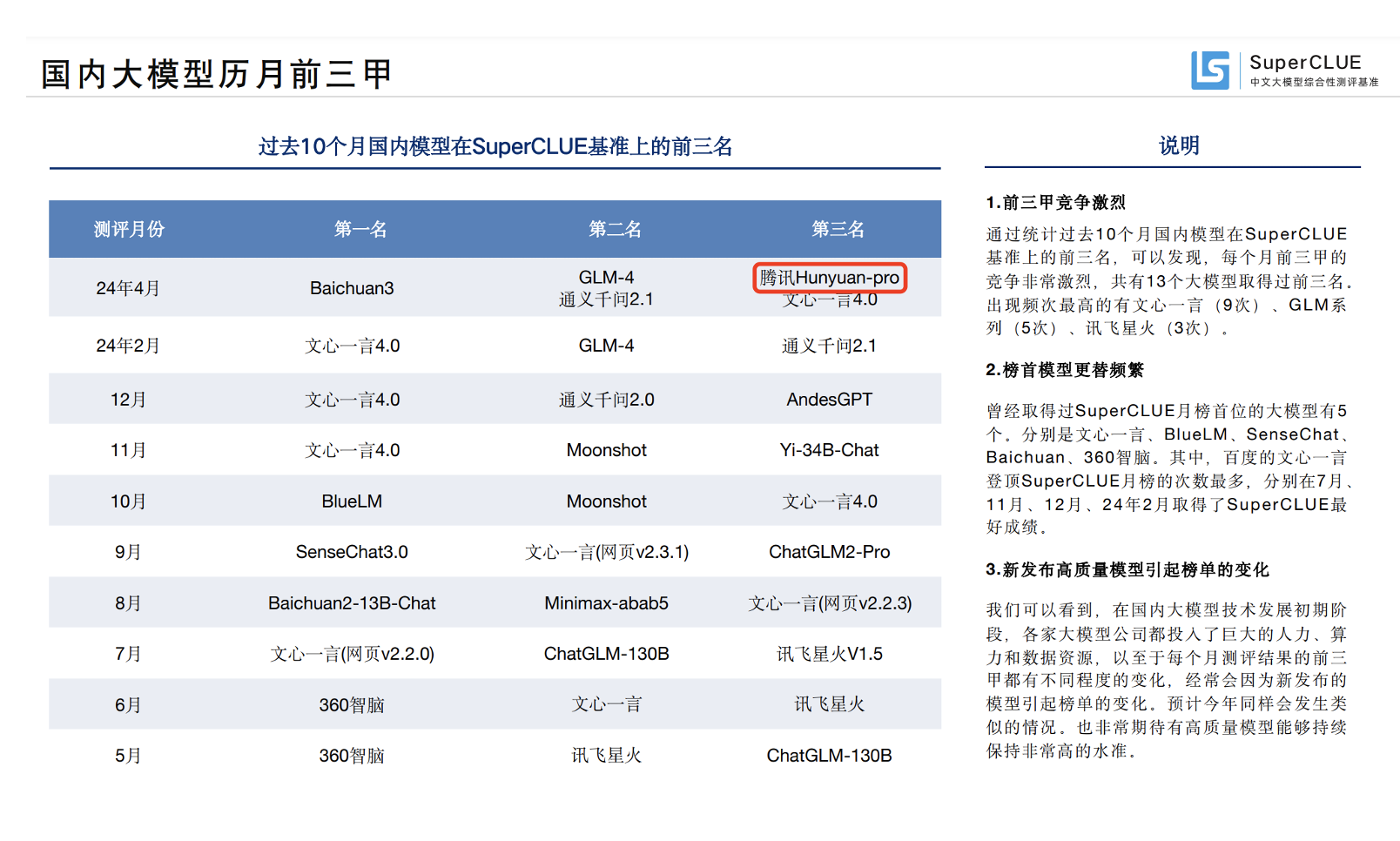

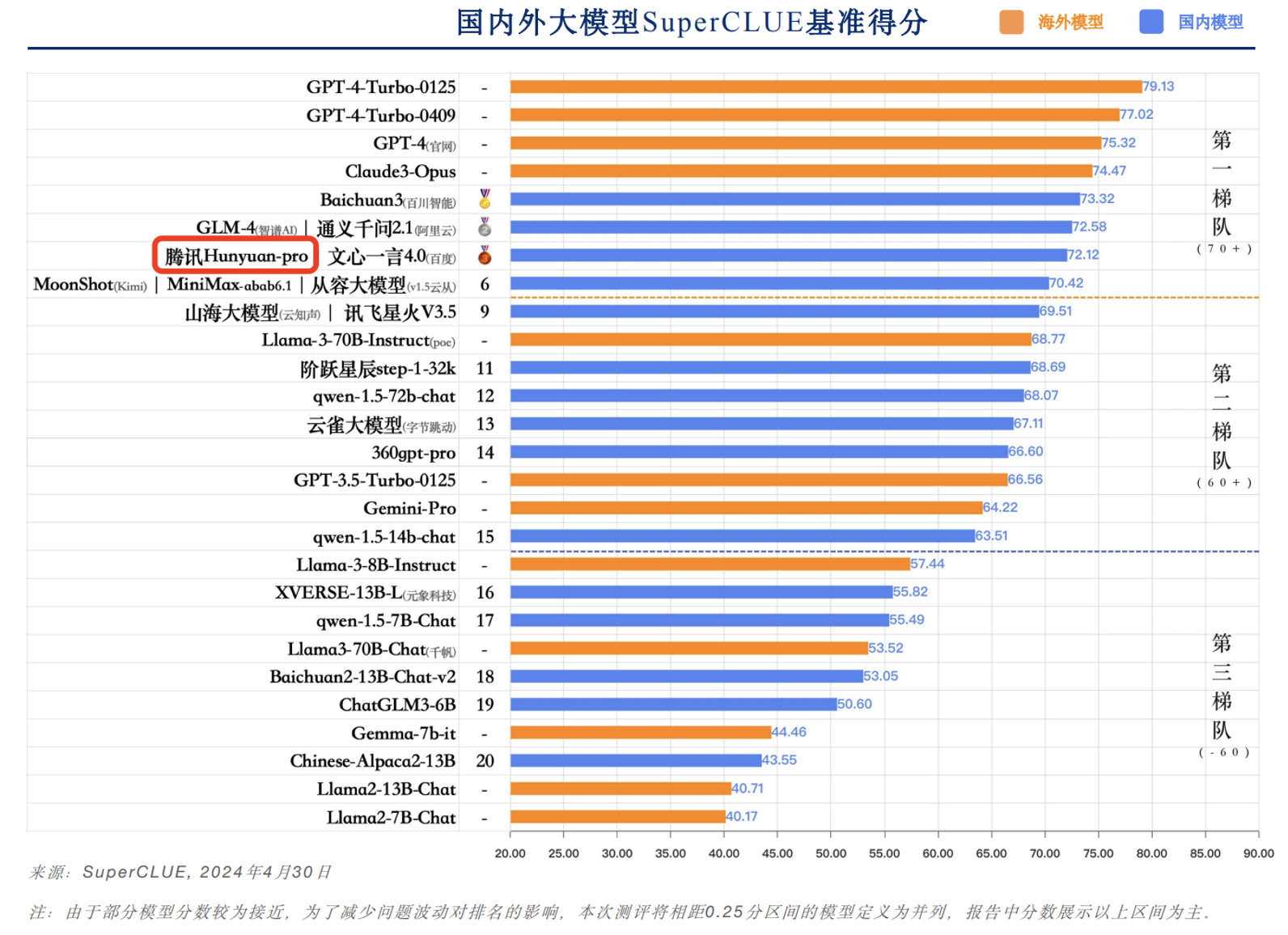

本報告選取了國內外具有代表性的32個大模型4月份的版本,透過多維度綜合性測評,真實準確地反映了國內外大模型在中文領域的綜合能力和發展現狀。在測評報告的總分排名上,騰訊混元大模型位列前三,體現了領先的模式實力。

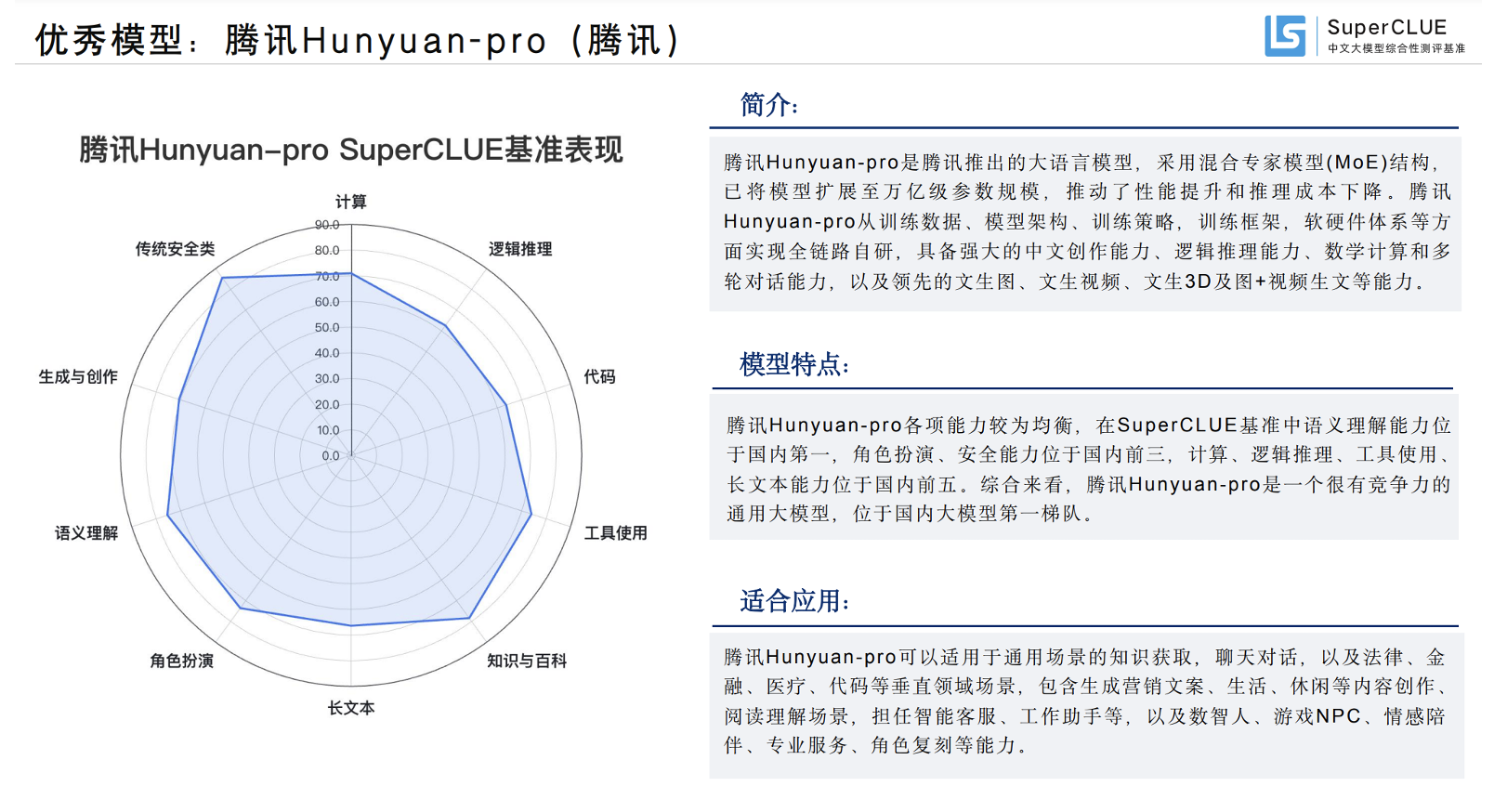

在十大能力得分中,騰訊混元大模型的各項能力較為均衡,在語義理解能力上,得分為75.4的高分排名國內第一;在角色扮演、安全能力、計算、邏輯推理、工具使用、長文本能力上,也均處於位於國內一流水準。

查看全文,國內大模型的第一梯隊已經達到或接近國際一流的水平,其中既有騰訊混元、文心一言、通識千問等來自大廠的大模型,也有GLM-4、Baichuan3、Moonshot和Minimax等大型模型新創公司的代表。

深入了解後,混元大模型作為騰訊基於全鏈路自主可控技術打造的實用級大模型,自2023年9月首次亮相以來,通過持續迭代和實踐,累積了從底層算力到機器學習平台再到上層應用的完整自主技術。

騰訊擁有自研的星脈高效能運算網絡,可為AI大模型帶來10倍通訊效能提升;在訓練與推理架構上,騰訊自研的機器學習平台訓練速度是主流框架的2.6倍,大模型推理成本相較於業界主流框架下降70%;演算法上,騰訊混元大模型率先採用混合專家模型(MoE)結構,模型整體效果相比上代模型提升50%。

最近,騰訊聯合北京大學、北京科技大學共同完成的研究《面向大規模數據的Angel機器學習平台關鍵技術及應用》,也斬獲2023中國電子學會科學技術獎一等獎,體現了騰訊深厚的自研技術累積。

在應用程式上,騰訊混元大模型已經支援了騰訊內部超過400個業務和場景接入,騰訊旗下協作SaaS產品全面接入混元,並實現了智慧化升級。騰訊混元也已經透過騰訊雲面向企業和個人開發者全面開放。

目前,騰訊混元大模型參數量超過兆,tokens數超過7兆。先前國際權威研究機構沙利文發布的《2024年中國大模型能力評測》顯示,騰訊混元在通用基礎能力和專業應用能力已居國內第一梯隊。

以上是最新中文大模式評測出爐,騰訊混元居卓越領導者象限的詳細內容。更多資訊請關注PHP中文網其他相關文章!