關於面向機器人操作的世界模型的一點思考

- 王林轉載

- 2024-04-28 17:31:10841瀏覽

近年來,世界模範的火熱似乎可以在機器人操作中發揮一些至關重要的作用。而對於具身智能來說,現階段manipulation是最需要突破的點。特別是針對以下long horizon的任務,如何建造機器人“小腦”,來實現各種複雜的操作要求,是當下最需要解決的問題。

是否需要透過拆分skill為原子運算?

在使用LM應用在機器人上時,比較常用的做法是將各類API提供在context裡面,然後讓LLM根據任務prompt自動寫planning程式碼,可參考文章:

這種方法優點是非常直觀,可以比較清晰地掌握任務的拆解邏輯,例如移動到A,抓起B,移動到C,放下B。但是這種操作的前提是能夠把整個任務拆分成原子操作(移動、抓取、放置等)。但是如果是一些比較複雜的任務,例如疊衣服這種任務,其是天然難以進行任務分割的,那這個時候該怎麼辦?其實對於manipulation來說,我們大量面對的應該是這種long horizon且難以進行拆分的任務。

世界模型可以作為關鍵突破點

針對long horizon且難以進行拆分的manipulation任務,比較好的處理方法是研究模仿學習,例如diffusion policy或ACT這種,對整個操作trajectory進行建模擬合。但這種方法都會遇到一個問題,就是沒有辦法很好的處理累積誤差──而這個問題的本質就是缺乏一套有效地回饋機制。

還是以疊衣服為例,人在疊衣服的時候,其實會根據視覺獲取的衣服變化,不斷地調整操作策略,最終將衣服疊到想要的樣子。那這個裡面其實有一個比較隱含但是很重要的重點:人大概知道什麼樣的操作,會導致衣物發生什麼樣的變化。那麼進一步,就是人其實具備一個關於衣物變形的模型,能夠大概知道什麼樣的輸入,會導致狀態(衣物擺放)的變化(視覺層面就是像素級別),更加具體的可以表示為:

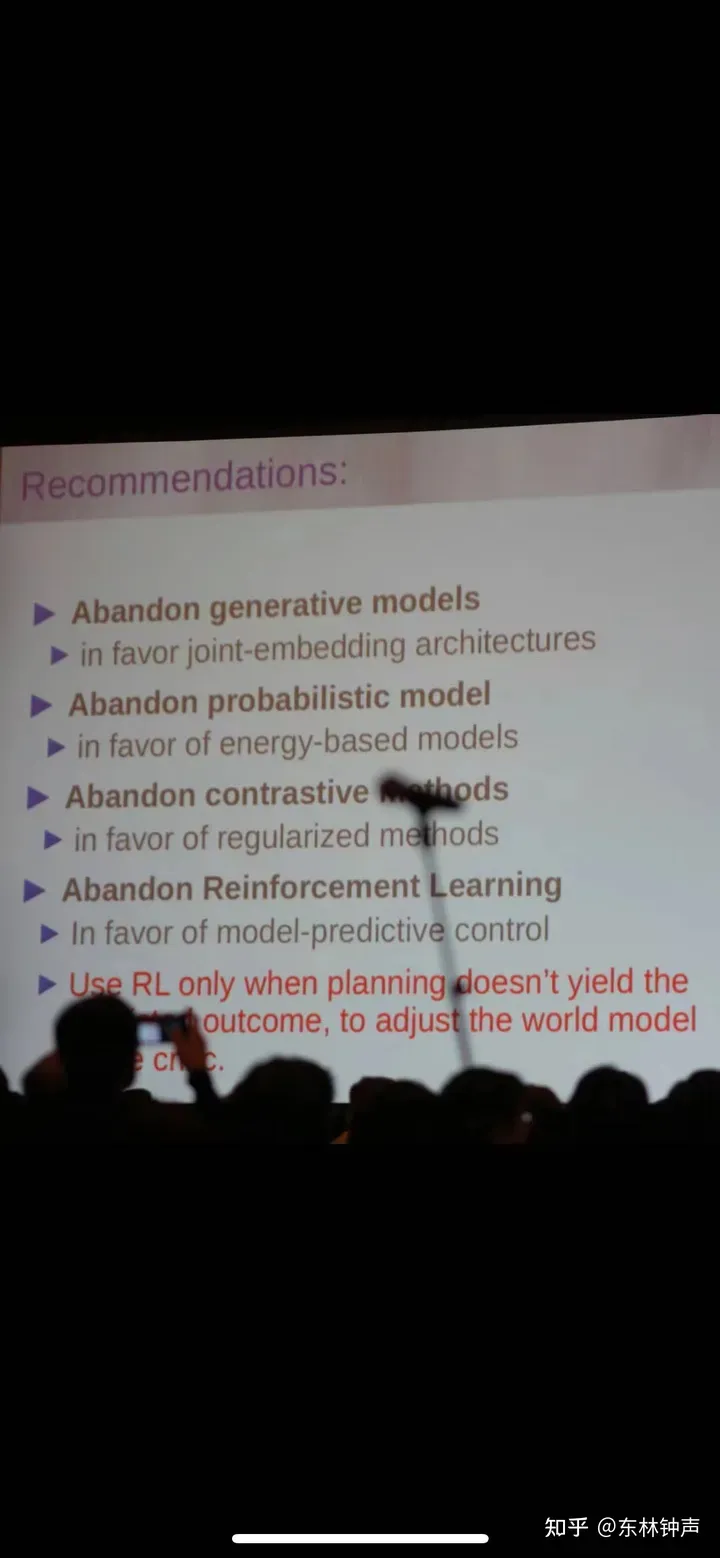

SORA其實給了一劑強心針,就是只要數據夠多,我能用transformer diffusion layer,硬train一個可以理解並預測變化的模型f。假設我們已經有了一個非常強的預測衣物隨操作變化的模型f,那這個時候疊衣服就可以透過像素層級的衣物狀態回饋,透過Model Predictive Control的思路,建構一個視覺伺服(Visual Servo)的策略,將衣服疊到我們想要的狀態。這點其實在LeCun最近的一些「暴論」上也得到了驗證:

如何建構一個面向機器人操作的世界模型

以上是關於面向機器人操作的世界模型的一點思考的詳細內容。更多資訊請關注PHP中文網其他相關文章!