Snowflake 發布高「企業智慧」模型 Arctic,專注於企業內部應用。 剛剛,資料管理和倉庫供應商Snowflake 宣布加入LLM 混戰,發布了一款專注於企業級應用的頂級大型語言模型(LLM)——Snowflake Arctic 。 作為雲端運算公司推出的LLM,Arctic 主要具備以下兩個面向的優勢:

- 高效能智慧:Arctic 在企業任務方面表現出色,例如SQL 產生、程式設計和指令遵循,甚至可與使用更高運算成本訓練的開源模型媲美。 Arctic 為經濟高效的訓練設定了新的基線,使 Snowflake 客戶能夠以低成本為其企業需求創建高品質的客製化模型。

- 開源開放:Arctic 採用 Apache 2.0 許可,提供對權重和程式碼的開放訪問,Snowflake 還將開源所有的資料方案和研究發現。

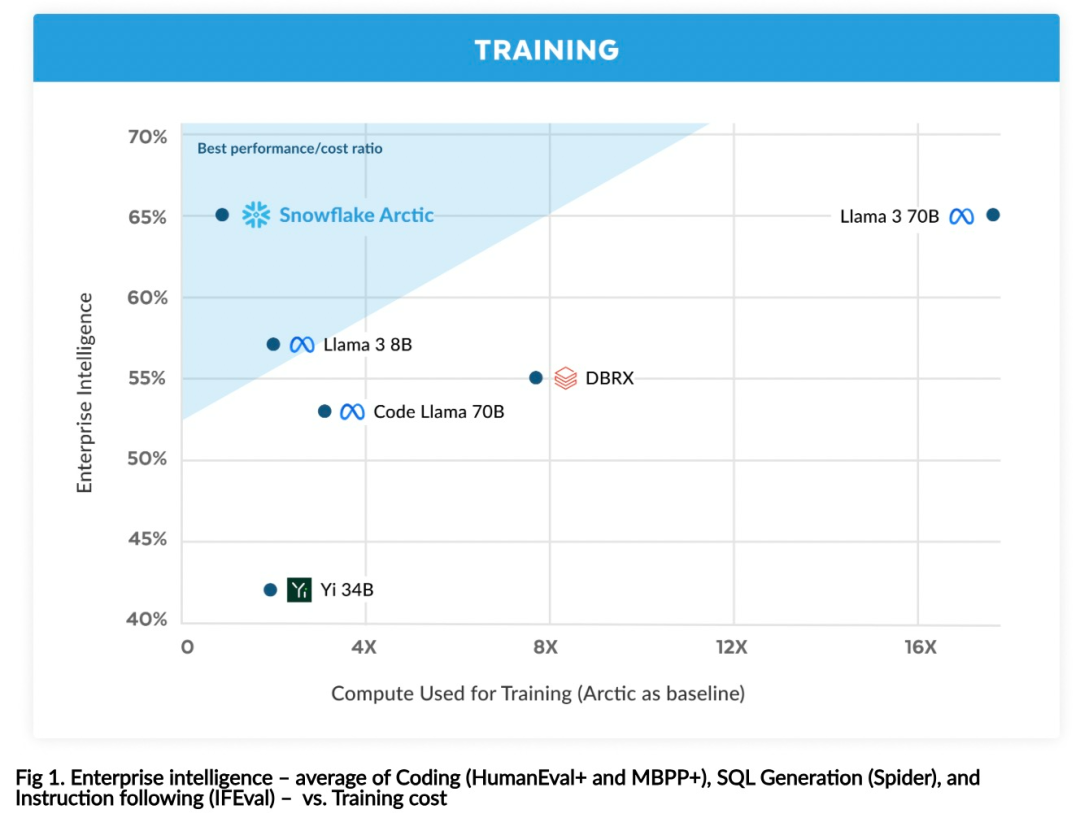

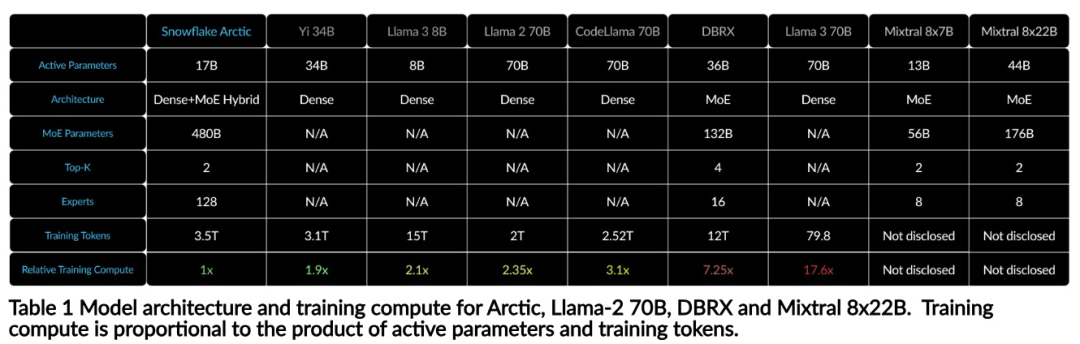

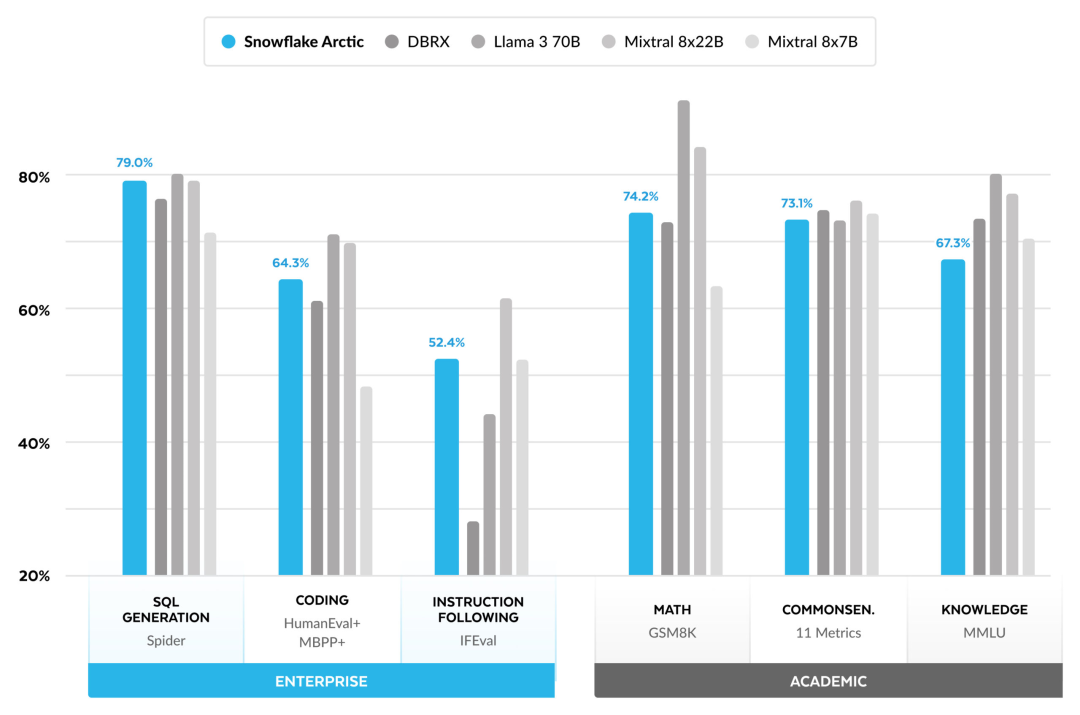

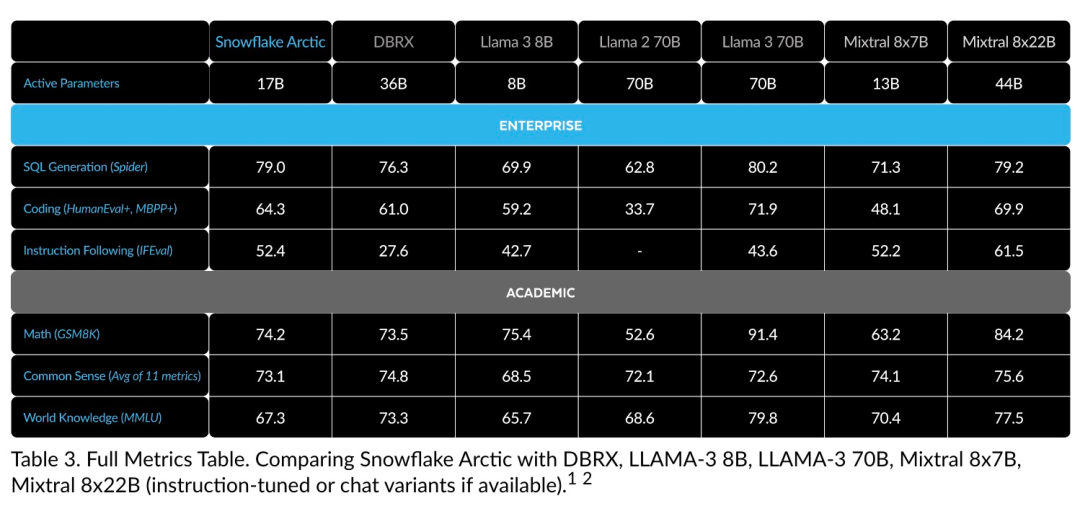

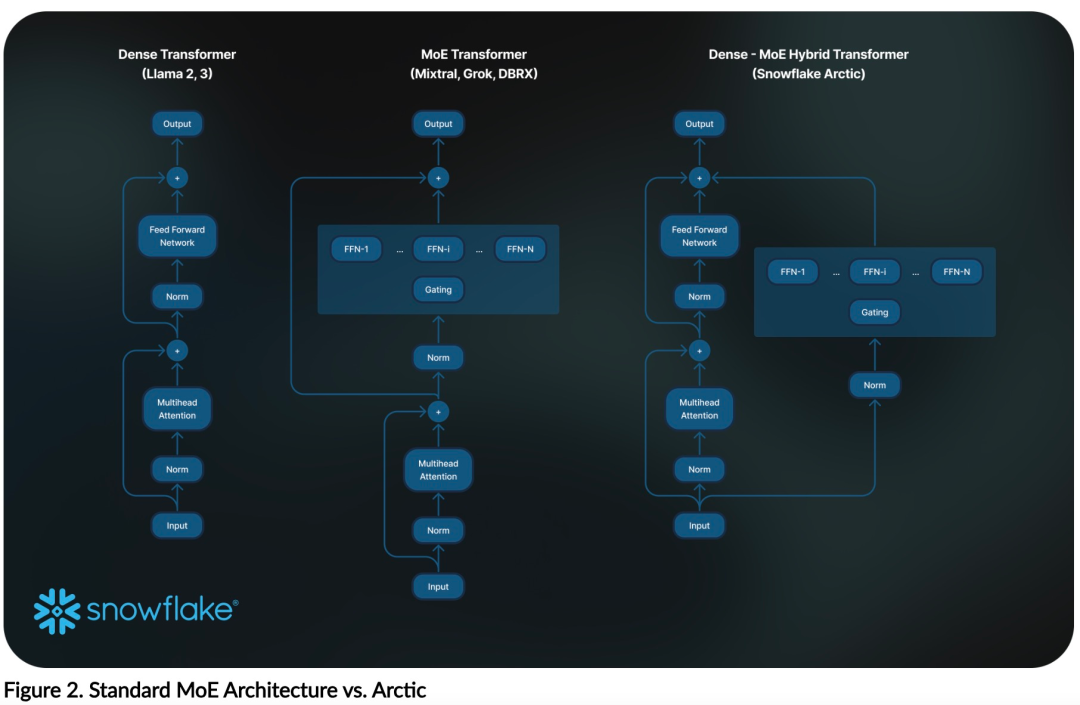

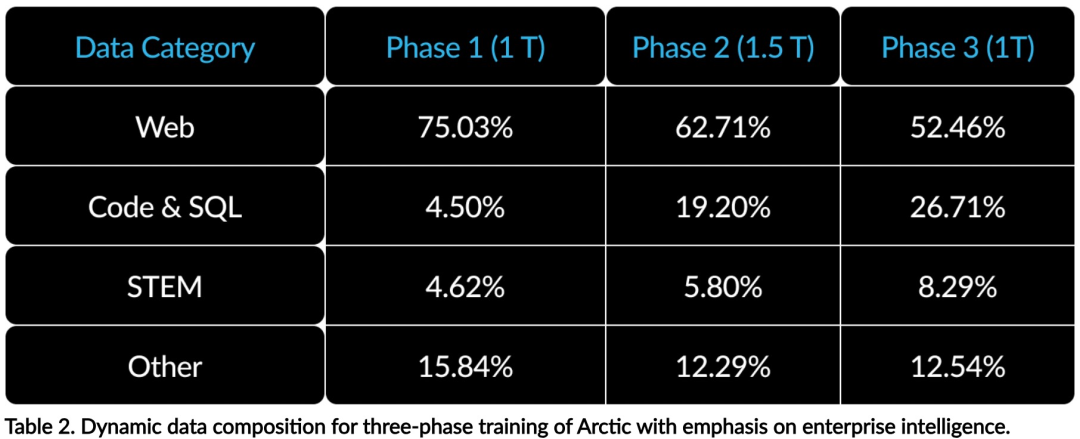

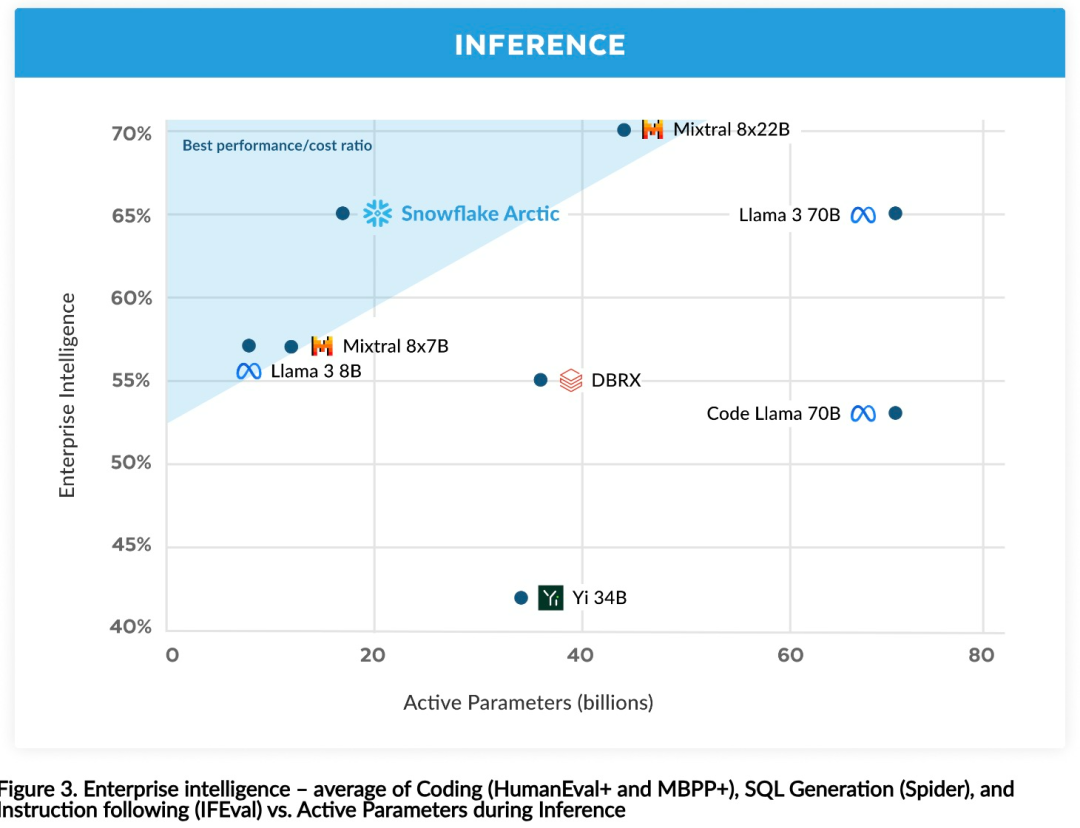

現在,你可以在 Hugging Face 上存取 Arctic 模型。 Snowflake 表示:使用者很快可以透過一些模型庫取得,包括 Snowflake Cortex、AWS、微軟 Azure、NVIDIA API、Lamini、Perplexity、Replicate 和 Together 等。 Hugging Face:https://huggingface.co/Snowflake/snowflake-arctic-instructArctic 的上下文視窗設定為4K,研究團隊正在研發基於注意力池(attention-sink)的滑動視窗實現,在未來幾週內將支援無限序列生成,並在不久的將來擴展到32K 注意力視窗。 #Snowflake 的研究團隊從企業客戶的AI需求和使用案例中看到了一個一致的模式:企業希望使用LLM 建立對話式SQL 資料copilot、程式碼copilot 和RAG 聊天機器人。 這表示 LLM 需要在 SQL、程式碼、複雜指令遵循和產生特定回應方面表現出色。 Snowflake 將這些能力融合成一個稱為「企業智慧」的單一指標,具體方式是對編碼(HumanEval 和 MBPP )、SQL 生成(Spider)和指令遵循(IFEval)效能水準取平均值。 Arctic 在開源LLM 中達到了頂級的「企業智慧」水平,而且是在大約不到200 萬美元的訓練運算成本(少於3K GPU 週)的情況下做到的。這意味著 Arctic 比其他使用類似運算成本訓練的開源模型能力更強。 更重要的是,即使與那些使用遠高於其的運算成本訓練的模型相比,Arctic 在企業智慧方面也表現出色。 Arctic 的高訓練效率意味著 Snowflake 的客戶和整個 AI 社群可以以更經濟的方式訓練客製化模型。 如圖 1 所示,Arctic 在企業智慧指標上與 LLAMA 3 8B 和 LLAMA 2 70B 不相上下,而使用的訓練計算成本不到一半。並且,儘管僅使用1/17 倍的計算成本,Arctic 在編碼(HumanEval 和MBPP )、SQL(Spider)和指令遵循(IFEval)等指標上可與Llama3 70B 媲美,即Arctic 在保持整體性能競爭力的同時做到了這一點。 此外,Snowflake 也在學術基準上評估了Arctic,涉及世界知識、常識推理和數學能力,完整評估結果如下圖中所示:############################################## #######為了達到上述訓練效率,Arctic 採用獨特的Dense-MoE 混合transformer 架構。它將一個 10B 的密集 transformer 模型與一個 128×3.66B 的殘差 MoE MLP 結合起來,總共有 480B 參數和 17B 活躍參數,使用 top-2 gating 來進行選擇。设计和训练 Arctic 时,研究团队使用了以下三个关键的见解和创新:2021 年底,DeepSpeed 团队证明了 MoE 可以应用于自回归 LLM,从而显著提高模型质量而不增加计算成本。在设计 Arctic 时,研究团队注意到,基于这个思路,模型质量的提高主要取决于 MoE 模型中的专家数量和总参数量,以及这些专家的组合方式数量。基于此,Arctic 被设计为在 128 个细粒度(fine-grained)专家之间分布 480B 参数,并使用 top-2 gating 来选择 17B 活跃参数。在强大的 AI 训练硬件上训练具有大量专家的基本 MoE 架构非常低效,因为专家之间的全连接通信开销很高。Snowflake 发现,如果通信可以与计算重叠,就可以省去这种开销。因此,Arctic 将密集 transformer 与残差 MoE 组件相结合(图 2),通过通信计算重叠,使训练系统能够实现良好的训练效率,隐藏了通信开销的大部分。在代码生成和 SQL 等企业级指标上表现出色需要与通用指标截然不同的数据课程学习(Curriculum Learning)。通过数百次小规模的消融实验,该团队了解到通用技能,如常识推理,可以在初始阶段学习;而编码、数学和 SQL 等更复杂的指标可以在训练后期有效学习。这可以类比于人类的生活教育,从简单到困难逐步获取能力。因此,Arctic 使用一个三阶段的课程学习,每个阶段的数据构成都不同,第一阶段侧重于通用技能(1T token),后两个阶段侧重于企业技能(1.5T 和 1T token)。推理效率也是模型高效的一个重要方面,影响到模型是否可以在低成本下进行实际部署。Arctic 代表了 MoE 模型规模的一次飞跃,它比任何其他开源自回归 MoE 模型都使用了更多的专家和总参数。因此,Snowflake 需要几个创新思路来确保 Arctic 能够高效推理:a) 在批大小较小的交互推理中,例如批大小为 1,MoE 模型的推理延迟受制于读取所有活跃参数的时间,推理是受内存带宽限制的。在这种批大小下,Arctic(17B 活跃参数)的内存读取量仅为 Code-Llama 70B 的 1/4、Mixtral 8x22B(44B 活跃参数)的 2/5,从而具备更快的推理速率。b) 当批大小显著增加,例如每次前向传递数千个 token 时,Arctic 从内存带宽受限转变为计算受限,推理受到每个 token 的活跃参数的限制。在这方面,Arctic 的计算量是 CodeLlama 70B 和 Llama 3 70B 的 1/4。为了实现计算受限的推理和与 Arctic 中少量活跃参数相匹配的高吞吐量,需要一个较大的批大小。实现这一点需要有足够的 KV 缓存来支持,同时还需要足够的内存来存储模型的近 500B 参数。虽然具有挑战性,但 Snowflake 通过使用两个节点进行推理,并结合 FP8 权重、split-fuse 和连续批处理、节点内张量并行以及节点间 pipeline 并行等系统优化来实现。研究团队已与 NVIDIA 展开密切合作,针对由 TensorRT-LLM 驱动的 NVIDIA NIM 微服务进行推理优化。同时,研究团队还与 vLLM 社区合作,内部开发团队也将在未来几周内为企业用例实现 Arctic 的高效推理。参考链接:https://www.snowflake.com/blog/arctic-open-efficient-foundation-language-models-snowflake/以上是僅需Llama3 1/17的訓練成本,Snowflake開源128x3B MoE模型的詳細內容。更多資訊請關注PHP中文網其他相關文章!