原標題:LidarDM: Generative LiDAR Simulation in a Generated World

論文連結:https://arxiv.org/pdf/2404.02903.pdf

程式碼連結:https ://github.com/vzyrianov/lidardm

作者單位:伊利諾大學麻省理工學院

##論文想法:

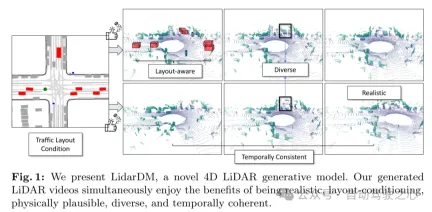

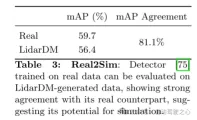

本文介紹了LidarDM,這是一種新穎的雷射雷達生成模型,能夠產生逼真、佈局感知、物理可信以及時間上連貫的雷射雷達視訊。 LidarDM在雷射雷達生成建模方面具有兩個前所未有的能力:(一)由駕駛場景引導的雷射雷達生成,為自動駕駛模擬提供了重大激勵;(二)4D光達點雲生成,使得創建逼真且時間上連貫的雷射雷達序列成為可能。本文模型的核心是一個新穎的綜合4D世界生成架構。具體來說,本文採用隱性擴散模型(latent diffusion models)來產生3D場景,將其與動態參與者(dynamic actors)結合,形成底層的4D世界,然後在這個虛擬環境中產生逼真的雷射感知數據。本文的實驗表明,本文的方法在逼真度、時間連貫性和佈局一致性方面優於競爭演算法。本文也展示了LidarDM可作為生成世界模擬器,用於訓練和測試感知模型。網頁設計:

制定的生成模型在處理資料分佈和內容創作方面已經越來越引起人們的關注,例如在圖像和視訊生成[ 10, 33, 52-55]、3D物體生成[10,19,38,52]、壓縮[5,29,68]以及編輯[37,47]等領域。生成模型對於模擬[6, 11, 18, 34, 46, 60, 64, 66, 76, 82]也表現出出色的潛力,能夠創建逼真的場景及其相關的感知數據,用於訓練和評估安全關鍵的智慧能力,如機器人和自動駕駛車輛,無需昂貴的手工建模現實世界。這些能力對於依賴廣泛的環境訓練或場景測試的應用至關重要。 在條件影像和影片產生方面的進展非常顯著,但自動駕駛應用產生功能特定場景下逼真的光達點雲序列的具體任務仍未得到充分探索。目前的光達產生方法主要分為兩大類,每一類都面臨特定的挑戰。- 目前的雷射雷達生成建模方法[8, 72, 79, 83]僅限於單幀生成,並且沒有提供語義可控性和時間一致性的手段。

- 雷射雷達重模擬(resimulation)[14, 17, 46, 65, 67, 74]嚴重依賴使用者創建或現實世界收集的資產。這增加了高昂的操作成本,限制了多樣性,並限制了更廣泛的應用性。

圖 1:本文展示了 LidarDM,這是一個新穎的 4D 雷射雷達生成模型。本文產生的光達影片同時具有逼真性、佈局條件性、物理可信性、多樣性和時間連貫性的優勢。

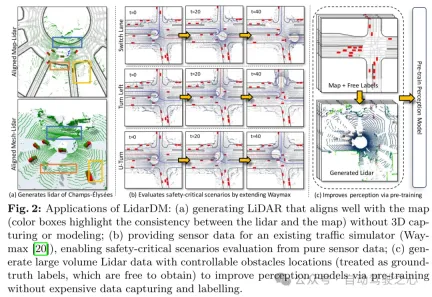

圖2:LidarDM 的應用:(a) 在沒有3D 捕捉或建模的情況下產生與地圖緊密對齊的雷射雷達(彩色框突出顯示雷射雷達與地圖之間的一致性);(b) 為現有的交通模擬器(Waymax [20])提供感測器數據,使其能夠僅從純感測器數據評估安全關鍵場景;(c) 產生具有可控障礙物位置的大量光達資料(被視為免費獲得的真實標籤),以透過無需昂貴資料捕捉和標註的預訓練來改進感知模型。

圖 3:LidarDM 概覽:給定時間 t = 0 時的交通佈局輸入,LidarDM 首先產生交通參與者(actors)和靜態場景。然後,本文產生交通參與者(actors)和自車的運動,並建構底層的 4D 世界。最後,使用基於生成和物理的模擬來創建逼真的 4D 感測器數據。

圖 4:本文的 3D 場景產生流程。首先,累積的點雲被用來重建每個真實網格樣本。接下來,訓練一個變分自編碼器(VAE)將網格壓縮成隱式編碼。最後,訓練以地圖為條件的擴散模型,在 VAE 的隱空間內進行取樣,產生新的樣本。

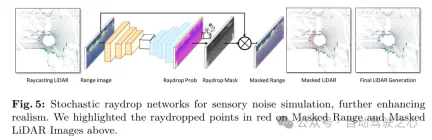

圖 5:用於感知噪音模擬的隨機光線丟棄(raydrop)網絡,進一步增強了真實感。本文在上方的掩碼距離圖和掩碼光達影像中以紅色突出顯示了光線丟棄的(raydropped)點。

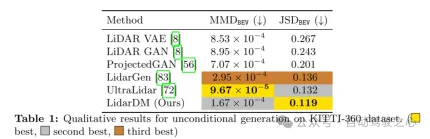

實驗結果:

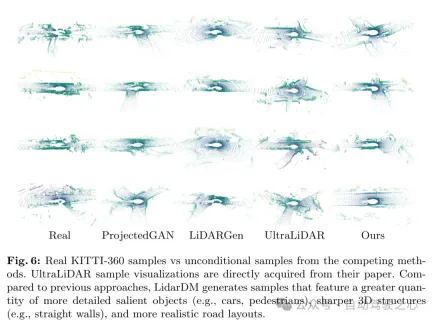

圖 6:真實的 KITTI-360 樣本與來自競爭方法的無條件樣本比較。 UltraLiDAR 樣本視覺化直接從它們的論文中取得。與先前的方法相比,LidarDM 產生的樣本具有更多數量、更詳細的顯著物體(例如,汽車、行人)、更清晰的 3D 結構(例如,直牆)以及更逼真的道路佈局。

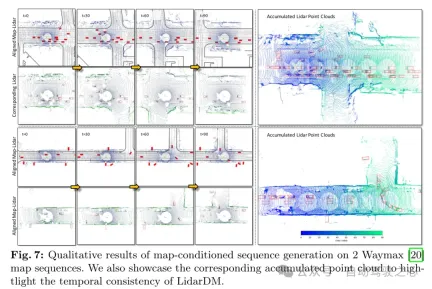

圖 7:在 2 Waymax [20] 地圖序列上進行的以地圖為條件的序列產生的定性結果。本文也展示了對應的累積點雲,以突顯 LidarDM 的時序一致性。

總結:

本文提出了LidarDM,這是一個新穎的基於佈局條件的隱擴散模型(latent diffusion models) ,用於產生逼真的雷射雷達點雲。本文的方法將問題框定為一個聯合的 4D 世界創建和感知資料生成任務,並開發了一個新穎的隱擴散模型(latent diffusion models) 來創建 3D 場景。由此產生的點雲視訊是真實的、連貫的,並且具有佈局感知(layout-aware)能力。

以上是LiDAR模擬新想法 | LidarDM:協助4D世界生成,模擬殺器~的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Gemma範圍:Google'用於凝視AI的顯微鏡Apr 17, 2025 am 11:55 AM

Gemma範圍:Google'用於凝視AI的顯微鏡Apr 17, 2025 am 11:55 AM使用Gemma範圍探索語言模型的內部工作 了解AI語言模型的複雜性是一個重大挑戰。 Google發布的Gemma Scope是一種綜合工具包,為研究人員提供了一種強大的探索方式

誰是商業智能分析師以及如何成為一位?Apr 17, 2025 am 11:44 AM

誰是商業智能分析師以及如何成為一位?Apr 17, 2025 am 11:44 AM解鎖業務成功:成為商業智能分析師的指南 想像一下,將原始數據轉換為驅動組織增長的可行見解。 這是商業智能(BI)分析師的力量 - 在GU中的關鍵作用

如何在SQL中添加列? - 分析VidhyaApr 17, 2025 am 11:43 AM

如何在SQL中添加列? - 分析VidhyaApr 17, 2025 am 11:43 AMSQL的Alter表語句:動態地將列添加到數據庫 在數據管理中,SQL的適應性至關重要。 需要即時調整數據庫結構嗎? Alter表語句是您的解決方案。本指南的詳細信息添加了Colu

業務分析師與數據分析師Apr 17, 2025 am 11:38 AM

業務分析師與數據分析師Apr 17, 2025 am 11:38 AM介紹 想像一個繁華的辦公室,兩名專業人員在一個關鍵項目中合作。 業務分析師專注於公司的目標,確定改進領域,並確保與市場趨勢保持戰略一致。 simu

什麼是Excel中的Count和Counta? - 分析VidhyaApr 17, 2025 am 11:34 AM

什麼是Excel中的Count和Counta? - 分析VidhyaApr 17, 2025 am 11:34 AMExcel 數據計數與分析:COUNT 和 COUNTA 函數詳解 精確的數據計數和分析在 Excel 中至關重要,尤其是在處理大型數據集時。 Excel 提供了多種函數來實現此目的,其中 COUNT 和 COUNTA 函數是用於在不同條件下統計單元格數量的關鍵工具。雖然這兩個函數都用於計數單元格,但它們的設計目標卻針對不同的數據類型。讓我們深入了解 COUNT 和 COUNTA 函數的具體細節,突出它們獨特的特性和區別,並學習如何在數據分析中應用它們。 要點概述 理解 COUNT 和 COU

Chrome在這裡與AI:每天都有新事物!Apr 17, 2025 am 11:29 AM

Chrome在這裡與AI:每天都有新事物!Apr 17, 2025 am 11:29 AMGoogle Chrome的AI Revolution:個性化和高效的瀏覽體驗 人工智能(AI)正在迅速改變我們的日常生活,而Google Chrome正在領導網絡瀏覽領域的負責人。 本文探討了興奮

AI的人類方面:福祉和四人底線Apr 17, 2025 am 11:28 AM

AI的人類方面:福祉和四人底線Apr 17, 2025 am 11:28 AM重新構想影響:四倍的底線 長期以來,對話一直以狹義的AI影響來控制,主要集中在利潤的最低點上。但是,更全面的方法認識到BU的相互聯繫

您應該知道的5個改變遊戲規則的量子計算用例Apr 17, 2025 am 11:24 AM

您應該知道的5個改變遊戲規則的量子計算用例Apr 17, 2025 am 11:24 AM事情正穩步發展。投資投入量子服務提供商和初創企業表明,行業了解其意義。而且,越來越多的現實用例正在出現以證明其價值超出

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

Atom編輯器mac版下載

最受歡迎的的開源編輯器

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

Dreamweaver CS6

視覺化網頁開發工具