4月2日消息,根據媒體報道,在最近的一篇論文中,蘋果的研究團隊宣稱,他們提出了一個可以在設備端運行的模型ReALM,這個模型在某些方面可以超過GPT- 4。

ReALM的參數量分別為80M、250M、1B和3B,體積都非常小,適合在手機、平板電腦等裝置端運作。

ReALM研究的主要是,讓AI辨識文本中提到的各種實體(如人名、地點、組織等)之間的指涉關係的過程。

論文將實體分為三種:

螢幕實體(On-screen Entities):指的是目前顯示在使用者螢幕上的內容。

對話實體(Conversational Entities):指的是與對話相關的內容。例如,使用者說“打電話給媽媽”,那麼媽媽的聯絡人資訊就是對話實體。

後台實體(Background Entities):指的是與使用者當下操作或螢幕顯示內容可能不會直接相關的實體,例如正在播放的音樂或即將響起的鬧鈴。

論文表示,儘管大型語言模型已經證明在多種任務上具有極強的能力,但在用於解決非對話實體(如螢幕實體、後台實體)的指涉問題時,它們的潛力還沒有充分利用。

而ReALM則是一種全新的方法,透過將其性能與GPT-3.5和GPT-4進行了對比,顯示最小模型的性能與GPT-4相當,而更大的模型則顯著超過了GPT-4。

這項研究有望用來改進蘋果設備上的Siri助手,幫助Siri更好地理解和處理用戶詢問中的上下文。

以上是蘋果AI放大招!聲稱其設備端模型性能優於GPT-4的詳細內容。更多資訊請關注PHP中文網其他相關文章!

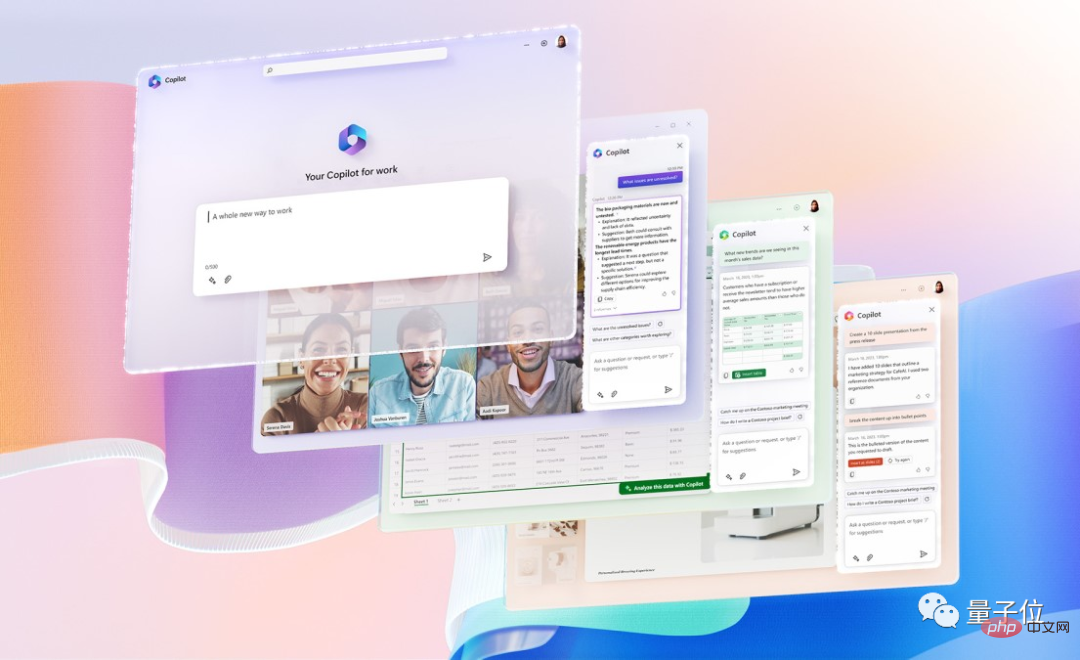

GPT-4接入Office全家桶!Excel到PPT动嘴就能做,微软:重新发明生产力Apr 12, 2023 pm 02:40 PM

GPT-4接入Office全家桶!Excel到PPT动嘴就能做,微软:重新发明生产力Apr 12, 2023 pm 02:40 PM一觉醒来,工作的方式被彻底改变。微软把AI神器GPT-4全面接入Office,这下ChatPPT、ChatWord、ChatExcel一家整整齐齐。CEO纳德拉在发布会上直接放话:今天,进入人机交互的新时代,重新发明生产力。新功能名叫Microsoft 365 Copilot(副驾驶),与改变了程序员的代码助手GitHub Copilot成为一个系列,继续改变更多人。现在AI不光能自动做PPT,而且能根据Word文档的内容一键做出精美排版。甚至连上台时对着每一页PPT应该讲什么话,都给一起安排

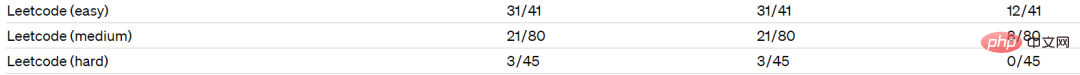

集成GPT-4的Cursor让编写代码和聊天一样简单,用自然语言编写代码的新时代已来Apr 04, 2023 pm 12:15 PM

集成GPT-4的Cursor让编写代码和聊天一样简单,用自然语言编写代码的新时代已来Apr 04, 2023 pm 12:15 PM集成GPT-4的Github Copilot X还在小范围内测中,而集成GPT-4的Cursor已公开发行。Cursor是一个集成GPT-4的IDE,可以用自然语言编写代码,让编写代码和聊天一样简单。 GPT-4和GPT-3.5在处理和编写代码的能力上差别还是很大的。官网的一份测试报告。前两个是GPT-4,一个采用文本输入,一个采用图像输入;第三个是GPT3.5,可以看出GPT-4的代码能力相较于GPT-3.5有较大能力的提升。集成GPT-4的Github Copilot X还在小范围内测中,而

GPT-4的两个谣言和最新预测!Apr 11, 2023 pm 06:07 PM

GPT-4的两个谣言和最新预测!Apr 11, 2023 pm 06:07 PM作者 | 云昭3月9日,微软德国CTO Andreas Braun在AI kickoff会议上带来了一个期待已久的消息:“我们将于下周推出GPT-4,届时我们将推出多模式模式,提供完全不同的可能性——例如视频。”言语之中,他将大型语言模型(LLM)比作“游戏改变者”,因为他们教机器理解自然语言,然后机器以统计的方式理解以前只能由人类阅读和理解的东西。与此同时,这项技术已经发展到“适用于所有语言”:你可以用德语提问,也可以用意大利语回答。借助多模态,微软(-OpenAI)将“使模型变得全面”。那

再一次改变“AI”世界 GPT-4千呼万唤始出来Apr 10, 2023 pm 02:40 PM

再一次改变“AI”世界 GPT-4千呼万唤始出来Apr 10, 2023 pm 02:40 PM近段时间,人工智能聊天机器人ChatGPT刷爆网络,网友们争先恐后去领略它的超高情商和巨大威力。参加高考、修改代码、构思小说……它在广大网友的“鞭策”下不断突破自我,甚至可以用一整段程序,为你拼接出一只小狗。而这些技能只是基于GPT-3.5开发而来,在3月15日,AI世界再次更新,最新版本的GPT-4也被OpenAI发布了出来。与之前相比,GPT-4不仅展现了更加强大的语言理解能力,还能够处理图像内容,在考试中的得分甚至能超越90%的人类。那么,如此“逆天”的GPT-4还具有哪些能力?它又是如何

GPT-4救了我狗的命Apr 04, 2023 pm 12:25 PM

GPT-4救了我狗的命Apr 04, 2023 pm 12:25 PMGPT-4在发布之时公布了一项医学知识测试结果,该测试由美国医师学会开发,最终它答对了75%的问题,相比GPT3.5的53%有很大的飞跃。 这两天,一篇关于“GPT-4救了我狗的命”的帖子属实有点火:短短一两天就有数千人转发,上万人点赞,网友在评论区讨论得热火朝天。△ 是真狗命,not人的“狗命”(Doge)乍一听,大家想必很纳闷:这俩能扯上什么关系?GPT-4还能长眼睛发现狗有什么危险吗?真实的经过是这样子的:当兽医说无能为力时,他问了GPT-4发帖人名叫Cooper。他自述自己养的一条狗子,

GPT-4帮助企业实现数字化转型的五种方法May 05, 2023 pm 12:19 PM

GPT-4帮助企业实现数字化转型的五种方法May 05, 2023 pm 12:19 PM人工智能在过去几十年里发展势头强劲,像GPT-4这样的大型语言模型引起了用户的更多兴趣,他们想知道GPT-4如何支持数字化转型。根据行业媒体的预测,到2024年,GPT-4所基于的ChatGPT深度学习堆栈将产生10亿美元的收入。GPT-4的普及是由于人工智能技术的力量,以及高用户可访问性和广泛的通用性。科技行业的许多不同领域都可以利用GPT-4来自动化和个性化许多任务,使企业员工能够专注于更复杂的任务。以下是GPT-4在几个不同领域促进数字化转型的一些例子。1、个性化员工培训像GPT-4这样的

有没有可能Bing正在集成GPT-4?这是否属实还是无根之论?May 08, 2023 pm 10:37 PM

有没有可能Bing正在集成GPT-4?这是否属实还是无根之论?May 08, 2023 pm 10:37 PM作者|徐杰承在微软NewBing发布前,绝大部分人对其的预测都是——NewBing的整体表现将会与ChatGPT极其相似,即使二者在细节层面存在某些差异,用户也应当无法从体验角度发现这些区别。然而随着NewBing的发布与更新,越来越多的人开始怀疑,微软与OpenAI此前那宗100亿美元的交易,似乎不止关系到ChatGPT这一个“宝贝”。1、微软官宣:集成全新模型虽然NewBing与ChatGPT都基于GPT3.5系列模型微调而成,但在2月中旬,微软宣称已将一种全新的AI语言模型集成到了N

微软 Bing Chat 聊天机器人已升级使用最新 OpenAI GPT-4 技术Apr 12, 2023 pm 10:58 PM

微软 Bing Chat 聊天机器人已升级使用最新 OpenAI GPT-4 技术Apr 12, 2023 pm 10:58 PM3 月 15 日消息,今天 OpenAI 发布了全新的 GPT-4 大型语言模型,随后微软官方宣布,Bing Chat 此前已经升级使用 OpenAI 的 GPT-4 技术。微软公司副总裁兼消费者首席营销官 Yusuf Mehdi 确认 Bing Chat 聊天机器人 AI 已经在 GPT-4 上运行,ChatGPT 基于最新版本 GPT-4,由 OpenAI 开发 。微软 Bing 博客网站上的一篇帖子进一步证实了这一消息。微软表示,如果用户在过去五周内的任何时间使用过新的 Bing 预览版,

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

SublimeText3漢化版

中文版,非常好用

WebStorm Mac版

好用的JavaScript開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

SublimeText3 Linux新版

SublimeText3 Linux最新版