隨著人工智慧技術(AI)的不斷普及,各種演算法在推動這一領域的發展中扮演著重要角色。從用於預測房價的線性迴歸演算法到支援自動駕駛汽車的神經網絡,這些演算法默默地為無數應用提供支援和運作。隨著資料量的增加和運算能力的提升,人工智慧演算法的效能和效率也不斷提升。這些演算法的應用範圍越來越廣泛,涵蓋了醫療診斷、金融風險評估、自然語言處理等

今天,我們將帶您一覽這些熱門的人工智慧演算法(線性迴歸、邏輯迴歸、決策樹、樸素貝葉斯、支援向量機(SVM)、整合學習、K近鄰演算法、K-means演算法、神經網路、強化學習Deep Q-Networks ),探索它們的運作方式、應用場景以及在現實世界中的影響力。

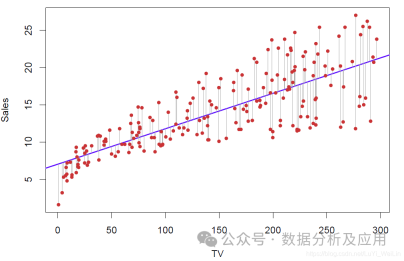

1、線性迴歸:

線性迴歸的原理是尋找一條最優直線,以最大程度地擬合資料點的分佈。

模型訓練是利用已知的輸入和輸出資料來最佳化模型,通常透過最小化預測值與實際值之間的差異來實現。

優點:簡單易懂,運算效率高。

缺點:對非線性關係處理能力有限。

使用情境:適用於預測連續值的問題,如預測房價、股價等。

範例程式碼(使用Python的Scikit-learn函式庫建立一個簡單的線性迴歸模型):

from sklearn.linear_model import LinearRegressionfrom sklearn.datasets import make_regression# 生成模拟数据集X, y = make_regression(n_samples=100, n_features=1, noise=0.1)# 创建线性回归模型对象lr = LinearRegression()# 训练模型lr.fit(X, y)# 进行预测predictions = lr.predict(X)

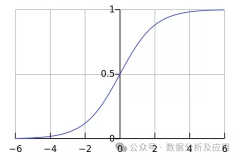

2、邏輯迴歸:

模型原理:邏輯迴歸是一種用於解決二分類問題的機器學習演算法,它將連續的輸入映射到離散的輸出(通常是二進制的)。它使用邏輯函數將線性迴歸的結果映射到(0,1)範圍內,從而得到分類的機率。

模型訓練:使用已知分類的樣本資料來訓練邏輯迴歸模型,透過最佳化模型的參數以最小化預測機率與實際分類之間的交叉熵損失。

優點:簡單易懂,對二分類問題效果較好。

缺點:對非線性關係處理能力有限。

使用情境:適用於二分類問題,如垃圾郵件過濾、疾病預測等。

範例程式碼(使用Python的Scikit-learn函式庫建立一個簡單的邏輯迴歸模型):

from sklearn.linear_model import LogisticRegressionfrom sklearn.datasets import make_classification# 生成模拟数据集X, y = make_classification(n_samples=100, n_features=2, n_informative=2, n_redundant=0, random_state=42)# 创建逻辑回归模型对象lr = LogisticRegression()# 训练模型lr.fit(X, y)# 进行预测predictions = lr.predict(X)

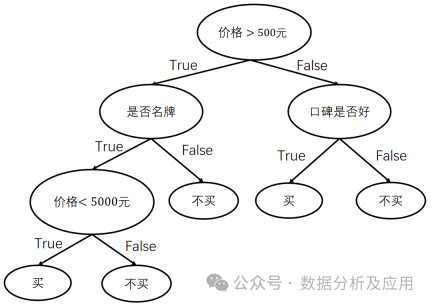

3、決策樹:

模型原理:決策樹是一種監督學習演算法,透過遞歸地將資料集分割成更小的子集來建構決策邊界。每個內部節點表示一個特徵屬性上的判斷條件,每個分支代表一個可能的屬性值,每個葉子節點表示一個類別。

模型訓練:透過選擇最佳劃分屬性來建立決策樹,並使用剪枝技術來防止過度擬合。

優點:易於理解和解釋,能夠處理分類和迴歸問題。

缺點:容易過度擬合,對雜訊和異常值敏感。

使用情境:適用於分類和迴歸問題,如信用卡詐欺偵測、天氣預報等。

範例程式碼(使用Python的Scikit-learn函式庫建立一個簡單的決策樹模型):

from sklearn.tree import DecisionTreeClassifierfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_split# 加载数据集iris = load_iris()X = iris.datay = iris.target# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 创建决策树模型对象dt = DecisionTreeClassifier()# 训练模型dt.fit(X_train, y_train)# 进行预测predictions = dt.predict(X_test)

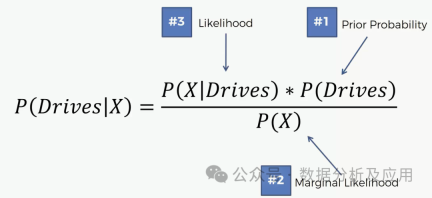

4、樸素貝葉斯斯:

模型原理:樸素貝葉斯是一種基於貝葉斯定理和特徵條件獨立假設的分類方法。它將每個類別中樣本的屬性值進行機率建模,然後基於這些機率來預測新的樣本所屬的類別。

模型訓練:透過使用已知類別和屬性的樣本資料來估計每個類別的先驗機率和每個屬性的條件機率,從而建立樸素貝葉斯分類器。

優點:簡單、高效,對於大類別和小資料集特別有效。

缺點:對特徵之間的依賴關係建模不佳。

使用場景:適用於文字分類、垃圾郵件過濾等場景。

範例程式碼(使用Python的Scikit-learn函式庫建立一個簡單的樸素貝葉斯分類器):

from sklearn.naive_bayes import GaussianNBfrom sklearn.datasets import load_iris# 加载数据集iris = load_iris()X = iris.datay = iris.target# 创建朴素贝叶斯分类器对象gnb = GaussianNB()# 训练模型gnb.fit(X, y)# 进行预测predictions = gnb.predict(X)

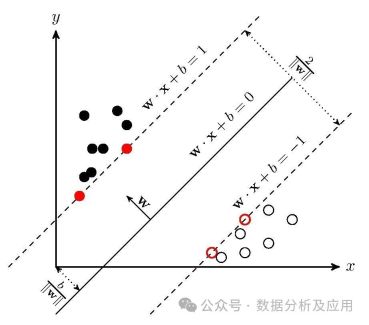

5、支持向量机(SVM):

模型原理:支持向量机是一种监督学习算法,用于分类和回归问题。它试图找到一个超平面,使得该超平面能够将不同类别的样本分隔开。SVM使用核函数来处理非线性问题。

模型训练:通过优化一个约束条件下的二次损失函数来训练SVM,以找到最佳的超平面。

优点:对高维数据和非线性问题表现良好,能够处理多分类问题。

缺点:对于大规模数据集计算复杂度高,对参数和核函数的选择敏感。

使用场景:适用于分类和回归问题,如图像识别、文本分类等。

示例代码(使用Python的Scikit-learn库构建一个简单的SVM分类器):

from sklearn import svmfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_split# 加载数据集iris = load_iris()X = iris.datay = iris.target# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 创建SVM分类器对象,使用径向基核函数(RBF)clf = svm.SVC(kernel='rbf')# 训练模型clf.fit(X_train, y_train)# 进行预测predictions = clf.predict(X_test)

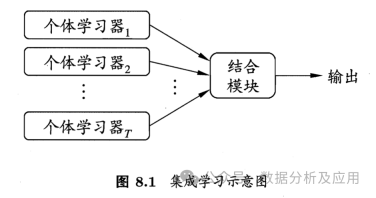

6、集成学习:

模型原理:集成学习是一种通过构建多个基本模型并将它们的预测结果组合起来以提高预测性能的方法。集成学习策略有投票法、平均法、堆叠法和梯度提升等。常见集成学习模型有XGBoost、随机森林、Adaboost等

模型训练:首先使用训练数据集训练多个基本模型,然后通过某种方式将它们的预测结果组合起来,形成最终的预测结果。

优点:可以提高模型的泛化能力,降低过拟合的风险。

缺点:计算复杂度高,需要更多的存储空间和计算资源。

使用场景:适用于解决分类和回归问题,尤其适用于大数据集和复杂的任务。

示例代码(使用Python的Scikit-learn库构建一个简单的投票集成分类器):

from sklearn.ensemble import VotingClassifierfrom sklearn.linear_model import LogisticRegressionfrom sklearn.tree import DecisionTreeClassifierfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_split# 加载数据集iris = load_iris()X = iris.datay = iris.target# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 创建基本模型对象和集成分类器对象lr = LogisticRegression()dt = DecisionTreeClassifier()vc = VotingClassifier(estimators=[('lr', lr), ('dt', dt)], voting='hard')# 训练集成分类器vc.fit(X_train, y_train)# 进行预测predictions = vc.predict(X_test)7、K近邻算法:

模型原理:K近邻算法是一种基于实例的学习,通过将新的样本与已知样本进行比较,找到与新样本最接近的K个样本,并根据这些样本的类别进行投票来预测新样本的类别。

模型训练:不需要训练阶段,通过计算新样本与已知样本之间的距离或相似度来找到最近的邻居。

优点:简单、易于理解,不需要训练阶段。

缺点:对于大规模数据集计算复杂度高,对参数K的选择敏感。

使用场景:适用于解决分类和回归问题,适用于相似度度量和分类任务。

示例代码(使用Python的Scikit-learn库构建一个简单的K近邻分类器):

from sklearn.neighbors import KNeighborsClassifierfrom sklearn.datasets import load_irisfrom sklearn.model_selection import train_test_split# 加载数据集iris = load_iris()X = iris.datay = iris.target# 划分训练集和测试集X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)# 创建K近邻分类器对象,K=3knn = KNeighborsClassifier(n_neighbors=3)# 训练模型knn.fit(X_train, y_train)# 进行预测predictions = knn.predict(X_test)

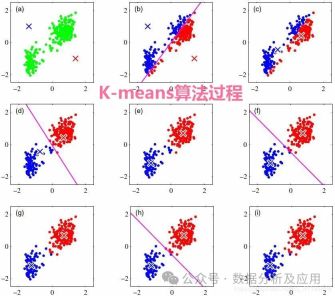

8、K-means算法:

模型原理:K-means算法是一种无监督学习算法,用于聚类问题。它将n个点(可以是样本数据点)划分为k个聚类,使得每个点属于最近的均值(聚类中心)对应的聚类。

模型训练:通过迭代更新聚类中心和分配每个点到最近的聚类中心来实现聚类。

优点:简单、快速,对于大规模数据集也能较好地运行。

缺点:对初始聚类中心敏感,可能会陷入局部最优解。

使用场景:适用于聚类问题,如市场细分、异常值检测等。

示例代码(使用Python的Scikit-learn库构建一个简单的K-means聚类器):

from sklearn.cluster import KMeansfrom sklearn.datasets import make_blobsimport matplotlib.pyplot as plt# 生成模拟数据集X, y = make_blobs(n_samples=300, centers=4, cluster_std=0.60, random_state=0)# 创建K-means聚类器对象,K=4kmeans = KMeans(n_clusters=4)# 训练模型kmeans.fit(X)# 进行预测并获取聚类标签labels = kmeans.predict(X)# 可视化结果plt.scatter(X[:, 0], X[:, 1], c=labels, cmap='viridis')plt.show()

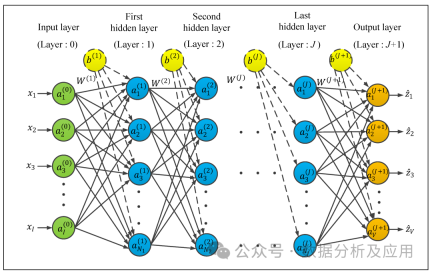

9、神经网络:

模型原理:神经网络是一种模拟人脑神经元结构的计算模型,通过模拟神经元的输入、输出和权重调整机制来实现复杂的模式识别和分类等功能。神经网络由多层神经元组成,输入层接收外界信号,经过各层神经元的处理后,最终输出层输出结果。

模型训练:神经网络的训练是通过反向传播算法实现的。在训练过程中,根据输出结果与实际结果的误差,逐层反向传播误差,并更新神经元的权重和偏置项,以减小误差。

优点:能够处理非线性问题,具有强大的模式识别能力,能够从大量数据中学习复杂的模式。

缺点:容易陷入局部最优解,过拟合问题严重,训练时间长,需要大量的数据和计算资源。

使用场景:适用于图像识别、语音识别、自然语言处理、推荐系统等场景。

示例代码(使用Python的TensorFlow库构建一个简单的神经网络分类器):

import tensorflow as tffrom tensorflow.keras import layers, modelsfrom tensorflow.keras.datasets import mnist# 加载MNIST数据集(x_train, y_train), (x_test, y_test) = mnist.load_data()# 归一化处理输入数据x_train = x_train / 255.0x_test = x_test / 255.0# 构建神经网络模型model = models.Sequential()model.add(layers.Flatten(input_shape=(28, 28)))model.add(layers.Dense(128, activation='relu'))model.add(layers.Dense(10, activation='softmax'))# 编译模型并设置损失函数和优化器等参数model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])# 训练模型model.fit(x_train, y_train, epochs=5)# 进行预测predictions = model.predict(x_test)

10.深度强化学习(DQN):

模型原理:Deep Q-Networks (DQN) 是一种结合了深度学习与Q-learning的强化学习算法。它的核心思想是使用神经网络来逼近Q函数,即状态-动作值函数,从而为智能体在给定状态下选择最优的动作提供依据。

模型训练:DQN的训练过程包括两个阶段:离线阶段和在线阶段。在离线阶段,智能体通过与环境的交互收集数据并训练神经网络。在线阶段,智能体使用神经网络进行动作选择和更新。为了解决过度估计问题,DQN引入了目标网络的概念,通过使目标网络在一段时间内保持稳定来提高稳定性。

优点:能够处理高维度的状态和动作空间,适用于连续动作空间的问题,具有较好的稳定性和泛化能力。

缺点:容易陷入局部最优解,需要大量的数据和计算资源,对参数的选择敏感。

使用场景:适用于游戏、机器人控制等场景。

示例代码(使用Python的TensorFlow库构建一个简单的DQN强化学习模型):

import tensorflow as tffrom tensorflow.keras.models import Sequentialfrom tensorflow.keras.layers import Dense, Dropout, Flattenfrom tensorflow.keras.optimizers import Adamfrom tensorflow.keras import backend as Kclass DQN:def __init__(self, state_size, action_size):self.state_size = state_sizeself.action_size = action_sizeself.memory = deque(maxlen=2000)self.gamma = 0.85self.epsilon = 1.0self.epsilon_min = 0.01self.epsilon_decay = 0.995self.learning_rate = 0.005self.model = self.create_model()self.target_model = self.create_model()self.target_model.set_weights(self.model.get_weights())def create_model(self):model = Sequential()model.add(Flatten(input_shape=(self.state_size,)))model.add(Dense(24, activation='relu'))model.add(Dense(24, activation='relu'))model.add(Dense(self.action_size, activation='linear'))return modeldef remember(self, state, action, reward, next_state, done):self.memory.append((state, action, reward, next_state, done))def act(self, state):if len(self.memory) > 1000:self.epsilon *= self.epsilon_decayif self.epsilon

以上是十大必知的人工智慧演算法的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Llama 4與GPT-4O:哪個更好?Apr 26, 2025 am 09:37 AM

Llama 4與GPT-4O:哪個更好?Apr 26, 2025 am 09:37 AM本文比較了Meta的Llama 4 Scout和OpenAI的GPT-4O在檢索效果(RAG)系統中的性能。 該評估利用Ragas框架,為忠誠,回答相關性和背景預先提供指標

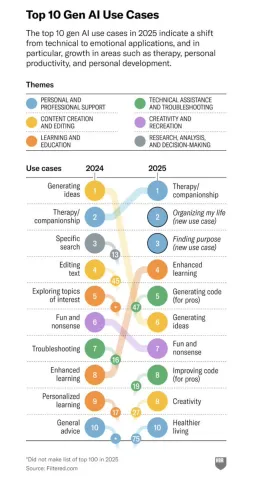

生成的人工智能和人類聯繫改變關係 - 分析vidhyaApr 26, 2025 am 09:36 AM

生成的人工智能和人類聯繫改變關係 - 分析vidhyaApr 26, 2025 am 09:36 AM2025年:生成的AI從生產力工具發展到個人同伴 Generative AI的角色在2025年大大擴展,超越了簡單的生產力任務,成為個人生活中的重要領域。而其提高效率

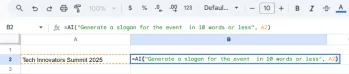

如何在Google表中使用雙子座?Apr 26, 2025 am 09:34 AM

如何在Google表中使用雙子座?Apr 26, 2025 am 09:34 AMGoogle表可以通過引入Gemini's = AI功能,自動化以前需要手動努力的數據任務進行了重大升級。這種AI驅動的公式簡化了通過簡單的分類,匯總和公式開發

Python One Liners數據清潔:快速指南 - 分析VidhyaApr 26, 2025 am 09:33 AM

Python One Liners數據清潔:快速指南 - 分析VidhyaApr 26, 2025 am 09:33 AM使用Python單線使數據清潔變得容易 用強大的Python單線簡化數據清潔過程!本指南展示了用於處理缺失價值,重複,格式化問題等基本熊貓技術

為您的任務選擇最佳AI聊天機器人的指南Apr 26, 2025 am 09:31 AM

為您的任務選擇最佳AI聊天機器人的指南Apr 26, 2025 am 09:31 AM您如何跟踪最新的LLM?如果您一直在跟踪新聞,那麼我確定您對那裡的模型不知所措,尤其是在過去的幾個月中。今天,我們的AI聊天機器人比FI更多

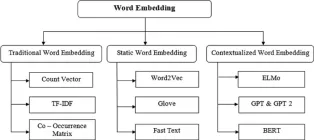

14個強大的技術定義嵌入的演變-Analytics VidhyaApr 26, 2025 am 09:29 AM

14個強大的技術定義嵌入的演變-Analytics VidhyaApr 26, 2025 am 09:29 AM本文探討了文本嵌入的演變,從簡單的基於計數的方法到復雜的上下文感知模型。 它突出了MTEB等排行榜在評估嵌入性能和尖端的可及性中的作用

O3 vs O4 -Mini vs Gemini 2.5 Pro:終極推理戰 - 分析VidhyaApr 26, 2025 am 09:28 AM

O3 vs O4 -Mini vs Gemini 2.5 Pro:終極推理戰 - 分析VidhyaApr 26, 2025 am 09:28 AM該博客將三個領先的AI模型(O3,O4-Mini和Gemini 2.5 Pro)置於嚴格的推理挑戰中。 我們在物理,數學,編碼,網頁設計和圖像分析中測試它們的能力,揭示了它們的優勢

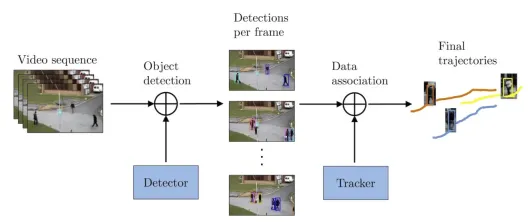

在Yolo -Analytics Vidhya中進行有效的重新ID跟踪Apr 26, 2025 am 09:26 AM

在Yolo -Analytics Vidhya中進行有效的重新ID跟踪Apr 26, 2025 am 09:26 AMYOLO,SSD和DETR等實時對象檢測工具對於監視對象運動和動作至關重要。 交通管理和安全等行業利用這些工具來跟踪和分析。但是,一個主要挑戰是維護

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

WebStorm Mac版

好用的JavaScript開發工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。