这就是由微软和中国中科院大学在最新一项研究中所提出的结论——

所有的LLM,都将是1.58 bit的。

具体而言,这项研究提出的方法叫做BitNet b1.58,可以说是从大语言模型“根儿”上的参数下手。

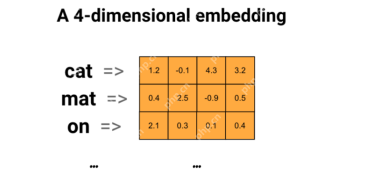

将传统以16位浮点数(如FP16或BF16)形式的存储,统统变成了三进制,也就是 {-1, 0, 1}。

需要注意的是,“1.58 bit”并非表示每个参数占用1.58字节的存储空间,而是指每个参数可以用1.58位的信息来编码。

在如此转换之后,矩阵中的计算就只会涉及到整数的加法,因此会让大模型在保持一定精度的同时,显著减少所需的存储空间和计算资源。

例如BitNet b1.58在3B模型大小时与Llama做比较,速度提高了2.71倍的同时,GPU内存使用几乎仅是原先的四分之一。

而且当模型的规模越大时(例如70B),速度上的提升和内存上的节省就会更加显著!

这种颠覆传统的思路着实是让网友们眼前一亮,论文在X上也是受到了高度的关注:

网友们惊叹“改变游戏规则”的同时,还玩起了谷歌attention论文的老梗:

1 bit is all YOU need.

那么BitNet b1.58具体又是如何实现的?我们继续往下看。

把参数都变成三进制

这项研究实则是原班人马在此前发表的一篇论文基础之上做的优化,即在原始BitNet的基础上增加了一个额外的0值。

整体来看,BitNet b1.58依旧是基于BitNet架构(一种Transformer),用BitLinear替换了nn.Linear。

至于细节上的优化,首先就是我们刚才提到的“加个0”,即权重量化(weight quantization)。

BitNet b1.58模型的权重被量化为三元值{-1, 0, 1},这相当于在二进制系统中使用了1.58 bit来表示每个权重。这种量化方法减少了模型的内存占用,并简化了计算过程。

其次,在量化函数设计方面,为了将权重限制在-1、0或 1之间,研究者们采用了一种称为absmean的量化函数。

这个函数先会根据权重矩阵的平均绝对值进行缩放,然后将每个值四舍五入到最接近的整数(-1, 0, 1)。

接下来就到了激活量化(activation quantization)这一步。

激活值的量化与BitNet中的实现相同,但在非线性函数之前不将激活值缩放到[0, Qb]的范围内。相反,激活值被缩放到[−Qb, Qb]的范围,以此来消除零点量化。

值得一提的是,研究团队为了BitNet b1.58与开源社区兼容,采用了LLaMA模型的组件,如RMSNorm、SwiGLU等,使得它可以轻松集成到主流开源软件中。

最后,在实验的性能比较上,团队将BitNet b1.58与FP16 LLaMA LLM在不同大小的模型上进行了比较。

结果显示,BitNet b1.58在3B模型大小时开始与全精度LLaMA LLM在困惑度上匹配,同时在延迟、内存使用和吞吐量方面有显著提升。

而且当模型规模越大时,这种性能上提升就会越发显著。

网友:能在消费级GPU跑120B大模型了

正如上文所言,这篇研究独特的方法在网上引发了不小的热议。

DeepLearning.scala作者杨博表示:

BitNet b1.58相比原版BitNet,最大的特点就是允许0参数。我觉得稍微修改一下量化函数,也许可以控制0参数的比例。当0参数的比例很大时,可以用稀疏格式存储权重,使得平均每个参数的显存占用甚至低于1比特。这就相当于权重级别的MoE了。我觉得比一般的MoE更优雅。

与此同时,他也提出了关于BitNet的缺点:

BitNet最大的缺点在于虽然能减少推理时的显存开销,但优化器状态和梯度仍然要用浮点数,训练仍然很费显存。我觉得如果能把BitNet和训练时节省显存的技术结合起来,那么相比传统半精度网络,同等算力和显存下支持更多参数,优势就很大了。

目前能节省优化器状态的显存开销的办法是offloading。能节省梯度的显存占用的办法可能是ReLoRA。但是ReLoRA的论文实验只用了十亿参数的模型,并没有证据表明能不能推广到百亿、千亿参数的模型。

△图源:知乎,经授权引用

不过也有网友分析认为:

若论文成立,那么我们就能在24GB消费级GPU上跑120B的大模型了。

那么你觉得这种新方法如何呢?

以上是微軟6頁論文爆火:三進制LLM,真香!的詳細內容。更多資訊請關注PHP中文網其他相關文章!

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM生成的AI:革命性的創造力和創新 生成的AI通過按下按鈕來創建文本,圖像,音樂和虛擬世界來改變行業。 它的影響跨越視頻編輯,音樂製作,藝術,娛樂,HEA

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM利用嵌入模型的力量來回答高級問題 在當今信息豐富的世界中,立即獲得精確答案的能力至關重要。 本文展示了使用強大的提問(QA)模型

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM本文探討了十個徹底改變人工智能(AI)和機器學習(ML)的開創性出版物。 我們將研究神經網絡和算法的最新突破,並解釋驅動現代AI的核心概念。 Th

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AM

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AMAI在SEO中的崛起:超過SEO代理商的前11個工具 AI的快速發展已深刻地重塑了SEO景觀。 旨在提高頂級搜索引擎排名的企業正在利用AI優化其在線策略的能力。 來自AU

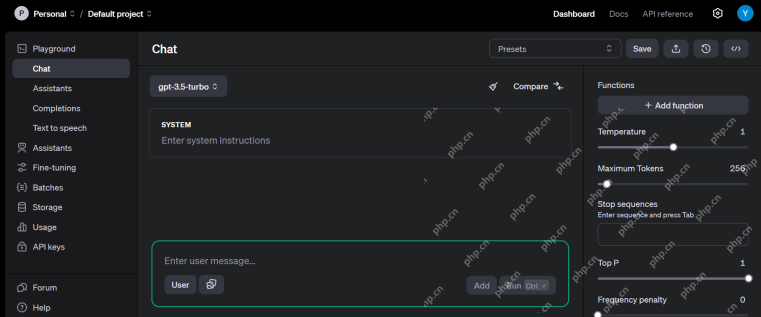

前10個免費的AI遊樂場供您在2025年嘗試-Analytics VidhyaApr 19, 2025 am 09:45 AM

前10個免費的AI遊樂場供您在2025年嘗試-Analytics VidhyaApr 19, 2025 am 09:45 AM探索2024年最好的免費AI遊樂場:綜合指南 訪問正確的工具和平台是在不斷發展的人工智能(AI)領域學習和創新的關鍵。 AI遊樂場提供了絕佳的機會

矢量數據庫中索引算法的詳細指南Apr 19, 2025 am 09:41 AM

矢量數據庫中索引算法的詳細指南Apr 19, 2025 am 09:41 AM介紹 向量數據庫是專門的數據庫,旨在有效地存儲和檢索高維矢量數據。 這些向量代表數據點的特徵或屬性,範圍從數十到數千個維度,具體取決於

反向擴散過程是什麼? - 分析VidhyaApr 19, 2025 am 09:40 AM

反向擴散過程是什麼? - 分析VidhyaApr 19, 2025 am 09:40 AM穩定的擴散:揭示反向擴散的魔力 穩定的擴散是一種強大的生成模型,能夠從噪聲中產生高質量的圖像。此過程涉及兩個關鍵步驟:正向擴散過程(在上一個A中詳細介紹

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

SublimeText3漢化版

中文版,非常好用

Dreamweaver Mac版

視覺化網頁開發工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器