罕見!蘋果開源圖片編輯神器MGIE,要上iPhone?

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2024-02-05 15:33:291315瀏覽

拍张照片,输入文字指令,手机就开始自动修图?

这一神奇功能,来自苹果刚刚开源的图片编辑神器「MGIE」。

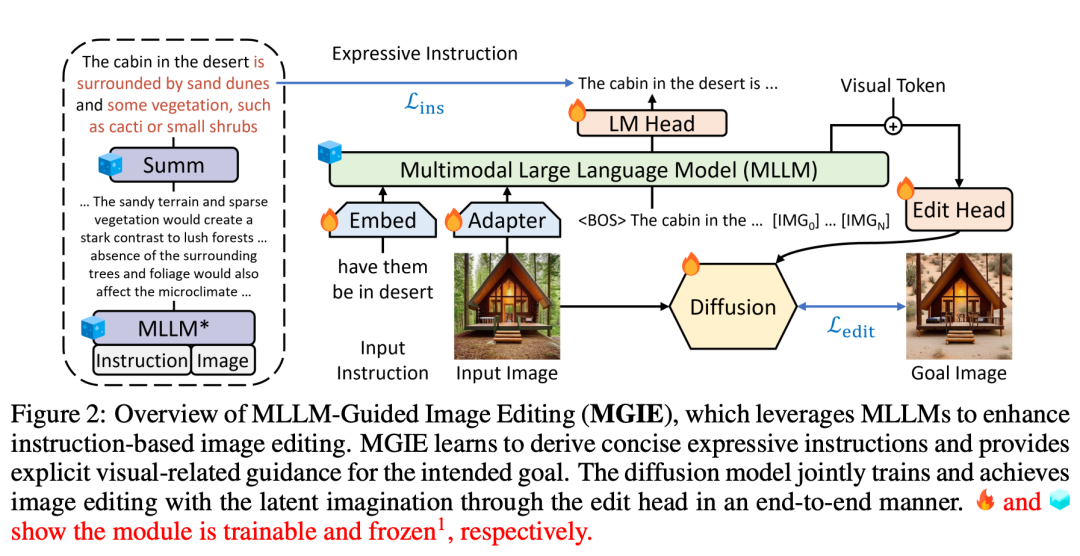

把背景中的人移除

在桌子上添加披萨

最近,AI在图片编辑方面取得了显著的进展。一方面,通过多模态大模型(MLLM),AI能够将图像作为输入,并提供视觉感知响应,从而实现更自然的图片编辑。另一方面,基于指令的编辑技术使得编辑过程不再依赖于详细描述或区域掩码,而是允许用户直接下达指令,以表达编辑的方式和目标。这种方法非常实用,因为它更符合人类的直觉方式。通过这些创新技术,AI在图片编辑领域正逐渐成为人们的得力助手。

基于上述技术的启发,苹果提出了 MGIE(MLLM-Guided Image Editing),将 MLLM 用于解决指令引导不足的问题。

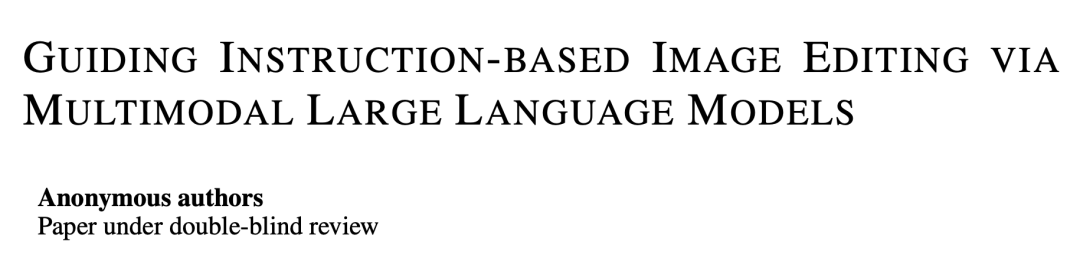

- 论文标题:Guiding Instruction-based Image Editing via Multimodal Large Language Models

- 论文链接:https://openreview.net/pdf?id=S1RKWSyZ2Y

- 项目主页:https://mllm-ie.github.io/

MGIE(Mind-Guided Image Editing)由MLLM(Mind-Language Linking Model)和扩散模型组成,如图2所示。MLLM通过学习获得简明的表达指令,并提供明确的视觉相关引导。扩散模型利用预期目标的潜在想象力执行图像编辑,并通过端到端训练同步更新。这样,MGIE能够从固有的视觉推导中获益,并解决模糊的人类指令,从而实现合理的编辑。

在人类指令的引导下,MGIE 可进行 Photoshop 风格的修改、全局照片优化和局部对象修改。以下图为例,在没有额外语境的情况下,很难捕捉到「健康」的含义,但 MGIE 可以将「蔬菜配料」与披萨精确地联系起来,并按照人类的期望进行相关编辑。

这让我们想起,库克前不久在财报电话会议上表达的「雄心壮志」:「我认为苹果在生成式 AI 方面存在着巨大的机会,但我不想谈更多细节。」他透露的信息包括,苹果正在积极开发生成式 AI 软件功能,且这些功能在 2024 年晚些时候就能向客户提供。

结合苹果在近段时间发布的一系列生成式 AI 理论研究成果,看来我们期待一下苹果接下来要发布的新 AI 功能了。

論文細節

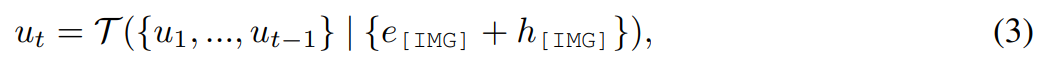

該研究提出的MGIE 方法能夠透過給定的指令X 將輸入圖片V 編輯為目標圖片  。對於那些不精確的指令,MGIE 中的 MLLM 會進行學習推導,從而得到簡潔的表達指令 ε。為了在語言和視覺模態之間架起橋樑,研究者還在 ε 之後添加了特殊的 token [IMG],並採用編輯頭(edit head)

。對於那些不精確的指令,MGIE 中的 MLLM 會進行學習推導,從而得到簡潔的表達指令 ε。為了在語言和視覺模態之間架起橋樑,研究者還在 ε 之後添加了特殊的 token [IMG],並採用編輯頭(edit head) 對它們進行轉換。轉換後的訊息將作為 MLLM 中的潛在視覺想像,引導擴散模型

對它們進行轉換。轉換後的訊息將作為 MLLM 中的潛在視覺想像,引導擴散模型 實現預期的編輯目標。然後,MGIE 能夠理解具有視覺感知的模糊指令,從而進行合理的影像編輯(架構圖如上圖 2 所示)。

實現預期的編輯目標。然後,MGIE 能夠理解具有視覺感知的模糊指令,從而進行合理的影像編輯(架構圖如上圖 2 所示)。

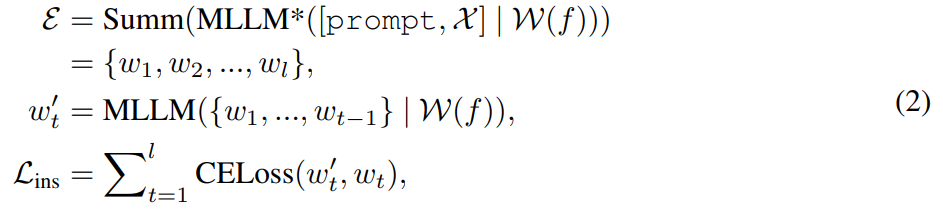

簡潔的表達指令

#透過特徵對齊和指令調整,MLLM 能夠跨模態感知提供與視覺相關的響應。對於圖像編輯,該研究使用提示“what will this image be like if [instruction]”作為圖像的語言輸入,並導出編輯命令的詳細解釋。然而,這些解釋往往過於冗長、甚至誤導了使用者意圖。為了獲得更簡潔的描述,研究應用預訓練摘要器讓 MLLM 學習產生摘要輸出。這個過程可以總結為以下方式:

# 透過潛在想像進行圖片編輯

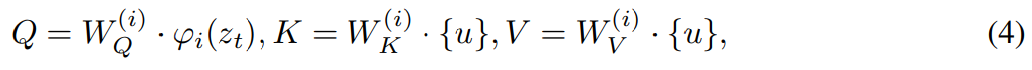

#本研究採用編輯頭  將[IMG] 轉化為實際的視覺引導。其中

將[IMG] 轉化為實際的視覺引導。其中  是一個序列到序列模型,它將來自MLLM 的連續視覺tokens 映射到語義上有意義的潛在U = {u_1, u_2, ..., u_L} 並作為編輯引導:

是一個序列到序列模型,它將來自MLLM 的連續視覺tokens 映射到語義上有意義的潛在U = {u_1, u_2, ..., u_L} 並作為編輯引導:

為了實現透過視覺想像U 引導影像編輯這個過程,研究考慮使用擴散模型 ,此模型在包含變分自動編碼器(VAE)的同時,還能解決潛在空間中的去噪擴散問題。

,此模型在包含變分自動編碼器(VAE)的同時,還能解決潛在空間中的去噪擴散問題。

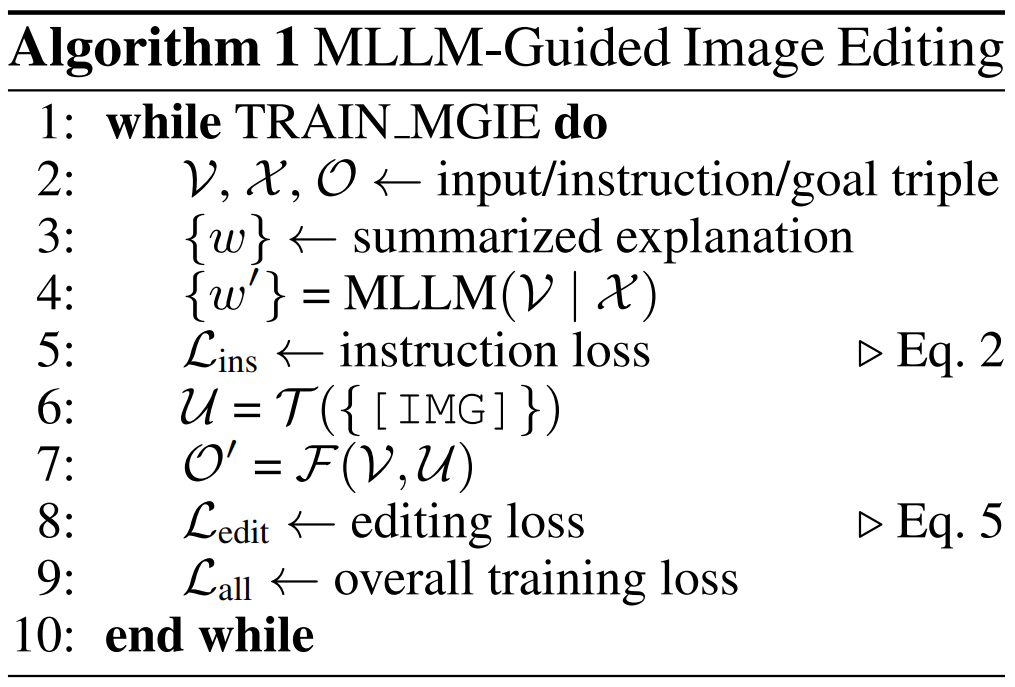

演算法 1 展示了 MGIE 學習過程。 MLLM 透過指令損失 L_ins 導出簡潔指令 ε。透過 [IMG] 的潛在想像, 轉變其模態並引導

轉變其模態並引導  合成結果影像。編輯損失 L_edit 用於擴散訓練。由於大多數權重可以被凍結(MLLM 內的自註意力區塊),因而可以實現參數高效的端到端訓練。

合成結果影像。編輯損失 L_edit 用於擴散訓練。由於大多數權重可以被凍結(MLLM 內的自註意力區塊),因而可以實現參數高效的端到端訓練。

實驗評估

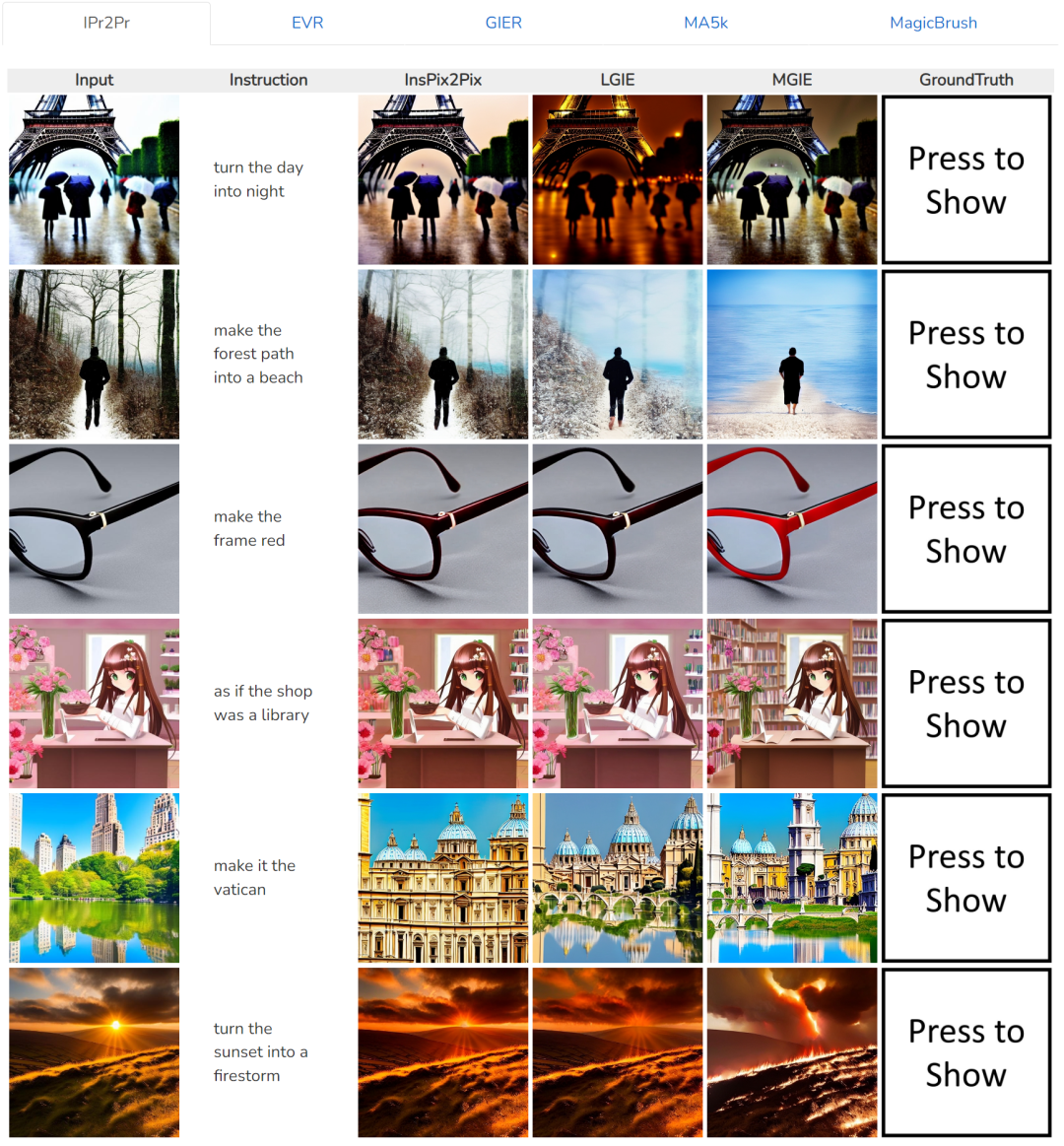

#對於輸入圖片,在相同的指令下,不同方法之間的比較,如第一行的指令是「把白天變成黑夜」:##

#

#

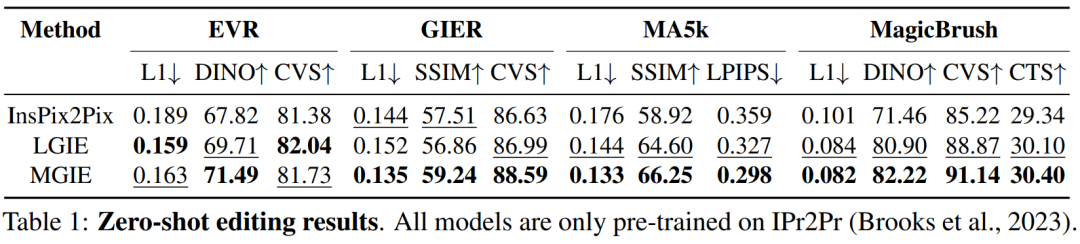

表 1 显示了模型仅在数据集 IPr2Pr 上训练的零样本编辑结果。对于涉及 Photoshop 风格修改的 EVR 和 GIER,编辑结果更接近引导意图(例如,LGIE 在 EVR 上获得了更高的 82.0 CVS)。对于 MA5k 上的全局图片优化,由于相关训练三元组的稀缺,InsPix2Pix 很难处理。LGIE 和 MGIE 可以通过 LLM 的学习提供详细的解释,但 LGIE 仍然局限于其单一的模态。通过访问图像,MGIE 可以得出明确的指令,例如哪些区域应该变亮或哪些对象更加清晰,从而带来显著的性能提升(例如,更高的 66.3 SSIM 和更低的 0.3 拍照距离),在 MagicBrush 上也发现了类似的结果。MGIE 还从精确的视觉想象中获得最佳性能,并修改指定目标作为目标(例如,更高的 82.2 DINO 视觉相似度和更高的 30.4 CTS 全局字幕对齐)。

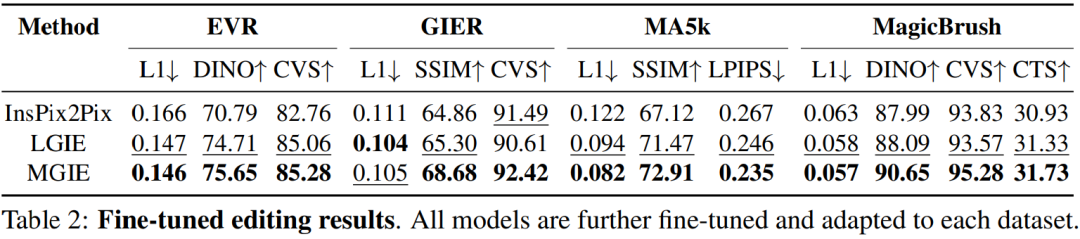

为了研究针对特定目的的基于指令的图像编辑,表 2 对每个数据集上的模型进行了微调。对于 EVR 和 GIER,所有模型在适应 Photoshop 风格的编辑任务后都获得了改进。MGIE 在编辑的各个方面始终优于 LGIE。这也说明了使用表达指令进行学习可以有效地增强图像编辑,而视觉感知在获得最大增强的明确引导方面起着至关重要的作用。

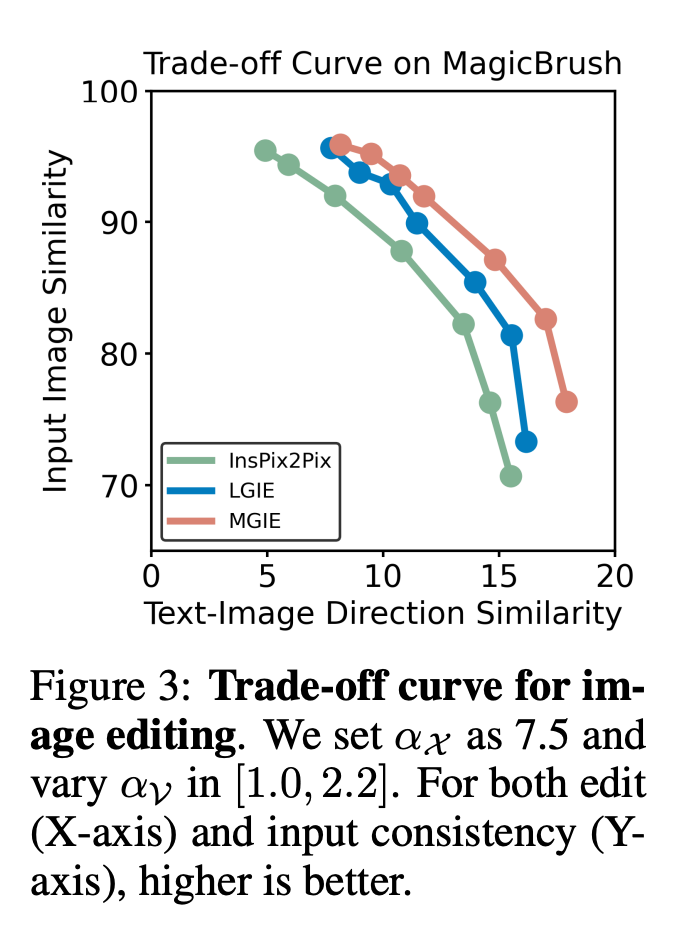

α_X 和 α_V 之间的权衡。图像编辑有两个目标:操作作为指令的目标和保留作为输入图像的剩余部分。图 3 显示了指令 (α_X) 和输入一致性 (α_V) 之间的权衡曲线。该研究将 α_X 固定为 7.5,α_V 在 [1.0, 2.2] 范围内变化。α_V 越大,编辑结果与输入越相似,但与指令的一致性越差。X 轴计算的是 CLIP 方向相似度,即编辑结果与指令的一致程度;Y 轴是 CLIP 视觉编码器与输入图像的特征相似度。通过具体的表达指令,实验在所有设置中都超越了 InsPix2Pix。此外, MGIE 还能通过明确的视觉相关引导进行学习,从而实现全面提升。无论是要求更高的输入相关性还是编辑相关性,这都支持稳健的改进。

消融研究

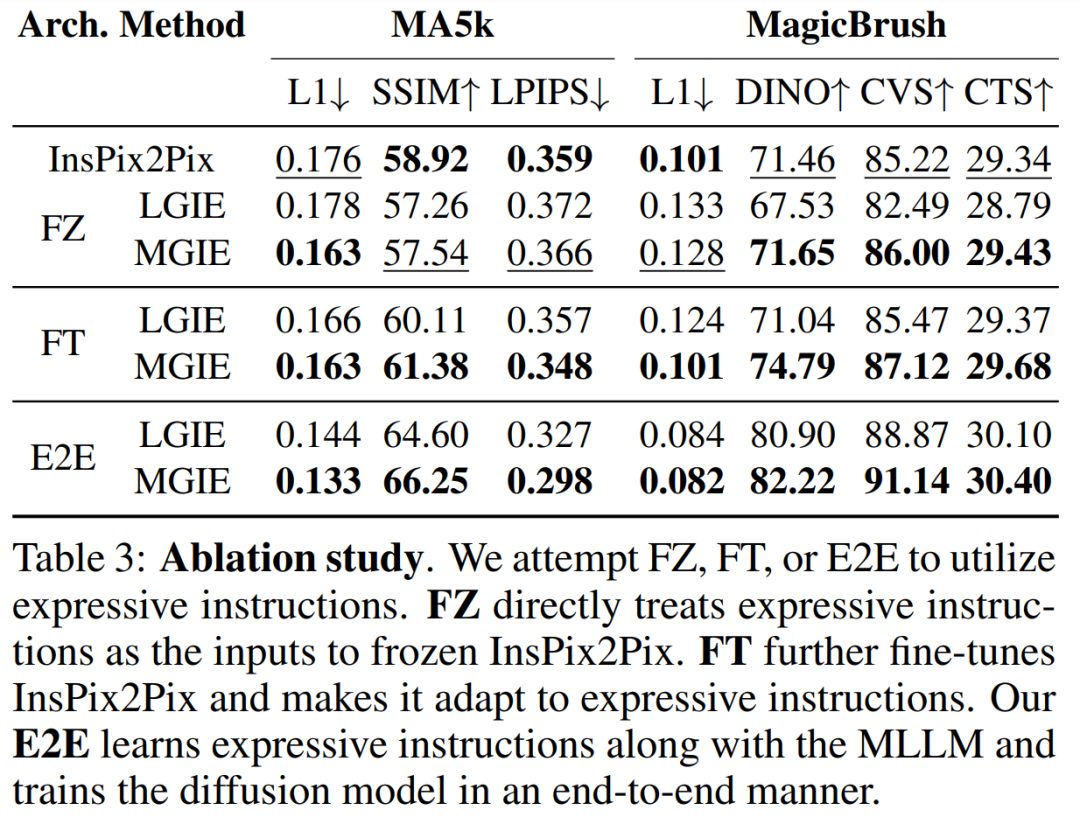

除此以外,研究者还进行了消融实验,考虑了不同的架构 FZ、FT 以及 E2E 在表达指令上的性能 。结果表明,在 FZ、FT、E2E 中,MGIE 持续超过 LGIE。这表明具有关键视觉感知的表达指令在所有消融设置中始终具有优势。

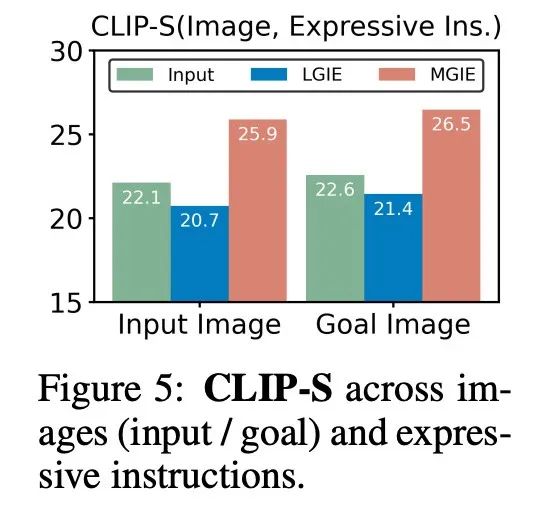

为什么 MLLM 引导有用?图 5 显示了输入或 ground-truth 目标图像与表达式指令之间的 CLIP-Score 值。输入图像的 CLIP-S 分数越高,说明指令与编辑源相关,而更好地与目标图像保持一致可提供明确、相关的编辑引导。如图所示,MGIE 与输入 / 目标更加一致,这就解释了为什么其表达性指令很有帮助。有了对预期结果的清晰叙述,MGIE 可以在图像编辑方面取得最大的改进。

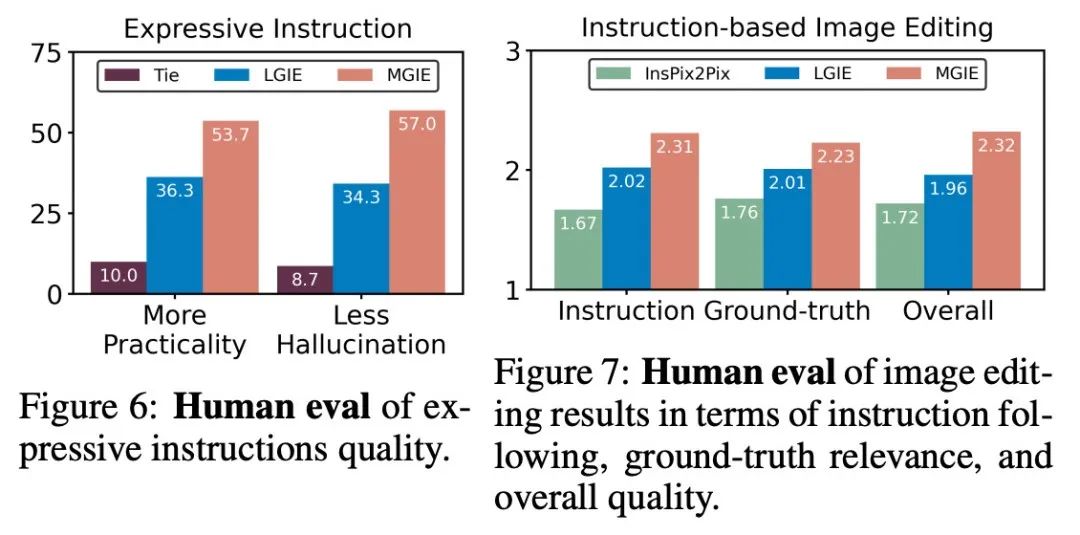

人工评估。除了自动指标外,研究者还进行了人工评估。图 6 显示了生成的表达指令的质量,图 7 对比了 InsPix2Pix、LGIE 和 MGIE 在指令遵循、ground-truth 相关性和整体质量方面的图像编辑结果。

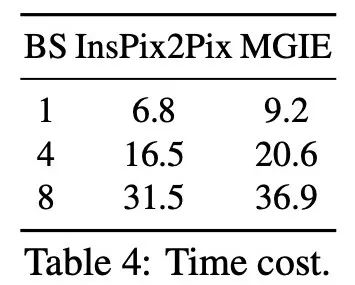

推理效率。儘管 MGIE 依靠 MLLM 來推動映像編輯,但它只推出了簡潔的表達式指令(少於 32 個 token),因此效率與 InsPix2Pix 不相上下。表 4 列出了在英偉達 A100 GPU 上的推理時間成本。對於單一輸入,MGIE 可以在 10 秒內完成編輯任務。在資料並行化程度較高的情況下,所需的時間也差不多(當批次大小為 8 時,需要 37 秒)。整個過程只需一個 GPU(40GB)即可完成。

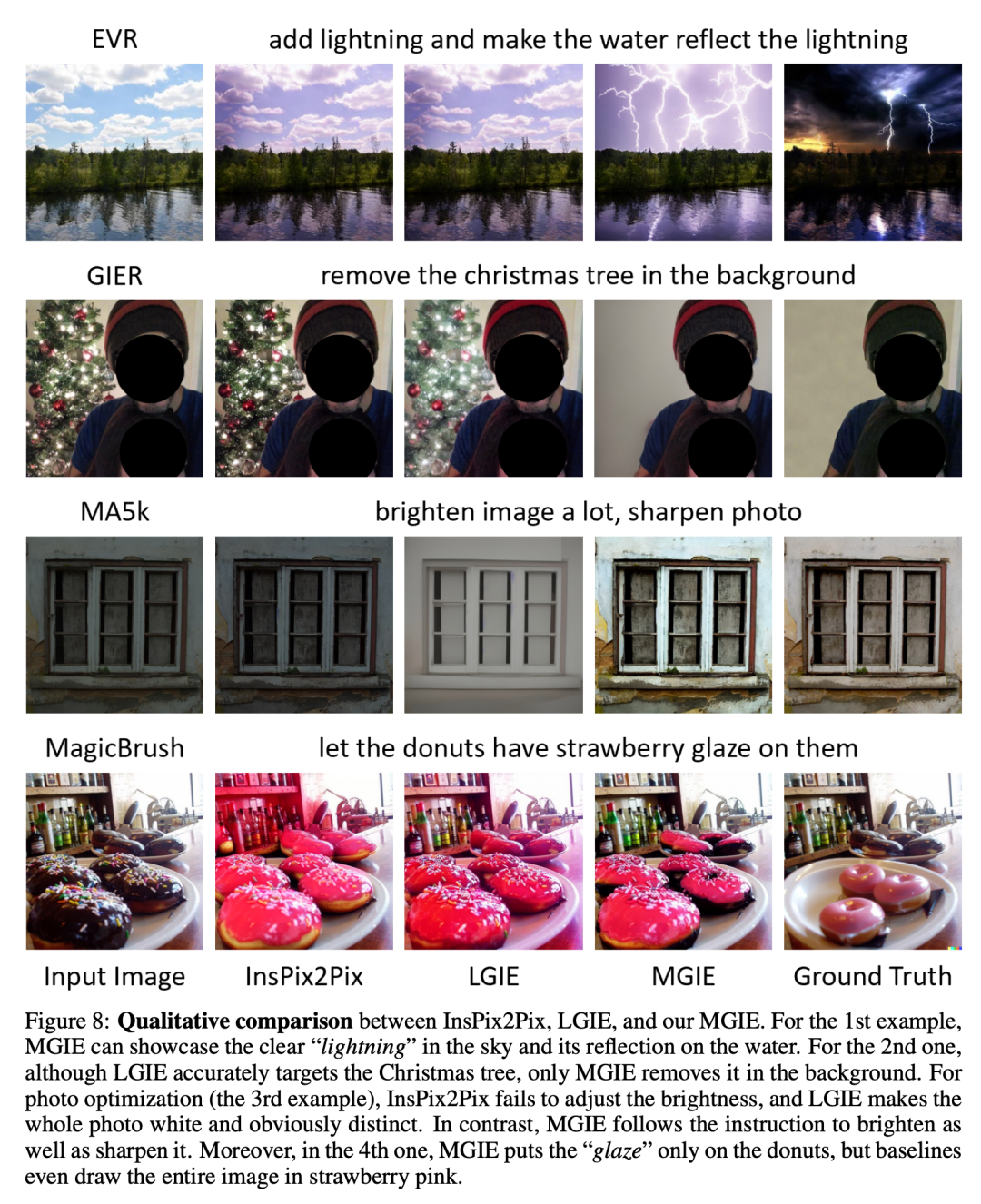

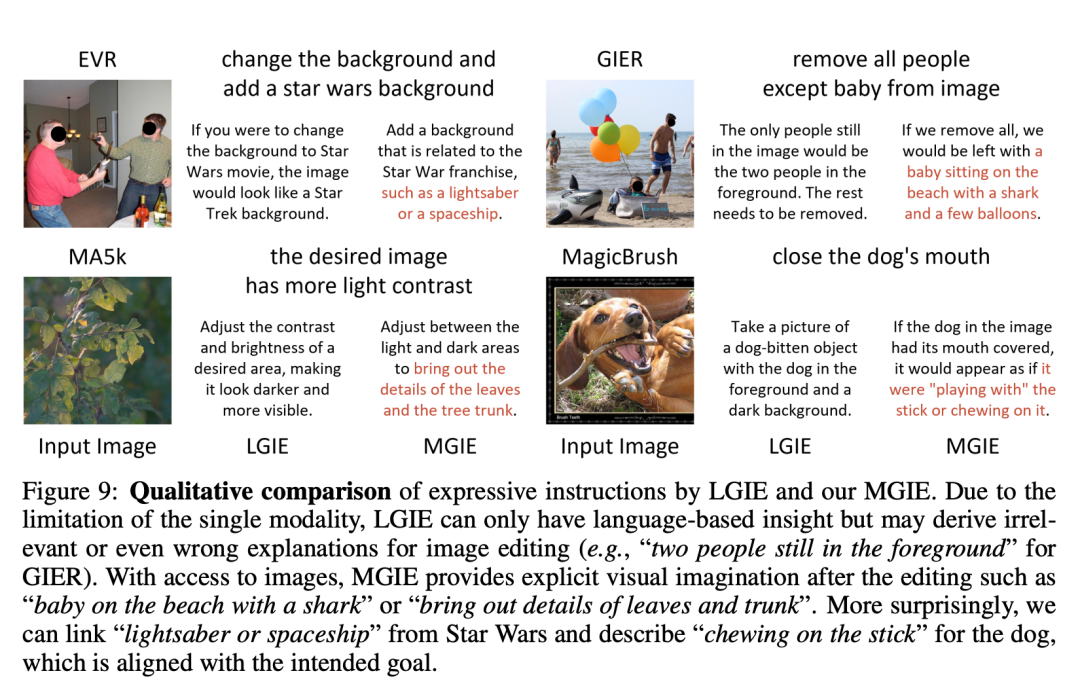

定性比較。圖 8 展示了所有使用資料集的視覺化對比,圖 9 進一步對比了 LGIE 或 MGIE 的表達指令。

在專案首頁中,研究者也提供了更多demo(https://mllm- ie.github.io/)。更多研究細節,可參考原論文。

以上是罕見!蘋果開源圖片編輯神器MGIE,要上iPhone?的詳細內容。更多資訊請關注PHP中文網其他相關文章!