Transformers是一種使用自註意力機制的模型,它採用編碼器-解碼器架構來實現結果。一些常見的基於Transformer架構的模型包括BERT和RoBERTa。

Transformer架構是專為處理自然語言處理任務中的序列到序列問題而設計的。相對於傳統的RNN、LSTM等架構,Transformer的主要優勢在於其獨特的自註意力機制。這種機制使得Transformer能夠準確地捕捉輸入句子中標記之間的遠端依賴和相關性,並且大大降低了計算時間。透過自註意力機制,Transformer能夠對輸入序列中的每個位置進行自適應的加權處理,從而更好地捕捉到不同位置的上下文資訊。這種機制使得Transformer在處理長距離依賴性時更加有效,從而在許多自然語言處理任務中取得了優異的效能。

這個架構是基於編碼器-解碼器,由多層編碼器和解碼器組成。每個編碼器包含多個子層,包括多頭自註意力層和位置全連接前饋神經網路。同樣,每個解碼器也有兩個相同的子層,並添加了一個名為編碼解碼器注意力層的第三個子層,該層應用於編碼器堆疊的輸出。

每個子層後面都有一個歸一化層,同時每個前饋神經網路周圍都有殘差連接。這種殘差連接提供了梯度和資料流的自由路徑,有助於在訓練深度神經網路時避免梯度消失的問題。

編碼器的注意力向量被傳送到前饋神經網絡,將其轉換為向量表示,並傳遞至下一個注意層。解碼器的任務是將編碼器的注意力向量轉換為輸出資料。在訓練階段,解碼器可以使用編碼器產生的注意力向量和預期結果。

解碼器使用相同的標記化、字詞嵌入和注意力機制,以處理預期結果並產生注意力向量。隨後,此註意力向量與編碼器模組中的注意力層進行交互,以建立輸入和輸出值之間的關聯。解碼器注意力向量經過前饋層的處理,再映射為目標資料大小的大向量。

以上是Transformer模型應用簡介的詳細內容。更多資訊請關注PHP中文網其他相關文章!

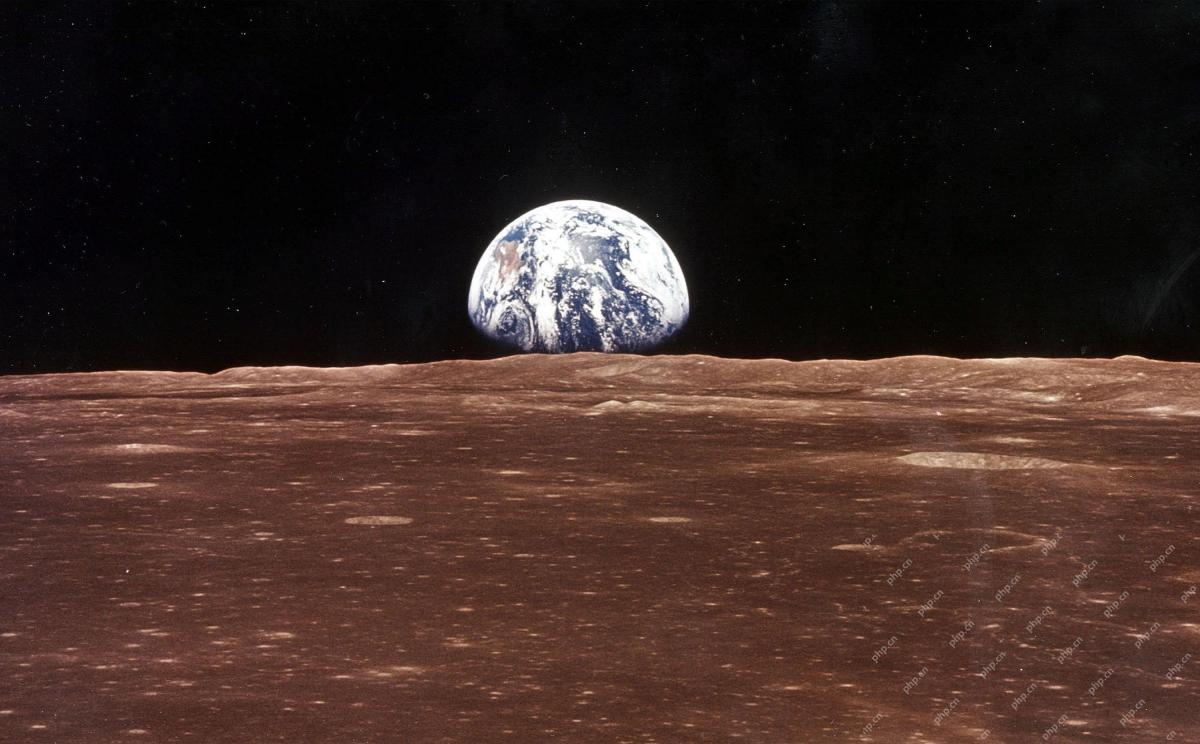

AI太空公司誕生了May 12, 2025 am 11:07 AM

AI太空公司誕生了May 12, 2025 am 11:07 AM本文展示了AI如何以Tomorrow.io為典型的例子來徹底改變空間行業。 與像SpaceX這樣的建立太空公司不同,SpaceX並非沒有AI的核心,明天是AI本地公司。 讓我們探索

印度的10個機器學習實習(2025)May 12, 2025 am 10:47 AM

印度的10個機器學習實習(2025)May 12, 2025 am 10:47 AM在印度(2025)登陸您夢想中的機器學習實習! 對於學生和早期職業專業人員來說,機器學習實習是一個有意義的職業的完美髮射台。 跨不同部門的印度公司 - 尖端的基因

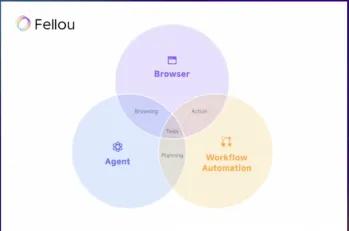

嘗試Fellou AI並向Google和Chatgpt說再見May 12, 2025 am 10:26 AM

嘗試Fellou AI並向Google和Chatgpt說再見May 12, 2025 am 10:26 AM在過去的一年中,在線瀏覽的景觀經歷了重大轉變。 這種轉變始於增強,個性化的搜索結果,例如困惑和副駕駛等平台,並隨著Chatgpt的整合而加速了

個人黑客將是一隻非常兇猛的熊May 11, 2025 am 11:09 AM

個人黑客將是一隻非常兇猛的熊May 11, 2025 am 11:09 AM網絡攻擊正在發展。 通用網絡釣魚電子郵件的日子已經一去不復返了。 網絡犯罪的未來是超個性化的,利用了容易獲得的在線數據和AI來製作高度針對性的攻擊。 想像一個知道您的工作的騙子

教皇獅子座XIV揭示了AI如何影響他的名字選擇May 11, 2025 am 11:07 AM

教皇獅子座XIV揭示了AI如何影響他的名字選擇May 11, 2025 am 11:07 AM新當選的教皇獅子座(Leo Xiv)在對紅衣主教學院的就職演講中,討論了他的同名人物教皇里奧XIII的影響,他的教皇(1878-1903)與汽車和汽車和汽車公司的黎明相吻合

Fastapi -MCP初學者和專家教程-Analytics VidhyaMay 11, 2025 am 10:56 AM

Fastapi -MCP初學者和專家教程-Analytics VidhyaMay 11, 2025 am 10:56 AM本教程演示瞭如何使用模型上下文協議(MCP)和FastAPI將大型語言模型(LLM)與外部工具集成在一起。 我們將使用FastAPI構建一個簡單的Web應用程序,並將其轉換為MCP服務器,使您的L

dia-1.6b tts:最佳文本到二元格生成模型 - 分析vidhyaMay 11, 2025 am 10:27 AM

dia-1.6b tts:最佳文本到二元格生成模型 - 分析vidhyaMay 11, 2025 am 10:27 AM探索DIA-1.6B:由兩個本科生開發的開創性的文本對語音模型,零資金! 這個16億個參數模型產生了非常現實的語音,包括諸如笑聲和打噴嚏之類的非語言提示。本文指南

AI可以使指導比以往任何時候都更有意義May 10, 2025 am 11:17 AM

AI可以使指導比以往任何時候都更有意義May 10, 2025 am 11:17 AM我完全同意。 我的成功與導師的指導密不可分。 他們的見解,尤其是關於業務管理,構成了我的信念和實踐的基石。 這種經驗強調了我對導師的承諾

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

記事本++7.3.1

好用且免費的程式碼編輯器

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。