遷移學習是一種利用已有機器學習任務中的訓練模型來解決新任務的方法。它透過將已有模型的知識遷移到新任務中,能夠減少新任務所需的訓練資料量。近年來,遷移學習在自然語言處理和影像辨識等領域已廣泛應用。本文將詳細介紹遷移學習的概念和原則。

經典遷移學習策略

根據任務的領域、資料的可用性,應用不同的遷移學習策略和技術。

1、歸納遷移學習

歸納遷移學習要求源域和目標域相同,儘管模型處理的特定任務不同。這些演算法試圖利用來源模型的知識,並將其應用於改進目標任務。預訓練模型已經具備了領域特徵的專業知識,相較於從頭開始訓練,它們具有更好的起點。

根據來源域是否包含標記數據,歸納遷移學習進一步分為兩個子類別。這些分別包括多任務學習和自學學習。

2、轉導遷移學習

來源任務和目標任務的領域不完全相同但相互關聯的場景可使用轉導遷移學習策略。人們可以得出源任務和目標任務之間的相似性。這些場景通常在來源域中有大量標記數據,而目標域中只有未標記資料。

3、無監督遷移學習

無監督遷移學習類似歸納遷移學習。唯一的區別是演算法側重於無監督任務,並且在來源任務和目標任務中都涉及未標記的資料集。

4、基於領域的相似性並獨立於訓練的資料樣本類型的策略

- 同構遷移學習

開發並提出了同構遷移學習方法來處理領域具有相同特徵空間的情況。在同構遷移學習中,域在邊際分佈上只有微小的差異。這些方法透過修正樣本選擇偏差或協變量偏移來調整域。

- 異質遷移學習

異質遷移學習方法旨在解決具有不同特徵空間的來源域和目標域的問題以及不同資料分佈和標籤空間等其他問題。異質遷移學習應用於跨領域任務,例如跨語言文字分類、文字到圖像分類等。

遷移學習6個步驟

1.取得預訓練模型

第一步是根據任務選擇我們希望保留的預訓練模型作為我們訓練的基礎。遷移學習需要預先訓練源模型的知識與目標任務域之間的強相關性才能相容。

2.建立基礎模型

基礎模型是在第一步中選擇與任務密切相關的架構,可能存在這樣一種情況,基礎模型在最終輸出層中的神經元數量超過用例中所需的數量。在這種情況下,需要移除最終輸出層並進行相應更改。

3.凍結起始層

凍結預訓練模型的起始層對於避免使模型學習基本特徵的至關重要。如果不凍結初始層,將失去所有已經發生的學習。這與從頭開始訓練模型沒有什麼不同,會導致浪費時間、資源等。

4.新增的可訓練層

#從基礎模型中重複使用的唯一知識是特徵提取層。需要在特徵提取層之上添加額外的層來預測模型的特殊任務。這些通常是最終的輸出層。

5.訓練新層

預訓練模型的最終輸出很可能與我們想要的模型輸出不同,在這種情況下,必須使用新的輸出層來訓練模型。

6.微調模型

為了提高模型的效能。微調涉及解凍基礎模型的某些部分,並以非常低的學習率在整個資料集上再次訓練整個模型。低學習率將提高模型在新資料集上的效能,同時防止過度擬合。

傳統機器學習與遷移學習的差異

#1.傳統機器學習模型需要從頭開始訓練,計算量大,需要大量數據才能達到高性能。另一方面,遷移學習計算效率高,有助於使用小資料集獲得更好的結果。

2.傳統機器學習採用孤立的訓練方法,每個模型都針對特定目的進行獨立訓練,不依賴過去的知識。與此相反,遷移學習使用從預訓練模型中獲得的知識來處理任務。

3.遷移學習模型比傳統的ML模型更快達到最佳效能。這是因為利用先前訓練的模型的知識(特徵、權重等)的模型已經理解了這些特徵。它比從頭開始訓練神經網路更快。

深度遷移學習的概念

許多模型預訓練的神經網路和模型構成了深度學習背景下遷移學習的基礎,這被稱為深度遷移學習。

#要了解深度學習模型的流程,必須了解它們的組成部分。深度學習系統是分層架構,可以在不同層學習不同的特徵。初始層編譯更高層級的功能,隨著我們深入網絡,這些功能會縮小到細粒度的功能。

這些層最終連接到最後一層以獲得最終輸出。這開啟了使用流行的預訓練網路的限制,無需將其最後一層作為其他任務的固定特徵提取器。其關鍵思想是利用預訓練模型的加權層來提取特徵,但在使用新任務的新資料訓練期間不更新模型的權重。

深度神經網路是分層結構,具有許多可調的超參數。初始層的作用是捕捉通用特徵,而後面的層更側重於手邊的明確任務。微調基礎模型中的高階特徵表示以使其與特定任務更相關是有意義的。我們可以重新訓練模型的某些層,同時在訓練中保持一些凍結。

進一步提升模型效能的方法是重新訓練或微調預訓練模型頂層的權重,同時訓練分類器。這將強制從模型來源任務中學習到的通用特徵圖中更新權重。微調將允許模型在目標領域中應用過去的知識並重新學習一些東西。

此外,應該嘗試微調少數頂層而不是整個模型。前幾層學習基本的通用的特徵,這些特徵可以泛化到幾乎所有類型的資料。微調的目的是使這些專門的特徵適應新的資料集,而不是覆蓋通用的學習。

#以上是理解遷移學習的策略、步驟、差異和概念的詳細內容。更多資訊請關注PHP中文網其他相關文章!

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM

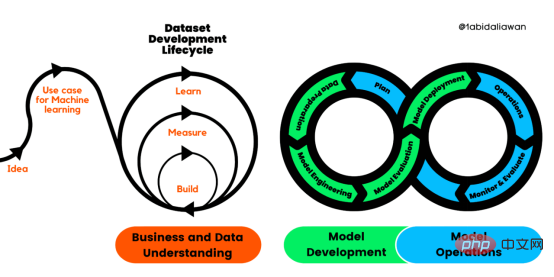

解读CRISP-ML(Q):机器学习生命周期流程Apr 08, 2023 pm 01:21 PM译者 | 布加迪审校 | 孙淑娟目前,没有用于构建和管理机器学习(ML)应用程序的标准实践。机器学习项目组织得不好,缺乏可重复性,而且从长远来看容易彻底失败。因此,我们需要一套流程来帮助自己在整个机器学习生命周期中保持质量、可持续性、稳健性和成本管理。图1. 机器学习开发生命周期流程使用质量保证方法开发机器学习应用程序的跨行业标准流程(CRISP-ML(Q))是CRISP-DM的升级版,以确保机器学习产品的质量。CRISP-ML(Q)有六个单独的阶段:1. 业务和数据理解2. 数据准备3. 模型

2023年机器学习的十大概念和技术Apr 04, 2023 pm 12:30 PM

2023年机器学习的十大概念和技术Apr 04, 2023 pm 12:30 PM机器学习是一个不断发展的学科,一直在创造新的想法和技术。本文罗列了2023年机器学习的十大概念和技术。 本文罗列了2023年机器学习的十大概念和技术。2023年机器学习的十大概念和技术是一个教计算机从数据中学习的过程,无需明确的编程。机器学习是一个不断发展的学科,一直在创造新的想法和技术。为了保持领先,数据科学家应该关注其中一些网站,以跟上最新的发展。这将有助于了解机器学习中的技术如何在实践中使用,并为自己的业务或工作领域中的可能应用提供想法。2023年机器学习的十大概念和技术:1. 深度神经网

基于因果森林算法的决策定位应用Apr 08, 2023 am 11:21 AM

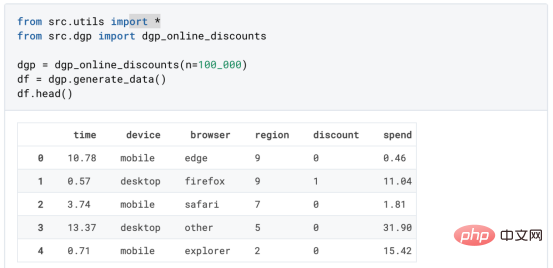

基于因果森林算法的决策定位应用Apr 08, 2023 am 11:21 AM译者 | 朱先忠审校 | 孙淑娟在我之前的博客中,我们已经了解了如何使用因果树来评估政策的异质处理效应。如果你还没有阅读过,我建议你在阅读本文前先读一遍,因为我们在本文中认为你已经了解了此文中的部分与本文相关的内容。为什么是异质处理效应(HTE:heterogenous treatment effects)呢?首先,对异质处理效应的估计允许我们根据它们的预期结果(疾病、公司收入、客户满意度等)选择提供处理(药物、广告、产品等)的用户(患者、用户、客户等)。换句话说,估计HTE有助于我

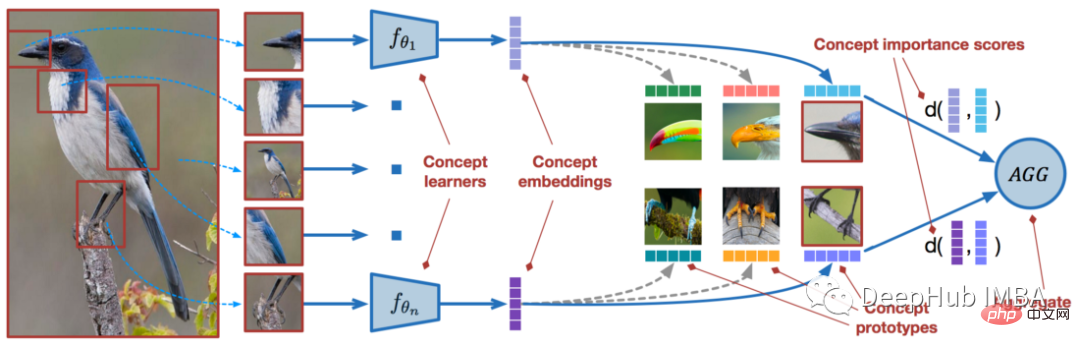

使用PyTorch进行小样本学习的图像分类Apr 09, 2023 am 10:51 AM

使用PyTorch进行小样本学习的图像分类Apr 09, 2023 am 10:51 AM近年来,基于深度学习的模型在目标检测和图像识别等任务中表现出色。像ImageNet这样具有挑战性的图像分类数据集,包含1000种不同的对象分类,现在一些模型已经超过了人类水平上。但是这些模型依赖于监督训练流程,标记训练数据的可用性对它们有重大影响,并且模型能够检测到的类别也仅限于它们接受训练的类。由于在训练过程中没有足够的标记图像用于所有类,这些模型在现实环境中可能不太有用。并且我们希望的模型能够识别它在训练期间没有见到过的类,因为几乎不可能在所有潜在对象的图像上进行训练。我们将从几个样本中学习

LazyPredict:为你选择最佳ML模型!Apr 06, 2023 pm 08:45 PM

LazyPredict:为你选择最佳ML模型!Apr 06, 2023 pm 08:45 PM本文讨论使用LazyPredict来创建简单的ML模型。LazyPredict创建机器学习模型的特点是不需要大量的代码,同时在不修改参数的情况下进行多模型拟合,从而在众多模型中选出性能最佳的一个。 摘要本文讨论使用LazyPredict来创建简单的ML模型。LazyPredict创建机器学习模型的特点是不需要大量的代码,同时在不修改参数的情况下进行多模型拟合,从而在众多模型中选出性能最佳的一个。本文包括的内容如下:简介LazyPredict模块的安装在分类模型中实施LazyPredict

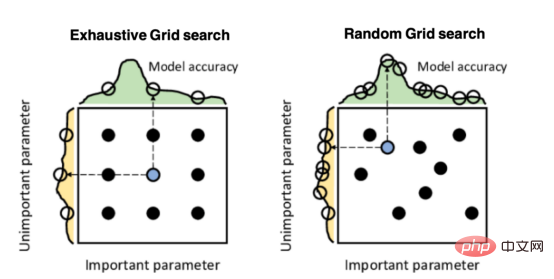

Mango:基于Python环境的贝叶斯优化新方法Apr 08, 2023 pm 12:44 PM

Mango:基于Python环境的贝叶斯优化新方法Apr 08, 2023 pm 12:44 PM译者 | 朱先忠审校 | 孙淑娟引言模型超参数(或模型设置)的优化可能是训练机器学习算法中最重要的一步,因为它可以找到最小化模型损失函数的最佳参数。这一步对于构建不易过拟合的泛化模型也是必不可少的。优化模型超参数的最著名技术是穷举网格搜索和随机网格搜索。在第一种方法中,搜索空间被定义为跨越每个模型超参数的域的网格。通过在网格的每个点上训练模型来获得最优超参数。尽管网格搜索非常容易实现,但它在计算上变得昂贵,尤其是当要优化的变量数量很大时。另一方面,随机网格搜索是一种更快的优化方法,可以提供更好的

超参数优化比较之网格搜索、随机搜索和贝叶斯优化Apr 04, 2023 pm 12:05 PM

超参数优化比较之网格搜索、随机搜索和贝叶斯优化Apr 04, 2023 pm 12:05 PM本文将详细介绍用来提高机器学习效果的最常见的超参数优化方法。 译者 | 朱先忠审校 | 孙淑娟简介通常,在尝试改进机器学习模型时,人们首先想到的解决方案是添加更多的训练数据。额外的数据通常是有帮助(在某些情况下除外)的,但生成高质量的数据可能非常昂贵。通过使用现有数据获得最佳模型性能,超参数优化可以节省我们的时间和资源。顾名思义,超参数优化是为机器学习模型确定最佳超参数组合以满足优化函数(即,给定研究中的数据集,最大化模型的性能)的过程。换句话说,每个模型都会提供多个有关选项的调整“按钮

人工智能自动获取知识和技能,实现自我完善的过程是什么Aug 24, 2022 am 11:57 AM

人工智能自动获取知识和技能,实现自我完善的过程是什么Aug 24, 2022 am 11:57 AM实现自我完善的过程是“机器学习”。机器学习是人工智能核心,是使计算机具有智能的根本途径;它使计算机能模拟人的学习行为,自动地通过学习来获取知识和技能,不断改善性能,实现自我完善。机器学习主要研究三方面问题:1、学习机理,人类获取知识、技能和抽象概念的天赋能力;2、学习方法,对生物学习机理进行简化的基础上,用计算的方法进行再现;3、学习系统,能够在一定程度上实现机器学习的系统。

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

Dreamweaver Mac版

視覺化網頁開發工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能