#透過選擇200 個(約6%)高品質的指令遵循資料來訓練InstructionGPT-4,研究者表明可以為多模態大型語言模型使用更少的指令資料來實現更好的對齊。 文中提出了一種資料選擇器,其使用了一種可解釋的簡單原則來選取用於微調的高品質多模態指令遵循資料。這種方法力求在資料子集的評估和調整中實現有效性和可攜性。 研究者透過實驗顯示這種簡單技巧能夠很好地應對不同任務。相較於原始的 MiniGPT-4,僅使用 6% 已過濾資料微調得到的 InstructionGPT-4 在多種任務上都取得了更優表現。

##為了深入了解InstructionGPT-4 在理解視覺輸入和產生合理回應方面的能力,研究者也對InstructionGPT-4 和MiniGPT-4 的圖像理解和對話能力進行了對比評估。此分析基於一個顯眼的實例,涉及到對圖像的描述以及進一步的理解,結果見表 6。

以上是精選200筆資料後,MiniGPT-4被配對相同模型的效果超越的詳細內容。更多資訊請關注PHP中文網其他相關文章!

潛在的醫療補助削減威脅孕產婦醫療保健Apr 17, 2025 am 11:18 AM

潛在的醫療補助削減威脅孕產婦醫療保健Apr 17, 2025 am 11:18 AM眾議院和參議院都同意在周末進行預算框架。該框架要求削減支出,以支付削減稅收的費用,這些減稅量不成比例,以防止赤字增加,同時也增加

Snowflake首席執行官說,AI ROI始於正確獲取數據Apr 17, 2025 am 11:13 AM

Snowflake首席執行官說,AI ROI始於正確獲取數據Apr 17, 2025 am 11:13 AM雪花首席執行官在坐下來告訴我:“人工智能不應該是大爆炸。” “這應該是一系列小項目,顯示出每一步的價值。”但是,正如拉馬斯瓦米(Ramaswamy)指出的那樣,雖然這聽起來可能謹慎,但實際上是策略。 在中間

每天上傳到Deezer的20,000個AI生成的歌曲Apr 17, 2025 am 11:11 AM

每天上傳到Deezer的20,000個AI生成的歌曲Apr 17, 2025 am 11:11 AMDeezer的首席創新官Aurelien Herault在一份聲明中說:“ AI產生的內容繼續傳到Deezer等洪水流媒體平台,我們沒有看到它放慢速度的跡象。” 儘管沒有減輕洪水的跡象,但Deezer確實有

從體育場到場外:AI如何重塑體育的未來Apr 17, 2025 am 11:10 AM

從體育場到場外:AI如何重塑體育的未來Apr 17, 2025 am 11:10 AM這種轉變不再是理論上的。 卡夫集團(Kraft Group) - 新英格蘭愛國者隊,新英格蘭革命和吉列特體育場(Gillette Stadium)的所有者 - 剛剛宣布與NWN建立戰略合作夥伴關係,以現代化和轉變KR的技術

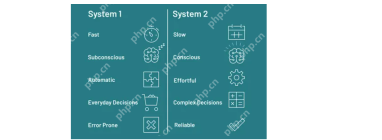

什麼是及時工程中的問題鏈? - 分析VidhyaApr 17, 2025 am 11:06 AM

什麼是及時工程中的問題鏈? - 分析VidhyaApr 17, 2025 am 11:06 AM問題鏈:革命性及時工程 想像一下與AI的對話,每個問題都基於上一個問題,從而導致越來越有見地的答案。這是及時工程中的問題鏈(COQ)的力量

訪問Mistral Nemo:功能,應用程序和含義Apr 17, 2025 am 11:04 AM

訪問Mistral Nemo:功能,應用程序和含義Apr 17, 2025 am 11:04 AMMistral Nemo:強大的開源多語言LLM Mistral AI和Nvidia的合作努力Mismtral Nemo是一種尖端的開源大語模型(LLM),提供最先進的自然語言處理。 這120億桿

Excel中的回合功能是什麼? - 分析VidhyaApr 17, 2025 am 10:56 AM

Excel中的回合功能是什麼? - 分析VidhyaApr 17, 2025 am 10:56 AM掌握Microsoft Excel的圓形功能,以獲得精確的數值數據 數字是電子表格的基礎,但是實現準確性和可讀性通常不僅需要原始數據。 Microsoft Excel的圓形功能是TRA的強大工具

使用LlamainDex的反射劑指南Apr 17, 2025 am 10:41 AM

使用LlamainDex的反射劑指南Apr 17, 2025 am 10:41 AM增強AI智能:深入研究LlamainDex的反射性AI代理 想像一個AI不僅可以解決問題,而且還反映了自己的改進思維過程。這是反光AI代理的領域,本文探討了

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

WebStorm Mac版

好用的JavaScript開發工具

記事本++7.3.1

好用且免費的程式碼編輯器

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

SublimeText3漢化版

中文版,非常好用

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器