谷歌MIT最新研究顯示:取得高品質數據並非難事,大型模式是解決之道

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2024-01-14 20:30:251388瀏覽

取得高品質數據,已經成為目前大模型訓練的一大瓶頸。

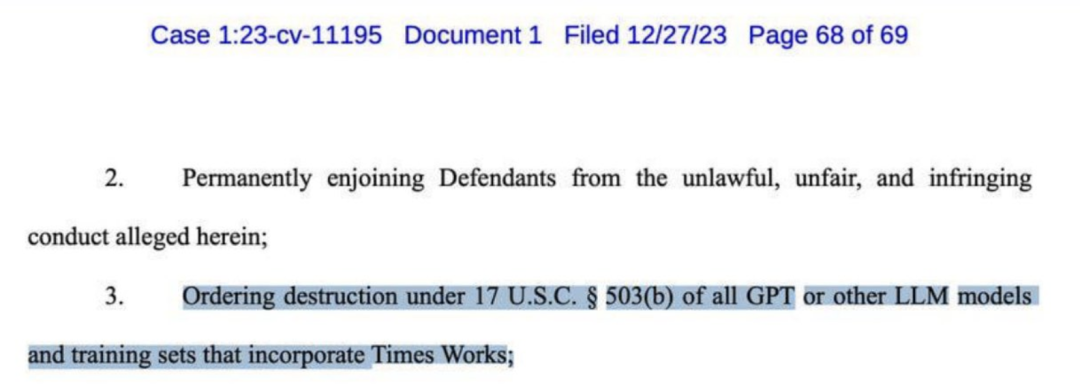

前幾天,OpenAI被《紐約時報》起訴,並要求索賠數十億美元。訴狀中,列舉了GPT-4抄襲的多項罪證。

甚至,《紐約時報》也呼籲摧毀幾乎所有的GPT等大模型。

一直以來,AI界多位大佬認為「合成資料」或許是解決這個問題的最優解。

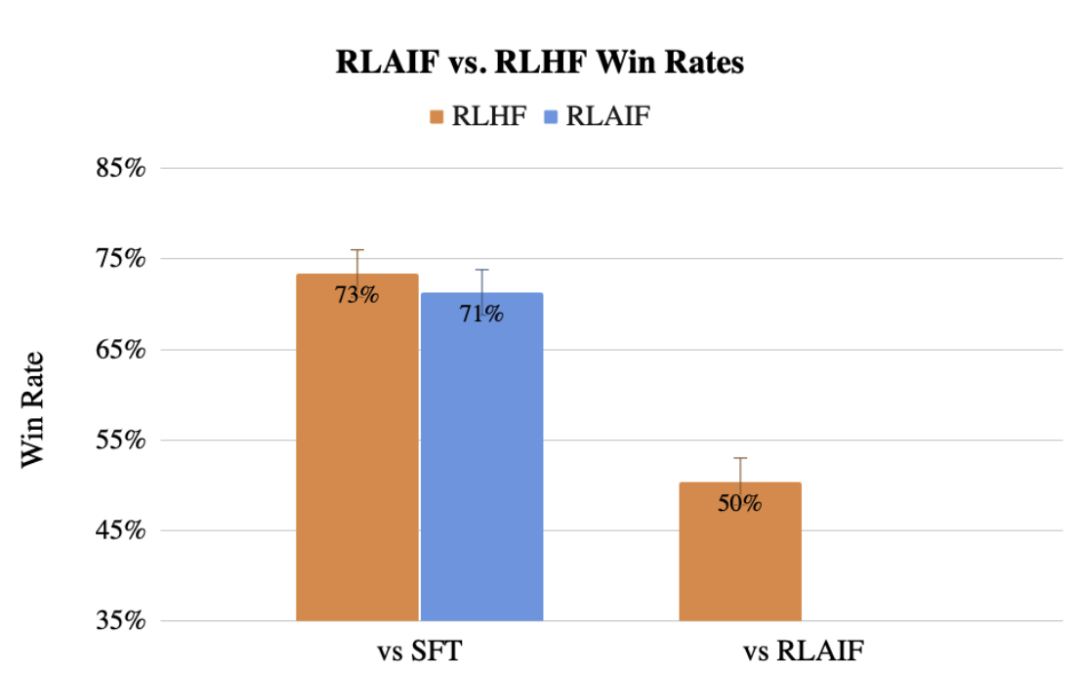

先前,Google團隊也提出了用LLM取代人類標記偏好的方法RLAIF,效果甚至不輸人類。

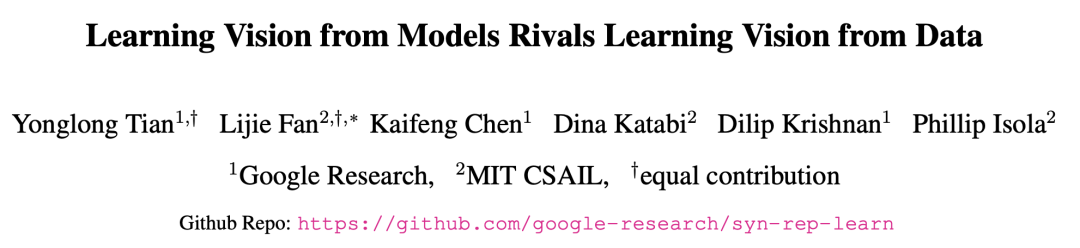

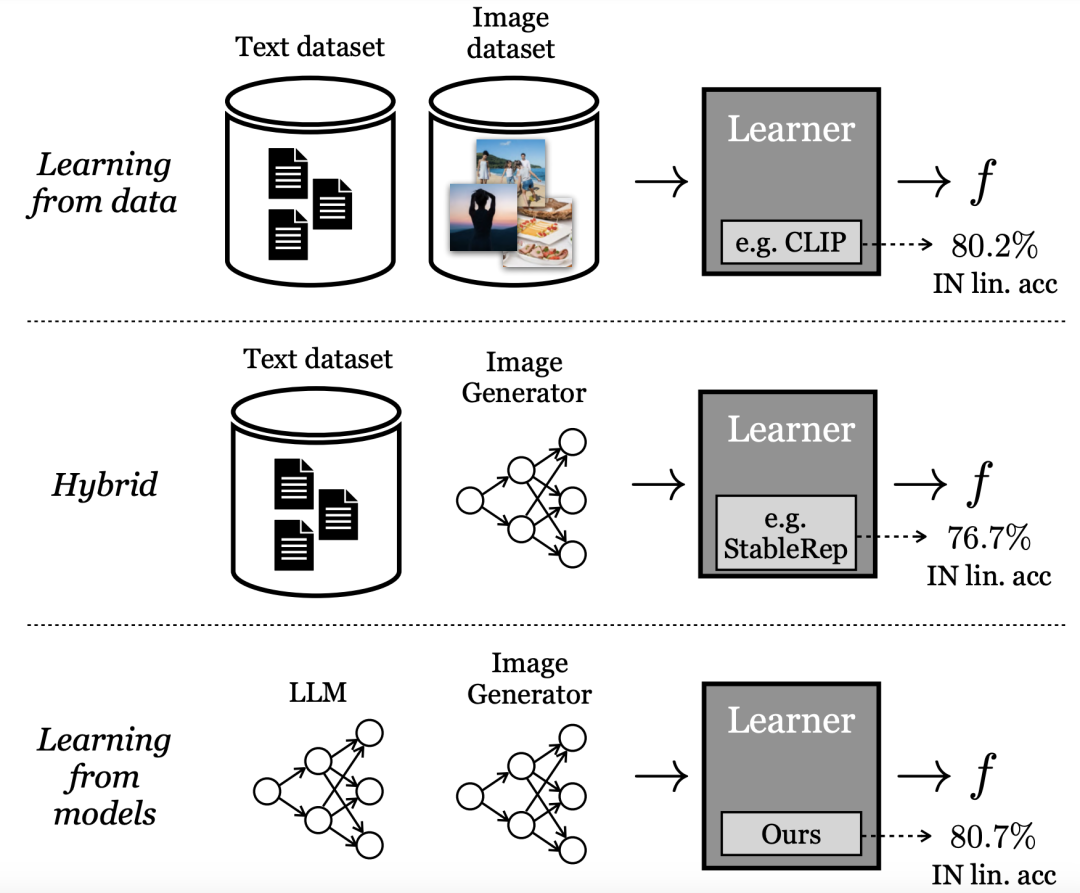

現在,GoogleMIT的研究人員發現,從大模型中學習可以得到使用真實資料訓練的最佳模型的表徵。

此最新方法稱為SynCLR,一種完全從合成影像和合成描述學習虛擬表徵的方法,無需任何真實資料。

論文網址:https://arxiv.org/abs/2312.17742

實驗結果顯示,透過SynCLR方法學習到的表徵,能夠與OpenAI的CLIP在ImageNet 上的傳輸效果一樣好。

從生成模型中學習

#目前表現最好的「視覺表徵」學習方法依賴大規模的實際數據集。然而,真實數據的蒐集卻有不少的困難。

為了降低收集資料的成本,研究人員在本文中提出了一個問題:

從現成的生成模型取樣的合成數據,是否是一條通往大規模策劃數據集的可行之路,從而訓練出最先進的視覺表徵?

與直接從資料中學習不同,Google研究人員稱這種模式為「從模型中學習」。作為建立大規模訓練集的資料來源,模型有幾個優點:

- 透過其潛在變數、條件變數和超參數,為資料管理提供了新的控制方法。

- 模型也更容易共享和儲存(因為模型比資料更容易壓縮),並且可以產生無限數量的資料樣本。

越來越多的文獻研究了產生模型的這些特性和其他優點和缺點,並將其作為訓練下游模型的資料來源。

其中一些方法採用混合模式,即混合真實資料集和合成資料集,或需要一個真實資料集來產生另一個合成資料集。

其他方法試圖從純粹的「合成資料」中學習表徵,但遠遠落後於表現最好的模型。

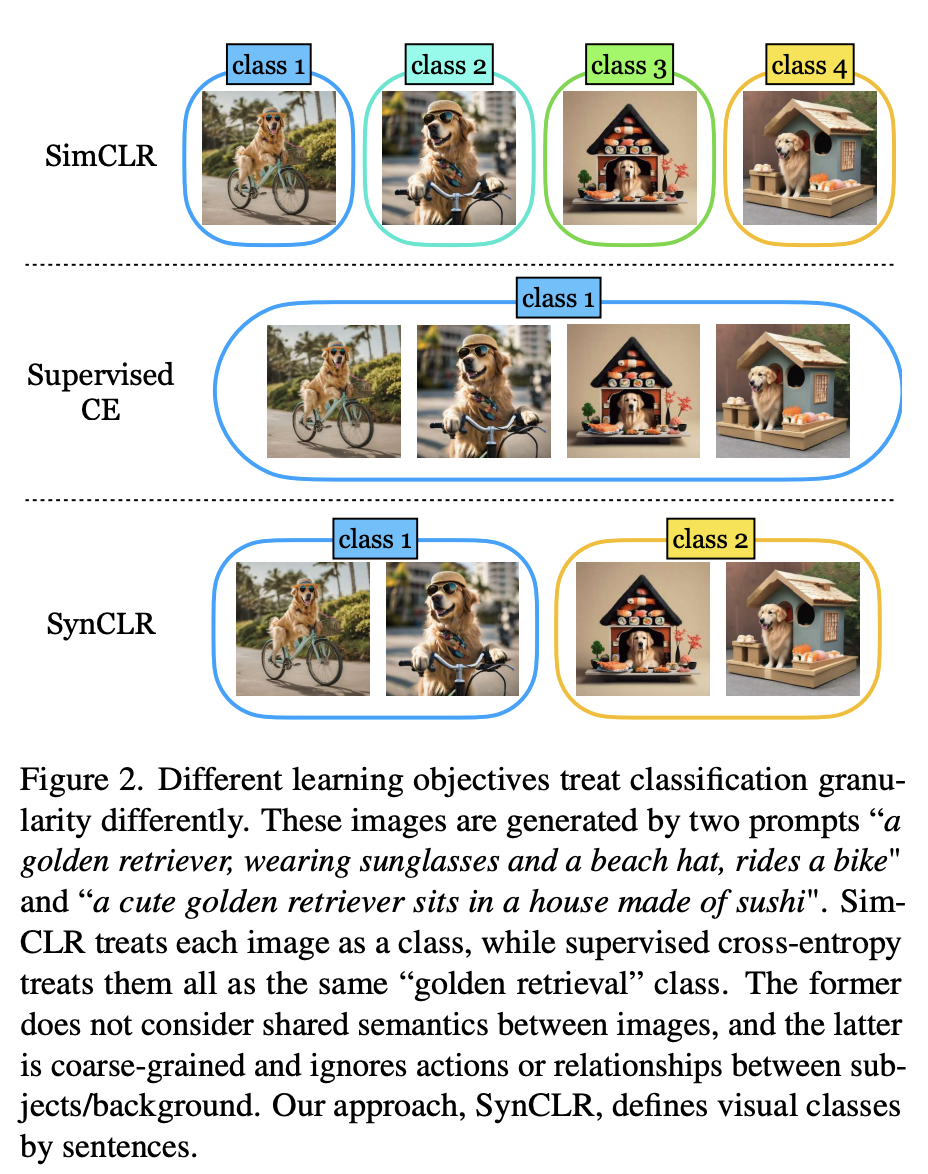

論文中,研究人員提出的最新方法,使用生成模型重新定義視覺化類別的粒度。

如圖2所示,使用2個提示產生了四張圖片「一隻戴著墨鏡和沙灘帽的金毛獵犬騎著腳踏車」和「一隻可愛的金毛獵犬坐在壽司做成的房子裡」。

傳統的自監督方法(如Sim-CLR)會將這些圖像視為不同的類,不同圖像的嵌入會被分開,而不會明確考慮圖像之間的共享語義。

另一個極端是,監督學習方法(即SupCE)會將所有這些圖像視為單一類別(如「黃金獵犬」)。這就忽略了這些圖像在語義上的細微差別,例如在一對圖像中狗在騎自行車,而在另一對圖像中狗坐在壽司屋內。

相反,SynCLR方法將描述視為類,即每個描述一個視覺化類別。

這樣,我們就可以按照「騎自行車」和「坐在壽司店裡」這兩個概念來分組圖片。

這種粒度很難在真實資料中挖掘,因為收集由給定描述的多張圖片並非易事,尤其是當描述數量增加時。

然而,文字到圖像的擴散模型從根本上就具備這種能力。

只需對相同的描述設定條件,並使用不同的雜訊輸入,文字到影像的擴散模型就能產生與相同描述相符的不同影像。

具體來說,作者研究了在沒有真實圖像或文字資料的情況下,學習視覺編碼器的問題。

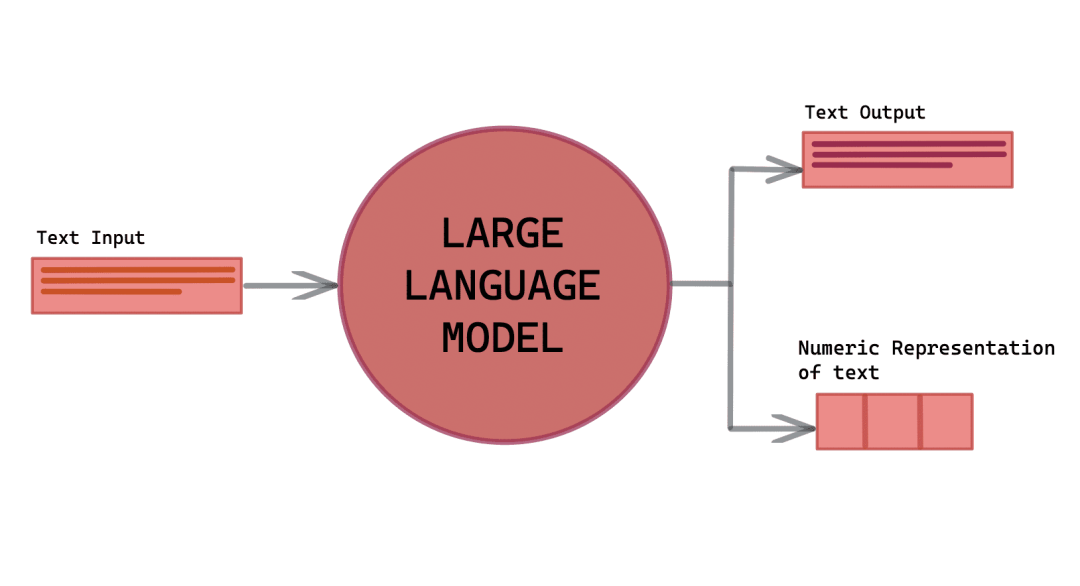

最新方法依賴3個關鍵資源的利用:一個語言生成模型(g1),一個文字到圖像的生成模型(g2),以及一個經過整理的視覺概念清單( c)。

前處理包含三個步驟:

(1)使用(g1)合成一組全面的影像描述T,其中涵蓋了C中的各種視覺概念;

(2)對於T中的每個標題,使用(g2)產生多個圖像,最終產生一個廣泛的合成圖像資料集X ;

(3)在X上進行訓練,以獲得視覺表示編碼器f。

然後,分別使用llama-27b和Stable Diffusion 1.5作為(g1)和(g2),因為其推理速度很快。

合成描述

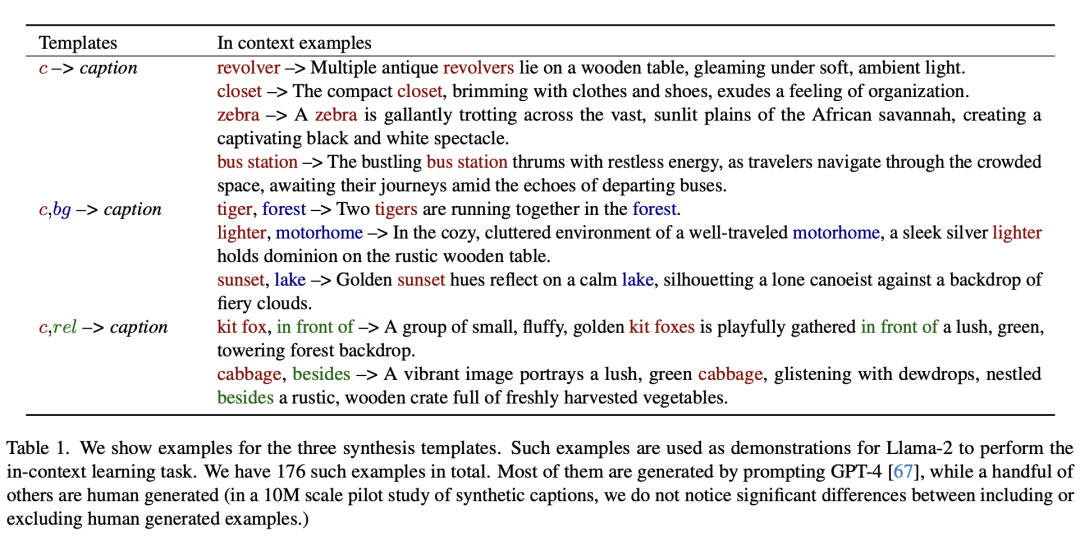

為了利用強大的文字到圖像模型的能力,來產生大量的訓練圖像數據集,首先需要一個不僅精確描述圖像而且展示多樣性的描述集合,以包含廣泛的視覺概念。

對此,作者開發了一種可擴展的方法來創建如此大量的描述集,利用大模型的上下文學習能力。

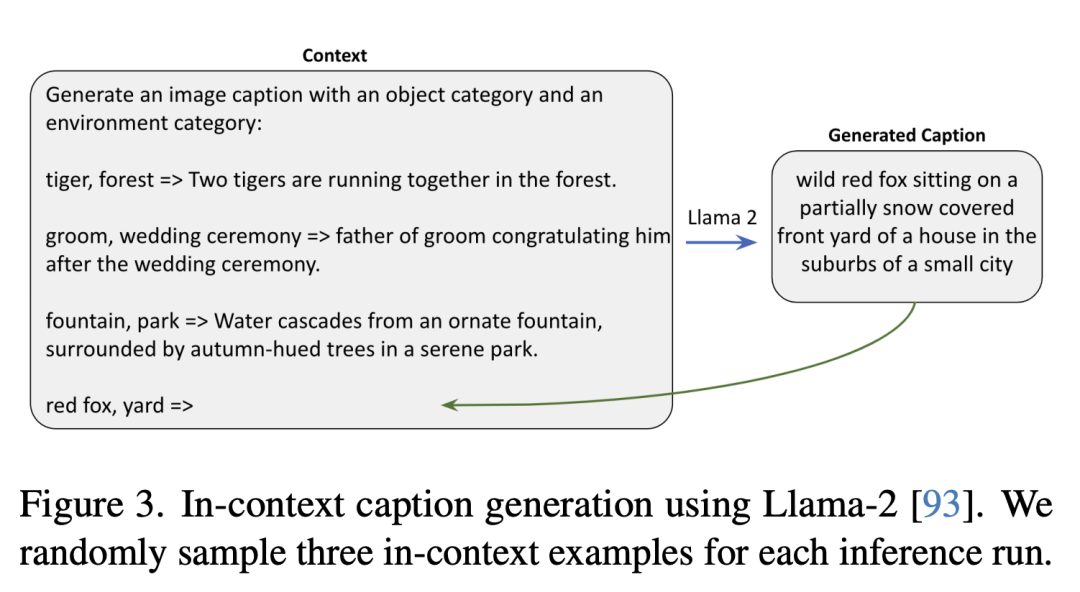

如下展示了三個合成模板的範例。

如下是使用Llama-2產生上下文描述,研究人員在每次推理運行中隨機抽取三個上下文範例。

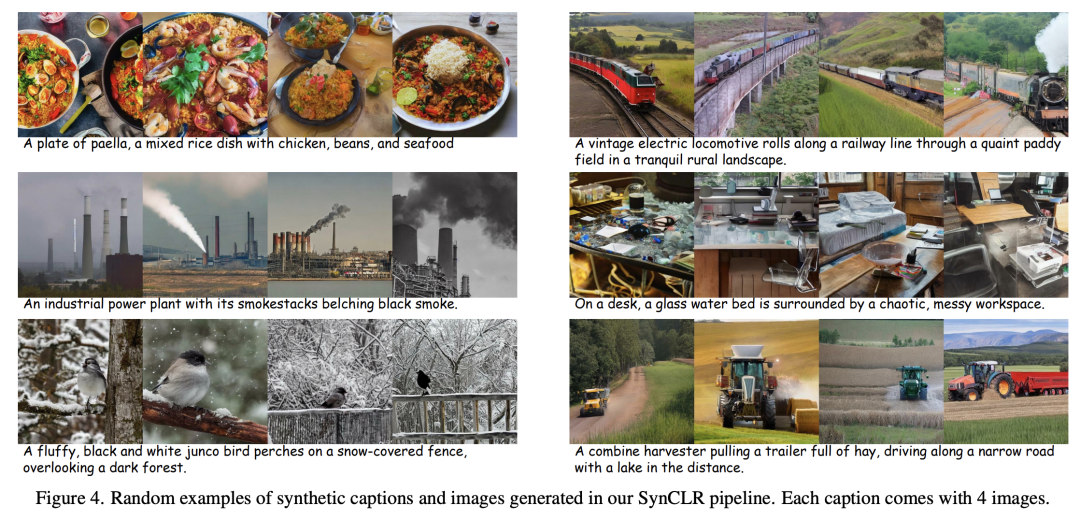

#合成圖像

#對於每個文字描述,研究人員都會以不同的隨機雜訊啟動反向擴散過程,從而產生各種影像。

在這個過程中,無分類器引導(CFG)比例是一個關鍵因素。

CFG標度越高,樣本的品質和文字與圖像之間的一致性就越好,而標度越低,樣本的多樣性就越大,也就越符合基於給定文字的圖像原始條件分佈。

表徵學習

#論文中,表徵學習的方法建立在StableRep的基礎上。

作者提出的方法的關鍵組成部分是多正對比學習損失,它的工作原理是對齊(在嵌入空間)從同一描述生成的圖像。

另外,研究中也結合了其他自監督學習方法的多種技巧。

與OpenAI的CLIP相媲美

實驗評估中,研究人員首先進行消融研究,以評估管道內各種設計和模組的有效性,然後繼續擴大合成數據的量。

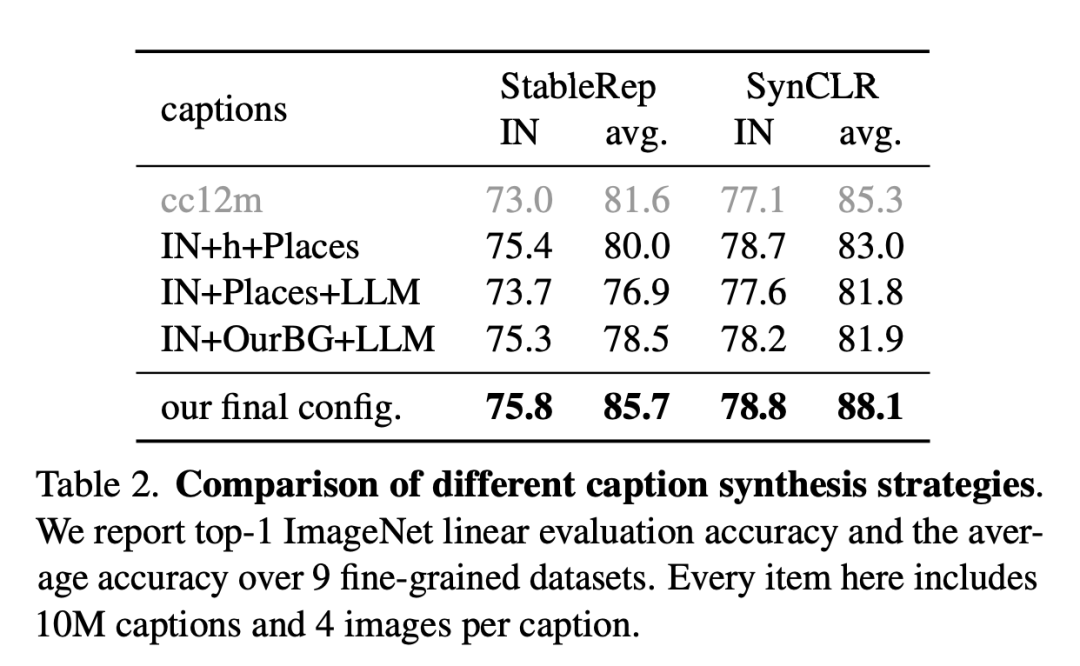

下圖是不同描述合成策略的比較。

研究人員報告了9個細粒度資料集的ImageNet線性評估準確度和平均準確度。這裡的每個項目包括1000萬個描述和每個描述4張圖片。

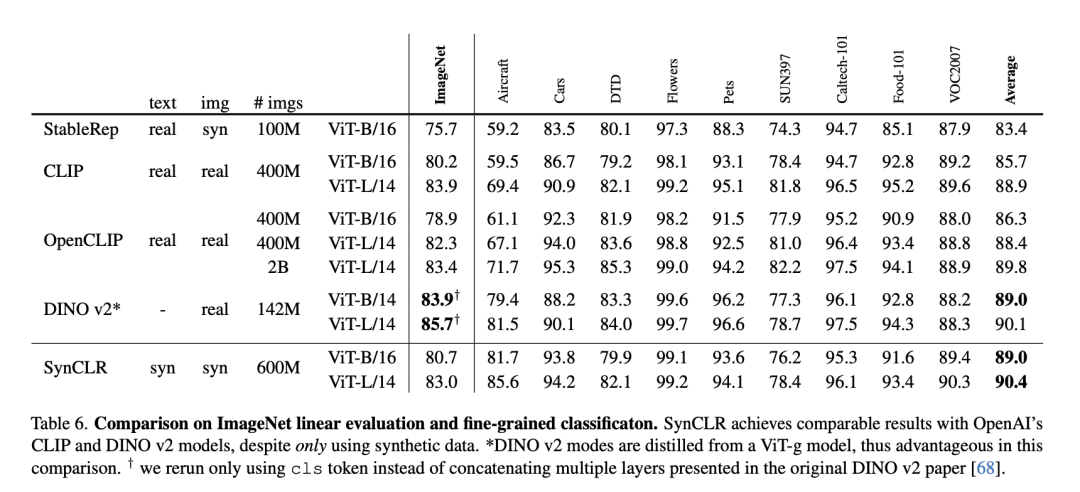

下表是ImageNet線性評估與細粒度分類的比較。

儘管只使用了合成數據,但SynCLR與OpenAI的CLIP和DINO v2模型取得了不相上下的結果。

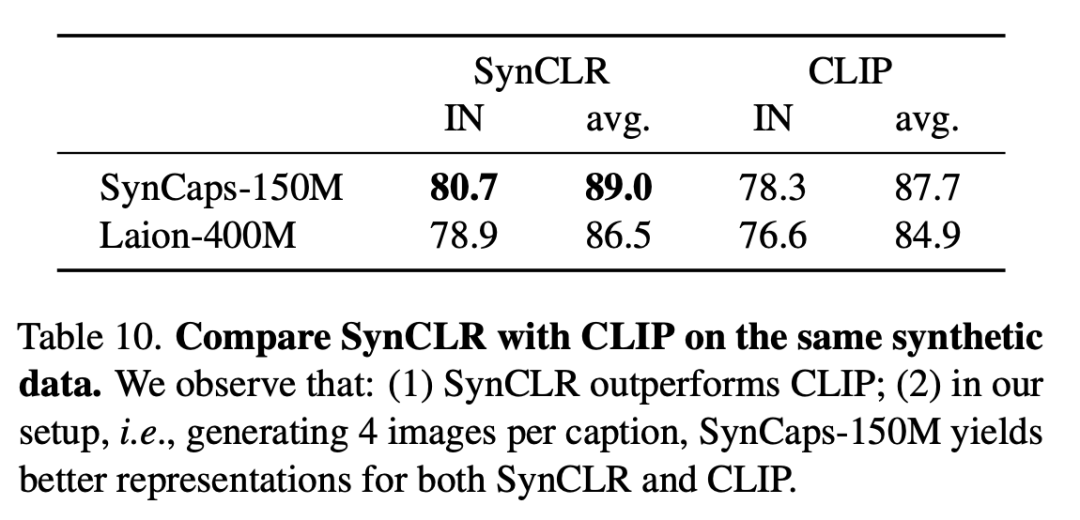

下表是在相同的合成資料上比較SynCLR和CLIP,可以看出,SynCLR明顯優於CLIP。

具體設定為,每個標題產生4個圖像,SynCaps-150M為SynCLR和CLIP提供了更好的表示。

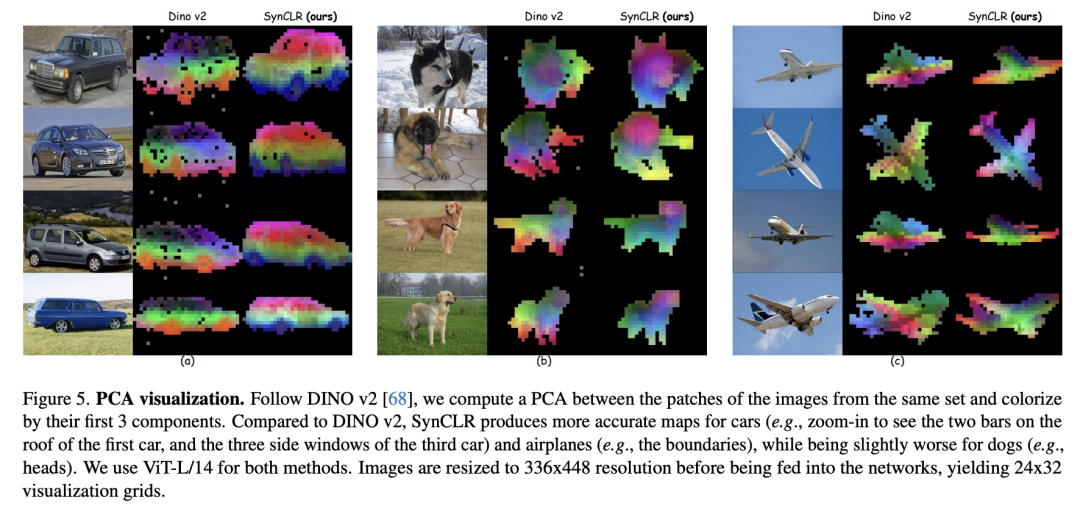

PCA視覺化如下。依照DINO v2,研究人員計算了同一組影像的斑塊之間的PCA,並根據其前3個分量進行著色。

與DINO v2相比,SynCLR對汽車和飛機的繪製的圖更為準確,而對能繪製的圖則稍差一些。

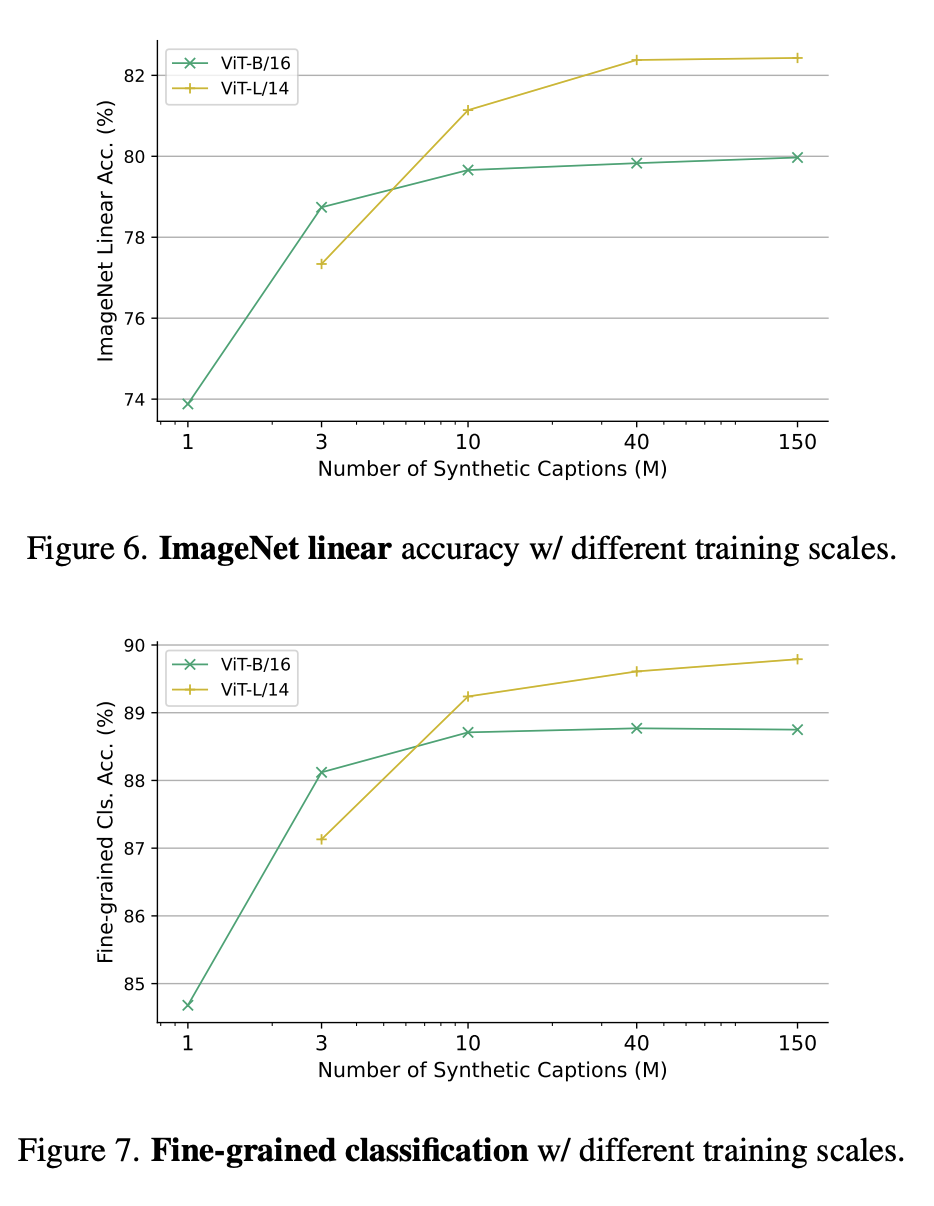

圖6和圖7中,分別展示了不同訓練規模下的ImageNet線性準確率,以及不同訓練參數規模下的精細分類。

為什麼要從生成模型學習?

一個令人信服的原因是,生成模型可以像數百個資料集一樣同時運作,能夠為策劃訓練資料提供了一種方便有效的方法。

總而言之,最新論文研究了視覺表徵學習的新典範-從生成模型中學習。

在沒有使用任何實際數據的情況下,SynCLR學習到的視覺表徵,與最先進的通用視覺表徵學習器學習到的視覺表徵不相上下。

以上是谷歌MIT最新研究顯示:取得高品質數據並非難事,大型模式是解決之道的詳細內容。更多資訊請關注PHP中文網其他相關文章!