Meta 推出音訊轉影像 AI 框架,用於產生人物對話場景的配音

- PHPz轉載

- 2024-01-13 11:39:061046瀏覽

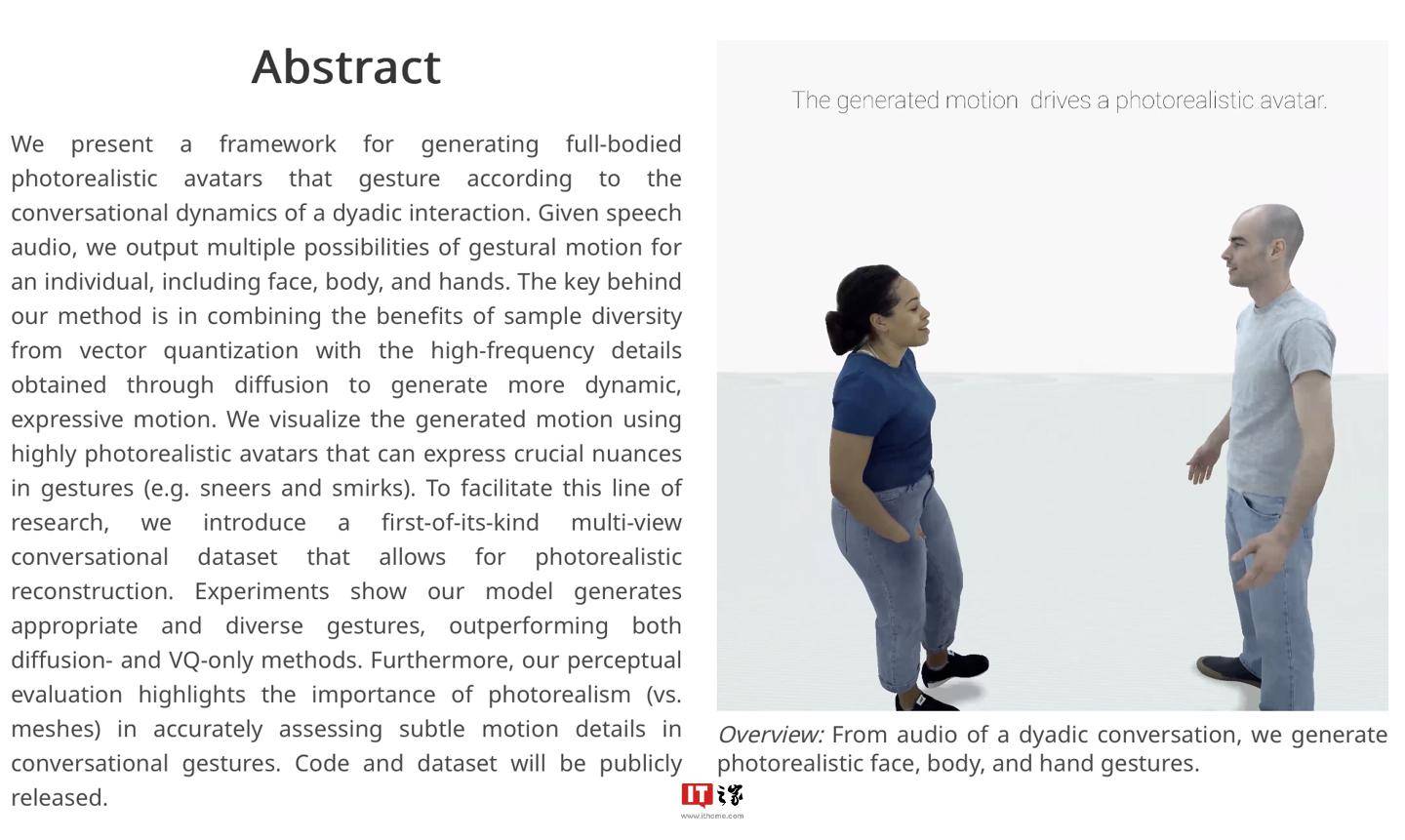

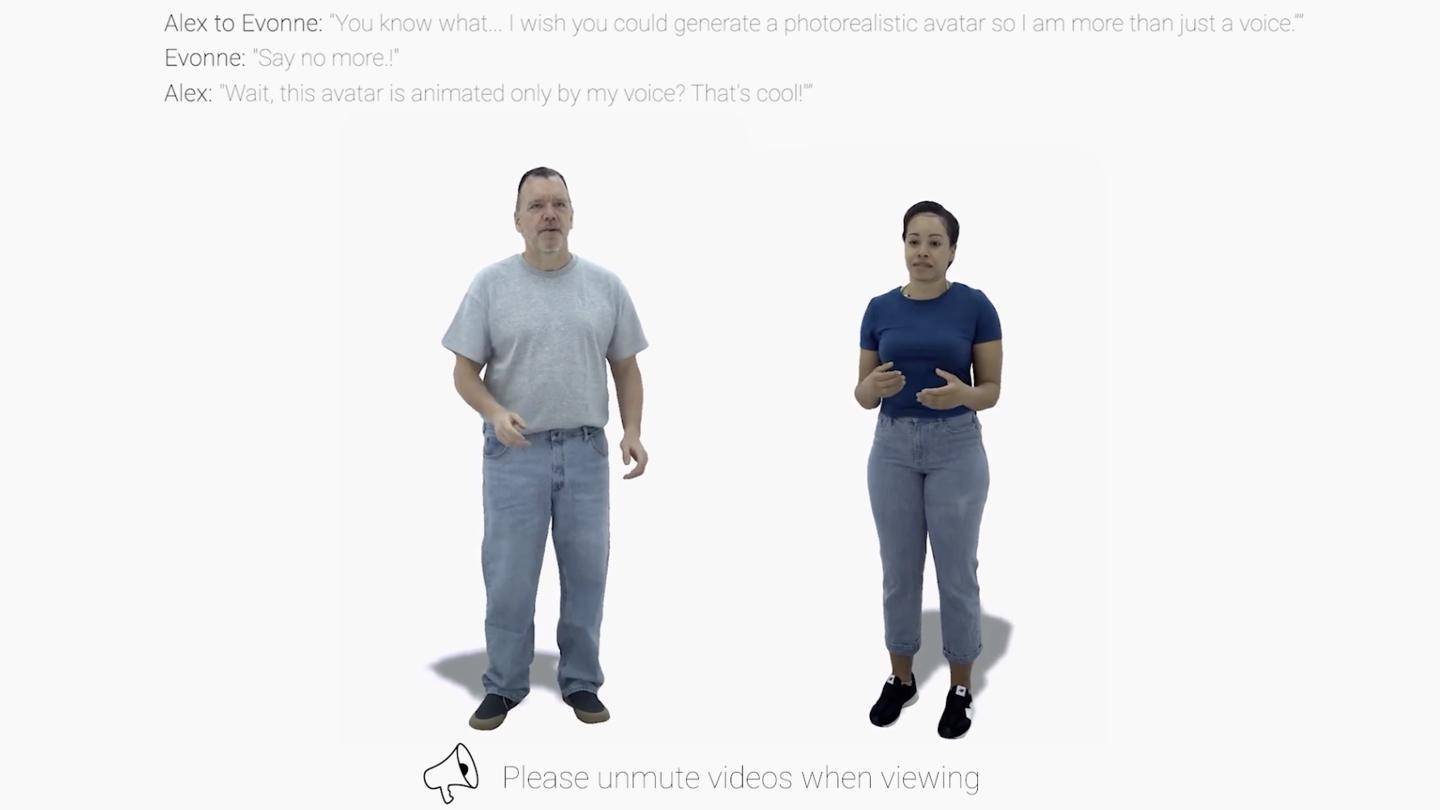

IT之家1 月9 日消息,Meta 日前公佈了一項名為audio2photoreal 的AI 框架,該框架能夠生成一系列逼真的NPC 人物模型,並藉助現有配音文件自動為人物模型「對口型”“擺動作”。

▲ 圖源 Meta 研究報告(下同)

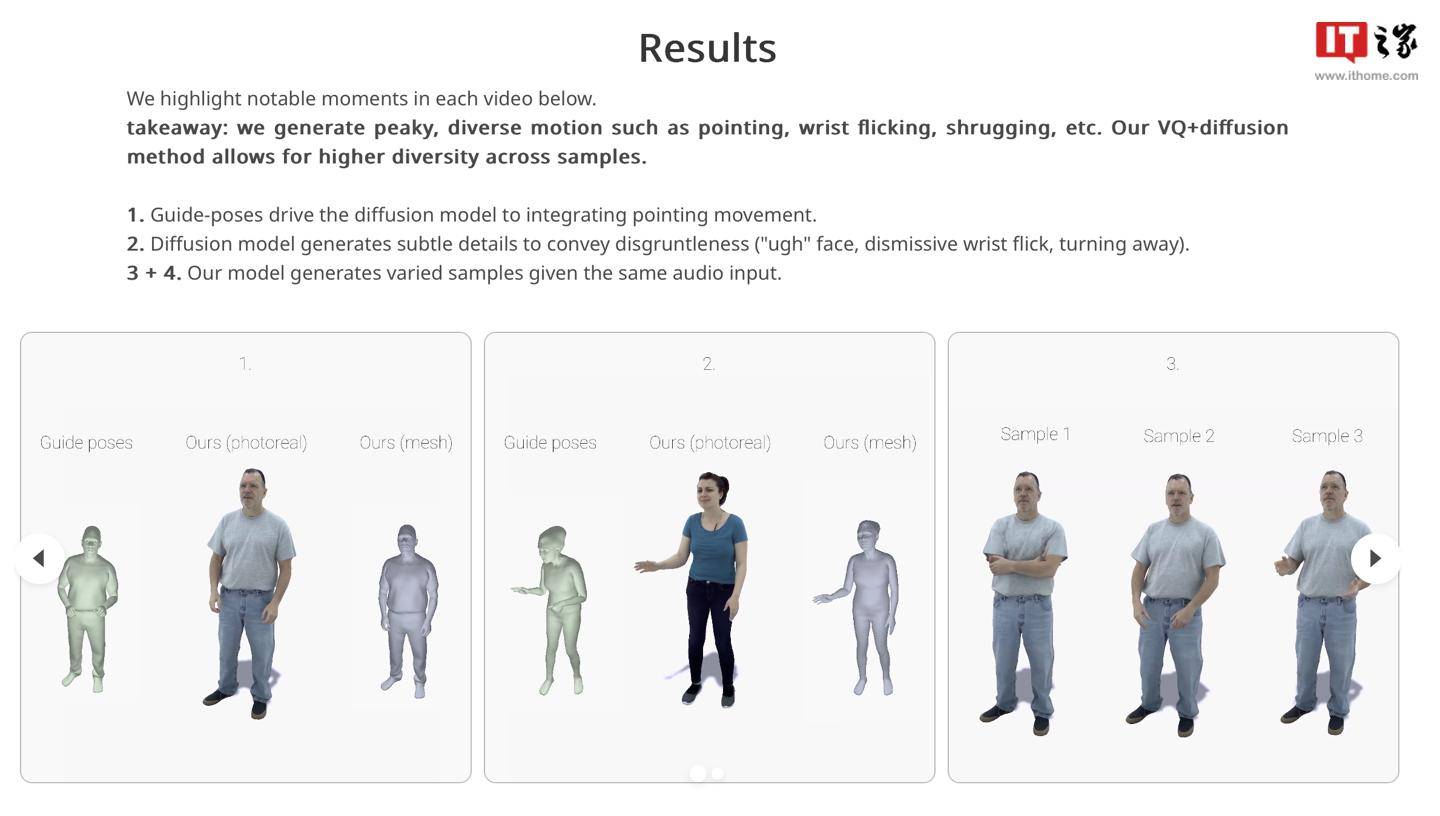

IT之家從官方研究報告中得知,Audio2photoreal 框架在接收到配音文件後,首先生成一系列NPC 模型,之後利用量化技術及擴散算法生成模型用動作,其中量化技術為框架提供動作樣本參考、擴散演算法用於改善框架產生的人物動作效果。

研究人員提到,該框架可以產生30 FPS 的“高質量動作樣本”,還能模擬人類在對話中“手指點物”、“轉手腕”或“聳肩”等不由自主的“習慣性動作」。

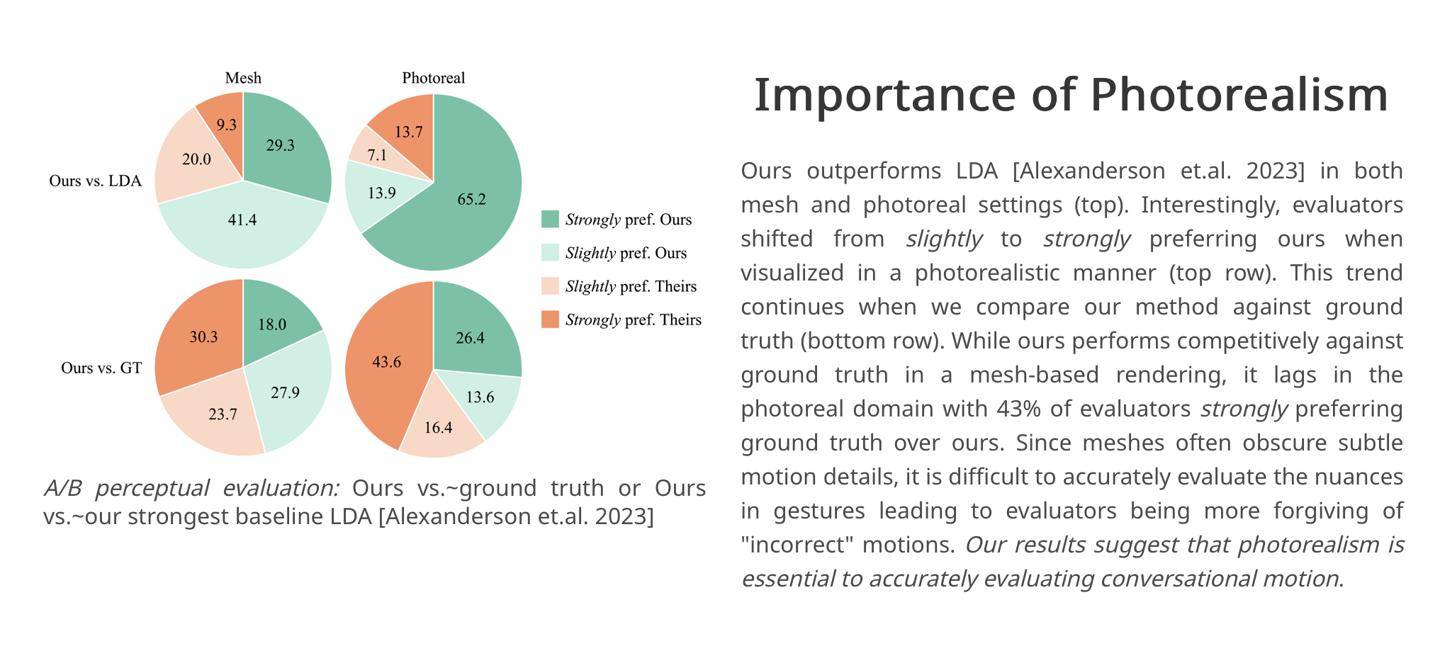

研究人員引用自家實驗結果,在對照實驗中有43% 的評估者對框架生成的人物對話場景感到“強烈滿意”,因此研究人員認為Audio2photoreal 框架相對於業界競品能夠生成“更具動態和表現力」的動作。

據悉,研究團隊目前已經在 GitHub 公開了相關程式碼和資料集,有興趣的小夥伴可以點此存取。

以上是Meta 推出音訊轉影像 AI 框架,用於產生人物對話場景的配音的詳細內容。更多資訊請關注PHP中文網其他相關文章!

陳述:

本文轉載於:sohu.com。如有侵權,請聯絡admin@php.cn刪除