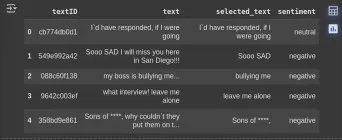

多模態大模型整合了偵測分割模組後,摳圖變得更簡單了!

我們的模型可以透過自然語言描述來快速標註要尋找的物體,並提供文字解釋,讓您輕鬆完成任務。

新加坡國立大學NExT 實驗室與清華劉知遠團隊合作開發的全新多模態大模型,為我們提供了強大的支援。這個模型的背後是經過精心打造的,它能夠在解謎過程中為玩家們提供全面的幫助和指導。它結合了多種模態的訊息,為玩家們呈現出全新的解謎方法和策略。這個模型的應用將為玩家們

隨著GPT-4v的推出,多模態領域迎來了一系列新模型,如LLaVA、BLIP-2等等。這些模型的出現在提升了多模態任務的表現和效果方面做出了巨大貢獻。

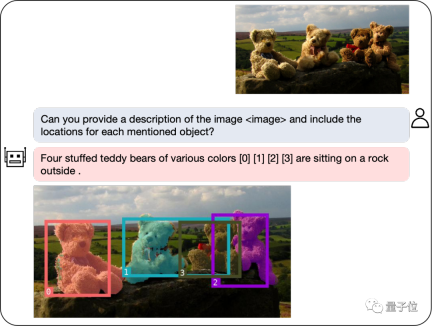

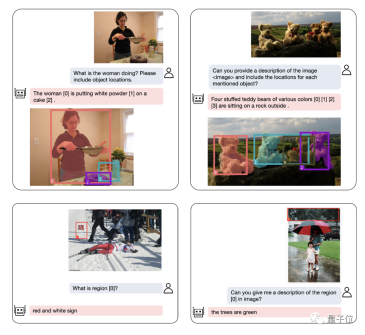

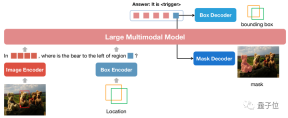

為了進一步提升多模態大模型的區域理解能力,研究團隊發展了一個名為NExT-Chat的多模態模型。此模型具備同時進行對話與檢測、分割的能力。

NExT-Chat的最大亮點是其多模態模型中引入了位置輸入和輸出的能力。這項特點使得NExT-Chat在互動中能夠更準確地理解和回應使用者的需求。透過位置輸入,NExT-Chat可以根據使用者所在的地理位置提供相關的資訊和建議,從而提升使用者體驗。而透過位置輸出,NExT-Chat可以將特定地理位置的相關資訊傳達給用戶,幫助他們更好

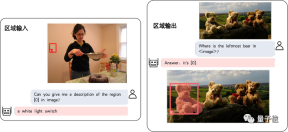

其中,位置輸入能力是指根據指定的區域回答問題,而位置輸出能力則是指定位元對話中提及的物體。這兩種能力在解謎遊戲中非常重要。

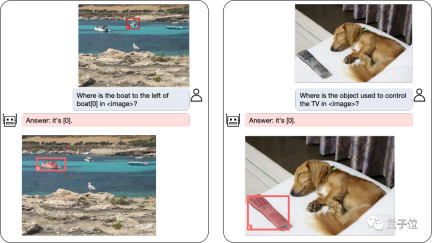

即使是複雜的定位問題,也能迎刃而解:

除了物體定位,NExT-Chat還可以將圖片或其中的某個部分進行描述:

分析完影像的內容之後,NExT-Chat可以利用得到的資訊進行推理:

為了準確評估NExT-Chat的表現,研究團隊在多個任務資料集上進行了測試。

在多個資料集上取得SOTA

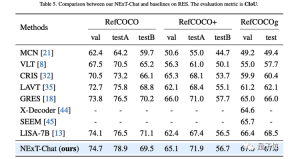

作者首先展示了NExT-Chat在指代表達式分割(RES)任務上的實驗結果。

雖然僅用了極少量的分割數據,NExT-Chat卻展現出了良好的指代分割能力,甚至打敗了一系列有監督模型(如MCN,VLT等)和用了5倍以上分割掩模標註的LISA方法。

△RES任務上NExT-Chat結果

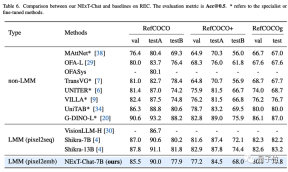

#接著,研究團隊展示了NExT-Chat在REC任務上的實驗結果。

如下表所示,相較於相當一系列的有監督方法(如UNITER),NExT-Chat都可以取得更優的效果。

一個有趣的發現是NExT-Chat比使用了類似框訓練資料的Shikra效果要稍差一些。

作者猜測,這是由於pix2emb方法中LM loss和detection loss更難以平衡,以及Shikra更貼近現有的純文本大模型的預訓練形式導致的。

△REC任務上NExT-Chat結果

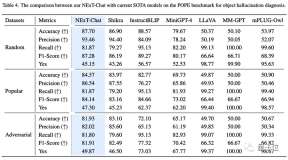

在影像幻覺任務上,如表3所示,NExT-Chat可以在Random和Popular數據集上取得最優的準確率。

△POPE資料集上NExT-Chat結果

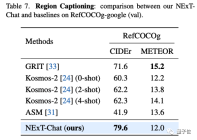

在區域描述任務上,NExT-Chat也能取得最優的CIDEr表現,且在該指標打敗了4-shot情況下的Kosmos- 2。

△RefCOCOg資料集上NExT-Chat結果

那麼,NExT-Chat背後都採用了哪些方法呢?

提出影像編碼新方式

傳統方法的缺陷

傳統的模型主要透過pix2seq的方式進行LLM相關的位置建模。

例如Kosmos-2將圖像劃分成32x32的區塊,用每個區塊的id來代表點的座標;Shikra將物體框的座標轉化為純文字的形式從而使得LLM可以理解座標。

但使用pix2seq方法的模型輸出主要限制在框和點這樣的簡單格式,而很難泛化到其他更密集的位置表示格式,例如segmentation mask。

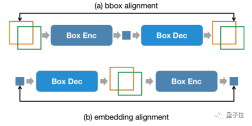

為了解決這個問題,本文提出了一種全新的基於embedding的位置建模方式pix2emb。

pix2emb方法

不同於pix2seq,pix2emb所有的位置資訊都透過對應的encoder和decoder進行編碼和解碼,而不是藉助LLM本身的文字預測頭。

△pix2emb方法簡單範例

#如上圖所示,位置輸入被對應的encoder編碼為位置embedding,而輸出的位置embedding則透過Box Decoder和Mask Decoder轉換為框架和遮罩。

這樣做帶來了兩個好處:

- 模型的輸出格式可以非常方便的擴展到更多複雜形式,例如segmentation mask。

- 模型可以非常容易的定位任務中已有的實踐方式,例如本文的detection loss採用L1 Loss和GIoU Loss (pix2seq則只能使用文本生成loss),本文的mask decoder借助了已有的SAM來做初始化。

透過將pix2seq與pix2emb結合,作者訓練了全新的NExT-Chat模型。

NExT-Chat模型

△NExT-Chat模型架構

NExT-Chat整體採用了LLaVA架構,即透過Image Encoder來編碼圖像資訊並輸入LLM進行理解,並在此基礎上添加了對應的Box Encoder和兩種位置輸出的Decoder。

為了解決LLM不知道何時該使用語言的LM head還是位置解碼器的問題,NExT-Chat額外引入一個全新的token類型來標識位置資訊。

如果模型輸出了,則該token的embedding會被送入對應的位置解碼器進行解碼而不是語言解碼器。

此外,為了維持輸入階段和輸出階段位置資訊的一致性,NExT-Chat額外引入了一個對齊約束:

- 第一階段:訓練模型

- 基本的框輸入輸出基本能力。 NExT-Chat採用Flickr-30K,RefCOCO,VisualGenome等包含框輸入輸出的資料集進行預訓練。訓練過程中,LLM參數會被全部訓練。 第二階段:

- 調整LLM的指令遵循能力。透過一些Shikra-RD,LLaVA-instruct之類的指令微調資料使得模型可以更好的回應人類的要求,輸出更人性化的結果。 第三階段:

- 賦予NExT-Chat模型分割能力。透過以上兩階段訓練,模型已經有很好的位置建模能力了。作者進一步將此能力擴展到mask輸出。實驗發現,透過使用極少量的mask標註資料和訓練時間(大約3小時),NExT-Chat可以快速的擁有良好的分割能力。

NExT-Chat透過在充沛的檢測框資料訓練基本的位置建模能力,之後可以快速的擴展到難度更大且標註更稀缺的分割任務上。

以上是大規模模型已經可以為圖像做標註,只需簡單對話!清華&NUS的研究成果的詳細內容。更多資訊請關注PHP中文網其他相關文章!

Markitdown MCP可以將任何文檔轉換為Markdowns!Apr 27, 2025 am 09:47 AM

Markitdown MCP可以將任何文檔轉換為Markdowns!Apr 27, 2025 am 09:47 AM處理文檔不再只是在您的AI項目中打開文件,而是將混亂變成清晰度。諸如PDF,PowerPoints和Word之類的文檔以各種形狀和大小淹沒了我們的工作流程。檢索結構化

如何使用Google ADK進行建築代理? - 分析VidhyaApr 27, 2025 am 09:42 AM

如何使用Google ADK進行建築代理? - 分析VidhyaApr 27, 2025 am 09:42 AM利用Google的代理開發套件(ADK)的力量創建具有現實世界功能的智能代理!該教程通過使用ADK來構建對話代理,並支持Gemini和GPT等各種語言模型。 w

在LLM上使用SLM進行有效解決問題-Analytics VidhyaApr 27, 2025 am 09:27 AM

在LLM上使用SLM進行有效解決問題-Analytics VidhyaApr 27, 2025 am 09:27 AM摘要: 小型語言模型 (SLM) 專為效率而設計。在資源匱乏、實時性和隱私敏感的環境中,它們比大型語言模型 (LLM) 更勝一籌。 最適合專注型任務,尤其是在領域特異性、控制性和可解釋性比通用知識或創造力更重要的情況下。 SLM 並非 LLMs 的替代品,但在精度、速度和成本效益至關重要時,它們是理想之選。 技術幫助我們用更少的資源取得更多成就。它一直是推動者,而非驅動者。從蒸汽機時代到互聯網泡沫時期,技術的威力在於它幫助我們解決問題的程度。人工智能 (AI) 以及最近的生成式 AI 也不例

如何將Google Gemini模型用於計算機視覺任務? - 分析VidhyaApr 27, 2025 am 09:26 AM

如何將Google Gemini模型用於計算機視覺任務? - 分析VidhyaApr 27, 2025 am 09:26 AM利用Google雙子座的力量用於計算機視覺:綜合指南 領先的AI聊天機器人Google Gemini擴展了其功能,超越了對話,以涵蓋強大的計算機視覺功能。 本指南詳細說明瞭如何利用

Gemini 2.0 Flash vs O4-Mini:Google可以比OpenAI更好嗎?Apr 27, 2025 am 09:20 AM

Gemini 2.0 Flash vs O4-Mini:Google可以比OpenAI更好嗎?Apr 27, 2025 am 09:20 AM2025年的AI景觀正在充滿活力,而Google的Gemini 2.0 Flash和Openai的O4-Mini的到來。 這些尖端的車型分開了幾週,具有可比的高級功能和令人印象深刻的基準分數。這個深入的比較

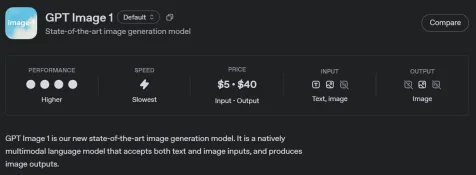

如何使用OpenAI GPT-Image-1 API生成和編輯圖像Apr 27, 2025 am 09:16 AM

如何使用OpenAI GPT-Image-1 API生成和編輯圖像Apr 27, 2025 am 09:16 AMOpenai的最新多模式模型GPT-Image-1徹底改變了Chatgpt和API的形像生成。 本文探討了其功能,用法和應用程序。 目錄 了解gpt-image-1 gpt-image-1的關鍵功能

如何使用清潔行執行數據預處理? - 分析VidhyaApr 27, 2025 am 09:15 AM

如何使用清潔行執行數據預處理? - 分析VidhyaApr 27, 2025 am 09:15 AM數據預處理對於成功的機器學習至關重要,但是實際數據集通常包含錯誤。清潔行提供了一種有效的解決方案,它使用其Python軟件包來實施自信的學習算法。 它自動檢測和

AI技能差距正在減慢供應鏈Apr 26, 2025 am 11:13 AM

AI技能差距正在減慢供應鏈Apr 26, 2025 am 11:13 AM經常使用“ AI-Ready勞動力”一詞,但是在供應鏈行業中確實意味著什麼? 供應鏈管理協會(ASCM)首席執行官安倍·埃什肯納齊(Abe Eshkenazi)表示,它表示能夠評論家的專業人員

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

Dreamweaver Mac版

視覺化網頁開發工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

WebStorm Mac版

好用的JavaScript開發工具