Q-Learning是強化學習中至關重要的無模型演算法,專注於學習特定狀態下動作的價值或「Q 值」。這種方法在具有不可預測性的環境中表現出色,因為它不需要周圍環境的預定義模型。它有效地適應隨機轉換和各種獎勵,使其適用於結果不確定的場景。這種靈活性使 Q-Learning 成為需要自適應決策的強大工具,而無需事先了解環境動態。

使用Dyna-Q 擴充Q-Learning 以增強決策能力

探索Dyna-Q,這是一種先進的強化學習演算法,透過將真實體驗與模擬規劃相結合來擴展Q-Learning。

Q-Learning 是強化學習中一種至關重要的無模型演算法,專注於學習特定狀態下動作的價值或「Q 值」。這種方法在具有不可預測性的環境中表現出色,因為它不需要周圍環境的預定義模型。它有效地適應隨機轉換和各種獎勵,使其適用於結果不確定的場景。這種靈活性使 Q-Learning 成為需要自適應決策的強大工具,而無需事先了解環境動態。

學習過程

Q-learning 的工作原理是更新每個狀態下每個動作的 Q 值表。它使用貝爾曼方程,根據觀察到的獎勵及其對未來獎勵的估計,迭代更新這些值。策略 - 選擇行動的策略 - 是從這些Q值中得出的。

- Q值- 表示在給定狀態下採取特定動作可以獲得的預期未來獎勵

- 更新規則- Q 值更新如下:

- ##Q (狀態,動作) ← Q (狀態,動作) α (獎勵 最大γ Q (下一個狀態,a) − Q (狀態, 動作))

- 學習率α表示新資訊的重要性,折扣係數γ表示未來獎勵的重要性。

def train_Q(self,s_prime,r): self.QTable[self.s,self.action] = (1-self.alpha)*self.QTable[self.s, self.action] + \ self.alpha * (r + self.gamma * (self.QTable[s_prime, np.argmax(self.QTable[s_prime])])) self.experiences.append((self.s, self.action, s_prime, r)) self.num_experiences = self.num_experiences + 1 self.s = s_prime self.action = action return action勘探與開發Q-learning的一個關鍵方面是平衡探索(嘗試新的行動來發現他們的獎勵)和利用(使用已知資訊來最大化獎勵)。演算法通常使用ε貪婪等策略來維持這種平衡。

if rand.random() >= self.random_action_rate: action = np.argmax(self.QTable[s_prime,:]) #Exploit: Select Action that leads to a State with the Best Reward else: action = rand.randint(0,self.num_actions - 1) #Explore: Randomly select an Action. # Use a decay rate to reduce the randomness (Exploration) as the Q-Table gets more evidence self.random_action_rate = self.random_action_rate * self.random_action_decay_rateDyna-Q簡介Dyna-Q 是傳統 Q-Learning 演算法的創新擴展,處於將真實體驗與模擬規劃相結合的最前沿。這種方法透過整合實際互動和模擬體驗,顯著增強了學習過程,使智能體能夠在複雜的環境中快速適應並做出明智的決策。透過利用從環境回饋中直接學習和透過模擬獲得的見解,Dyna-Q提供了一種全面而有效的策略,以應對真實世界資料稀缺或獲取成本高昂的挑戰。

Dyna-Q的组件

- Q-Learning:从真实经验中学习

- 模型学习:学习环境模型

- 规划:使用模型生成模拟体验

模型学习

- 该模型跟踪转换和奖励。对于每个状态-动作对 (s, a),模型存储下一个状态 s′ 和奖励 r。

- 当智能体观察到转换 (s, a,r,s′) 时,它会更新模型。

使用模拟体验进行规划

- 在每个步骤中,代理从真实体验更新其 Q 值后,还会根据模拟体验更新 Q 值。

- 这些体验是使用学习模型生成的:对于选定的状态-动作对(s,a),它预测下一个状态和奖励,并且Q值被更新,就好像已经经历了这种转变一样。

算法 Dyna-Q

- 初始化所有状态-动作对的 Q 值 Q(s, a) 和模型 (s, a)。

- 循环(每集):

- 初始化状态 s。

- 循环(针对剧集的每个步骤):

- 使用派生自 Q 从状态 s 中选择操作 a(例如,ε-greedy )

- 采取行动 a,观察奖励 r,然后下一个状态 s′

- 直接学习:使用观察到的跃迁(s、a、r、s′)更新 Q 值

- 模型学习:使用转换(s、a、r、s′)更新模型

- 计划:重复 n 次:

- 随机选择以前经历过的状态-动作对 (s, a)。

- 使用模型生成预测的下一个状态 s′ 并奖励 r

- 使用模拟跃迁 (s, a,r,s′) 更新 Q 值

- s← s′。

- 结束循环 此功能将 Dyna-Q 计划阶段合并到前面提到的 Q-Learner 中,从而能够指定在每一集中运行的所需模拟量,其中操作是随机选择的。此功能增强了 Q-Learn 的整体功能和多功能性。

def train_DynaQ(self,s_prime,r): self.QTable[self.s,self.action] = (1-self.alpha)*self.QTable[self.s, self.action] + \ self.alpha * (r + self.gamma * (self.QTable[s_prime, np.argmax(self.QTable[s_prime])])) self.experiences.append((self.s, self.action, s_prime, r)) self.num_experiences = self.num_experiences + 1 # Dyna-Q Planning - Start if self.dyna_planning_steps > 0: # Number of simulations to perform idx_array = np.random.randint(0, self.num_experiences, self.dyna) for exp in range(0, self.dyna): # Pick random experiences and update QTable idx = idx_array[exp] self.QTable[self.experiences[idx][0],self.experiences[idx][1]] = (1-self.alpha)*self.QTable[self.experiences[idx][0], self.experiences[idx][1]] + \ self.alpha * (self.experiences[idx][3] + self.gamma * (self.QTable[self.experiences[idx][2], np.argmax(self.QTable[self.experiences[idx][2],:])])) # Dyna-Q Planning - End if rand.random() >= self.random_action_rate: action = np.argmax(self.QTable[s_prime,:]) #Exploit: Select Action that leads to a State with the Best Reward else: action = rand.randint(0,self.num_actions - 1) #Explore: Randomly select an Action. # Use a decay rate to reduce the randomness (Exploration) as the Q-Table gets more evidence self.random_action_rate = self.random_action_rate * self.random_action_decay_rate self.s = s_prime self.action = action return action

结论

Dyna Q 代表了一种进步,我们追求设计能够在复杂和不确定的环境中学习和适应的代理。通过理解和实施 Dyna Q,人工智能和机器学习领域的专家和爱好者可以为各种实际问题设计出有弹性的解决方案。本教程的目的不是介绍概念和算法,而是在这个引人入胜的研究领域激发创造性应用和未来进展的创造力。

以上是使用Dyna-Q擴展Q-Learning以增強決策能力的詳細內容。更多資訊請關注PHP中文網其他相關文章!

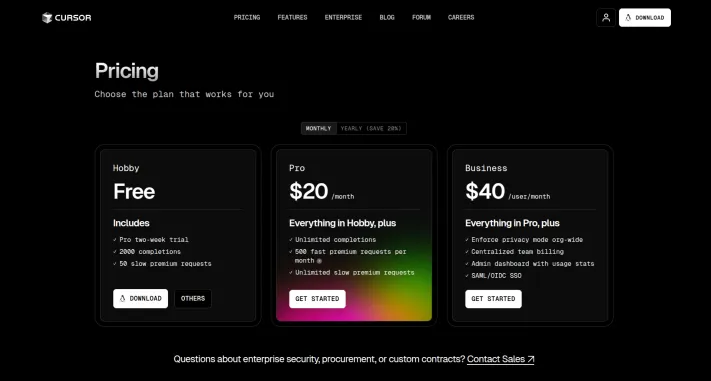

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!Mar 20, 2025 pm 03:34 PM

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!Mar 20, 2025 pm 03:34 PMVibe編碼通過讓我們使用自然語言而不是無盡的代碼行創建應用程序來重塑軟件開發的世界。受Andrej Karpathy等有遠見的人的啟發,這種創新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!Mar 22, 2025 am 10:58 AM2025年2月,Generative AI又是一個改變遊戲規則的月份,為我們帶來了一些最令人期待的模型升級和開創性的新功能。從Xai的Grok 3和Anthropic的Claude 3.7十四行詩到Openai的G

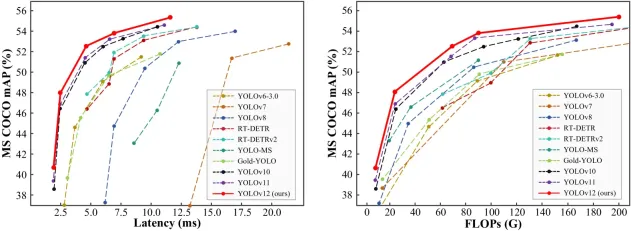

如何使用Yolo V12進行對象檢測?Mar 22, 2025 am 11:07 AM

如何使用Yolo V12進行對象檢測?Mar 22, 2025 am 11:07 AMYolo(您只看一次)一直是領先的實時對象檢測框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了進步,可顯著提高準確性

Sora vs veo 2:哪個創建更現實的視頻?Mar 10, 2025 pm 12:22 PM

Sora vs veo 2:哪個創建更現實的視頻?Mar 10, 2025 pm 12:22 PMGoogle的VEO 2和Openai的Sora:哪個AI視頻發電機佔據了至尊? 這兩個平台都產生了令人印象深刻的AI視頻,但它們的優勢在於不同的領域。 使用各種提示,這種比較揭示了哪種工具最適合您的需求。 t

Google的Gencast:Gencast Mini Demo的天氣預報Mar 16, 2025 pm 01:46 PM

Google的Gencast:Gencast Mini Demo的天氣預報Mar 16, 2025 pm 01:46 PMGoogle DeepMind的Gencast:天氣預報的革命性AI 天氣預報經歷了巨大的轉變,從基本觀察到復雜的AI驅動預測。 Google DeepMind的Gencast,開創性

Chatgpt 4 o可用嗎?Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用嗎?Mar 28, 2025 pm 05:29 PMChatgpt 4當前可用並廣泛使用,與諸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和產生連貫的響應方面取得了重大改進。未來的發展可能包括更多個性化的間

哪個AI比Chatgpt更好?Mar 18, 2025 pm 06:05 PM

哪個AI比Chatgpt更好?Mar 18, 2025 pm 06:05 PM本文討論了AI模型超過Chatgpt,例如Lamda,Llama和Grok,突出了它們在準確性,理解和行業影響方面的優勢。(159個字符)

O1 vs GPT-4O:OpenAI的新型號比GPT-4O好嗎?Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O:OpenAI的新型號比GPT-4O好嗎?Mar 16, 2025 am 11:47 AMOpenai的O1:為期12天的禮物狂歡始於他們迄今為止最強大的模型 12月的到來帶來了全球放緩,世界某些地區的雪花放緩,但Openai才剛剛開始。 山姆·奧特曼(Sam Altman)和他的團隊正在推出12天的禮物前

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

Dreamweaver Mac版

視覺化網頁開發工具