2023 年即將過去。一年以來,各式各樣的大模型爭相發布。當 OpenAI 和Google等科技巨頭正在競爭時,另一方「勢力」悄悄崛起 —— 開源。

開源模型受到的質疑一向不少。它們是否能像專有模型一樣優秀?是否能夠媲美專有模型的性能?到目前為止,我們一直只能說是某些方面接近。即便如此,開源模型總是會為我們帶來經驗的表現,讓我們刮目相看。

開源模型的興起正在改變遊戲規則。如 Meta 的 LLaMA 系列以其快速迭代、可自訂性和隱私性正受到追捧。這些模型被社群迅速發展,為專有模型帶來了強大的挑戰,能夠改變大型科技公司的競爭格局。

不過先前人們的想法大多只是來自於「感覺」。今天早上,Meta 首席AI 科學家、圖靈獎得主Yann LeCun 突然發出了這樣的感嘆:「開源人工智慧模型正走在超越專有模型的路上。」

這個由方舟投資(ARK Invest)團隊製作的趨勢圖被認為可能預測了2024年的人工智慧發展。它展示了開源社群與專有模式在生成式人工智慧方面的發展

#隨著OpenAI和Google等公司變得越來越封閉,他們公開最新模型資訊的頻率越來越少。因此,開源社群及其企業支持者Meta開始步入其後,使得生成式AI更加民主化,這或許會對專有模式的商業模式構成挑戰

在這個散佈圖中顯示了各種AI 模型的性能百分比。專有模型以藍色表示,開源模型以黑色表示。我們可以看到不同的 AI 模型如 GPT-3、Chinchilla 70B(Google)、PaLM(Google)、GPT-4(OpenAI)和 Llama65B(Meta)等在不同時間點的表現。

Meta 最初發布 LLaMA 時,參數量從 70 億到 650 億不等。這些模型的性能非常優異:具有130 億參數的Llama 模型「在大多數基準上」可以勝過GPT-3(參數量達1750 億),而且可以在單塊V100 GPU 上運行;而最大的650 億參數的Llama 模型可以媲美Google的Chinchilla-70B 和PaLM-540B。

Falcon-40B 剛發布就衝上了 Huggingface 的 OpenLLM 排行榜首位,改變了 Llama 一枝獨秀的場面。

Llama 2 開源,再一次使大模型格局發生巨變。相較於 Llama 1,Llama 2 的訓練資料多了 40%,上下文長度也翻倍,並採用了分組查詢注意力機制。

最近,開源大模型宇宙又有了新的重量級成員 ——Yi 模型。它能一次處理 40 萬漢字、中英均霸榜。 Yi-34B 也成為迄今為止唯一成功登頂 Hugging Face 開源模型排行榜的國產模型。

根據散佈圖所示,開源模型的效能不斷追趕專有模型。這意味著在不久的將來,開源模型有望與專有模型在性能上並駕齊驅,甚至超越

Mistral 8x7B在上週末以最樸素的發布方式和強大的性能引起了研究者的高度評價,他們表示「閉源大模型走到結局了。」

#已經有網友開始預祝「2024年成為開源人工智慧年」,認為「我們正在接近一個臨界點。考慮到當前開源社群專案的發展速度,我們預計未來12個月內將達到GPT-4的水平。」

##接下來,我們將拭目以待開源模型的未來是否一帆風順,以及它將展現出怎樣的表現

以上是開源大模型必須超越閉源——LeCun揭示2024年AI趨勢圖的詳細內容。更多資訊請關注PHP中文網其他相關文章!

DeepSeek V3 vs Llama 4:哪種模型統治至高無上? - 分析VidhyaApr 25, 2025 am 10:27 AM

DeepSeek V3 vs Llama 4:哪種模型統治至高無上? - 分析VidhyaApr 25, 2025 am 10:27 AM在不斷發展的大語言模型的景觀中,DeepSeek V3 vs Llama 4已成為開發人員,研究人員和AI愛好者的最熱門對決之一。無論您是針對燃燒速度的輸液而優化

什麼是開源和開放重量模型?Apr 25, 2025 am 10:19 AM

什麼是開源和開放重量模型?Apr 25, 2025 am 10:19 AMDeepSeek模型和Google的Gemma 3強調了“開放” AI模型開發的增長趨勢,強調了出色的推理能力和輕量級設計。 Openai準備通過即將到來的Quo為這個生態系統做出貢獻

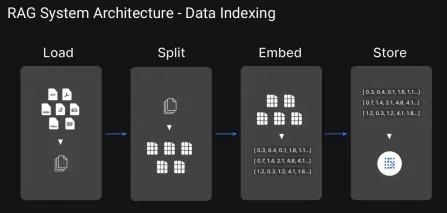

下一個項目的前13個高級抹布技術Apr 25, 2025 am 10:07 AM

下一個項目的前13個高級抹布技術Apr 25, 2025 am 10:07 AMAI可以大規模產生真正相關的答案嗎?我們如何確保它了解複雜的多轉交談?我們如何避免自信地吐出不正確的事實?這些是Mo的挑戰

Llama 4型號:Meta AI正在開放購買最好的! - 分析VidhyaApr 25, 2025 am 10:06 AM

Llama 4型號:Meta AI正在開放購買最好的! - 分析VidhyaApr 25, 2025 am 10:06 AMMeta的Llama 4:開源AI Powerhouses的三重奏 Meta AI通過同時發布了Llama 4 Banner下的三種開創性的大語言模型(LLM),從而破壞了AI景觀:Scout,Maverick和Beamemoth。 這一舉動與SH進行了對比

代理商OPS的十大工具Apr 25, 2025 am 10:05 AM

代理商OPS的十大工具Apr 25, 2025 am 10:05 AM當AI代理承擔更複雜的任務時,簡單地構建它們還不夠。管理他們的績效,可靠性和效率同樣至關重要。這就是代理商操作的來源。它可以幫助組織監視,優化,

7個免費的chatgpt替代品來創建吉卜力風格的圖像Apr 25, 2025 am 09:48 AM

7個免費的chatgpt替代品來創建吉卜力風格的圖像Apr 25, 2025 am 09:48 AM解鎖吉卜力風格的AI藝術的魔力:免費,簡單的方法! AI生成的藝術的最近激增模仿了吉卜力的吉卜力工作室的迷人風格,這吸引了互聯網。 雖然OpenAI的GPT-4O提供了令人印象深刻的功能,但需求量很高。

AI通過圖靈測試:GPT-4.5揭示了未來Apr 25, 2025 am 09:42 AM

AI通過圖靈測試:GPT-4.5揭示了未來Apr 25, 2025 am 09:42 AM這篇博客文章探討了2025年聖地亞哥UC研究的開創性結果,其中高級語言模型(LLMS)(如GPT-4.5)令人信服地通過了現代化的圖靈測試,通常在模仿人類對話的能力方面表現出色的真實人物

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

Atom編輯器mac版下載

最受歡迎的的開源編輯器

禪工作室 13.0.1

強大的PHP整合開發環境