隨著大模型技術的發展與落地,「模型治理」成為了目前受到重點關注的命題。只不過,在實務中,研究者往往感受到多重挑戰。

一方面,為了高其在目標任務的表現表現,研究者會收集並建構目標任務資料集並對大語言模型(LLM)進行微調,但這種方式通常會導致目標任務以外的一般任務的表現明顯下降,損害LLM 原本具備的通用能力。

另一方面,開源社群的模型逐漸增多,大模型開發者也可能在多次訓練中累積了越來越多的模型,每個模型都具有各自的優勢,如何選擇合適的模型執行任務或進一步微調反而成為一個問題。

近日,智源研究院資訊檢索與知識計算組發布 LM-Cocktail 模型治理策略,旨在為大模型開發者提供一個低成本持續提升模型效能的方式:透過少量範例計算融合權重,借助模型融合技術融合微調模型與原模型的優勢,實現「模型資源」的高效利用。

- #技術報告:https://arxiv.org/abs/2311.13534

- #程式碼:https://github.com/FlagOpen/FlagEmbedding/tree/master/LM_Cocktail

模型融合技術可以透過融合多個模型提高單模型的性能。受此啟發,LM-Cocktail 策略進一步透過對目標任務計算不同模型的重要性,賦予不同模型不同的權重,在此基礎上進行模型融合,在提升目標任務上性能的同時,保持在通用任務上的強大能力。

LM-Cocktail 策略的作用類似於製作雞尾酒,它可以將各個模型的優勢能力匯總起來,透過調配不同的模型,創造出一個擁有多種專長的「多才」模型

方法創新

具體而言,LM-Cocktail 可以透過手動選擇模型配比,或輸入少量樣例自動計算加權權重,來融合現有模型產生一個新模型,該過程不需要對模型進行重新訓練並且具備適配多種結構的模型,如大語言模型Llama,語義向量模型BGE 等。

如果開發者缺乏某些目標任務的標籤數據,或者缺少計算資源進行模型微調,那麼可以採用LM-Cocktail策略來省去模型微調的步驟。只要建構極少量的資料範例,就可以融合開源社群中已有的大型語言模型,以調製自己的「LM雞尾酒」

##如上圖所示,在特定目標任務上微調Llama,可以顯著提高目標任務上的準確度,但損害了在其他任務上的通用能力。採用 LM-Cocktail 可以解決這個問題。

LM-Cocktail 的核心是將微調後的模型與多個其他模型的參數進行融合,整合多個模型的優點,在提高目標任務上準確度的同時,保持在其他任務上的通用能力。具體形式為,給定目標任務、基礎模型,以及一個在該任務上微調基礎模型後所得到的模型,同時收集開源社群或以往訓練過的模型組成集合。透過目標任務上少量的範例計算每個模型的融合加權權重,對這些模型的參數進行加權求和,得到新的模型(具體的過程請參考論文或開源程式碼)。如果開源社群不存在其他模型,也可以直接整合基礎模型和微調模型,在不降低通用能力的基礎上提升下游任務表現。 使用者在實際應用場景中,由於資料和資源的限制,可能無法進行下游任務的微調,即沒有在目標任務微調過後的模型。在這種情況下,使用者可以透過建構非常少量的資料範例融合社群中已有的大語言模型,產生一個面向新任務的模型,提高目標任務的準確度,而無需對模型進行訓練。

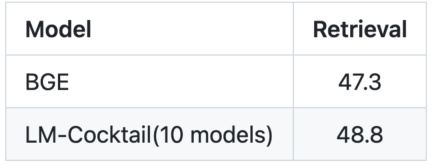

#########實驗結果###############1.彈性微調以維持通用能力#########

從上圖中可以看到,在某個目標任務上進行微調之後,微調後的模型大幅提高了在該任務上的準確度,但其他通用任務上的準確度都有下降。例如,在 AG News 到訓練集上進行微調,Llama 在 AG News 測試集上準確度從 40.80% 漲到 94.42%,但在其他任務上準確度從 46.80% 下降到了 38.58%。

然而,透過簡單的融合微調後模型和原始模型的參數,在目標任務上實現了具有競爭力的性能94.46%,與微調模型相當,同時在其他任務上準確度為47.73%, 甚至稍強於原模型的性能。在某些任務下,如Helleswag, 融合後的模型甚至可以在該微調任務上超過微調後的模型,並在其他任務上超過原始通用模型,即在繼承微調模型和原模型的優點的同時,超過了他們。可以看出,透過 LM-Cocktail 計算融合比例,進一步融合其他微調模型,可以在確保目標任務準確度的同時,進一步提昇在其他任務上的通用效能。

2. 混合已有模型處理新任務

重寫後來的內容:圖表展示了語言模型目標任務MMLU

#重寫後的內容:圖片:向量模型的目標任務是檢索(訊息檢索)

微調模型需要大量的數據,同時需要大量的運算資源,尤其是微調大語言模型,這些在實際情況中不一定可以實現。在無法對目標任務進行微調的情況下,LM- Cocktail 可以透過混合現有的模型(來自開源社群或自己歷史訓練累積)來實現新的能力。

透過只給定5 個樣例數據,LM-Cocktail 自動計算融合加權權重,從現有的模型進行篩選然後融合得到新的模型,而無需使用大量數據進行訓練。實驗發現,產生的新模型可以在新的任務上得到更高的準確度。例如,對於 Llama,透過 LM- Cocktail 整合現有 10 個模型(其訓練任務都與 MMLU 榜單無關),可以取得明顯的提升,並且要高於使用 5 個範例資料進行情境學習的 Llama 模型。

請嘗試使用LM-Cocktail,我們歡迎您透過GitHub issue提供回饋與建議:https://github.com/FlagOpen/FlagEmbedding/tree/master/LM_Cocktail

以上是智源等機構發布LM-Cocktail模型的多技能大模型治理策略的詳細內容。更多資訊請關注PHP中文網其他相關文章!

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM

从VAE到扩散模型:一文解读以文生图新范式Apr 08, 2023 pm 08:41 PM1 前言在发布DALL·E的15个月后,OpenAI在今年春天带了续作DALL·E 2,以其更加惊艳的效果和丰富的可玩性迅速占领了各大AI社区的头条。近年来,随着生成对抗网络(GAN)、变分自编码器(VAE)、扩散模型(Diffusion models)的出现,深度学习已向世人展现其强大的图像生成能力;加上GPT-3、BERT等NLP模型的成功,人类正逐步打破文本和图像的信息界限。在DALL·E 2中,只需输入简单的文本(prompt),它就可以生成多张1024*1024的高清图像。这些图像甚至

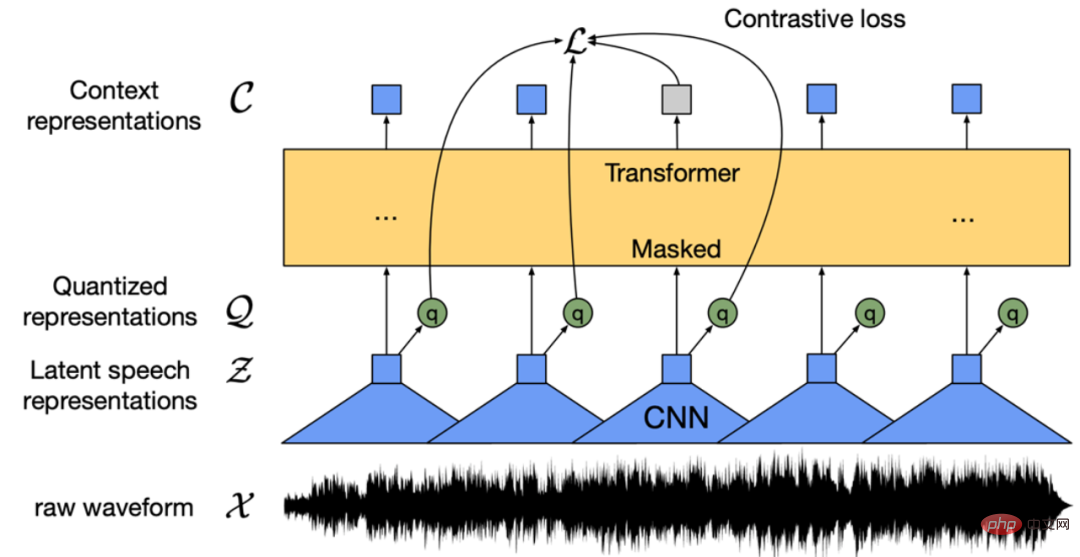

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PM

找不到中文语音预训练模型?中文版 Wav2vec 2.0和HuBERT来了Apr 08, 2023 pm 06:21 PMWav2vec 2.0 [1],HuBERT [2] 和 WavLM [3] 等语音预训练模型,通过在多达上万小时的无标注语音数据(如 Libri-light )上的自监督学习,显著提升了自动语音识别(Automatic Speech Recognition, ASR),语音合成(Text-to-speech, TTS)和语音转换(Voice Conversation,VC)等语音下游任务的性能。然而这些模型都没有公开的中文版本,不便于应用在中文语音研究场景。 WenetSpeech [4] 是

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM

普林斯顿陈丹琦:如何让「大模型」变小Apr 08, 2023 pm 04:01 PM“Making large models smaller”这是很多语言模型研究人员的学术追求,针对大模型昂贵的环境和训练成本,陈丹琦在智源大会青源学术年会上做了题为“Making large models smaller”的特邀报告。报告中重点提及了基于记忆增强的TRIME算法和基于粗细粒度联合剪枝和逐层蒸馏的CofiPruning算法。前者能够在不改变模型结构的基础上兼顾语言模型困惑度和检索速度方面的优势;而后者可以在保证下游任务准确度的同时实现更快的处理速度,具有更小的模型结构。陈丹琦 普

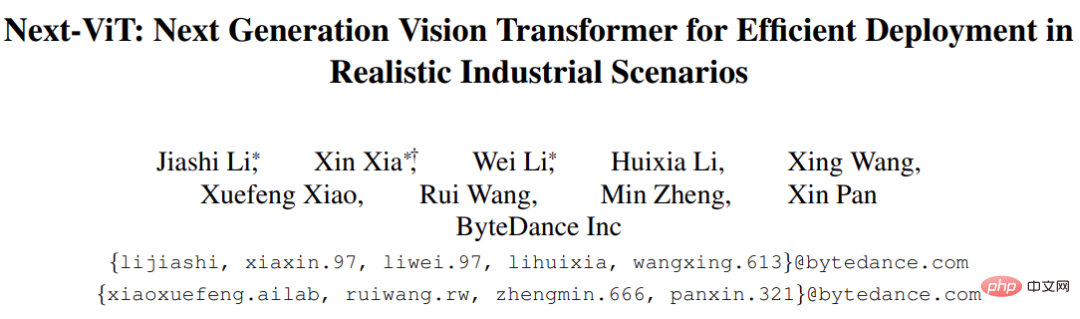

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM

解锁CNN和Transformer正确结合方法,字节跳动提出有效的下一代视觉TransformerApr 09, 2023 pm 02:01 PM由于复杂的注意力机制和模型设计,大多数现有的视觉 Transformer(ViT)在现实的工业部署场景中不能像卷积神经网络(CNN)那样高效地执行。这就带来了一个问题:视觉神经网络能否像 CNN 一样快速推断并像 ViT 一样强大?近期一些工作试图设计 CNN-Transformer 混合架构来解决这个问题,但这些工作的整体性能远不能令人满意。基于此,来自字节跳动的研究者提出了一种能在现实工业场景中有效部署的下一代视觉 Transformer——Next-ViT。从延迟 / 准确性权衡的角度看,

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM

Stable Diffusion XL 现已推出—有什么新功能,你知道吗?Apr 07, 2023 pm 11:21 PM3月27号,Stability AI的创始人兼首席执行官Emad Mostaque在一条推文中宣布,Stable Diffusion XL 现已可用于公开测试。以下是一些事项:“XL”不是这个新的AI模型的官方名称。一旦发布稳定性AI公司的官方公告,名称将会更改。与先前版本相比,图像质量有所提高与先前版本相比,图像生成速度大大加快。示例图像让我们看看新旧AI模型在结果上的差异。Prompt: Luxury sports car with aerodynamic curves, shot in a

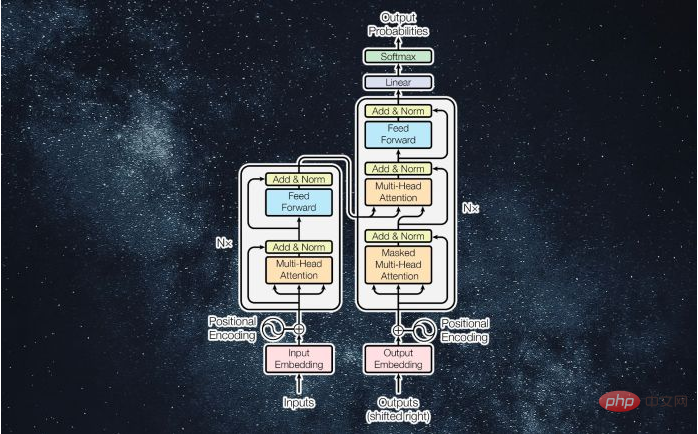

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM

什么是Transformer机器学习模型?Apr 08, 2023 pm 06:31 PM译者 | 李睿审校 | 孙淑娟近年来, Transformer 机器学习模型已经成为深度学习和深度神经网络技术进步的主要亮点之一。它主要用于自然语言处理中的高级应用。谷歌正在使用它来增强其搜索引擎结果。OpenAI 使用 Transformer 创建了著名的 GPT-2和 GPT-3模型。自从2017年首次亮相以来,Transformer 架构不断发展并扩展到多种不同的变体,从语言任务扩展到其他领域。它们已被用于时间序列预测。它们是 DeepMind 的蛋白质结构预测模型 AlphaFold

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM

五年后AI所需算力超100万倍!十二家机构联合发表88页长文:「智能计算」是解药Apr 09, 2023 pm 07:01 PM人工智能就是一个「拼财力」的行业,如果没有高性能计算设备,别说开发基础模型,就连微调模型都做不到。但如果只靠拼硬件,单靠当前计算性能的发展速度,迟早有一天无法满足日益膨胀的需求,所以还需要配套的软件来协调统筹计算能力,这时候就需要用到「智能计算」技术。最近,来自之江实验室、中国工程院、国防科技大学、浙江大学等多达十二个国内外研究机构共同发表了一篇论文,首次对智能计算领域进行了全面的调研,涵盖了理论基础、智能与计算的技术融合、重要应用、挑战和未来前景。论文链接:https://spj.scien

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM

AI模型告诉你,为啥巴西最可能在今年夺冠!曾精准预测前两届冠军Apr 09, 2023 pm 01:51 PM说起2010年南非世界杯的最大网红,一定非「章鱼保罗」莫属!这只位于德国海洋生物中心的神奇章鱼,不仅成功预测了德国队全部七场比赛的结果,还顺利地选出了最终的总冠军西班牙队。不幸的是,保罗已经永远地离开了我们,但它的「遗产」却在人们预测足球比赛结果的尝试中持续存在。在艾伦图灵研究所(The Alan Turing Institute),随着2022年卡塔尔世界杯的持续进行,三位研究员Nick Barlow、Jack Roberts和Ryan Chan决定用一种AI算法预测今年的冠军归属。预测模型图

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

Dreamweaver Mac版

視覺化網頁開發工具