AI 畫圖的著名公司 Stability AI,終於入局 AI 生成影片了。

這週二,基於穩定擴散的視訊生成模型Stable Video Diffusion 推出了,AI 社群立即展開了討論

很多人都表示「我們終於等到了」。

專案連結:https://github.com/Stability-AI/generative-models

現在,你可以利用現有的靜態影像來產生幾秒鐘的影片

基於Stability AI 原有的Stable Diffusion 文生圖模型,Stable Video Diffusion 成為了開源或商業行列中為數不多的視訊生成模型之一。

但目前還不是所有人都可以使用,Stable Video Diffusion 已經開放了用戶候補名單註冊(https://stability.ai/contact)。

根據介紹,穩定視訊傳播可以輕鬆適應各種下游任務,包括透過對多視圖資料集進行微調,從單一影像進行多視圖合成。穩定人工智慧表示,正在計劃建立和擴展這一基礎的各種模型,類似於圍繞穩定擴散建立的生態系統

透過穩定的影片傳播,可以以每秒3到30幀的可自訂幀速率產生14和25幀的影片

在外部評估中, Stability AI 證實這些模型超越了用戶偏好研究中領先的閉源模型:

Stability AI 強調,Stable Video Diffusion 現階段不適用於現實世界或直接的商業應用,後續將根據使用者對安全性和品質的見解和回饋來完善此模型。

論文地址:https://stability.ai/research/stable-video-diffusion-scaling-latent-video-diffusion-models- to-large-datasets

穩定的視訊傳輸是穩定AI開源模型家族中的一員。現在看來,他們的產品已涵蓋圖像、語言、音訊、三維和程式碼等多個模態,這充分證明了他們對提升人工智慧的承諾

Stable Video Diffusion的技術層面

穩定視訊擴散模型作為一種高解析度視訊的潛在擴散模型,已經達到了文字到視訊或圖像到視訊的SOTA 水平。最近,透過在小型高品質視訊資料集上插入時間層並進行微調,將2D影像合成訓練的潛在擴散模型轉變為生成視訊模型。然而,文獻中的訓練方法千差萬別,該領域尚未就視頻資料整理的統一策略達成一致

在Stable Video Diffusion 的論文中,Stability AI 確定並評估了成功訓練視頻潛在擴散模型的三個不同階段:文字轉影像預訓練、視訊預訓練和高品質視訊微調。他們還證明了精心準備的預訓練資料集對於產生高品質影片的重要性,並介紹了訓練出強大基礎模型的系統化策劃流程,其中包括了字幕和過濾策略。

Stability AI 在論文中也探討了在高品質資料上對基礎模型進行微調的影響,並訓練出一個可與閉源視訊生成相媲美的文本到視頻模型。該模型為下游任務提供了強大的運動表徵,例如影像到視訊的生成以及對攝影機運動特定的 LoRA 模組的適應性。除此之外,該模型還能夠提供強大的多視圖3D 先驗,這可以作為多視圖擴散模型的基礎,模型以前饋方式生成對象的多個視圖,只需要較小的算力需求,性能也優於基於圖像的方法。

具體而言,訓練模型成功需要經歷以下三個階段:

階段一:影像預訓練。 本文將影像預訓練視為訓練 pipeline 的第一階段,並將初始模型建立在 Stable Diffusion 2.1 的基礎上,這樣一來為視訊模型配備了強大的視覺表示。為了分析影像預訓練的效果,本文也訓練並比較了兩個相同的影片模型。圖 3a 結果表明,影像預訓練模型在品質和提示追蹤方面都更受青睞。

階段 2:影片預訓練資料集。 本文依靠人類偏好作為訊號來創建合適的預訓練資料集。本文所建立的資料集為 LVD(Large Video Dataset ),由 580M 對註解的影片片段組成。

進一步調查發現,產生的資料集中包含一些可能會降低最終視訊模型效能的範例。因此,在本文中我們使用了密集光流來給資料集進行標註

#此外,本文也應用光學字元辨識來清除包含大量文字的剪輯。最後,本文使用 CLIP 嵌入來註釋每個剪輯的第一幀、中間幀和最後一幀。下表提供了 LVD 資料集的一些統計資料:

階段 3:高品質微調。 為了分析影片預訓練對最後階段的影響,本文對三個模型進行了微調,這些模型僅在初始化方面有所不同。圖 4e 為結果。

看起來這是個好的開始。什麼時候,我們能用 AI 直接生成一部電影呢?

以上是Stable Video Diffusion來了,程式碼權重已上線的詳細內容。更多資訊請關注PHP中文網其他相關文章!

如何使用Llama索引和Monsterapi建立AI代理Apr 15, 2025 am 10:44 AM

如何使用Llama索引和Monsterapi建立AI代理Apr 15, 2025 am 10:44 AMAI特工:由Llamaindex和Monsterapi提供支持的AI的未來 AI代理有望徹底改變我們與技術的互動方式。 這些自主系統模仿人類行為,執行需要推理,決策和REA的任務

在沒有人類干預的情況下訓練LLM的7種方法Apr 15, 2025 am 10:38 AM

在沒有人類干預的情況下訓練LLM的7種方法Apr 15, 2025 am 10:38 AM解鎖自治AI:自我訓練LLMS的7種方法 想像一個未來AI系統在沒有人類干預的情況下學習和發展的未來,就像孩子獨立掌握複雜概念的孩子一樣。這不是科幻小說;這是自我的應許

通過AI和NLG進行財務報告 - 分析VidhyaApr 15, 2025 am 10:35 AM

通過AI和NLG進行財務報告 - 分析VidhyaApr 15, 2025 am 10:35 AMAI驅動的財務報告:通過自然語言產生革新見解 在當今動態的業務環境中,準確及時的財務分析對於戰略決策至關重要。 傳統財務報告

這款Google DeepMind機器人會在2028年奧運會上演奏嗎?Apr 15, 2025 am 10:16 AM

這款Google DeepMind機器人會在2028年奧運會上演奏嗎?Apr 15, 2025 am 10:16 AMGoogle DeepMind的乒乓球機器人:體育和機器人技術的新時代 巴黎2024年奧運會可能已經結束,但是由於Google DeepMind,運動和機器人技術的新時代正在興起。 他們的開創性研究(“實現人類水平的競爭

使用Gemini Flash 1.5型號構建食物視覺網絡應用Apr 15, 2025 am 10:15 AM

使用Gemini Flash 1.5型號構建食物視覺網絡應用Apr 15, 2025 am 10:15 AM雙子座閃光燈1.5解鎖效率和可伸縮性:燒瓶食物視覺webapp 在快速發展的AI景觀中,效率和可擴展性至關重要。 開發人員越來越多地尋求高性能模型,以最大程度地減少成本和延遲

使用LlamainDex實施AI代理Apr 15, 2025 am 10:11 AM

使用LlamainDex實施AI代理Apr 15, 2025 am 10:11 AM利用LlamainDex的AI特工的力量:逐步指南 想像一下,一個私人助理了解您的要求並完美地執行它們,無論是快速計算還是檢索最新的市場新聞。本文探索

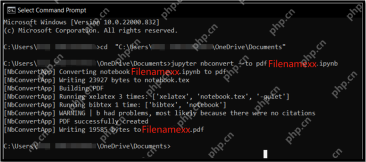

將.ipynb文件轉換為PDF- Analytics Vidhya的5種方法Apr 15, 2025 am 10:06 AM

將.ipynb文件轉換為PDF- Analytics Vidhya的5種方法Apr 15, 2025 am 10:06 AMJupyter Notebook (.ipynb) 文件廣泛用於數據分析、科學計算和交互式編碼。雖然這些 Notebook 非常適合開發和與其他數據科學家共享代碼,但有時您需要將其轉換為更普遍易讀的格式,例如 PDF。本指南將引導您逐步了解將 .ipynb 文件轉換為 PDF 的各種方法,以及技巧、最佳實踐和故障排除建議。 目錄 為什麼將 .ipynb 轉換為 PDF? 將 .ipynb 文件轉換為 PDF 的方法 使用 Jupyter Notebook UI 使用 nbconve

LLM量化和用例的綜合指南Apr 15, 2025 am 10:02 AM

LLM量化和用例的綜合指南Apr 15, 2025 am 10:02 AM介紹 大型語言模型(LLM)正在徹底改變自然語言處理,但它們的巨大規模和計算要求限制了部署。 量化是一種縮小模型和降低計算成本的技術,是至關重要的

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能

SublimeText3 Linux新版

SublimeText3 Linux最新版

Dreamweaver CS6

視覺化網頁開發工具

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中