大型語言模型在表現方面表現出色,能夠透過零樣本或少樣本提示來解決新任務。然而,在實際應用部署中,LLM卻不太實用,因為它的記憶體利用效率低,同時需要大量的運算資源

例如執行1750億參數的語言模型服務至少需要350GB的顯存,而目前最先進的語言模型大多已超過5000億參數量,許多研究團隊都沒有足夠的資源來運行,在現實應用中也無法滿足低延遲性能。

也有一些研究使用人工標註資料或使用LLM產生的標籤進行蒸餾來訓練較小的、任務專用的模型,不過微調和蒸餾需要大量的訓練資料才能實現與LLM相當的效能。

為了解決大型模型對資源的需求問題,華盛頓大學與Google合作提出了一種名為「逐步蒸餾」(Distilling Step-by-Step)的新蒸餾機制。透過逐步蒸餾,經過蒸餾後的模型尺寸相較於原模型來說更小,但性能卻更優,而且在微調和蒸餾過程中所需的訓練數據也更少

#請點選以下連結查看論文:https://arxiv.org/abs/2305.02301

分佈蒸餾機制把LLM中抽取的預測理由(rationale )作為在多任務框架內訓練小模型的額外監督資訊。

經過在4個NLP基準上進行實驗後,我們發現:

1. 與微調和蒸餾相比,該機制用更少的訓練樣本實現了更好的性能;

相對於少樣本提示LLM,該機制利用更小尺寸的模型實現了更出色的性能

3. 同時降低模型尺寸和數據量也可以實現優於LLM的效能。

實驗中,微調後770M的T5模型在基準測試中僅使用80%的可用數據就優於少樣本提示的540B的PaLM模型,而標準微調相同的T5模型即使使用100%的數據集也難以匹配。

蒸餾方法

分佈蒸餾的關鍵思想是逐步抽取資訊豐富且用自然語言描述的預測理由,即中間推理步驟,以解釋輸入問題與模型輸出之間的聯繫,並透過這些數據來更有效率地訓練小模型

分佈蒸餾主要包括兩個階段:

1. 從LLM中提取原理(rationale)

研究人員利用少樣本思維鏈(CoT)提示從LLM中提取預測中間步驟。

在決定目標任務之後,先在LLM輸入提示中準備幾個範例。每個範例都由一個三元組組成,包括輸入、原理和輸出

輸入提示後,LLM能夠模仿三元組演示以產生其他新問題的預測原理,例如,在常識問答案任務中,給定輸入問題:

#Sammy想去人群聚集的地方。他會選擇哪裡呢?選項有:(a)人口稠密地區,(b)賽道,(c)沙漠,(d)公寓,(e)路障

(Sammy wanted to go to where the people are. Where might he go? Answer Choices: (a) populated areas, (b) race track, (c) desert, (d) apartment, (e) roadblock)

經過逐步提煉後,LLM可以給出問題的正確答案“(a)人口稠密地區”,並且提供回答問題的理由“答案必須是一個有很多人的地方,在上述選擇中,只有人口稠密的地區有很多人。” 經過逐步提煉,LLM能夠得出正確答案為“(a)人口稠密地區”,並提供了解答問題的理由“答案必須是一個有很多人的地方,在上述選擇中,只有人口稠密的地區有很多人。”

透過在提示中提供與基本原理配對的CoT範例,上下文學習能力可以讓LLM為未曾遇到的問題類型產生對應的回答理由

2. 訓練小模型

透過將訓練過程建構成多任務問題,可以將預測理由抽取出來,並將其納入訓練小模型中

除了標準標籤預測任務之外,研究人員還使用新的理由生成任務來訓練小模型,使得模型能夠學習產生用於預測的中間推理步驟,並且引導模型更好地預測結果標籤。

透過在輸入提示中加入任務前綴「label」和「rationale」來區分標籤預測和理由產生任務。

實驗結果

在實驗中,研究人員選擇5,400億個參數量的PaLM模型作為LLM基線,使用T5模型作為任務相關的下游小模型。

在這項研究中,我們對四個基準資料集進行了實驗,這四個資料集分別是e-SNLI和ANLI用於自然語言推理,CQA用於常識問答,以及SVAMP用於算術數學應用題。我們在這三個不同的NLP任務中進行了實驗

#更少的訓練資料

逐步蒸餾方法在表現上比標準微調更出色,而且只需較少的訓練資料

在e-SNLI資料集上,當使用完整資料集的12.5%時就實現了比標準微調更好的性能,在ANLI、 CQA和SVAMP上分別只需要75%、25%和20%的訓練資料。

與使用220M T5模型對不同大小的人工標記資料集進行標準微調相比,分佈蒸餾在所有資料集上使用較少的訓練範例時,優於在完整資料集上進行標準微調

更小的部署模型尺寸

與少樣本CoT提示的LLM相比,分佈蒸餾得到的模型尺寸要小得多,但性能更好。

在e-SNLI資料集上,使用220M的T5模型實現了比540B的PaLM更好的性能;在ANLI上,使用770M的T5模型實現了比540B的PaLM更好的性能,模型尺寸僅為1/700

更小的模型、更少的資料

在縮小模型尺寸和訓練資料的同時,我們成功地實現了超越少樣本PaLM的性能

在ANLI中,使用770M T5模型的性能超過了540B PaLM,而且只使用了完整數據集的80%

經觀察可知,即使使用完整的100%資料集,標準微調也無法達到PaLM的性能水平,這表明透過逐步蒸餾可以同時減少模型尺寸和訓練資料量,從而實現超越LLM的效能

以上是7.7億參數,超越5400億PaLM! UW谷歌提出「分步蒸餾」,只需80%訓練資料|ACL 2023的詳細內容。更多資訊請關注PHP中文網其他相關文章!

ai合并图层的快捷键是什么Jan 07, 2021 am 10:59 AM

ai合并图层的快捷键是什么Jan 07, 2021 am 10:59 AMai合并图层的快捷键是“Ctrl+Shift+E”,它的作用是把目前所有处在显示状态的图层合并,在隐藏状态的图层则不作变动。也可以选中要合并的图层,在菜单栏中依次点击“窗口”-“路径查找器”,点击“合并”按钮。

ai橡皮擦擦不掉东西怎么办Jan 13, 2021 am 10:23 AM

ai橡皮擦擦不掉东西怎么办Jan 13, 2021 am 10:23 AMai橡皮擦擦不掉东西是因为AI是矢量图软件,用橡皮擦不能擦位图的,其解决办法就是用蒙板工具以及钢笔勾好路径再建立蒙板即可实现擦掉东西。

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM

谷歌超强AI超算碾压英伟达A100!TPU v4性能提升10倍,细节首次公开Apr 07, 2023 pm 02:54 PM虽然谷歌早在2020年,就在自家的数据中心上部署了当时最强的AI芯片——TPU v4。但直到今年的4月4日,谷歌才首次公布了这台AI超算的技术细节。论文地址:https://arxiv.org/abs/2304.01433相比于TPU v3,TPU v4的性能要高出2.1倍,而在整合4096个芯片之后,超算的性能更是提升了10倍。另外,谷歌还声称,自家芯片要比英伟达A100更快、更节能。与A100对打,速度快1.7倍论文中,谷歌表示,对于规模相当的系统,TPU v4可以提供比英伟达A100强1.

ai可以转成psd格式吗Feb 22, 2023 pm 05:56 PM

ai可以转成psd格式吗Feb 22, 2023 pm 05:56 PMai可以转成psd格式。转换方法:1、打开Adobe Illustrator软件,依次点击顶部菜单栏的“文件”-“打开”,选择所需的ai文件;2、点击右侧功能面板中的“图层”,点击三杠图标,在弹出的选项中选择“释放到图层(顺序)”;3、依次点击顶部菜单栏的“文件”-“导出”-“导出为”;4、在弹出的“导出”对话框中,将“保存类型”设置为“PSD格式”,点击“导出”即可;

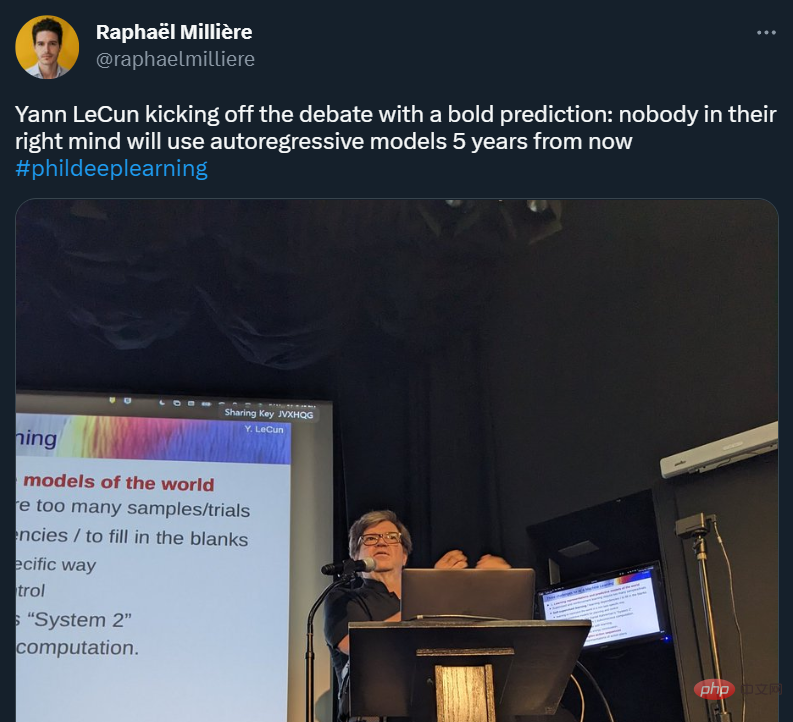

GPT-4的研究路径没有前途?Yann LeCun给自回归判了死刑Apr 04, 2023 am 11:55 AM

GPT-4的研究路径没有前途?Yann LeCun给自回归判了死刑Apr 04, 2023 am 11:55 AMYann LeCun 这个观点的确有些大胆。 「从现在起 5 年内,没有哪个头脑正常的人会使用自回归模型。」最近,图灵奖得主 Yann LeCun 给一场辩论做了个特别的开场。而他口中的自回归,正是当前爆红的 GPT 家族模型所依赖的学习范式。当然,被 Yann LeCun 指出问题的不只是自回归模型。在他看来,当前整个的机器学习领域都面临巨大挑战。这场辩论的主题为「Do large language models need sensory grounding for meaning and u

ai顶部属性栏不见了怎么办Feb 22, 2023 pm 05:27 PM

ai顶部属性栏不见了怎么办Feb 22, 2023 pm 05:27 PMai顶部属性栏不见了的解决办法:1、开启Ai新建画布,进入绘图页面;2、在Ai顶部菜单栏中点击“窗口”;3、在系统弹出的窗口菜单页面中点击“控制”,然后开启“控制”窗口即可显示出属性栏。

ai移动不了东西了怎么办Mar 07, 2023 am 10:03 AM

ai移动不了东西了怎么办Mar 07, 2023 am 10:03 AMai移动不了东西的解决办法:1、打开ai软件,打开空白文档;2、选择矩形工具,在文档中绘制矩形;3、点击选择工具,移动文档中的矩形;4、点击图层按钮,弹出图层面板对话框,解锁图层;5、点击选择工具,移动矩形即可。

强化学习再登Nature封面,自动驾驶安全验证新范式大幅减少测试里程Mar 31, 2023 pm 10:38 PM

强化学习再登Nature封面,自动驾驶安全验证新范式大幅减少测试里程Mar 31, 2023 pm 10:38 PM引入密集强化学习,用 AI 验证 AI。 自动驾驶汽车 (AV) 技术的快速发展,使得我们正处于交通革命的风口浪尖,其规模是自一个世纪前汽车问世以来从未见过的。自动驾驶技术具有显着提高交通安全性、机动性和可持续性的潜力,因此引起了工业界、政府机构、专业组织和学术机构的共同关注。过去 20 年里,自动驾驶汽车的发展取得了长足的进步,尤其是随着深度学习的出现更是如此。到 2015 年,开始有公司宣布他们将在 2020 之前量产 AV。不过到目前为止,并且没有 level 4 级别的 AV 可以在市场

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)