阿里巨型模型再次開源!影像理解與物體辨識功能一應俱全,基於通用問題集7B訓練,商業應用可行

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-09-03 13:01:08805瀏覽

阿里巴巴開源了一個新的大模型,非常令人興奮~

繼通義千問-7B(Qwen-7B)之後,阿里雲又推出了大規模視覺語言模型Qwen-VL,並且一上線就直接開源。

Qwen-VL是一種基於通義千問-7B的多模態大模型,具體而言,它支援圖像、文字和偵測框架等多種輸入,並且不僅可以輸出文本,還可以輸出檢測框

舉個例子,我們輸入一張阿尼亞的圖片,通過問答的形式,Qwen-VL-Chat能夠總結圖片內容,並且能夠準確地定位到圖片中的阿尼亞

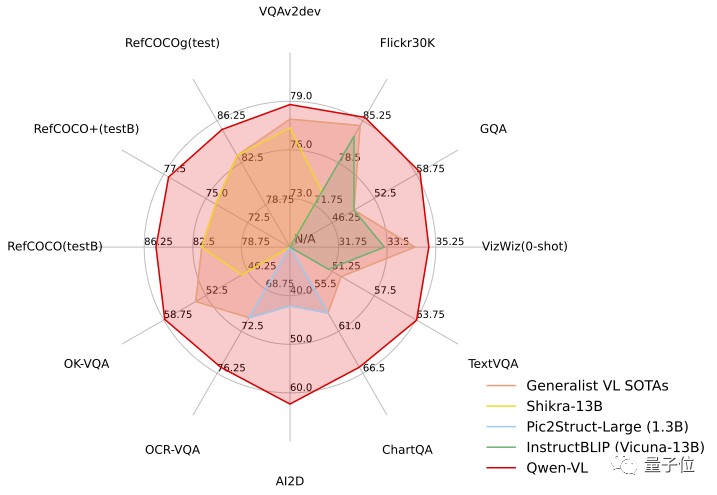

在測試任務中,Qwen-VL展現出了「六邊形戰士」的實力,在四大類在多模態任務的標準英文評測中(Zero-shot Caption/VQA/DocVQA/Grounding)上,都取得了最先進的成果

一經開源訊息傳出,立刻引起了廣泛關注

讓我們一起來看看具體的表現如何!

首個支援中文開放域定位的通用模型

首先,讓我們來整體看一下Qwen-VL系列模型的特點:

- 多語言對話:支援多語言對話,端到端支援圖片裡中英雙語的長文本辨識;

- 多圖交錯對話:支援多圖輸入和比較,指定圖片問答,多圖文學創作等;

- 首個支援中文開放域定位的一般模型:透過中文開放域語言表達進行偵測框標註,也就是能在畫面中精準地找到目標物件;

- 細微辨識與理解:相較於目前其它開源LVLM(大規模視覺語言模型)使用的224分辨率,Qwen-VL是首個開源的448分辨率LVLM模型。更高解析度可以提升細粒度的文字辨識、文件問答和偵測框標註。

在不改變原意的情況下,需要重寫的內容是:Qwen-VL可以在知識問答、圖像問答、文件問答、細粒度視覺定位等場景中使用

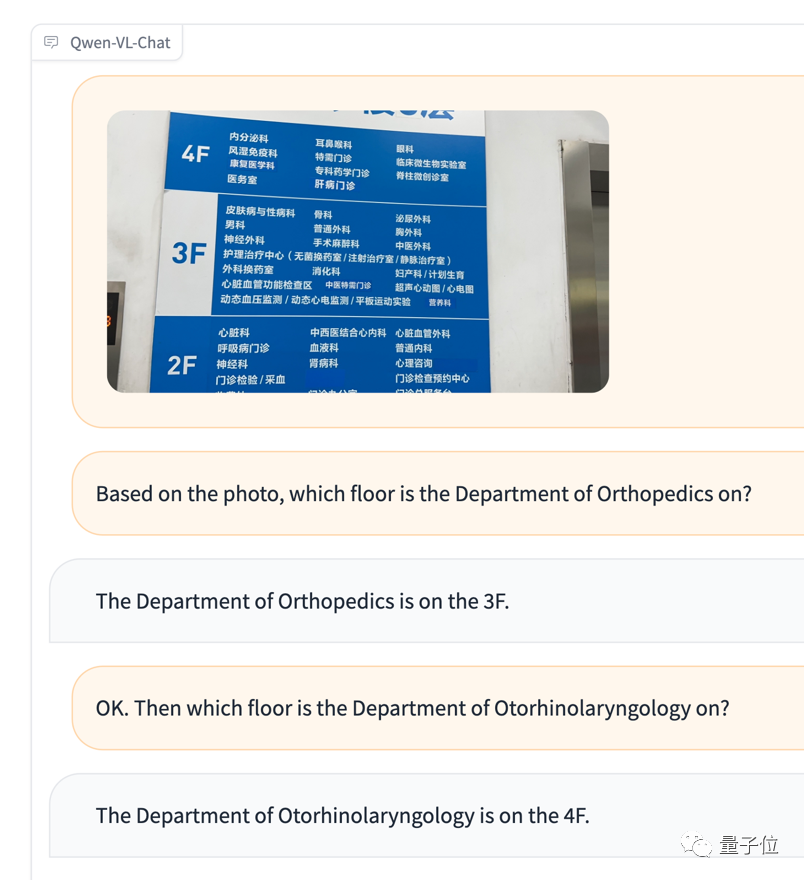

例如,有一個外國朋友不懂中文去醫院看病,對著導覽圖感到困惑,不知道如何前往相應的科室,可以直接將圖和問題交給Qwen-VL,讓它根據圖片信息充當翻譯

再次進行多圖輸入和比較的測試

#儘管沒有認出阿尼亞,但情緒判斷確實相當準確(手動狗頭)

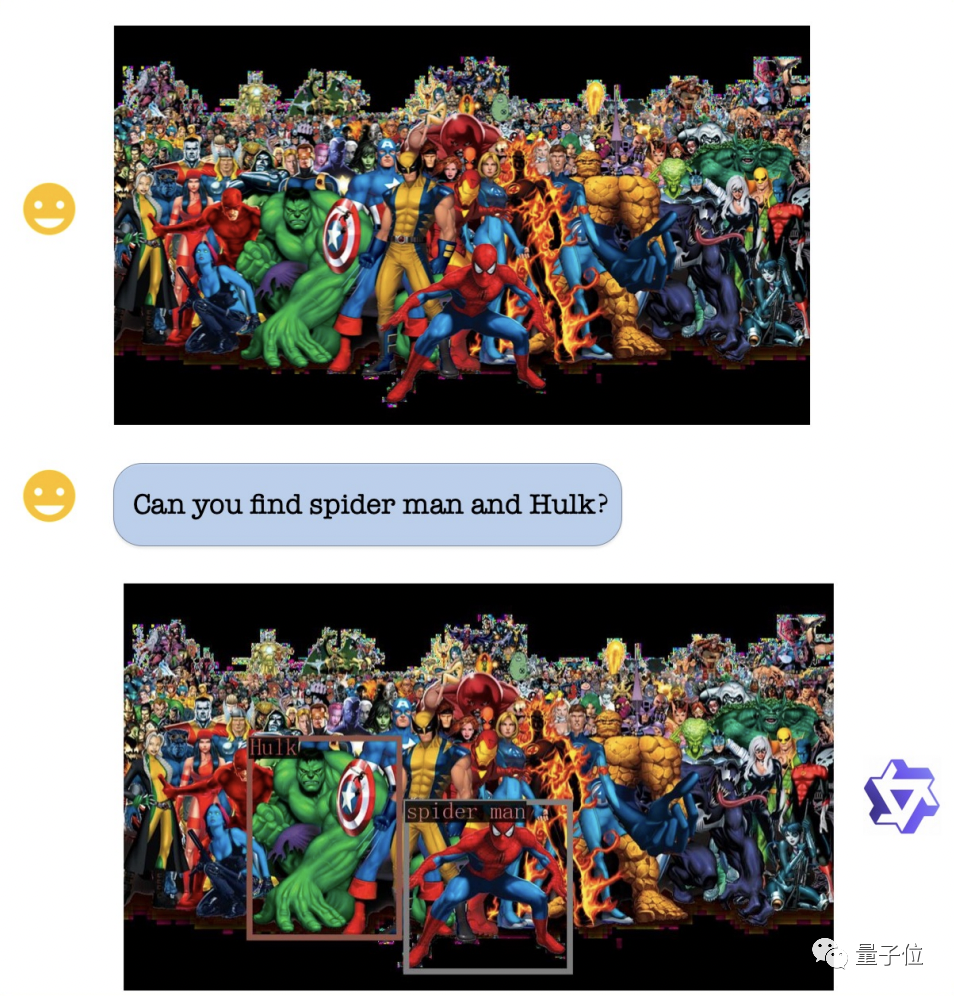

在視覺定位能力方面,即使圖片非常複雜且人物眾多,Qwen-VL仍然可以根據要求準確地找出綠巨人和蜘蛛俠

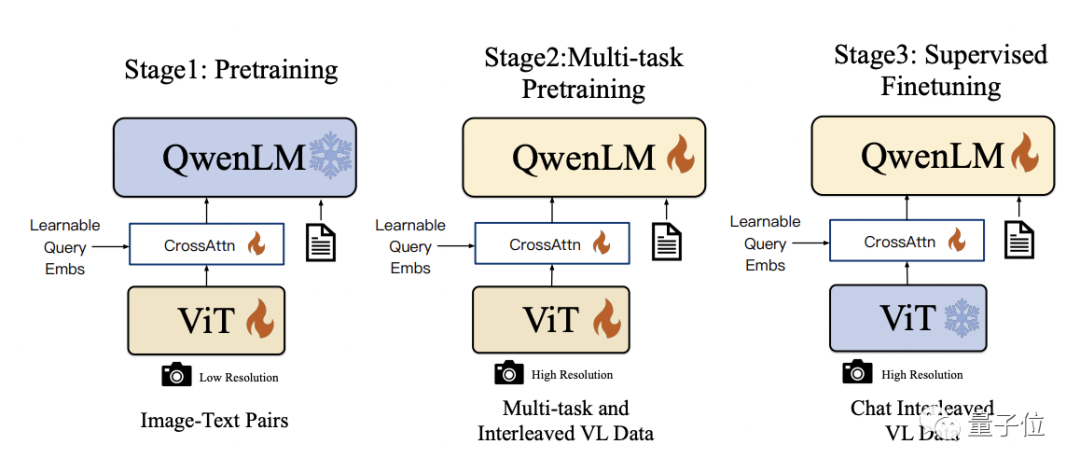

Qwen-VL在技術細節上以Qwen-7B為基座語言模型,並透過引入視覺編碼器ViT和位置感知的視覺語言適配器,使得模型能夠支援視覺訊號輸入

具體的訓練過程分為三個步驟:

- 預先訓練:只優化視覺編碼器和視覺語言適配器,凍結語言模型。使用大規模影像-文字配對數據,輸入影像解析度為224x224。

- 多任務預訓練:引入更高解析度(448x448)的多任務視覺語言數據,如VQA、文字VQA、指稱理解等,進行多任務聯合預訓練。

- 監督微調:凍結視覺編碼器,最佳化語言模型和適配器。使用對話互動資料進行提示調優,得到最終的具有互動能力的Qwen-VL-Chat模型。

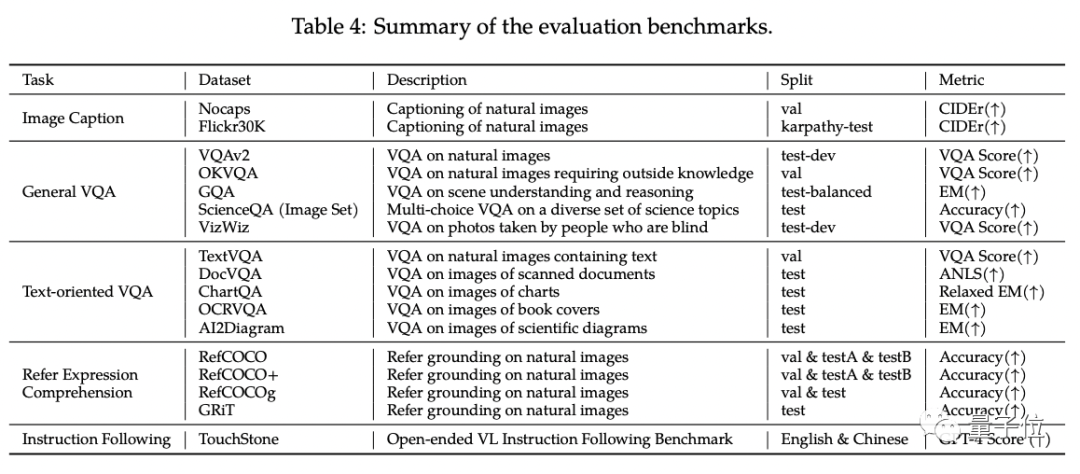

在Qwen-VL的標準英文評估中,研究人員對四大類多模態任務(Zero-shot Caption/VQA/DocVQA/Grounding)進行了測試

#根據結果顯示,Qwen-VL在與同等尺寸的開源LVLM進行比較時取得了最佳效果

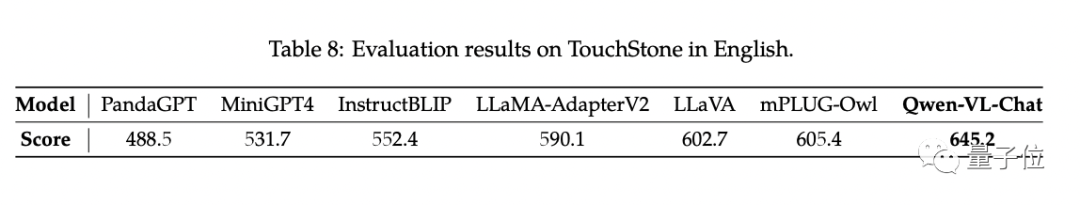

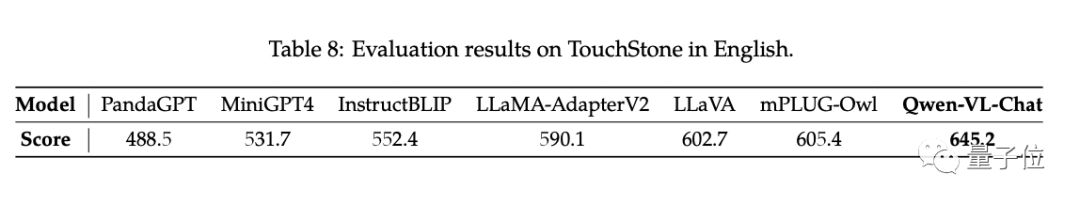

另外,研究人員構建了一套基於GPT-4打分機制的測試集TouchStone。

Qwen-VL-Chat在這項對比測試中取得了最先進技術水準(SOTA)

如果你對Qwen-VL有興趣,你可以在魔搭社群和huggingface上找到demo來直接試玩。連結在文末提供

Qwen-VL支持研究人員和開發者進行二次開發,並且允許商業使用。但要注意的是,如果要進行商業使用,需要先填寫問卷申請

#計畫連結:https://modelscope.cn/models/qwen/Qwen-VL /summary

https://modelscope.cn/models/qwen/Qwen-VL-Chat/summary

https://huggingface.co/Qwen/Qwen -VL

https://huggingface.co/Qwen/Qwen-VL-Chat

https://github.com/QwenLM/Qwen-VL

請點選以下連結查看論文:https://arxiv.org/abs/2308.12966

以上是阿里巨型模型再次開源!影像理解與物體辨識功能一應俱全,基於通用問題集7B訓練,商業應用可行的詳細內容。更多資訊請關注PHP中文網其他相關文章!