鵝廠機器狗搶起真狗「飯碗」!會撒歡兒做遊戲,遛人也賊6

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-06-15 21:49:541474瀏覽

讓機器狗學完真狗子的運動數據,真有二哈那感覺了!

它輕鬆跨個欄,後面「主人」差點沒跟上:

#鑽個「狗洞」倒是輕車熟路:

還能兩隻狗一起撒歡兒,它追、它逃…

這就是鵝廠機器狗的最新進展。

利用預訓練模型餵給機器狗真狗子的運動數據、並通過強化學習,機器狗Max不僅在行為上更靈動,而且還能根據已經掌握的技能“舉一反三”,去適應更加複雜的環境。

總結來說,就是裡裡外外都「更狗」了一些。

有策略地追逐撒歡兒

這次機器狗學習的新技能裡,最強的一項還是玩遊戲。

機器狗不僅能遵守規則,還能自己想出策略贏比賽,可能比真狗子還要聰明些。

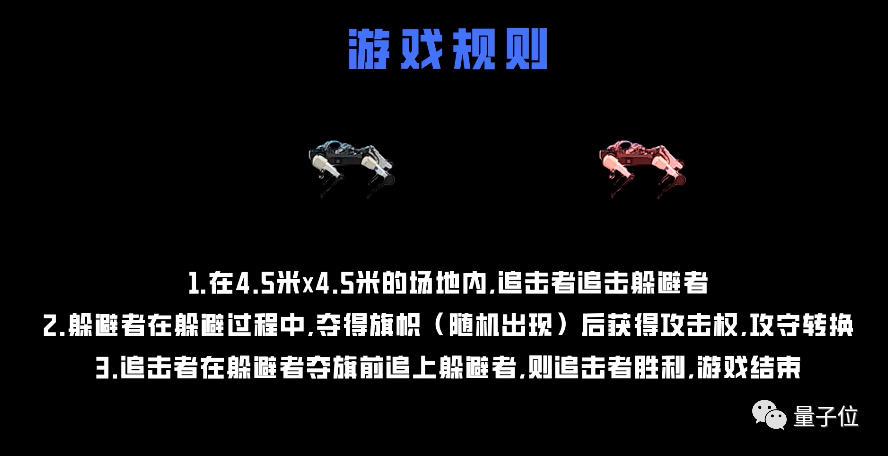

具體來看,這是一場障礙追逐比賽,受到「World Chase Tag」啟發,規則如下:

研究人員設定了不同遊戲難度,最簡單的就是空曠場地:

在玩遊戲過程裡,機器狗很明顯是有策略的。

例如,一般等到躲避者離棋旗子較遠時,追擊者才會發動猛攻,把它逼到死角,遊戲結束。

如果追擊者發現躲避者離旗幟很近,自己根本沒機會追上它時,它會先放棄追逐,等待下一個旗子出現:

有障礙物幹擾也沒關係,兩個狗子一樣玩得很6:

而能夠有如此表現,並不是機器狗從一開始就拿這個遊戲訓練。

它其實是基於自己已經學到的一些動作、知識和技能,來應對這個遊戲場景。

具體怎麼實現?往下看。

學了真·狗的資料

研究總共分為三個階段。

- 學習動物運動姿態

- 將運動姿態和外界感知聯繫起來

- 附加網路獲取和複雜任務有關資訊

第一階段,是透過遊戲中常用的動作捕捉系統,透過收集真狗的姿態資料,包括走、跑、跳、站立等動作,在模擬器中建構一個模仿學習任務。

然後將這些資料中的資訊抽象化並壓縮到深度神經網路模型中,使其在涵蓋運動姿態資訊的同時,還具有一定可解釋性。

騰訊RoboticsX機器人實驗室和騰訊遊戲合作,用遊戲技術提高了模擬引擎的準確性和高效性,同時遊戲製作和研發過程中累積了多元的動捕素材。

這些技術以及資料對基於物理模擬的智能體訓練以及真實世界機器人策略部署也起到了一定的輔助作用。

再下一步,模型引入周邊環境的感知數據,例如透過其他感測器「看到」的腳下的障礙物。

第二階段,透過額外的網路參數,將第一階段掌握的動物姿態和外界感知連結在一起。

這樣機器狗就能通過已經學會的動作,來應付外在環境。

當機器人能夠適應多種複雜的環境後,這些將動物姿態與外界感知聯繫在一起的知識也會被固化下來,存在神經網路結構中。

然後機器狗就能自如上樓梯了。

或在不連續、不平整地面上奔跑:

然後就到了最後一階段,讓機器狗根據上面學會的技能,去解決實際問題

也就是上面提到的做遊戲環節。

據介紹,遊戲中機器狗的所有控制策略都是神經網路策略。

在模擬中進行學習並透過zero-shot transfer(零調整遷移),讓神經網路模擬人類的推理方式,來辨識從未見過的新事物,並把這些知識部署到真實機器人。

例如在預訓練模型中學會了躲避障礙物的知識,那麼在遊戲裡設置障礙,機器狗也能輕鬆應付。

本研究新進展由騰訊Robotics X機器人實驗室帶來。

實驗成立於2018年,目前推出的機器人專案包括機器狗Max一代/二代、機器狗Jamoca、輪式機器人Ollie、自平衡自動駕駛摩托車等。

One More Thing

值得一提的是,之前UC伯克利的學者也將一種「真狗子」的訓練方法,用在了機器狗上。

吳恩達開山大弟子Pieter Abbeel等,讓機器狗自己在地上打滾一個小時,學會了走路。

而去年騰訊發布機器狗Max二代時,一段小花絮裡,這狗會“撲腳”、“撒歡跑”,確實有家裡毛孩子那味兒。

(當然,如果你想讓它成為一隻聽主人話的狗, 透過指令即可對其發號施令。)

以上是鵝廠機器狗搶起真狗「飯碗」!會撒歡兒做遊戲,遛人也賊6的詳細內容。更多資訊請關注PHP中文網其他相關文章!