Meta 開源 AI 語言模型 MusicGen,可將文字和旋律轉化為完整樂曲

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-06-13 11:39:531515瀏覽

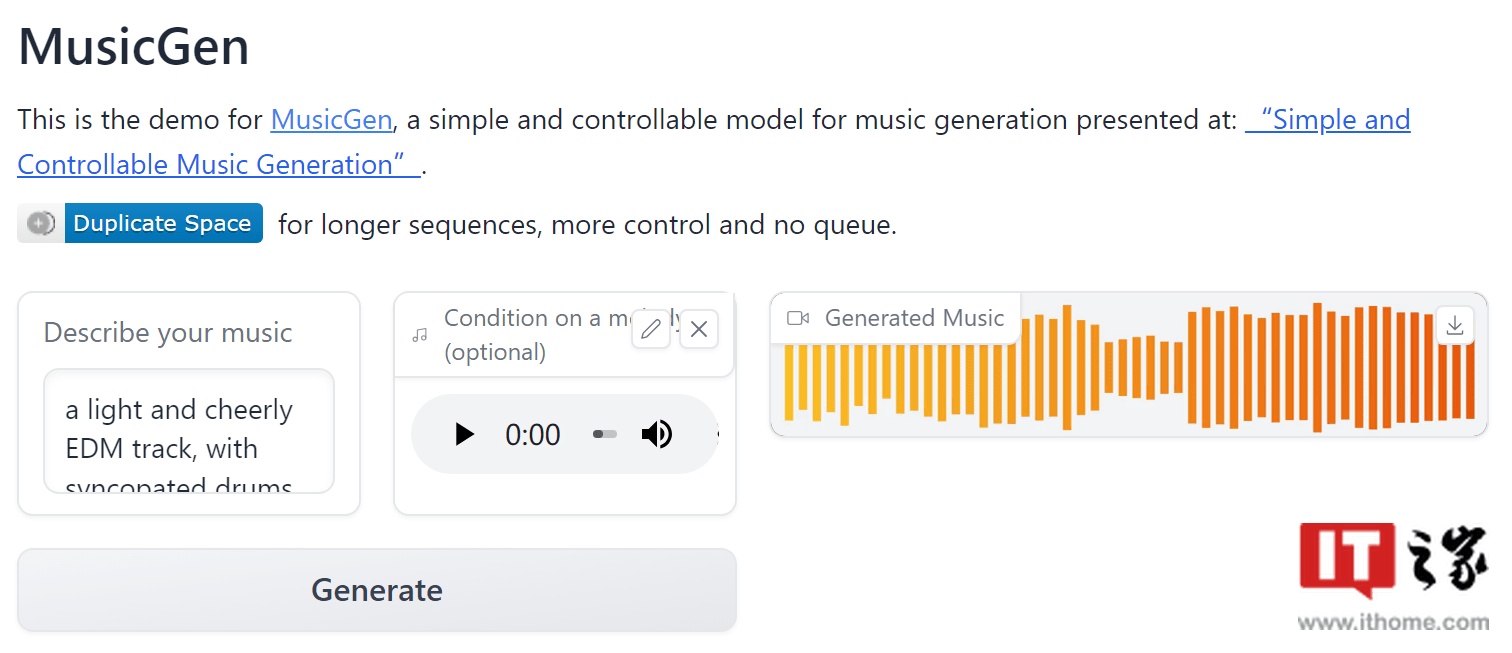

IT之家 6 月 12 日消息,Meta 近日在 Github 上開源了其 AI 語言模型 MusicGen,該模型基於谷歌 2017 年推出的 Transformer 模型。如模型名稱所示,MusicGen 主要用於音樂生成,它可以將文字和現有的旋律轉化為完整樂曲。

研發團隊表示:「我們使用了20000 小時的授權音樂來對訓練該模型,並採用Meta 的EnCodec 編碼器將音訊資料分解為更小的單元進行並行處理,進而讓MusicGen 的運算效率和生成速度都比同類型AI 模型更為出色。」

除此之外,MusicGen 還支援文本與旋律的組合輸入,例如你可以提出生成「一首輕快的曲目」並同時要求「將它與貝多芬的《歡樂頌》結合起來」。

研發團隊也對 MusicGen 的實際表現進行了測試。結果顯示,與Google的MusicLM 以及Riffusion、Mousai、Noise2Music 等其他音樂模型相比,MusicGen 在測試音樂與文字提示的匹配度以及作曲的可信度等指標上表現更好,總體而言略高於谷歌MusicLM 的等級。

Meta 已允許該模型的商業使用,並在 Huggingface 上發布了一個供演示的網頁應用程式。

IT之家附上模型位址:點此前往

示範應用程式位址:點此前往

以上是Meta 開源 AI 語言模型 MusicGen,可將文字和旋律轉化為完整樂曲的詳細內容。更多資訊請關注PHP中文網其他相關文章!

陳述:

本文轉載於:sohu.com。如有侵權,請聯絡admin@php.cn刪除