2023-06-07 17:42:41 作者:李文雯

每個科幻迷都嚮往著在未來能像和老朋友對話一樣,用寥寥數語發動星際飛船,征服星辰大海;或者擁有鋼鐵俠的人工智慧管家賈維斯,幾句對話就能造出一套奈米戰甲。其實這個畫面離我們並不遠──就像 iPhone 中的 Siri 一樣與我們同在觸手可及。 它的背後是自動語言辨識技術(Automatic Speech Recognition)。 這項關鍵技術能將語音轉換為電腦可辨識的文字或指令,實現便利、高效、智慧的人機互動體驗。

而隨著深度學習等 AI 技術的發展,語音辨識技術已經取得了巨大的進步——不僅識別準確度大大提高,而且能夠更好地處理口音、噪音和背景音等問題。但隨著科技在生活和業務中的不斷應用,仍會遇到一些瓶頸,畢竟從理論研究到實際應用,從論文到產品,需要考慮太多的現實因素。 如何讓語音辨識更好地輔助內容審核?如何讓辨識動作本身也能像人腦一樣,根據對情境的理解,以更低的成本給出更準確的答案?網易智企旗下易盾 AI Lab 給了新方法。

易盾又出黑科技,智企邁向全世界!

近日,全球語音、聲學會議ICASSP 2023 公佈了論文入選名單,網易智企旗下易盾 AI Lab 提交的論文成功被錄用。今年是第48 屆ICASSP 大會,也是疫情後的第一屆線下大會,雖然大會官方還未公佈最後錄用了多少篇論文,但論文投遞的數量相較往年上升了50%,達到了驚人的6,000 。

面對如此激烈的競爭,網易智企易盾AILab 團隊憑藉一篇語音辨識方向的論文《Improving CTC-based ASRModels with Gated Interplayer Collaboration(基於CTC 的模型改進,實現更強的模型結構)》脫穎而出,成功拿到了前往希臘羅德島線下參加的門票。

「GIC」,協助語音辨識更進一步

語音辨識本質上是語音序列到文字序列的轉化,而要完成這樣的轉化,一般會用到三類模型,CTC、Attention-based 和RNN-Transducer,它們在完成任務的時候採取了不同的路徑:

CTC:基於神經網路模型,在訓練過程中透過反向傳播來更新模型參數以最小化損失函數。該演算法引入了「空白符」來表示無意義字元或間隔符號。 CTC 適合處理輸入輸出長度相差較大的數據,如語音辨識中將聲學特徵對應為文字;

#Attention-based:注意力機制,也是基於神經網路模型,並使用一種稱為「注意力」的技術來對輸入進行加權匯聚。在每個時間步驟上,模型會根據當前狀態和所有輸入計算分佈式權重向量,並將其應用於所有輸入以產生一個加權平均值作為輸出。 這種方式可以使得模型更專注於與當前預測相關的部分資訊;

#RNN-Transducer:轉錄器,這個演算法結合了編碼器-解碼器框架和自回歸建模思想,在生成目標序列時同時考慮源語言句子和已生成部分目標語言句子之間的交互作用。與其他兩種方法不同,RNN-Transducer 沒有明確區分編碼器和解碼器階段,並且直接從源語言到目標語言進行轉換,因此可以同時考慮源語言句子和已生成部分目標語言句子之間的交互作用。

相比後兩者,雖然 CTC 具有天然的非自回歸解碼性質,解碼速度相對快很多,但依然有著性能劣勢:

1. CTC 演算法設定了條件獨立性假設,即 CTC 假設每個時間步的輸出之間是獨立的。這對語音辨識任務來說並不合理,假如說「ji rou」這個發音,在不同的脈絡中預測的文字內容應該不一樣的。如果上文是“我喜歡吃”,接下來“雞”的機率應該更高,同理如果上文是“他手臂有”,接下來“肌”的機率應該更高。 如果透過 CTC 訓練,很容易就會在忽略上文的前提下,輸出「我喜歡吃肌肉」這樣好笑的文字;

2.從建模的視角來看,Attention-based模型和RNN-Transducer 模型根據輸入和先前時間步的輸出預測當前時間步的輸出,而CTC 模型僅利用輸入來預測當下的輸出,在CTC 模型的建模過程中,文字資訊只是作為一種監督訊號回傳給網絡,並沒有作為網路的輸入明確促進模型的預測。

我們希望能在保留 CTC 解碼效率的同時,盡可能地解決以上兩點劣勢。於是,我們想從CTC 模型本身出發,設計輕量級的模組為基於CTC 的模型引入文本信息,使得模型能夠整合聲學和文本信息,學習到文本序列上下文之間的相互作用,從而緩解CTC 演算法的條件獨立性假設。但過程中,我們碰到了兩個問題:如何在CTC模型(Encoder CTC 結構)注入文字訊息?如何自適應地融合文本特徵和聲學特徵?

為了實現上述目標,我們設計了 Gated Interlayer Collaboration(簡寫為GIC)機制。 GIC 模組主要包含一個嵌入層(embedding layer)和一個門控單元(gate unit)。其中,嵌入層用於產生每個音訊輸入幀的文字訊息,門控單元用於自適應地融合文字訊息和聲學訊息。

具體地,我們的方法是基於多任務學習(Multi-taskLearning)框架,利用編碼器模組(Encoder)中間層的輸出計算輔助CTC loss,整個網路的目標函數是最後一層的CTC loss 和中間層輔助CTC loss 的加權和。 GIC 將網路中間層的預測,即 Softmax 輸出的機率分佈作為每一幀的軟標籤,點乘嵌入層矩陣總和作為每一幀的文字表徵。 最後,產生的文本表徵和聲學表徵透過一個閘控單元自適應地融合,成為一個新特徵輸入到下一層。此時的新特徵融合了文字特徵和聲學特徵,使得下一層的 Encoder 模組可以學習到聲學序列上下文資訊和文字序列上下文資訊。 整個模型的架構如下圖所示:

在 Conformer 和 Transformer 這兩個模型上的實驗顯示:

1. GIC 同時支援漢語和英文的場景辨識,同時準確度均取得了顯著的效能提升;

2. GIC 模型性能超過了同參數規模的Attention-based 和RNN-transducer 模型,並且具有非自回歸解碼的優勢,帶來數倍的解碼速度提升;

3. 相對原始的 CTC 模型,GIC 在多個開源資料集有遠超 10% 的相對效能提升。

Conformer 模型下的結論

#Transformer 模型下的結論

#GIC 為 CTC 模型的性能帶來了很大的提升。相對原始的 CTC 模型,GIC 模組大約帶來2M 的額外參數,其中,計算中間層輔助 CTC loss 所使用的線性層與最後一層是共享的,不會帶來額外的參數。多個中間層共享嵌入層,帶來 256*5000 約等於 1.3M 的參數。此外,多個控制門單元所需的額外參數量為256*256*2*k,總計約0.6M。

領先科技造就先進業務

#論文中的 GIC 已經應用在了網易易盾的內容審核業務中。

作為網易智企旗下一站式數位內容風控品牌,易盾長期專注於數位內容安全風控和反垃圾訊息的技術研發與創新。其中,針對以聲音作為載體的數位內容,易盾提供了多種音訊內容審核引擎,包括歌曲、廣播、電視節目、直播等各種類型的音訊內容,及時偵測並過濾含有敏感、違規、低俗,廣告內容的語音,進而減少不良內容的社會影響,營造良好的網路環境。

針對有具體語義內容的音頻,易盾透過語音辨識技術將音訊檔案中的語音內容轉寫為文字內容,再利用偵測模組分析和處理文本,從而實現對音頻內容的自動化審核和過濾。 因此,語音辨識的準確率與音訊內容的審核效率和準確性是息息相關的,會直接影響客戶開展業務的安全與穩定。

論文中的 GIC 在內容審核中的應用取得了顯著的效果提升。 在實際的應用過程中,需要調試的超參數有兩個,分別是多任務學習係數 lambda 和中間層層數 k。在18 層編碼器結構中我們發現 k=5,lambda=0.5 有較好的實驗效果。接著,我們會從這個設定開始嘗試,不斷微調以確定最優的超參數。

?

幕後英雄:網易智企易盾 AI Lab

#這不是易盾 AI Lab 團隊第一次獲得這樣規格的榮譽。

作為網易智企下設的始終走在人工智慧研究前沿的技術團隊,易盾AI Lab 致力於圍繞精細化、輕量化、敏捷化打造全面嚴謹、安全可信的AI 技術能力,不斷提升數位內容風控服務水準。在這之前,團隊曾獲得多項 AI 演算法競賽冠軍及重要獎勵榮譽:

2019 第一屆中國人工智慧大賽 旗幟辨識賽道最高級 A 級證書

2020 年第二屆中國人工智慧大賽 視訊深度偽造偵測賽道最高級 A 級證書

2021 年第三屆中國人工智慧大賽 視訊深度偽造偵測與音訊深度偽造偵測賽道兩項最高級 A 級證書

2021 年中國人工智慧產業發展聯盟「創新之星」、「創新人物」

2021 年第十六屆全國人機語音通訊學術會議(NCMMSC2021)「長短視訊多語言多模態辨識競賽」—漢語長短視訊直播語音關鍵字(VKW)雙賽道冠軍

2021 年獲得浙江省政府頒發的科學技術進步獎第一名

2022 年ICPR 多模態字幕識別比賽(Multimodal Subtitle Recognition, 簡稱MSR 競賽,國內首個多模態字幕識別大賽)賽道三“融合視覺和音頻的多模態字幕識別系統”冠軍

未來已來,AI 的 iPhone 時刻已至。易盾今天成功進入了語音學的學術殿堂,而在未來,科技將為業務的各個方面帶來成就與進步,而易盾將一直陪伴您左右。

以上是網易易盾 AI Lab 論文入選 ICASSP 2023!黑科技讓語音辨識越「聽」越準的詳細內容。更多資訊請關注PHP中文網其他相關文章!

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!Mar 20, 2025 pm 03:34 PM

我嘗試了使用光標AI編碼的Vibe編碼,這太神奇了!Mar 20, 2025 pm 03:34 PMVibe編碼通過讓我們使用自然語言而不是無盡的代碼行創建應用程序來重塑軟件開發的世界。受Andrej Karpathy等有遠見的人的啟發,這種創新的方法使Dev

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!Mar 22, 2025 am 10:58 AM

2025年2月的Genai推出前5名:GPT-4.5,Grok-3等!Mar 22, 2025 am 10:58 AM2025年2月,Generative AI又是一個改變遊戲規則的月份,為我們帶來了一些最令人期待的模型升級和開創性的新功能。從Xai的Grok 3和Anthropic的Claude 3.7十四行詩到Openai的G

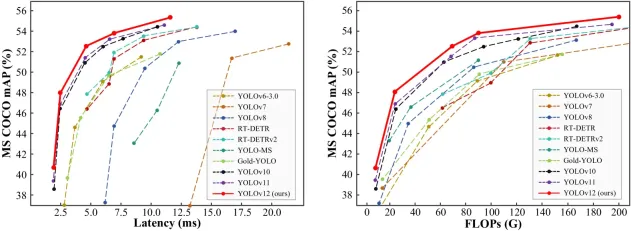

如何使用Yolo V12進行對象檢測?Mar 22, 2025 am 11:07 AM

如何使用Yolo V12進行對象檢測?Mar 22, 2025 am 11:07 AMYolo(您只看一次)一直是領先的實時對象檢測框架,每次迭代都在以前的版本上改善。最新版本Yolo V12引入了進步,可顯著提高準確性

Sora vs veo 2:哪個創建更現實的視頻?Mar 10, 2025 pm 12:22 PM

Sora vs veo 2:哪個創建更現實的視頻?Mar 10, 2025 pm 12:22 PMGoogle的VEO 2和Openai的Sora:哪個AI視頻發電機佔據了至尊? 這兩個平台都產生了令人印象深刻的AI視頻,但它們的優勢在於不同的領域。 使用各種提示,這種比較揭示了哪種工具最適合您的需求。 t

Google的Gencast:Gencast Mini Demo的天氣預報Mar 16, 2025 pm 01:46 PM

Google的Gencast:Gencast Mini Demo的天氣預報Mar 16, 2025 pm 01:46 PMGoogle DeepMind的Gencast:天氣預報的革命性AI 天氣預報經歷了巨大的轉變,從基本觀察到復雜的AI驅動預測。 Google DeepMind的Gencast,開創性

Chatgpt 4 o可用嗎?Mar 28, 2025 pm 05:29 PM

Chatgpt 4 o可用嗎?Mar 28, 2025 pm 05:29 PMChatgpt 4當前可用並廣泛使用,與諸如ChatGpt 3.5(例如ChatGpt 3.5)相比,在理解上下文和產生連貫的響應方面取得了重大改進。未來的發展可能包括更多個性化的間

哪個AI比Chatgpt更好?Mar 18, 2025 pm 06:05 PM

哪個AI比Chatgpt更好?Mar 18, 2025 pm 06:05 PM本文討論了AI模型超過Chatgpt,例如Lamda,Llama和Grok,突出了它們在準確性,理解和行業影響方面的優勢。(159個字符)

O1 vs GPT-4O:OpenAI的新型號比GPT-4O好嗎?Mar 16, 2025 am 11:47 AM

O1 vs GPT-4O:OpenAI的新型號比GPT-4O好嗎?Mar 16, 2025 am 11:47 AMOpenai的O1:為期12天的禮物狂歡始於他們迄今為止最強大的模型 12月的到來帶來了全球放緩,世界某些地區的雪花放緩,但Openai才剛剛開始。 山姆·奧特曼(Sam Altman)和他的團隊正在推出12天的禮物前

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver CS6

視覺化網頁開發工具

MantisBT

Mantis是一個易於部署的基於Web的缺陷追蹤工具,用於幫助產品缺陷追蹤。它需要PHP、MySQL和一個Web伺服器。請查看我們的演示和託管服務。

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

記事本++7.3.1

好用且免費的程式碼編輯器

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中