深度強化學習(Deep Reinforcement Learning)是一種結合了深度學習和強化學習的先進技術,被廣泛應用於語音辨識、影像辨識、自然語言處理等領域。 Go 語言作為一門快速、有效率、可靠的程式語言,可以為深度強化學習研究提供幫助。本文將介紹如何使用 Go 語言進行深度強化學習研究。

一、安裝 Go 語言和相關函式庫

在開始使用 Go 語言進行深度強化學習研究前,需要安裝 Go 語言和相關函式庫。具體步驟如下:

- 安裝 Go 語言。 Go 語言官網提供了適用於各種系統的安裝套件和原始碼,可以在 https://golang.org/ 下載安裝。

- 安裝 Go 語言的深度學習庫。目前,Go 語言的深度學習庫主要有 GoCV、Gorgonia 等。這些庫可以在 Github 上取得,具體使用方法可參考對應文件。

- 安裝 Go 語言的強化學習庫。目前,Go 語言中較受歡迎的強化學習庫有 Golang-rl、GoAI 和 Goml 等。這些庫也可以在 Github 上取得,具體使用方法可參考對應文件。

二、建構深度強化學習模型

在使用 Go 語言進行深度強化學習研究前,需要先建構一個深度強化學習模型。透過查閱相關文獻和程式碼,我們可以得到一個簡單的深度 Q 網路(Deep Q Network,簡稱 DQN)模型的程式碼實作。

type DQN struct {

// 神经网络的参数

weights [][][][]float64

// 模型的超参数

batch_size int

gamma float64

epsilon float64

epsilon_min float64

epsilon_decay float64

learning_rate float64

learning_rate_min float64

learning_rate_decay float64

}

func (dqn *DQN) Train(env Environment, episodes int) {

for e := 0; e < episodes; e++ {

state := env.Reset()

for {

// 选择一个行动

action := dqn.SelectAction(state)

// 执行该行动

next_state, reward, done := env.Step(action)

// 将元组(记忆)存入经验回放缓冲区

dqn.ReplayBuffer.Add(state, action, reward, next_state, done)

// 从经验回放缓冲区中采样一批元组

experiences := dqn.ReplayBuffer.Sample(dqn.BatchSize)

// 用这批元组来训练神经网络

dqn.Update(experiences)

// 更新状态

state = next_state

// 判断是否终止

if done {

break

}

}

// 调整超参数

dqn.AdjustHyperparameters()

}

}

func (dqn *DQN) Update(experiences []Experience) {

// 计算目标 Q 值

targets := make([][]float64, dqn.BatchSize)

for i, e := range experiences {

target := make([]float64, len(dqn.weights[len(dqn.weights)-1][0]))

copy(target, dqn.Predict(e.State))

if e.Done {

target[e.Action] = e.Reward

} else {

max_q := dqn.Predict(e.NextState)

target[e.Action] = e.Reward + dqn.Gamma*max_q

}

targets[i] = target

}

// 计算 Q 值的梯度

grads := dqn.Backpropagate(experiences, targets)

// 根据梯度更新神经网络的参数

for i, grad := range grads {

for j, g := range grad {

for k, gg := range g {

dqn.weights[i][j][k] -= dqn.LearningRate * gg

}

}

}

}

func (dqn *DQN) Predict(state []float64) []float64 {

input := state

for i, w := range dqn.weights {

output := make([]float64, len(w[0]))

for j, ww := range w {

dot := 0.0

for k, val := range ww {

dot += val * input[k]

}

output[j] = relu(dot)

}

input = output

if i != len(dqn.weights)-1 {

input = append(input, bias)

}

}

return input

}以上程式碼實現了一個簡單的DQN 訓練過程,包括選擇行動、執行行動、更新經驗回放緩衝區、從經驗回放緩衝區採樣一批元組、計算目標Q 值、計算梯度、更新神經網路等過程。其中,選擇行動和執行行動的過程需要依託於環境(Environment),而從經驗回放緩衝區採樣一批元組、計算目標 Q 值、計算梯度等過程是針對單一智能體操作的。需要注意的是,上述程式碼實現的 DQN 為單一智能體操作,而大多數深度強化學習問題都是多個智能體協作或競爭的,因此需要在此基礎上進行改進。

三、改進深度強化學習模型

改進深度強化學習模型的方法有很多,這裡介紹幾個常見的方法:

- 策略梯度(Policy Gradient)方法。策略梯度方法直接對策略進行學習,即不是透過最佳化 Q 值來引導智能體進行決策,而是直接優化策略。在策略梯度方法中,通常會採用梯度上升法對策略進行更新。

- 多智能體強化學習(Multi-Agent Reinforcement Learning,簡稱 MARL)方法。在多智能體強化學習方法中,有多個智能體協作或競爭,因此需要考慮智能體之間的互動。常見的多智能體強化學習演算法包括:Cooperative Q-Learning、Nash Q-Learning、Independent Q-Learning 等。其中,Cooperative Q-Learning 演算法考慮所有智能體的 Q 值,並將其組合成一個聯合 Q 值,然後將聯合 Q 值作為每個智能體的目標 Q 值進行更新。

- 分散式強化學習(Distributed Reinforcement Learning)方法。在分散式增強學習方法中,使用多個智能體同時學習一個強化學習任務。每個智能體都有一部分經驗,然後將這些經驗進行匯總並迭代更新模型。

四、總結

本文介紹如何使用Go 語言進行深度強化學習研究,包括安裝Go 語言和相關函式庫、建立深度強化學習模型、改進深度強化學習模型等。使用 Go 語言進行深度強化學習研究,可以利用其快速、高效和可靠的特點,提高研究效率和準確性。雖然深度強化學習方法在當前已經取得了巨大的成功,但仍存在許多需要解決的問題和挑戰。因此,我們有必要不斷探索其更深入的應用和發展。

以上是如何使用 Go 語言進行深度強化學習研究?的詳細內容。更多資訊請關注PHP中文網其他相關文章!

人工智能(AI)、机器学习(ML)和深度学习(DL):有什么区别?Apr 12, 2023 pm 01:25 PM

人工智能(AI)、机器学习(ML)和深度学习(DL):有什么区别?Apr 12, 2023 pm 01:25 PM人工智能Artificial Intelligence(AI)、机器学习Machine Learning(ML)和深度学习Deep Learning(DL)通常可以互换使用。但是,它们并不完全相同。人工智能是最广泛的概念,它赋予机器模仿人类行为的能力。机器学习是将人工智能应用到系统或机器中,帮助其自我学习和不断改进。最后,深度学习使用复杂的算法和深度神经网络来重复训练特定的模型或模式。让我们看看每个术语的演变和历程,以更好地理解人工智能、机器学习和深度学习实际指的是什么。人工智能自过去 70 多

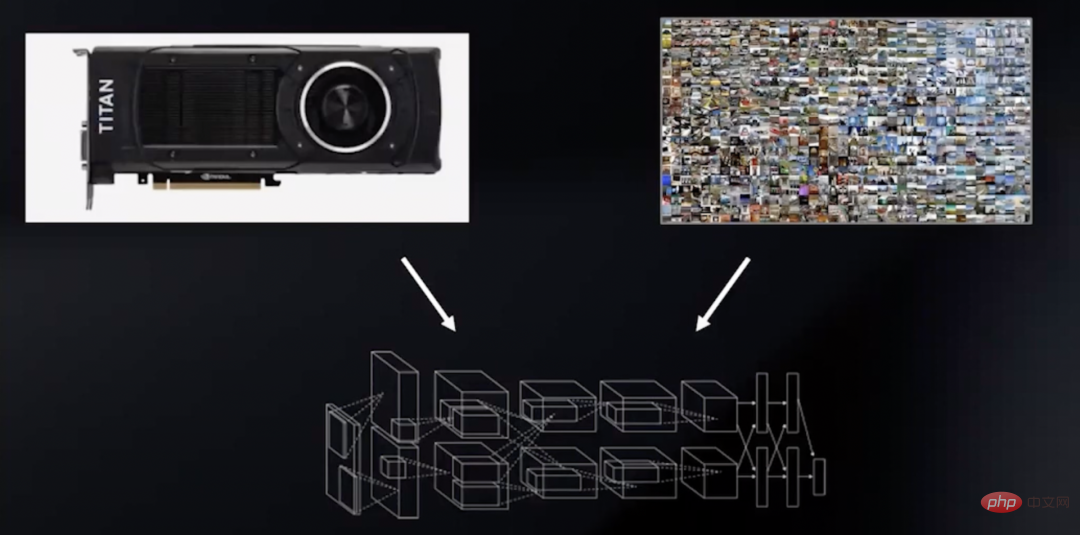

深度学习GPU选购指南:哪款显卡配得上我的炼丹炉?Apr 12, 2023 pm 04:31 PM

深度学习GPU选购指南:哪款显卡配得上我的炼丹炉?Apr 12, 2023 pm 04:31 PM众所周知,在处理深度学习和神经网络任务时,最好使用GPU而不是CPU来处理,因为在神经网络方面,即使是一个比较低端的GPU,性能也会胜过CPU。深度学习是一个对计算有着大量需求的领域,从一定程度上来说,GPU的选择将从根本上决定深度学习的体验。但问题来了,如何选购合适的GPU也是件头疼烧脑的事。怎么避免踩雷,如何做出性价比高的选择?曾经拿到过斯坦福、UCL、CMU、NYU、UW 博士 offer、目前在华盛顿大学读博的知名评测博主Tim Dettmers就针对深度学习领域需要怎样的GPU,结合自

字节跳动模型大规模部署实战Apr 12, 2023 pm 08:31 PM

字节跳动模型大规模部署实战Apr 12, 2023 pm 08:31 PM一. 背景介绍在字节跳动,基于深度学习的应用遍地开花,工程师关注模型效果的同时也需要关注线上服务一致性和性能,早期这通常需要算法专家和工程专家分工合作并紧密配合来完成,这种模式存在比较高的 diff 排查验证等成本。随着 PyTorch/TensorFlow 框架的流行,深度学习模型训练和在线推理完成了统一,开发者仅需要关注具体算法逻辑,调用框架的 Python API 完成训练验证过程即可,之后模型可以很方便的序列化导出,并由统一的高性能 C++ 引擎完成推理工作。提升了开发者训练到部署的体验

基于深度学习的Deepfake检测综述Apr 12, 2023 pm 06:04 PM

基于深度学习的Deepfake检测综述Apr 12, 2023 pm 06:04 PM深度学习 (DL) 已成为计算机科学中最具影响力的领域之一,直接影响着当今人类生活和社会。与历史上所有其他技术创新一样,深度学习也被用于一些违法的行为。Deepfakes 就是这样一种深度学习应用,在过去的几年里已经进行了数百项研究,发明和优化各种使用 AI 的 Deepfake 检测,本文主要就是讨论如何对 Deepfake 进行检测。为了应对Deepfake,已经开发出了深度学习方法以及机器学习(非深度学习)方法来检测 。深度学习模型需要考虑大量参数,因此需要大量数据来训练此类模型。这正是

地址标准化服务AI深度学习模型推理优化实践Apr 11, 2023 pm 07:28 PM

地址标准化服务AI深度学习模型推理优化实践Apr 11, 2023 pm 07:28 PM导读深度学习已在面向自然语言处理等领域的实际业务场景中广泛落地,对它的推理性能优化成为了部署环节中重要的一环。推理性能的提升:一方面,可以充分发挥部署硬件的能力,降低用户响应时间,同时节省成本;另一方面,可以在保持响应时间不变的前提下,使用结构更为复杂的深度学习模型,进而提升业务精度指标。本文针对地址标准化服务中的深度学习模型开展了推理性能优化工作。通过高性能算子、量化、编译优化等优化手段,在精度指标不降低的前提下,AI模型的模型端到端推理速度最高可获得了4.11倍的提升。1. 模型推理性能优化

聊聊实时通信中的AI降噪技术Apr 12, 2023 pm 01:07 PM

聊聊实时通信中的AI降噪技术Apr 12, 2023 pm 01:07 PMPart 01 概述 在实时音视频通信场景,麦克风采集用户语音的同时会采集大量环境噪声,传统降噪算法仅对平稳噪声(如电扇风声、白噪声、电路底噪等)有一定效果,对非平稳的瞬态噪声(如餐厅嘈杂噪声、地铁环境噪声、家庭厨房噪声等)降噪效果较差,严重影响用户的通话体验。针对泛家庭、办公等复杂场景中的上百种非平稳噪声问题,融合通信系统部生态赋能团队自主研发基于GRU模型的AI音频降噪技术,并通过算法和工程优化,将降噪模型尺寸从2.4MB压缩至82KB,运行内存降低约65%;计算复杂度从约186Mflop

深度学习撞墙?LeCun与Marcus到底谁捅了马蜂窝Apr 09, 2023 am 09:41 AM

深度学习撞墙?LeCun与Marcus到底谁捅了马蜂窝Apr 09, 2023 am 09:41 AM今天的主角,是一对AI界相爱相杀的老冤家:Yann LeCun和Gary Marcus在正式讲述这一次的「新仇」之前,我们先来回顾一下,两位大神的「旧恨」。LeCun与Marcus之争Facebook首席人工智能科学家和纽约大学教授,2018年图灵奖(Turing Award)得主杨立昆(Yann LeCun)在NOEMA杂志发表文章,回应此前Gary Marcus对AI与深度学习的评论。此前,Marcus在杂志Nautilus中发文,称深度学习已经「无法前进」Marcus此人,属于是看热闹的不

英伟达首席科学家:深度学习硬件的过去、现在和未来Apr 12, 2023 pm 03:07 PM

英伟达首席科学家:深度学习硬件的过去、现在和未来Apr 12, 2023 pm 03:07 PM过去十年是深度学习的“黄金十年”,它彻底改变了人类的工作和娱乐方式,并且广泛应用到医疗、教育、产品设计等各行各业,而这一切离不开计算硬件的进步,特别是GPU的革新。 深度学习技术的成功实现取决于三大要素:第一是算法。20世纪80年代甚至更早就提出了大多数深度学习算法如深度神经网络、卷积神经网络、反向传播算法和随机梯度下降等。 第二是数据集。训练神经网络的数据集必须足够大,才能使神经网络的性能优于其他技术。直至21世纪初,诸如Pascal和ImageNet等大数据集才得以现世。 第三是硬件。只有

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境