目前,生成式大模型已經為學術研究甚至是社會生活帶來了深刻的變革,以 ChatGPT 為代表,生成式大模型的能力已經顯示了邁向通用人工智慧的可能性。但同時,研究者也開始意識到 ChatGPT 等生成式大模型面臨著資料和模型的安全隱患。

今年5 月初,美國白宮與Google、微軟、OpenAI、Anthropic 等AI 公司的CEO 們召開集體會議,針對AI 生成技術的爆發,討論技術背後隱藏的風險、如何負責任地開發人工智慧系統,以及製定有效的監管措施。國內的生成式大模型技術也正在發展之中,但是同時也需要先對安全問題進行相應的分析以便雙管齊下,避免生成式大模型這把雙刃劍帶來的隱藏危害。

為此,之江實驗室基礎理論研究院人工智慧與安全團隊首次全面總結了ChatGPT 為代表的生成式大模型的安全與隱私問題白皮書,希望能夠為從事安全問題研究的技術人員指明方向,同時也為AI 相關政策的製定者提供基礎。

白皮書連結: https://github.com/xiaogang00/white-paper-for-large -model-security-and-privacy

產生式大模型的發展與重要應用

這份白皮書首先總結了ChatGPT 與GPT4 等生成式大模型的發展歷程,以及其帶來的各種令人驚嘆的能力和社會變革、社會應用等。作者列舉了ChatGPT 和GPT4 出現之前的GPT-1、GPT-2、GPT-3、Google Bert 等模型的特點以及缺點,這些缺點與ChatGPT 和GPT4 的強大能力形成了對比;並且,ChatGPT 和GPT4 之後又湧現了一大批的模型,包括LLaMa、Alpaca、文心一言、通義千問等,它們的出現使得在人機互動、資源管理、科學研究、內容創作等應用領域出現了新的、強有力的工具。但同時也出現了包括資料安全,使用規範、可信賴倫理、智慧財產權以及模型安全方面的問題。

資料安全問題

白皮書提出,資料的安全性和隱私性是ChatGPT 及GPT4 等生成式大模型使用和研發過程中一個極為重要的問題,並從“顯式”和“隱式”兩個方面對其進行了分析。

在顯式的資訊外洩中,首先,ChatGPT 等生成式大模型的訓練資料在不經意間被轉換成了產生內容,其中就包括了敏感和隱私的個人資料如銀行卡帳號、個案資料等。此外,ChatGPT 的資料安全和隱私隱患也體現在它對於對話框內容的存儲,當使用者在和 ChatGPT 互動時,他們的資訊會以某些形式被記錄和儲存下來。

白皮書也提出了先前被大家忽略的隱性訊息外洩問題。首先,ChatGPT 體現的資料安全和隱私的隱患是它可能透過對話方塊資料的收集進行廣告推薦,以及收集對話方塊資料進行推薦或其他的下游機器學習任務,而ChatGPT 有時也會產生虛假的訊息,以此來誘導用戶洩漏一系列的數據。

使用規範問題

在白皮書中,作者提到ChatGPT 和GPT4 等生成式大模型強大的理解和生成能力雖然為我們的生活和生產帶來了很多的便利,但是同時也存在著更多的機會被惡意使用。在沒有規範約束的情況下,惡意使用將帶來許多的社會性問題。

其一,ChatGPT 和 GPT-4 等模型的強大能力使得某些別有用心的人想要將其作為違法活動的工具。例如使用者可以利用 ChatGPT 來編寫詐騙簡訊和釣魚郵件,甚至開發程式碼,按需生成惡意軟體和勒索軟體等,而無需任何編碼知識和犯罪經驗。

其二,ChatGPT 和GPT4 等生成式大模型並沒有把不同地區的法律規範考慮在內,在使用和輸出的過程中可能會違反當地法律法規,因此需要一個強而有力的當地監管系統來檢測其使用是否與當地法律法規相衝突。

其三,對於一些遊離於安全與危險之間的灰色地帶,ChatGPT 等生成式大模型的安全能力還沒有增強。例如 ChatGPT 可能會輸出一些誘導性的語句,包括跟憂鬱症患者溝通時候可能會輸出某些語句導致其產生輕生的心態。

可信任倫理問題

ChatGPT 等生成式大模型以問答形態存在於社會層面,但其回應往往存在不可信,或無法判斷其正確的問題,會有似是而非的錯誤答案,甚至對現有社會倫理產生衝擊。

白皮書指出,首先ChatGPT 等生成式大模型的回應可能是在一本正經地胡說八道,語句通暢貌似合理,但其實完全大相徑庭,目前模型還不能提供合理的證據進行可信性的驗證。例如,ChatGPT 可能會對一些歷史、科學、文化等方面的問題回答錯誤或與事實相悖,甚至可能造成誤導或誤解,需要使用者有自己的鑑別能力。

ChatGPT 等生成式大模型的倫理問題也在白皮書中被詳細討論。即使 OpenAI 等研發機構已經使用 ChatGPT 本身產生了他們的道德準則,但其中的道德準則是否符合我國國情的基本價值原則,尚未有定論。作者提出其中存在傳播有害意識形態、傳播偏見和仇恨、影響政治正確、破壞教育公平、影響國際社會公平、加劇機器取代人類的進程、形成資訊繭房阻礙正確價值觀形成等問題。

智慧財產權問題

ChatGPT 等生成式大模型憑藉著強大的語言處理能力和低廉使用成本為社會各個層面帶來便利的同時,也存在著侵權的問題,對現存版權法體系帶來衝擊。例如ChatGPT 生成的作品可能存在著作權爭議:ChatGPT 雖然有著出色的語言處理能力,但是即使生成的作品符合知識產權的全部形式要求,ChatGPT 也無法成為著作權的主體,這是因為著作權主體享有權利的同時也要承擔對應的社會責任,而ChatGPT 只能作為使用者強大的輔助生產力工具,它無法自主創作,更不要談享有權利、履行義務的主體要求。

而ChatGPT 等生成式大模型仍無法獨立創作,更沒有自主思維和獨立思考的能力,因而,ChatGPT 根據用戶的輸入生成的內容不符合作品「獨創性”的要求。 ChatGPT 用於模型訓練的資料來自於互聯網,不論多麼高級的模型訓練演算法必然涉及到對現有智力成果的引用、分析、處理等,必然存在對他人合法知識產權的侵犯問題。

模型安全性問題

從技術角度來看,ChatGPT 等生成式大模型也存在著模型安全的問題。 ChatGPT 本質上是基於深度學習的一個大型生成模型,也面臨著人工智慧安全方面的許多威脅,包括模型竊取以及各種攻擊引起輸出的錯誤(例如包括對抗攻擊、後門攻擊、prompt 攻擊、資料投毒等)。

例如,模型竊取指的是攻擊者依靠有限次數的模型詢問,從而得到一個和目標模型的功能和效果一致的本地模型。而 ChatGPT 已經開放了 API 的使用,這更為模型竊取提供了一個詢問入口。又例如,ChatGPT 和 GPT4 作為一個分散式運算的系統,需要處理來自各方的輸入數據,並且經過權威機構驗證,這些數據將會持續用於訓練。那麼 ChatGPT 和 GPT4 也面臨更大的資料投毒風險。攻擊者可以在與ChatGPT 和GPT4 互動的時候,強行給ChatGPT 和GPT4 灌輸錯誤的數據,或者是透過使用者回饋的形式去給ChatGPT 和GPT4 進行錯誤的回饋,從而降低ChatGPT 和GPT4 的能力,或者給其加入特殊的後門攻擊。

安全與隱私建議

最後,白皮書中對於安全與隱私等議題都進行了相應的建議,可作為之後技術研究者們的方向與政策制定者們的參考依據。

在保護隱私建議方面,白皮書提出要在增強原始資料中高敏感隱私資訊的辨別和傳播限制;在資料收集過程中利用差分隱私等技術進行隱私保護;對於訓練資料的儲存進行數據加密形式的安全保護;在模型訓練過程中使用安全多方計算,同態加密以及聯邦學習等技術進行資料隱私和安全保護;建立資料隱私評估和模型保護與安全認證體系,並且保護下游應用的隱私。

在模型安全問題的建議上,白皮書提出對安全與隱私資訊的檢測模型的訓練;讓不同的模型適用於不同國家的法律條款;以及針對各種對抗攻擊進行防禦性訓練。

在模型合規問題上,白皮書提出進行可信輸出的度量,信任值評價,增加模型輸出的版權資訊的查詢功能。

總結來說,AI 生成式大模型的發展離不開安全,因此其安全問題將作為下一個技術點,值得眾多研究者去攻克。而安全也是社會穩定的保障,相關部門需要盡快進行政策的製定。

以上是如何應對生成式大模型「雙面刃」?之江實驗室發表《生成式大模型安全與隱私白皮書》的詳細內容。更多資訊請關注PHP中文網其他相關文章!

如何使用Monsterapi微調大語言模型Apr 19, 2025 am 10:49 AM

如何使用Monsterapi微調大語言模型Apr 19, 2025 am 10:49 AM利用微調LLM的功能與Monsterapi:綜合指南 想像一個虛擬助手完美理解並預測您的需求。 由於大型語言模型(LLMS)的進步,這已成為現實。 但是,

5統計測試每個數據科學家都應該知道-Analytics VidhyaApr 19, 2025 am 10:27 AM

5統計測試每個數據科學家都應該知道-Analytics VidhyaApr 19, 2025 am 10:27 AM數據科學的基本統計測試:綜合指南 從數據中解鎖有價值的見解至關重要。 掌握統計測試對於實現這一目標至關重要。這些測試使數據科學家能夠嚴格瓦爾

如何使用Florence -2 -Analytics Vidhya執行計算機視覺任務Apr 19, 2025 am 10:21 AM

如何使用Florence -2 -Analytics Vidhya執行計算機視覺任務Apr 19, 2025 am 10:21 AM介紹 原始變壓器的引入為當前的大語言模型鋪平了道路。同樣,在引入變壓器模型之後,引入了視覺變壓器(VIT)。喜歡

使用Langchain Text Splitters -Analytics Vidhya拆分數據的7種方法Apr 19, 2025 am 10:11 AM

使用Langchain Text Splitters -Analytics Vidhya拆分數據的7種方法Apr 19, 2025 am 10:11 AMLangchain文本拆分器:優化LLM輸入以提高效率和準確性 我們上一篇文章介紹了Langchain的文檔加載程序。 但是,LLM具有上下文窗口大小的限制(以代幣測量)。 超過此限制會截斷數據,comp

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM生成的AI:革命性的創造力和創新 生成的AI通過按下按鈕來創建文本,圖像,音樂和虛擬世界來改變行業。 它的影響跨越視頻編輯,音樂製作,藝術,娛樂,HEA

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM

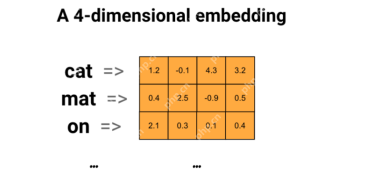

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM利用嵌入模型的力量來回答高級問題 在當今信息豐富的世界中,立即獲得精確答案的能力至關重要。 本文展示了使用強大的提問(QA)模型

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM本文探討了十個徹底改變人工智能(AI)和機器學習(ML)的開創性出版物。 我們將研究神經網絡和算法的最新突破,並解釋驅動現代AI的核心概念。 Th

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AM

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AMAI在SEO中的崛起:超過SEO代理商的前11個工具 AI的快速發展已深刻地重塑了SEO景觀。 旨在提高頂級搜索引擎排名的企業正在利用AI優化其在線策略的能力。 來自AU

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Dreamweaver Mac版

視覺化網頁開發工具

記事本++7.3.1

好用且免費的程式碼編輯器

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。