南科大黑科技:一鍵消除視訊人物,特效師的救星來了!

- PHPz轉載

- 2023-05-25 14:56:29862瀏覽

來自南方科技大學的這款視訊分割模型,可以追蹤影片中的任何事物。

不僅會“看”,還會“剪”,從影片中去掉個人,對它來說也是輕輕鬆鬆的事。

而操作上,你唯一需要做的就是點幾下滑鼠。

這位特效藝術家看到消息後彷彿找到了救星,直言這個產品將改變CGI產業的遊戲規則。

這款模型叫做TAM(Track Anything Model),是不是跟Meta的圖像分割模型SAM名字很像?

的確,TAM是將SAM擴展到了視訊領域,點亮了動態物件追蹤的技能樹。

視訊分割模型其實不是新技術了,但傳統的分割模型並沒有減輕人類的工作。

這些模型所使用的訓練資料全部需要人工標註,甚至在使用時還需要先用特定物體的遮罩參數進行初始化。

SAM的出現為解決這個問題提供了前提-至少初始化資料不再需要手動取得。

當然,TAM也不是逐幀使用SAM再疊加,還需要建立對應的時空關係。

團隊將SAM與名為XMem的記憶模組進行了整合。

只需要在第一幀中用SAM產生初始參數,XMem便可以指導接下來的追蹤過程。

追蹤的目標還可以是很多個,例如下面的清明上河圖:

甚至場景改變,也不影響TAM的表現:

我們體驗了一番發現,TAM採用了互動式使用者介面,操作上十分簡單友善。

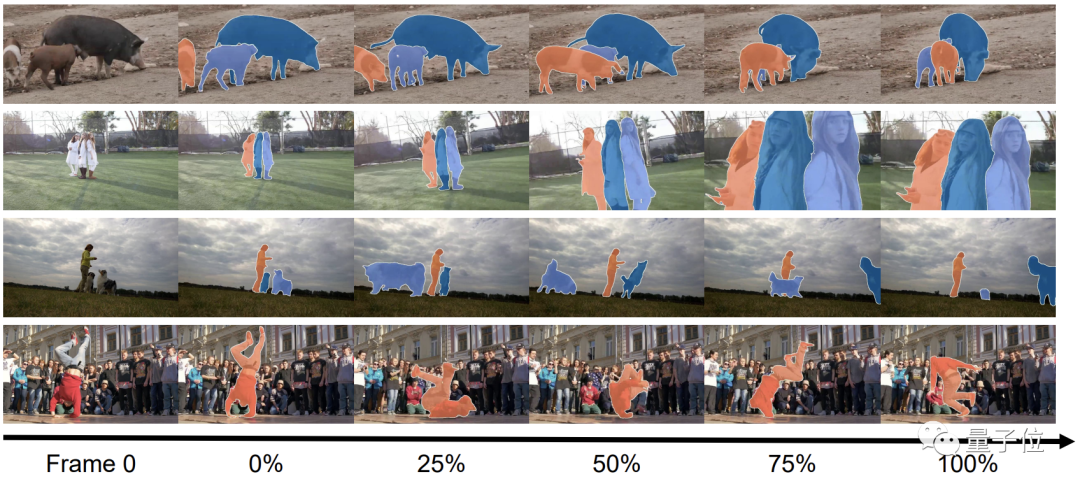

硬實力方面,TAM的追蹤效果的確也不錯:

但是,消除功能在某些細節上的精確度還有待提升。

從SAM到TAM

#前文已經提到,TAM是在SAM的基礎之上結合記憶能力建立時空關聯實現的。

具體而言,第一步是藉助SAM的靜態影像分割能力對模型進行初始化。

只需一次點擊,SAM就能產生目標物體的初始化遮罩參數,取代了傳統分割模型中的複雜初始化過程。

有了初始參數,團隊就可以將它交給XMem,進行半人工幹預訓練,大幅減少了人類工作量。

在這過程中,會有一些手動預測結果被用來和XMem的輸出進行比較。

實際過程中,隨著時間的成長,得到準確的分割結果對XMem變得越來越困難。

當結果與預期差距過大時,將進入再分割環節,這一步驟還是由SAM完成。

經過SAM的再最佳化,大部分輸出結果已比較準確,但仍有一部分需要手動再調整。

TAM的訓練過程大致就是這樣,而開頭提到的物體消除的技能是TAM與E2FGVI結合形成的。

E2FGVI本身也是一個視訊元素消除工具,在TAM精準分割的加持下,其工作更有的放矢。

為了測試TAM,團隊使用了DAVIS-16和DAVIS-17資料集對其進行了評估。

直覺感受還是很不錯的,從數據上看也的確如此。

TAM雖然無需手動設定遮罩參數,但其J(區域相似度)和F(邊界準確度)兩項指標已十分接近手工模型。

甚至在DAVIS-2017資料集上的表現還略勝於其中的STM。

其他初始化方式中,SiamMask的表現根本無法和TAM相提並論;

#另一種名為MiVOS方法雖然表現好於TAM,但畢竟已經進化了8輪…

團隊簡介

TAM來自南方科技大學視覺智慧與感知(VIP)實驗室。

此實驗室研究方向包括文字-圖像-聲音多模型學習、多模型感知、強化學習和視覺缺陷檢測等。

目前團隊已發表論文30餘篇,取得專利5項。

團隊領導人是南方科技大學鄭鋒副教授,博士畢業於英國謝菲爾德大學,先後任職於中科院深研院、騰訊優圖等機構,於2018年進入南科大,2021年晉升為副教授。

論文網址:

https://arxiv.org/abs/2304.11968

GitHub頁面:

https://github.com/gaomingqi/Track-Anything

參考連結:

https://twitter.com/bilawalsidhu/status/1650710123399233536 ?s=20

以上是南科大黑科技:一鍵消除視訊人物,特效師的救星來了!的詳細內容。更多資訊請關注PHP中文網其他相關文章!