3.6兆token、3400億參數,Google大模型PaLM 2細節曝光

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-05-21 08:07:20970瀏覽

上週四,在2023 谷歌I/O 大會上,GoogleCEO 皮查伊宣布推出對標GPT-4 的大模型PaLM 2,並正式發布預覽版本,改進了數學、程式碼、推理、多語言翻譯和自然語言生成能力。

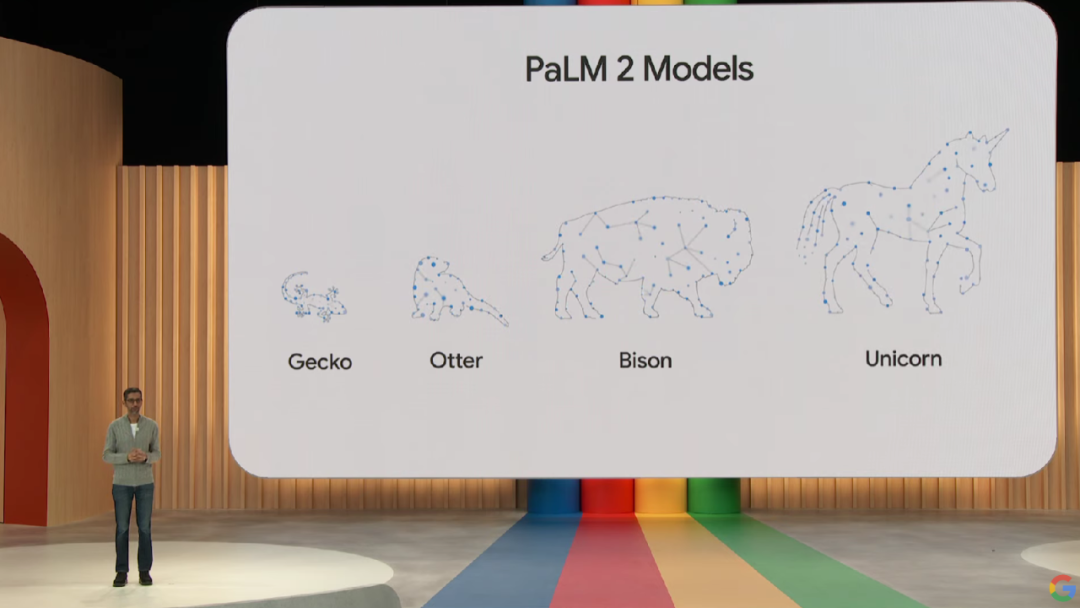

#PaLM 2 模型提供了不同尺寸規模的四個版本,從小到大依次為Gecko、Otter、Bison 和Unicorn,更易於針對各種用例進行部署。其中輕量級的 Gecko 模型可以在行動裝置上運行,速度非常快,不聯網也能在裝置上運行出色的互動式應用程式。

不過會上,Google並沒有給出有關 PaLM 2 的具體技術細節,只說明了它是建構在Google最新 JAX 和 TPU v4 之上。

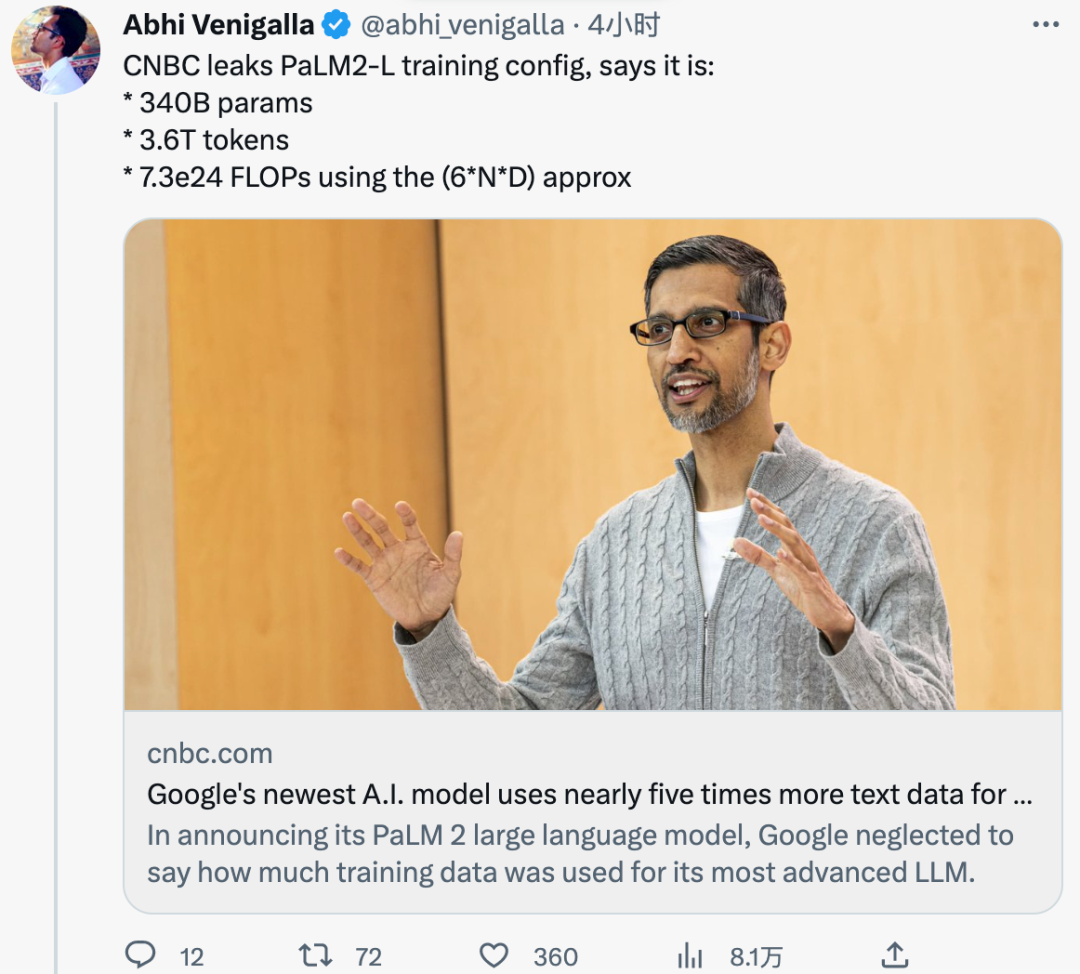

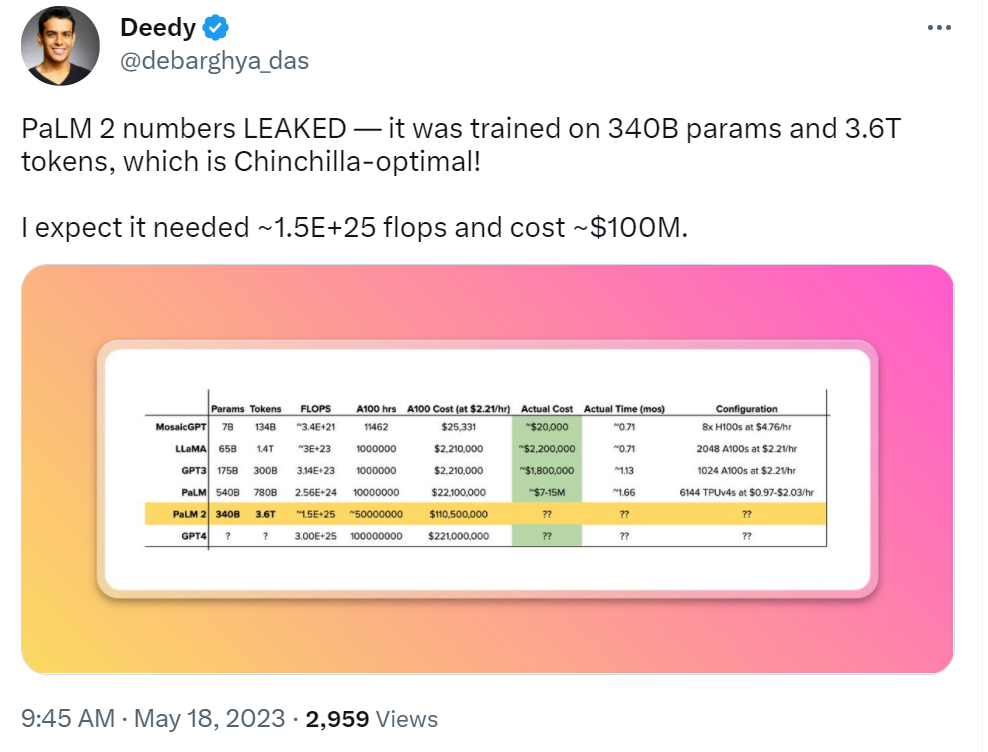

昨日,據外媒CNBC 看到的內部文件稱,PaLM 2 是在3.6 兆個token 上訓練。作為對比,上代 PaLM 接受了 7,800 億 token 的訓練。

此外,Google先前表示 PaLM 2 比以前的 LLM 規模更小,這意味著在完成更複雜任務的同時變得更有效率。這一點也在內部文件中得到了驗證,PaLM 2 的訓練參數量為 3,400 億,遠小於 PaLM 的 5,400 億。

PaLM 2 的訓練 token 和參數量與其他家的 LLM 相比如何?作為對比,Meta 在 2 月發布的 LLaMA 接受了 1.4 兆 token 的訓練。 OpenAI 1750 億參數的 GPT-3 是在 3000 億 token 上訓練的。

雖然Google一直渴望展示其AI 技術的強大能力以及如何嵌入到搜尋、電子郵件、文件處理和電子表格中,但也不願公佈其訓練資料的大小或其他細節。其實這樣做的不只谷歌一家,OpenAI 也緘口不言其最新多模態大模型 GPT-4 的細節。他們都表示不揭露細節是源自於業務的競爭屬性。

不過,隨著 AI 軍備競賽的持續升溫,研究界也越來越要求提高透明度。並且在前段時間洩露的一份谷歌內部文件中,谷歌內部研究人員表達了這樣一種觀點:雖然表面看起來OpenAI 和谷歌在AI 大模型上你追我趕,但真正的贏家未必會從這兩家中產生,因為第三方力量「開源」正在悄悄崛起。

目前,這份內部文件的真實性尚未得到驗證,Google也並未對相關內容置評。

網友評論

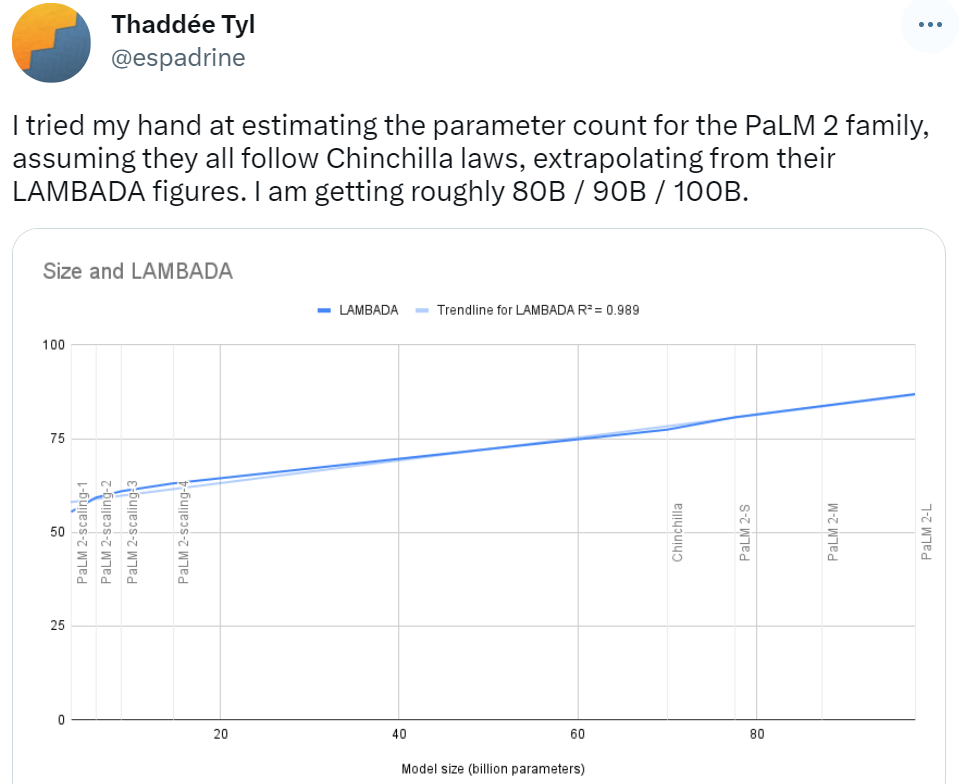

在官宣PaLM 2 之初,就有網友根據Chinchilla 定律預測其參數量,ta 預測PaLM 2 模型家族的參數結果為80B / 90B / 100B 不等,和這次爆料的340B 還是差距很大的。

也有人對PaLM 2 的訓練成本進行了一波預測,根據歷代大模型的發展來看,這位網友表示,打造PaLM 2 需要耗資1 億美元。

PaLM 2 參數都洩密了,可以試著推測Bard 了,這位網友表示:

隨著 PaLM 2 token 數的洩露,網友不禁疑問,在 AGI 到來之前,多少 token 才能迎來一次大轉折?

以上是3.6兆token、3400億參數,Google大模型PaLM 2細節曝光的詳細內容。更多資訊請關注PHP中文網其他相關文章!