只要和ChatGPT聊聊天,它就能幫你呼叫10萬個HuggingFace模型!

這是抱抱臉最新上線的功能HuggingFace Transformers Agents,一推出就獲得極大關注:

<code>from transformers import OpenAiAgentagent = OpenAiAgent(model="text-davinci-003", api_key="<your_api_key>")</your_api_key></code>也可以用BigCode或OpenAssistant等免費大模型:

<code>from huggingface_hub import loginlogin("<your_token>")</your_token></code>然後,設定Hugging Transformers Agents。這裡我們以預設的Agent為例:

<code>from transformers import HfAgent# Starcoderagent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoder")# StarcoderBase# agent = HfAgent("https://api-inference.huggingface.co/models/bigcode/starcoderbase")# OpenAssistant# agent = HfAgent(url_endpoint="https://api-inference.huggingface.co/models/OpenAssistant/oasst-sft-4-pythia-12b-epoch-3.5")</code>然後,您可以使用指令run()或chat()來執行Transformers Agents。 run()適合同時呼叫多個AI模型,執行比較複雜專業的任務。 可以呼叫單一AI工具。 例如執行agent.run(“Draw me a picture of rivers and lakes.”),它就能呼叫AI文生圖工具幫你產生一張圖片:

已設定一套預設AI模型

目前,Transformers Agents已經整合了一套預設AI模型,透過呼叫以下Transformer函式庫中的AI模型來完成:

1、視覺文件理解模型Donut。只要提供一個圖片格式的檔案(包括PDF轉換成的圖片),就能利用它來回答有關該文件的問題。

例如問“TRRF科學諮詢委員會會議將在哪裡舉行”,Donut就會給出答案:

2、文字問答模型Flan-T5。給定長文章和一個問題,它就能回答各種文字問題,幫你做閱讀理解。

3、零樣本視覺語言模型BLIP。它可以直接理解圖像中的內容,並對圖像進行文字說明。

4、多模態模型ViLT。它可以理解並回答給定圖像中的問題,

5、多模態圖像分割模型CLIPseg。只要提供一個模型和提示詞,系統就能根據提示詞分割出影像中指定的內容(mask)。

6、自動語音辨識模型Whisper。它可以自動辨識一段錄音中的文字,並完成轉錄。

7、語音合成模型SpeechT5。用於文字轉語音。

8、自編碼語言模型BART。除了可以自動將一段文字內容分類,還能做文字摘要。

9、200種語言翻譯模型NLLB。除了常見語言外,還能翻譯一些較不常見的語言,包括寮語和卡姆巴語等。

透過呼叫上面這些AI模型,包括圖像問答、文件理解、圖像分割、錄音轉文字、翻譯、起標題、文字轉語音、文字分類在內的任務都可以完成。

除此之外,抱抱臉還“夾帶私貨”,包含了一些Transformer庫以外的模型,包括從網頁下載文字、文生圖、圖生圖、文生影片:

這些模型不僅能單獨調用,還可以混合在一起使用,例如要求大模型“生成並描述一張好看的海狸照片”,它就會分別呼叫「文生圖」和「圖片理解」AI模型。

當然,如果我們不想用這些預設AI模型,想設定一套更好用的“工具整合包”,也可以依照步驟自行設定。

對於Transformers Agents,也有網友指出,有點像是LangChain agents的「平替」:

你試過這兩個工具了嗎?感覺哪個比較好用?

參考連結:[1]https://twitter.com/huggingface/status/1656334778407297027[2]https://huggingface.co/docs/transformers/transformers_agents

#以上是讓ChatGPT調用10萬+開源AI模型! HuggingFace新功能爆火:大模型可隨取隨用多模態AI工具的詳細內容。更多資訊請關注PHP中文網其他相關文章!

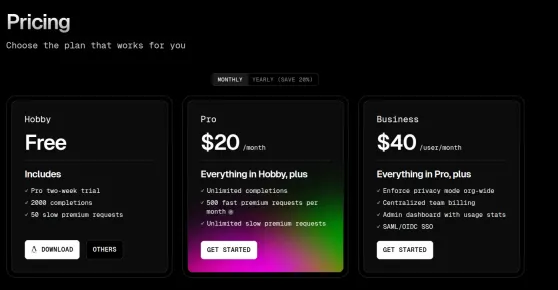

2025年的前5個代碼編輯器的Vibe代碼編輯器Apr 24, 2025 am 09:31 AM

2025年的前5個代碼編輯器的Vibe代碼編輯器Apr 24, 2025 am 09:31 AM革新軟件開發:深入研究AI代碼編輯器 厭倦了無休止的編碼,不斷的表切換和令人沮喪的故障排除? 編碼的未來就在這裡,並且由AI提供支持。 AI代碼編輯了解您的項目F

5個作業AI可以根據比爾·蓋茨(Bill Gates)替換Apr 24, 2025 am 09:26 AM

5個作業AI可以根據比爾·蓋茨(Bill Gates)替換Apr 24, 2025 am 09:26 AM比爾·蓋茨最近做客吉米·法倫的《今夜秀》,談到了他的新書《源代碼》、童年以及微軟50年的歷程。但談話中最引人注目的是關於未來,特別是人工智能的興起及其對我們工作的影響。蓋茨以充滿希望卻又誠實的方式分享了他的想法。他認為人工智能將以我們意想不到的速度徹底改變世界,並談到了在不久的將來人工智能無法取代的工作。讓我們一起來看看這些工作。 目錄 充裕智能的新時代 解決醫療和教育領域的全球短缺問題 人工智能會取代工作嗎?蓋茨說:對某些工作來說,會的 人工智能(目前)無法取代的工作:人情味依然重要 結語

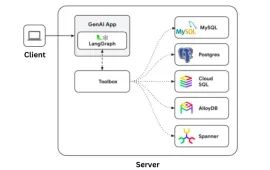

Google Gen AI工具箱:SQL數據庫的Python庫Apr 24, 2025 am 09:23 AM

Google Gen AI工具箱:SQL數據庫的Python庫Apr 24, 2025 am 09:23 AMGoogle的Gen AI工具箱用於數據庫:革新數據庫與自然語言的互動 Google已公佈了數據庫的Gen Gen AI工具箱,該工具箱是一個革命性的開源Python庫,旨在使用Natura簡化數據庫交互

Openai的GPT 4O圖像生成非常酷Apr 24, 2025 am 09:21 AM

Openai的GPT 4O圖像生成非常酷Apr 24, 2025 am 09:21 AMOpenai的Chatgpt現在擁有本地圖像生成:改變遊戲規則的人 Chatgpt的最新更新通過GPT-4O支持的本地圖像生成引入了技術世界。 山姆·奧特曼本人稱其為“之一

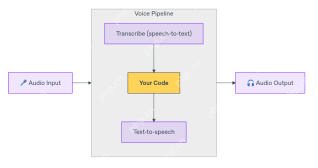

如何使用OpenAI Agent SDK構建多語言語音代理? - 分析VidhyaApr 24, 2025 am 09:16 AM

如何使用OpenAI Agent SDK構建多語言語音代理? - 分析VidhyaApr 24, 2025 am 09:16 AMOpenAI的Adent SDK現在提供了語音代理功能,徹底改變了智能,實時,語音驅動的應用程序的創建。 這使開發人員能夠建立諸如語言教師,虛擬助手和支持BO之類的交互式體驗

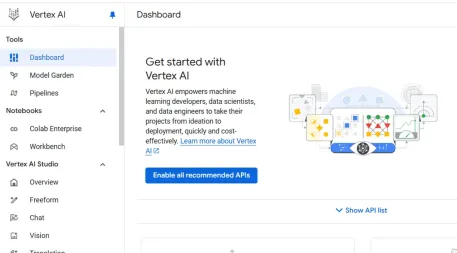

用頂點AI構建張量流管道Apr 24, 2025 am 09:15 AM

用頂點AI構建張量流管道Apr 24, 2025 am 09:15 AM使用TensorFlow數據集API和Vertex AI Workbench掌握數據管道:綜合指南 有效的數據處理至關重要。本指南提供了逐步構建強大數據管道USIN的逐步演練

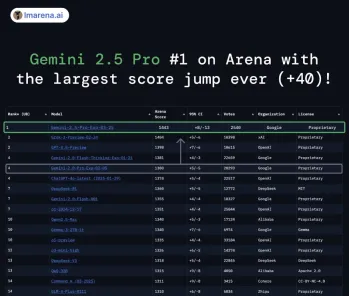

Gemini 2.5 Pro現在在聊天機器人競技場上排名第一,令人印象深刻Apr 24, 2025 am 09:13 AM

Gemini 2.5 Pro現在在聊天機器人競技場上排名第一,令人印象深刻Apr 24, 2025 am 09:13 AMGoogle DeepMind的雙子座2.5 Pro:AI的新領導者 Google DeepMind的最新AI模型Gemini 2.5 Pro在競技場排行榜上佔據了上位,超過了競爭對手Grok-3,而GPT-4.5則獲得了創紀錄的40分。 這個重要的Lea

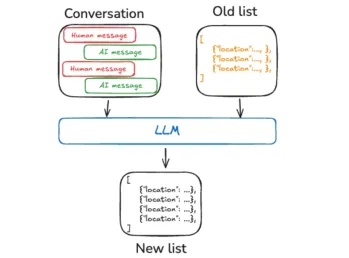

Langmem SDK:個性化具有語義記憶的AI代理Apr 24, 2025 am 09:12 AM

Langmem SDK:個性化具有語義記憶的AI代理Apr 24, 2025 am 09:12 AM人工智能代理商經常努力保留過去的對話中的信息,阻礙他們的學習和適應能力。 本文探討了Langmem SDK是如何通過提供長期記憶來解決此限制的如何解決此限制的

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

Dreamweaver CS6

視覺化網頁開發工具

WebStorm Mac版

好用的JavaScript開發工具

ZendStudio 13.5.1 Mac

強大的PHP整合開發環境

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)