英偉達發表ChatGPT專用GPU,推理速度提升了10倍

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-05-13 23:04:041326瀏覽

曾何幾時,人工智慧因為算力不足進入了長達數十年的瓶頸,GPU 點燃了深度學習。在 ChatGPT 時代,AI 因為大模型再次面臨算力不足的問題,這次英偉達還有辦法嗎?

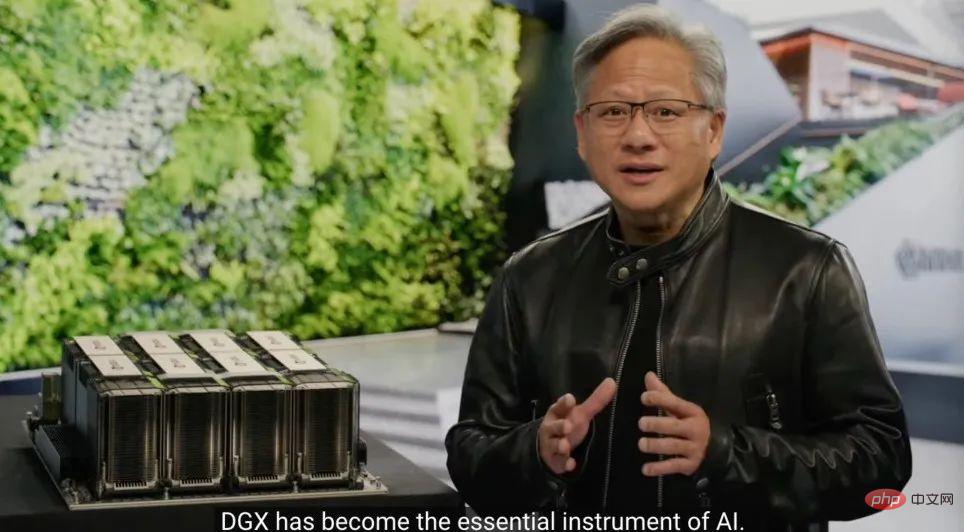

3 月 22 日,GTC 大會正式召開,在剛剛進行的 Keynote 上,英偉達 CEO 黃仁勳搬出了為 ChatGPT 準備的晶片。

「加速運算並非易事,2012 年,電腦視覺模型AlexNet 動用了GeForce GTX 580,每秒可處理262 PetaFLOPS。該模型引發了AI 技術的爆炸,」黃仁勳說道。 「十年後,Transformer 出現了,GPT-3 動用了323 ZettaFLOPS 的算力,是AlexNet 的100 萬倍,創造了ChatGPT 這個震驚全世界的AI。嶄新的計算平台出現了,AI 的iPhone 時代已經來臨」

AI 的繁榮推動英偉達股價在今年上漲了77%,目前,英偉達的市值為6,400 億美元,已是英特爾的近五倍。不過今天的發佈告訴我們,英偉達的腳步還沒停。

為AIGC 設計專用算力

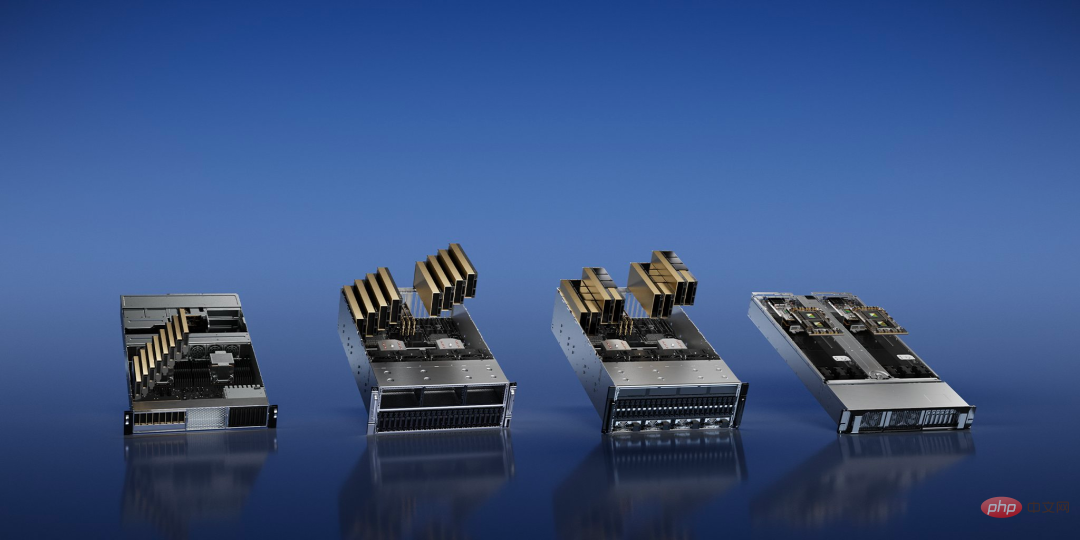

生成式AI(AIGC )的發展正在改變科技公司對於算力的需求,英偉達一次展示了四種針對AI任務的推理平台,它們都使用了統一的架構。

其中,NVIDIA L4 提供「比CPU 高120 倍的AI 驅動視頻性能,以及99% 的能源效率」,可以用於視頻串流、編碼和解碼以及生成AI 視訊等工作;算力更強的NVIDIA L40 則專門用於2D/3D 影像生成。

針對算力需求龐大的ChatGPT,英偉達發布了NVIDIA H100 NVL,這是一種具有94GB 記憶體和加速Transformer Engine 的大語言模型(LLM)專用解決方案,配備了雙GPU NVLINK 的PCIE H100 GPU。

「目前唯一可以實際處理ChatGPT 的GPU 是英偉達HGX A100。與前者相比,現在一台搭載四對H100 和雙NVLINK的標準伺服器速度能快10 倍,可以將大語言模型的處理成本降低一個數量級,」黃仁勳說。

最後還有 NVIDIA Grace Hopper for Recommendation Models,除了推薦任務優化之外,它還可以為圖形神經網路和向量資料庫提供動力。

讓晶片突破物理極限

目前,半導體的生產製程已逼近物理學所能達到的極限。 2nm 製程之後,突破點又是什麼?英偉達決定從晶片製造的最原始階段 —— 光刻入手。

從根本上來說,這是一個物理極限下的成像問題。在先進製程下,晶片上的許多特徵會小於列印過程中使用的光的波長,掩模的設計必須不斷進行修改,這一步驟稱為光學鄰近校正。計算光刻模擬了光透過原件與光阻相互作用時的行為,這些行為是根據麥克斯韋方程式描述的,這是晶片設計製造領域中需要算力最多的任務。

黃仁勳在 GTC 上宣布了一項名為 CuLitho 的新技術,以加快半導體的設計和製造。該軟體使用英偉達晶片來加速基於軟體的晶片設計,並加速用於在晶片上列印該設計的光刻掩模的物理製造之間的步驟。

CuLitho 在 GPU 上運行,其效能比目前的光刻技術提高了 40 倍,可以加速目前每年消耗數百億個 CPU 小時的大規模運算工作負載。 「造 H100 需要 89 塊掩膜版,在 CPU 上運算時一塊就得算兩個星期,但如果用 H100 在 CuLitho 上運行就只需要 8 個小時,」黃仁勳說道。

這意味著500 個英偉達DGX H100 系統就能夠取代4 萬個CPU 系統的工作,並運行計算光刻製程的所有部分,幫助減少電力需求和對環境的潛在影響。

這項進展將使晶片的電晶體和電路比現在尺寸更小,同時加快了晶片的上市時間,並提高為推動製造過程而全天候運行的大規模資料中心的能源效率。

英偉達表示,它正在與 ASML、Synopsys 和台積電合作,將該技術推向市場。據介紹,台積電將在 6 月開始準備此技術的試產。

「晶片產業是世界上幾乎所有其他產業的基礎,」黃仁勳表示。 「由於光刻技術已處於物理學的極限,透過CuLitho 以及與我們的合作夥伴台積電、ASML 和Synopsys 的合作,晶圓廠能夠提高產量,減少碳足跡,並為2nm 及以後的發展奠定基礎。」

首個GPU 加速的量子運算系統

在今天的活動中,英偉達也宣布了一個使用Quantum Machines 建構的新系統,該系統為從事高性能和低延遲量子經典計算的研究人員提供了一個革命性的新架構。

作為全球首個GPU 加速的量子運算系統,NVIDIA DGX Quantum 將全球最強大的加速運算平台(由NVIDIA Grace Hopper 超級晶片和CUDA Quantum 開源程式設計模型實現)與全球最先進的量子控制平台OPX(由Quantum Machines 提供)相結合。這種組合使研究人員能夠建立空前強大的應用,將量子計算與最先進的經典計算相結合,實現校準、控制、量子糾錯和混合演算法。

DGX Quantum 的核心是一個由 PCIe 連接到 Quantum Machines OPX 的 NVIDIA Grace Hopper 系統,實現了 GPU 和量子處理單元(QPU)之間的亞微秒延遲。

英偉達公司HPC 和量子主管Tim Costa 表示:「量子加速的超級計算有可能重塑科學和工業,英偉達DGX Quantum 將使研究人員能夠突破量子- 經典計算的界限。」

對此,英偉達將高性能的Hopper 架構GPU 與該公司的新Grace CPU 整合為“Grace Hopper”,為巨型AI 和HPC 應用提供了超強的動力。它為運行 TB 級數據的應用提供了高達 10 倍的性能,為量子 - 經典研究人員解決世界上最複雜的問題提供了更多動力。

DGX Quantum 也為開發者配備了英偉達 CUDA Quantum,這是一個強大的統一軟體棧,現在已經開放了原始碼了。 CUDA Quantum 是一個混合型量子 - 經典運算平台,能夠在一個系統中整合和編程 QPU、GPU 和 CPU。

每月3.7 萬美元,網頁上訓練自己的ChatGPT

微軟斥資數億美元購買了數萬塊A100 構建了GPT 專用超算,你現在可能會想要租用OpenAI 和微軟訓練ChatGPT 和必應搜尋相同的GPU 來訓練自己的大模型。

英偉達提出的DGX Cloud 提供了專用的NVIDIA DGX AI 超級運算集群,搭配NVIDIA AI 軟體,該服務使每個企業都可以使用簡單的網路瀏覽器存取AI 超算,消除了取得、部署和管理本地基礎架構的複雜性。

據介紹,每個 DGX Cloud 執行個體都有八個 H100 或 A100 80GB Tensor Core GPU,每個節點共有 640GB GPU 記憶體。使用 NVIDIA Networking 建構的高效能、低延遲結構確保工作負載可以跨互連系統叢集擴展,允許多個實例充當一個巨大的 GPU,以滿足高級 AI 訓練的效能要求。

現在,企業可以按月租用 DGX Cloud 集群,快速輕鬆地擴展大型多節點訓練工作負載的開發,而無需等待通常需求量很大的加速計算資源。

而月租的價格,根據黃仁勳介紹,每個實例每月 36999 美元起。

「我們正處於人工智慧的iPhone 時刻,」黃仁勳表示:「新創公司競相打造了顛覆性產品和商業模式,而現有企業也在尋求回應。DGX Cloud 讓客戶即時存取全球規模的雲端中的NVIDIA AI 超級運算。」

#為了幫助企業迎接生成式AI 的浪潮,英偉達同時宣布了一系列雲端服務,讓企業能夠建構、改進客製化的大型語言模型和生成式AI 模型。

現在,人們可以使用NVIDIA NeMo 語言服務和NVIDIA Picasso 圖像、視訊和3D 服務來建立專有的、特定領域的生成式AI 應用程序,用於智慧對話和客戶支援、專業內容創建、數位模擬等。另外,英偉達也宣布了 NVIDIA BioNeMo 生物雲服務的新模式。

「生成式AI 是一種新型計算機,可以用人類的自然語言進行程式設計。這種能力影響深遠—— 每個人都可以命令計算機來解決問題,而此前不久,這還是程式設計師的專利,」黃仁勳說。

從今天的發佈內容看來,英偉達不僅正在針對科技公司的 AI 負載不斷改進硬體設計,也在提出新的商業模式。在一些人看來,英偉達是想做「AI 領域的台積電」:像晶圓廠一樣提供先進生產力代工服務,幫助其他公司在其之上訓練各自特定場景的 AI 演算法。

用英偉達的超算訓練,直接省去中間商賺差價,會是未來 AI 發展的方向嗎?

以上是英偉達發表ChatGPT專用GPU,推理速度提升了10倍的詳細內容。更多資訊請關注PHP中文網其他相關文章!