AI文字翻譯系統品質提升44%,利用超500億參數翻譯200種語言

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-05-12 23:46:041947瀏覽

Meta Platforms今天開放了NLLB-200的系統程式碼,NLLB-200是Meta內部開發的一個人工智慧系統,可以翻譯200種語言的文字。

Meta也發表了一套工具,旨在幫助研究人員更輕鬆地將NLLB-200應用於軟體專案。

根據Meta的說法,NLLB-200可以理解的200種語言中,許多語言都沒有得到其他AI翻譯系統的良好支持。目前被廣泛使用的翻譯工具支援的非洲語言不到25種,而NLLB-200 支援多達55種非洲語言。

Meta表示,翻譯準確性是NLLB-200優於其他工具的另一個面向。 Meta採用的是BLEU評估系統的準確性標準,BLEU是一種用於衡量機器翻譯文字品質的演算法。 Meta稱,NLLB-200的BLEU評分比前平均高出44%。

Meta執行長Mark Zuckerberg表示:「我們剛剛開源了一個自主開發的AI模型,該模型可以翻譯200種不同的語言——其中許多語言未得到當前翻譯系統的支持。我們把這個計畫稱之為No Language Left Behind,我們使用的人工智慧建模技術正在為全球數十億人所使用的語言進行高品質的翻譯。」

NLLB-200有超過500億個參數,這些配置決定了AI系統處理資料的方式。人工智慧系統參數越多,準確性就越高。

NLLB-200具有如此大量的參數,並不是它能夠以高精度支援200種語言的唯一因素,因為NLLB-200系統也藉鑒了Meta工程師開發的許多其他AI創新。

Meta使用內部開發的LASER工具包為機器學習相關研究提供支援。研究人員使用該工具包可以對神經網路進行訓練,以一種語言執行某個特定的任務,然後相對輕鬆地使神經網路適應其他語言,這對於翻譯這一用途來說是很有用處的。 Meta開發了新的NLLB-200系統,支援改良版LASER—LASER3。

LASER的原始版本包括一個名為LSTM的神經網絡,這是一個將文字轉換為AI系統可以理解的、以數學方式表示的專用元件。這種數學表示有助於產生更準確的翻譯結果。在LASER3中,Meta用Transformer取代了LSTM神經網絡,前者是一種高階自然語言處理模型,可以更有效地執行相同的任務。

Meta還使用了其他幾種方法來改進NLLB-200的功能,例如Meta升級了用於收集訓練資料的系統,並對AI訓練工作流程進行了更改。

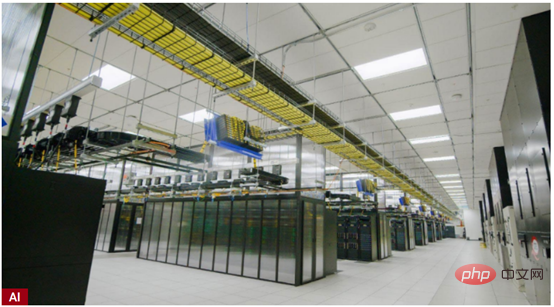

Meta使用內部開發的Research SuperCluster超級電腦(如圖)來訓練NLLB-200。今年1月Meta首次介紹Research SuperCluster的時候稱,該系統配備了6080個Nvidia最新的A100資料中心GPU,最終將升級到配置16,000個GPU。

Meta計畫使用NLLB-200在Facebook、Instagram和其他平台上提供更好的自動翻譯功能,預計該系統每天將支援超過250億次翻譯。

Meta在內部努力推廣NLLB-200的同時,也計劃幫助其他企業組織將系統應用到自己的軟體專案中。

除了NLLB-200之外,Meta還開源了可用於訓練AI的程式碼,以及一個名為FLORES-200的資料集,用於評估翻譯的準確性。 Meta將提供高達200000美元的資金,以幫助非營利組織採用NLLB-200。除此之外,Meta也將與Wikimedia Foundation展開合作,將自動翻譯技術應用於維基百科文章。

以上是AI文字翻譯系統品質提升44%,利用超500億參數翻譯200種語言的詳細內容。更多資訊請關注PHP中文網其他相關文章!