GPT-4 開始內測 32000 輸入長度的版本了!你收到邀請了嗎?

- PHPz轉載

- 2023-05-11 09:58:051006瀏覽

夕小瑤科技說 原創

作者 | 小戲、ZenMoore

要說現在 GPT-4 最大的問題是什麼?可能除了一時拿他沒辦法的機器幻覺,就是卡死的輸入長度了吧。儘管在一般的對話、搜尋的場景裡目前普通版本 GPT-4 的 8000 左右的上下文長度或許綽綽有餘,但是在諸如內容生成、智能閱讀等方面當下基礎版的 GPT-4 還是有些捉襟見肘。

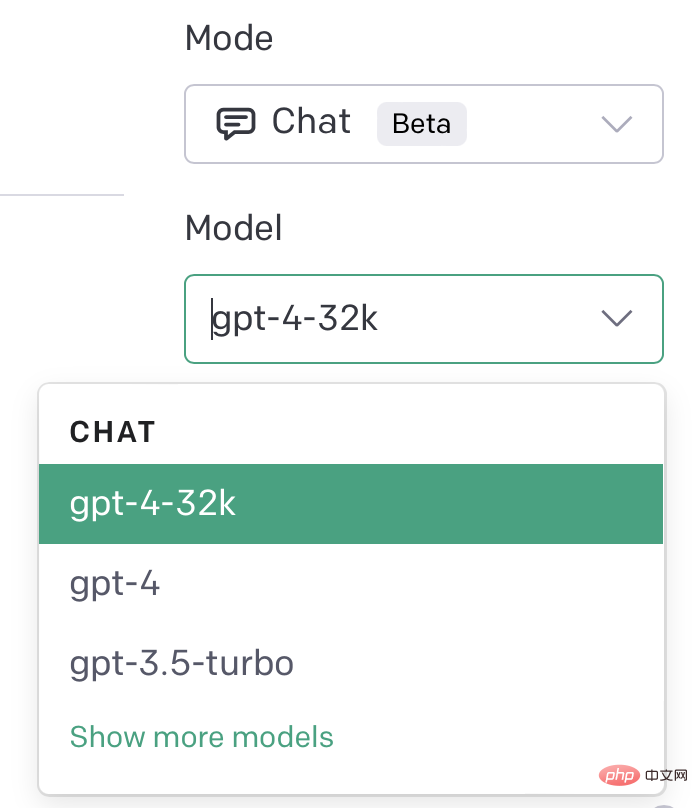

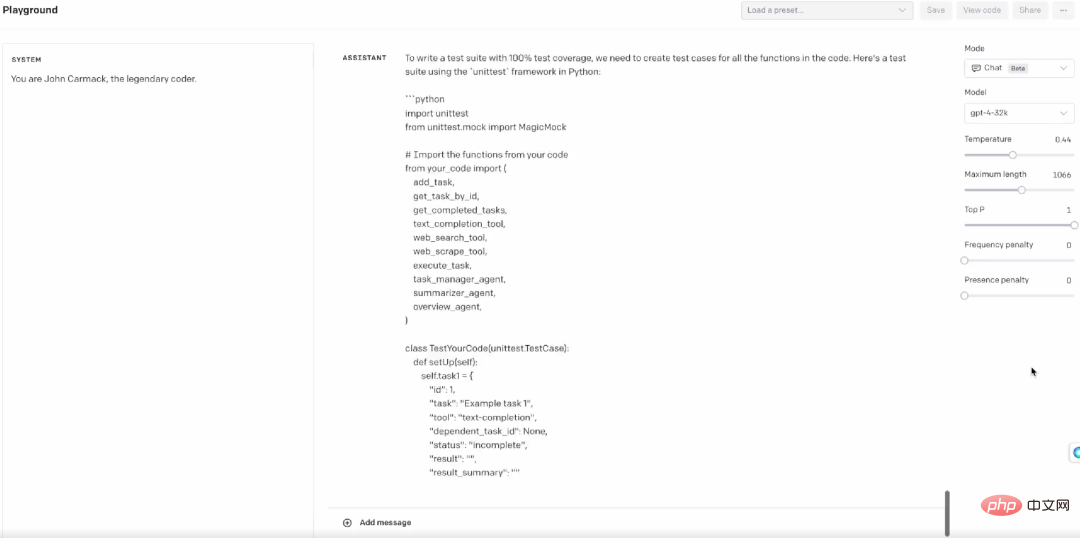

然而在 GPT-4 的發布會裡也談到,事實上 GPT-4 是支援 32768 個 token 長度的,只是暫時還沒有被完全釋放,而是會陸續自動更新。而這兩天,32k GPT-4 的曙光似乎馬上就要來了!不少 GPT-4 的用戶已經可以在自己的 PlayGround 上看到 GPT-4 32k 的選項。

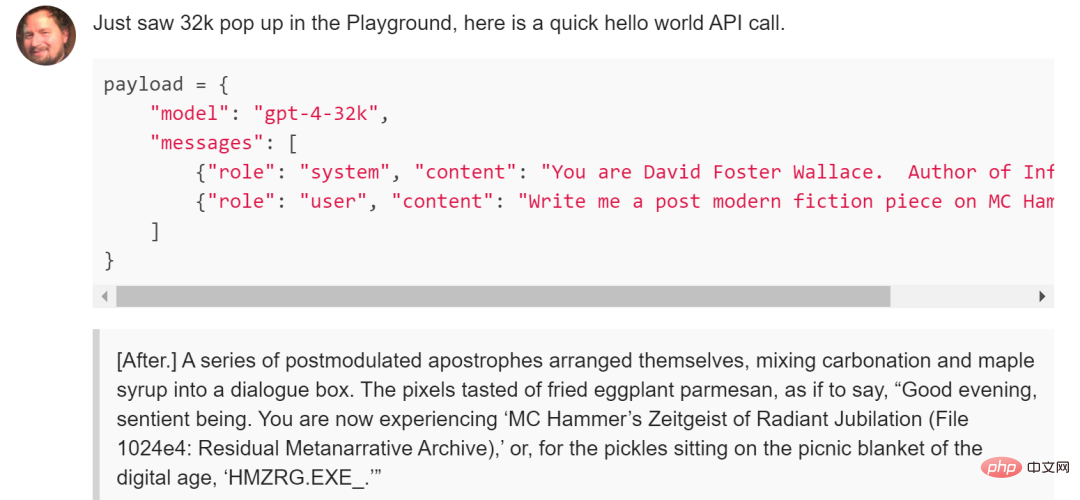

在API 裡,也可以透過指定GPT-4-32K 的Model 來呼叫升級版

但是,這應該仍然是GPT-4 對部分用戶的內測,並且應該不是按申請waitlist 的時間來發佈內測名額,收到32k 版本內測的用戶是在3 月16 日加入的waitlist,但也有同樣時間加入的用戶沒有解鎖32k 的版本。一個可能的原因是收到內測版本的用戶曾經在註冊時強調了對 32k GPT-4 極大的興趣。

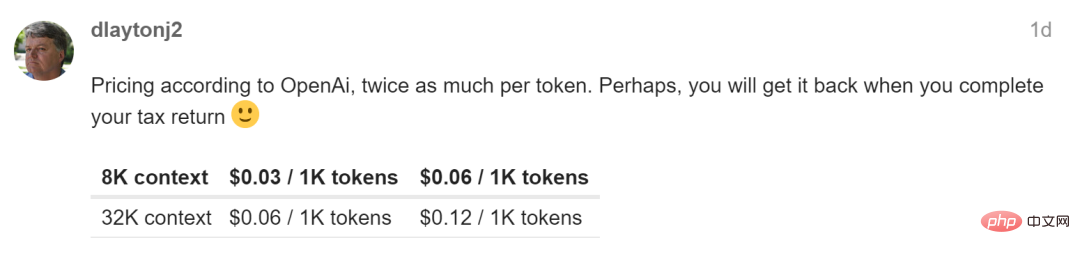

當然,不管怎樣,32k 的GPT-4 看起來確實是離我們越來越近了,那麼32k 的GPT-4 會帶來什麼樣的想像力的改變呢?畢竟它的價格比8k 版本的GPT-4 貴了兩倍,並且有可能會有更慢的回應時間…

一個例子是對話機器人,當上下文長度擴展到50 頁以後,那麼就可以極大的避免例如因為滑出了8k 視窗而帶來的複雜的嵌入問題。又如對如論文、研報等大量複雜資訊的提取與解讀,目前必須透過結構化的方法對資料進行拆分再逐步進行提取,而 32k 的上下文長度則可以一舉省去這些麻煩。再來像是推特部落客Matt Shumer 所做的一個小測試,透過提供給GPT-4 32k 一份程式碼範例,幾秒鐘內它就完成了一套完整的測試案例,這對工程而言也非常具有顛覆性。

在 OpenAI 之外,也有開源模型開放了甚至更大上下文長度的大規模語言模型。這個名為 MPT-7B (也稱為做 Llongboi) 在這個月 5 號發布,這個花費了 20 萬美元訓練的 Llongboi 最大的亮點在於支持 64k 的上下文,可以服務於內容生成、聊天等多種場景。

部落格網址:https://www.php.cn/link/894a200a66c2b57205af564d6883882a

專案連結:https ://www.php.cn/link/18fe8ebf5d52c8992581f439ba783aa3

當然,開源專案的效能及穩定性肯定無法比肩GPT-4,既然已經陸陸續續開始有人收到了32k 的GPT- 4 的邀請,相信它必然很快就會和我們見面,那就讓我們「Hopefully it picks up the pace」吧!

以上是GPT-4 開始內測 32000 輸入長度的版本了!你收到邀請了嗎?的詳細內容。更多資訊請關注PHP中文網其他相關文章!