前幾天,Meta首席人工智慧科學家Yann LeCun的一段對於ChatGPT的點評迅速傳遍圈內外,引發了大波討論。

在Zoom的媒體和高階主管小型聚會上,LeCun給了一段令人驚訝的評價:「就底層科技而言,ChatGPT並不是多麼了不得的創新。」

「雖然在公眾眼中,它是革命性的,但是我們知道,它就是一個組合得很好的產品,僅此而已。」

ChatGPT不算什麼創新

ChatGPT作為這幾個月的聊天機器人「頂流」,早就紅遍全世界,甚至切實改變了一部分人的職業生涯,以及學校教育的現狀。

全世界為它驚嘆的時候,LeCun對ChatGPT的點評居然如此「輕描淡寫」。

但其實,他的言論也不無道理。 像ChatGPT這種數據驅動的人工智慧系統,許多公司和研究型實驗室有。 LeCun表示,OpenAI在這個領域並沒有多麼獨樹一格。 「除了Google和Meta之外,還有六家新創公司,基本上都擁有非常相似的技術。」LeCun 補充道。接著,LeCun小酸了一把-

OpenAI的技術「在基礎科學方面並沒有什麼創新性,它只是設計得很好而已。」

OpenAI的技術「在基礎科學方面並沒有什麼創新性,它只是設計得很好而已。」

「當然啦,我不會為此批評他們。」

我並不是批評OpenAI的工作,也不是在批評他們的主張。

我並不是批評OpenAI的工作,也不是在批評他們的主張。

我是想修正大眾和媒體的看法,他們普遍認為ChatGPT是一種創新且獨特的技術突破,然而事實並非如此。

在紐約時報記者Cade Metz的座談會上,LeCun感受到了好事者的疑問。

「你可能想問,為什麼谷歌和Meta沒有類似的系統呢?我的回答是,如果谷歌和Meta推出這種會胡說八道的聊天機器人,損失會相當慘重。」他笑著說。

無獨有偶,OpenAI被微軟等金主看好、身價飆升至290億美元的新聞一出,馬庫斯也連夜在博客上寫了一篇文章嘲諷。 在文中,馬庫斯爆出一句金句:你OpenAI能做啥谷歌做不到的事,值290億美元天價?

他們製成了一個表,根據公開存取、訓練資料、模型架構和評估方向等細節,對BlenderBot、LaMDA、Sparrow和InstructGPT這些AI聊天機器人進行了比較。

注意:因為ChatGPT沒有記錄,所以他們使用的是InstructGPT的細節,InstructGPT是一個來自OpenAI的指令微調模型,可以被認為是ChatGPT的基礎。

| LaMDA | BlenderBot 3 | Sparrow | ||

| 組織機構 | ##GoogleMeta | DeepMind | #OpenAI | |

| 存取權 | 封閉 | 已公開 | #已封閉 | ### 有限### |

參數規模 |

1370億 |

1750億 | #700億 |

1750億 |

基礎模型 |

未知 |

OPT |

#Chinchilla |

GPT-3.5 |

語料庫規模 |

2.81兆 |

1000億 |

1.4兆 | |

| #存取網路 |

| ✔️###✔️### | ✔️ |

✖️ |

監督微調 |

✔️ |

##✔️ | ✔️ | ##✔️|

| 微調資料規模 | 高品質:6.4K | 安全性:8K | 落地性:4KIR: 49K |

20個NLP資料集,範圍從18K到1.2M |

| ###########12.7K(ChatGPT可能更多)##################RLHF############ ✖️############✖️############✔️############✔️########## ########人工安全規則### | ##✔ | ##✖️##✔ | #✖️ | # |

以上是聚焦Google、Meta、OpenAI的聊天機器人大比拼,ChatGPT讓LeCun不滿成為話題焦點的詳細內容。更多資訊請關注PHP中文網其他相關文章!

DeepSeek V3 vs Llama 4:哪種模型統治至高無上? - 分析VidhyaApr 25, 2025 am 10:27 AM

DeepSeek V3 vs Llama 4:哪種模型統治至高無上? - 分析VidhyaApr 25, 2025 am 10:27 AM在不斷發展的大語言模型的景觀中,DeepSeek V3 vs Llama 4已成為開發人員,研究人員和AI愛好者的最熱門對決之一。無論您是針對燃燒速度的輸液而優化

什麼是開源和開放重量模型?Apr 25, 2025 am 10:19 AM

什麼是開源和開放重量模型?Apr 25, 2025 am 10:19 AMDeepSeek模型和Google的Gemma 3強調了“開放” AI模型開發的增長趨勢,強調了出色的推理能力和輕量級設計。 Openai準備通過即將到來的Quo為這個生態系統做出貢獻

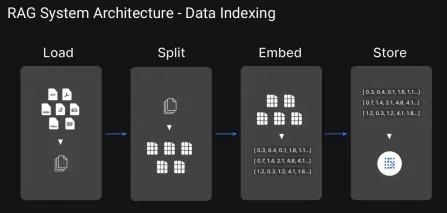

下一個項目的前13個高級抹布技術Apr 25, 2025 am 10:07 AM

下一個項目的前13個高級抹布技術Apr 25, 2025 am 10:07 AMAI可以大規模產生真正相關的答案嗎?我們如何確保它了解複雜的多轉交談?我們如何避免自信地吐出不正確的事實?這些是Mo的挑戰

Llama 4型號:Meta AI正在開放購買最好的! - 分析VidhyaApr 25, 2025 am 10:06 AM

Llama 4型號:Meta AI正在開放購買最好的! - 分析VidhyaApr 25, 2025 am 10:06 AMMeta的Llama 4:開源AI Powerhouses的三重奏 Meta AI通過同時發布了Llama 4 Banner下的三種開創性的大語言模型(LLM),從而破壞了AI景觀:Scout,Maverick和Beamemoth。 這一舉動與SH進行了對比

代理商OPS的十大工具Apr 25, 2025 am 10:05 AM

代理商OPS的十大工具Apr 25, 2025 am 10:05 AM當AI代理承擔更複雜的任務時,簡單地構建它們還不夠。管理他們的績效,可靠性和效率同樣至關重要。這就是代理商操作的來源。它可以幫助組織監視,優化,

7個免費的chatgpt替代品來創建吉卜力風格的圖像Apr 25, 2025 am 09:48 AM

7個免費的chatgpt替代品來創建吉卜力風格的圖像Apr 25, 2025 am 09:48 AM解鎖吉卜力風格的AI藝術的魔力:免費,簡單的方法! AI生成的藝術的最近激增模仿了吉卜力的吉卜力工作室的迷人風格,這吸引了互聯網。 雖然OpenAI的GPT-4O提供了令人印象深刻的功能,但需求量很高。

AI通過圖靈測試:GPT-4.5揭示了未來Apr 25, 2025 am 09:42 AM

AI通過圖靈測試:GPT-4.5揭示了未來Apr 25, 2025 am 09:42 AM這篇博客文章探討了2025年聖地亞哥UC研究的開創性結果,其中高級語言模型(LLMS)(如GPT-4.5)令人信服地通過了現代化的圖靈測試,通常在模仿人類對話的能力方面表現出色的真實人物

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

Atom編輯器mac版下載

最受歡迎的的開源編輯器

禪工作室 13.0.1

強大的PHP整合開發環境