在目前 AI 模型的開發以模型為中心轉向以資料為中心的趨勢下,資料的品質變得尤為重要。

在以往的 AI 開發流程中,資料集通常是固定的,開發工作的重點是迭代模型架構或訓練流程來提高基準效能。而現在,資料迭代成為重心,因此我們需要更系統化的方法來評估、篩選、清洗和註釋用於訓練和測試 AI 模型的資料。

最近,史丹佛大學電腦科學系的Weixin Liang、李飛飛等人在《自然-機器智能》上共同發表了一篇題為“Advances, challenges and opportunities in creating data for trustworthy AI”的文章,在AI 資料全流程的各個環節上討論了保證資料品質的關鍵因素和方法。

論文地址:https://www.nature.com/articles/s42256-022-00516-1.epdf?sharing_token=VPzI-KWAm8tLG_BiXJnV9tRgN0jAjpesWel9jn33Zo570FcCAjpesWwIAFkjpesWel90R30ZoCrCA0FAjpesWcIAFWk c6XO1tdlvV1lLJQtOvUFnSXpvW6_nu0Knc_dRekx6lyZNc6PcM1nslocIcut_qNW9OUg1IsbCfuL058R4MsYFqyzlb2E=

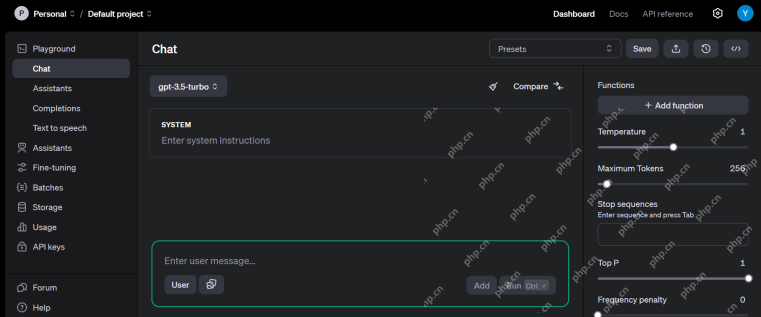

AI 資料流程中的主要步驟包括:資料設計(資料的收集和記錄)、資料改善(資料篩選、清洗、標註、增強)以及用於評估和監控AI 模型的資料策略,其中的每一個環節都會影響最終AI 模型的可信度。

圖1:從資料設計到評估的以資料為中心的方法開發路線圖。

1.AI 的資料設計

確定了一個人工智慧應用程式後,開發 AI 模型第一步就是設計資料(即識別和記錄資料來源)。

設計應是一個迭代過程-用試驗資料來發展初始的 AI 模型,然後再收集額外資料來修補模型的限制。設計的關鍵標準是確保資料適用於任務,並涵蓋足夠的範圍來代表模型可能遇到的不同使用者和場景。

而目前用於開發 AI 的資料集通常涵蓋範圍有限或具有偏差。例如在醫療 AI 中,用於開發演算法的患者數據的收集在地區分佈上不成比例,這會限制 AI 模型對不同人群的適用性。

提高資料覆蓋率的一種方法,是讓更廣泛的社群參與資料的創建。目前最大的公共資料集 Common Voice 專案就是一個例證,該資料集包含了來自 166,000 多名參與者的 76 種語言的 11192 小時語音轉錄。

而當代表性資料難以取得時,可以用合成資料來填補覆蓋空白。例如真實人臉的收集通常涉及隱私問題和抽樣偏差,而由深度生成模型創建的合成人臉現在已經被用來減輕資料不平衡和偏差。在醫療保健領域,可以共享合成醫療記錄來促進知識發現,而無需披露實際的患者資訊。在機器人技術中,真實世界的挑戰是終極的測試平台,也可以用高保真模擬環境讓智能體在複雜和長期任務中實現更快、更安全的學習。

但合成資料也存在一些問題。合成資料與現實資料之間總是存在差距,所以在將基於合成資料訓練的 AI 模型轉移到現實世界時,通常會出現效能下降。如果模擬器的設計不考慮少數群體,那麼合成資料也會加劇資料差異,而AI 模型的效能高度依賴其訓練和評估資料的上下文,因此在標準化和透明的報告中記錄資料設計地上下文就非常重要。

現在,研究人員已經創建了各種「資料營養標籤」(data nutrition labels)來捕獲有關資料設計和註釋過程的元資料(metadata)。有用的元資料包括資料集中參與者的性別、性別、種族和地理位置的統計數據,這有助於發現是否有代表性不足的亞群未被覆蓋。數據來源也是一種元數據,它追蹤數據的來源和時間以及產生數據的過程和方法。

元資料可以保存在一個專門的資料設計文件裡,資料文件對於觀察資料的生命週期和社會技術背景來說非常重要。文件可以上傳到穩定且集中的資料儲存庫(例如 Zenodo)。

2.完善数据:筛选、清洗、标注、增强

初始数据集收集完成后,我们就需要进一步完善数据,为 AI 的开发提供更有效的数据。这是 AI 以模型为中心的方法与以数据为中心的方法的关键不同之处,如图 2a ,以模型为中心的研究通常是基于给定的数据,专注于改进模型架构或优化此数据。而以数据为中心的研究则侧重于可扩展的方法,通过数据清洗、筛选、标注、增强等过程来系统地改进数据,并且可以使用一站式的模型开发平台。

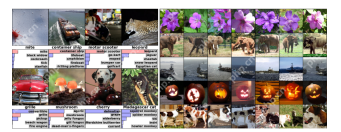

图2a:AI 以模型为中心与以数据为中心的方法比较。MNIST、COCO 和 ImageNet 是 AI 研究中常用的数据集。

数据筛选

如果数据集的噪声很大,我们就得仔细对数据进行筛选之后再做训练,这样可以显著提高模型的可靠性和泛化性。图 2a 中的飞机图像就是鸟类数据集中应删除的噪声数据点。

在 图 2b 中,由于训练数据的偏差,在以前使用的大型皮肤病学数据上训练的四种最先进的模型都表现不佳,在深色皮肤图像上的诊断效果尤其不好,而在较小的高质量数据上训练的模型 1 在深浅肤色上都相对更可靠一些。

图 2b:浅色皮肤和深色皮肤图像上的皮肤病诊断测试性能。

图 2c 显示,ResNet、DenseNet 和 VGG 这三种用于图像分类的流行深度学习架构,如果是在噪声大的图像数据集上进行训练,其性能都欠佳。而经过数据Shapley 值过滤后,质量较差的数据被删除,此时在更干净的数据子集上训练的ResNet模型性能显著更优。

图 2c:数据过滤前后不同模型的对象识别测试性能比较。括号中的数字表示过滤掉噪声数据后剩下的训练数据点的数量,结果汇总在五个随机种子上,阴影区域代表 95% 置信区间。

这就是数据评估的意义所在,它旨在量化不同数据的重要程度,并过滤掉可能由于质量差或偏差而损害模型性能的数据。

数据清洗

在本文中,作者介绍了两种数据评估方法来帮助清洗数据:

一种方法是测量在训练过程中删除不同数据时 AI 模型表现的变化,这可以采用数据的 Shapley 值或影响近似值来获得,如下图 3a。这种方法能够有效计算大型 AI 模型的评估。

图3a:数据评估。当在训练中删除特定点(图中被划掉的褪色五角星)时,数据的 Shapley 值测量在不同数据子集上训练的模型的性能变化,从而来量化每个数据点(五角星符号)的值。颜色表示类别标签。

另一种方法则是预测不确定性来检测质量差的数据点。数据点的人类注释可能会系统地偏离 AI 模型预测,置信学习算法可以检测出这些偏差,在 ImageNet 等常见基准测试中发现超过 3% 的测试数据被错误标注。过滤掉这些错误可以大大提升模型的性能。

数据标注

数据标注也是数据偏差的一个主要来源。尽管 AI 模型可以容忍一定程度的随机标签噪声,但有偏差的错误会产生有偏差的模型。目前,我们主要依赖于人工标注,成本很昂贵,比如标注单个 LIDAR 扫描的成本可能超过 30 美元,因为它是三维数据,标注者需要绘制出三维边界框,比一般的标注任务要求更高。

因此作者认为,我们需要仔细校准 MTurk 等众包平台上的标注工具,提供一致的标注规则。在医疗环领域,还要考虑到标注人员可能需要专业知识或者可能有无法众包的敏感数据。

降低註解成本的一種方法是資料程式設計。在資料程式設計中,AI 開發人員不再需要手動標記資料點,而是編寫程式標籤函數來自動標註訓練集。如圖 3b,使用使用者定義的標籤函數為每個輸入自動產生多個可能有雜訊的標籤後,我們可以設計額外的演算法,來聚合多個標籤功能以減少雜訊。

圖 3b:資料程式設計。

另一種降低標註成本的「人在迴路」(human-in-the-loop)方法是優先考慮最有價值的數據,以便我們透過主動學習(active learning)來進行標註。主動學習從最佳實驗設計中汲取思想,在主動學習中,演算法從一組未標註的數據點中選擇資訊量最大的點,例如具有高資訊增益的點或模型在其上具有不確定性的點嗎,然後再進行人工標註。這種方法的好處是,所需的數據數量比標準的監督學習所需的數據量要少得多。

資料增強

最後,當現有資料仍十分有限時,資料增強就是一種擴充資料集和提高模型可靠性的有效方法。

電腦視覺資料可以透過影像旋轉、翻轉和其他數位轉換來增強,文字資料可以透過變換自動書寫風格來增強。還有最近的 Mixup,是一種更複雜的增強技術,它透過對訓練樣本對進行插值來創建新的訓練數據,如圖 3c。

除了手動資料增強之外,目前的 AI 的自動化資料增強流程也是一種流行方案。此外,當未標註的資料可用時,還可以透過使用初始模型進行預測(這些預測稱為偽標籤)來實現標籤增強,然後在具有真實和高置信度偽標籤的組合資料上訓練一個更大的模型。

圖 3c:Mixup 透過建立對現有資料進行內插的合成資料來擴充資料集。藍點表示訓練集中的現有資料點,紅點表示透過內插兩個現有資料點所建立的合成資料點。

3.用於評估和監控 AI 模型的資料

在模型經過訓練後,AI 評估的目標是模型的通用性和可信性。

為了實現這個目標,我們應該仔細設計評估數據,從而去找到模型的現實世界設定(real-world settings),同時評估數據也需要與模型的訓練數據有足夠大的差異。

舉個例子,在醫學研究中,AI 模型通常是基於少數醫院的資料訓練的。這樣的模型在新的醫院部署時,由於資料收集和處理方面的差異,其準確性就會降低。為了評估模型的泛化性,就需要從不同的醫院、不同的資料處理管道收集評估資料。在其他應用程式中,評估資料應該從不同的來源收集,最好由不同的註釋器標記為訓練資料。同時,高品質的人類標籤仍然是最重要的評價。

AI 評估的一個重要角色是,判斷 AI 模型是否在無法很好形成概念的訓練資料中將虛假相關性作為「捷徑」。例如,在醫學影像中,資料的處理方式(例如裁剪或影像壓縮)可能產生模型拾取的虛假相關性(即捷徑)。這些捷徑表面上可能很有幫助,但當模型部署在稍微不同的環境中時,就可能會出現災難性的失敗。

系統的資料消融是檢查潛在的模式「捷徑」的好方法。在資料消融(data ablation)中,AI 模型在虛假相關表面訊號的消融輸入上進行訓練和測試。

圖4:資料消融

使用資料消融偵測出模型捷徑的一個例子是,一項關於常見自然語言推理資料集的研究發現,僅對文字輸入的前一半進行訓練的人工智慧模型在推斷文字的前一半和後一半之間的邏輯關係方面取得了很高的準確性,而人類在相同的輸入上的推斷水平和隨機猜測差不多。這就顯示人工智慧模型利用虛假相關性作為完成這項任務的捷徑。研究團隊發現,特定的語言現象會被人工智慧模型利用,如文本中的否定與標籤高度相關。

數據消融被廣泛適用於各個領域。例如,在醫學領域,可以屏蔽影像中與生物相關的部分,以這種方式評估人工智慧是從虛假背景中學習,還是從影像品質的人工製品中學習。

AI 評估通常局限於比較整個測試資料集的整體效能指標。但即使 AI 模型在整體資料層面運作良好,它仍然可能在特定的資料子組上顯示系統性錯誤,而這些錯誤群集的特徵描述可以讓我們更了解模型的局限性。

當元資料可用時,細粒度的評估方法應該盡可能地按資料集中參與者的性別、性別、種族和地理位置對評估資料進行切片——例如,「亞洲老年男性」或「美國原住民女性」—並量化模型在每個資料子組上的表現。多精確度審計(Multi-accuracy auditing)是一種自動搜尋 AI 模型表現不佳的資料子組的演算法。在此處,審計演算法被訓練來使用元資料預測和聚類原始模型的錯誤,然後提供 AI 模型犯了什麼錯,為什麼會犯錯等問題的可解釋答案。

當元資料不可用時,Domino 等方法會自動識別評估模型容易出錯的資料集群,並使用文字生成來創建這些模型錯誤的自然語言解釋。

4.資料的未來

目前大多數 AI 研究專案只開發一次資料集,但現實世界的 AI 使用者通常需要不斷更新資料集和模型。持續的數據開發將帶來以下挑戰:

首先,數據和AI 任務都可以隨著時間的推移而變化:例如,可能道路上出現了一種新的車輛模型(即領域轉移) ,或者可能AI 開發人員想要識別一種新的物件類別(例如,不同於普通公車的校車類型),這就會改變標籤的分類。而將丟掉數百萬小時的舊標籤資料十分浪費,所以更新勢在必行。此外,訓練和評估指標應該經過精心設計後用來權衡新數據,並為每個子任務使用適當的數據。

其次,為了持續取得和使用數據,使用者將需要自動化大部分以數據為中心的 AI 流程。這種自動化包括使用演算法來選擇將哪些資料傳送給標註器,以及如何使用它來重新訓練模型,並且只在流程出現錯誤時(例如,準確度指標下降時)才向模型開發人員發出警報。作為「MLOps(Machine Learning Operations,機器學習操作)」趨勢的一部分,業界公司開始使用工具來實現機器學習生命週期的自動化。

以上是史丹佛李飛飛團隊新研究發現:設計、完善、評估數據是實現可信任人工智慧的關鍵的詳細內容。更多資訊請關注PHP中文網其他相關文章!

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM

免費生成的AI課程:開創創新的未來Apr 19, 2025 am 10:01 AM生成的AI:革命性的創造力和創新 生成的AI通過按下按鈕來創建文本,圖像,音樂和虛擬世界來改變行業。 它的影響跨越視頻編輯,音樂製作,藝術,娛樂,HEA

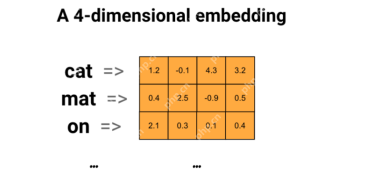

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM

使用通用句子編碼器和Wikiqa創建QA模型Apr 19, 2025 am 10:00 AM利用嵌入模型的力量來回答高級問題 在當今信息豐富的世界中,立即獲得精確答案的能力至關重要。 本文展示了使用強大的提問(QA)模型

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM

前十名必須閱讀機器學習研究論文Apr 19, 2025 am 09:53 AM本文探討了十個徹底改變人工智能(AI)和機器學習(ML)的開創性出版物。 我們將研究神經網絡和算法的最新突破,並解釋驅動現代AI的核心概念。 Th

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AM

替換SEO機構的11個AI工具 - 分析VidhyaApr 19, 2025 am 09:49 AMAI在SEO中的崛起:超過SEO代理商的前11個工具 AI的快速發展已深刻地重塑了SEO景觀。 旨在提高頂級搜索引擎排名的企業正在利用AI優化其在線策略的能力。 來自AU

前10個免費的AI遊樂場供您在2025年嘗試-Analytics VidhyaApr 19, 2025 am 09:45 AM

前10個免費的AI遊樂場供您在2025年嘗試-Analytics VidhyaApr 19, 2025 am 09:45 AM探索2024年最好的免費AI遊樂場:綜合指南 訪問正確的工具和平台是在不斷發展的人工智能(AI)領域學習和創新的關鍵。 AI遊樂場提供了絕佳的機會

矢量數據庫中索引算法的詳細指南Apr 19, 2025 am 09:41 AM

矢量數據庫中索引算法的詳細指南Apr 19, 2025 am 09:41 AM介紹 向量數據庫是專門的數據庫,旨在有效地存儲和檢索高維矢量數據。 這些向量代表數據點的特徵或屬性,範圍從數十到數千個維度,具體取決於

反向擴散過程是什麼? - 分析VidhyaApr 19, 2025 am 09:40 AM

反向擴散過程是什麼? - 分析VidhyaApr 19, 2025 am 09:40 AM穩定的擴散:揭示反向擴散的魔力 穩定的擴散是一種強大的生成模型,能夠從噪聲中產生高質量的圖像。此過程涉及兩個關鍵步驟:正向擴散過程(在上一個A中詳細介紹

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

SublimeText3漢化版

中文版,非常好用

Dreamweaver Mac版

視覺化網頁開發工具

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器