自 ChatGPT 發布以來,這段時間對話模型的熱度只增不減。當我們讚嘆這些模型表現驚豔的同時,也應該猜到背後巨大的算力和海量數據的支持。

單就數據而言,高品質的數據至關重要,為此 OpenAI 對數據和標註工作下了很大力氣。有多項研究表明,ChatGPT 是比人類更可靠的數據標註者,如果開源社群可以獲得 ChatGPT 等強大語言模型的大量對話數據,就可以訓練出表現更好的對話模型。這一點羊駝系列模型 ——Alpaca、Vicuna、Koala—— 已經證明過。例如,Vicuna 使用從 ShareGPT 收集的使用者共享資料對 LLaMA 模型進行指令微調,就復刻了 ChatGPT 九成功力。越來越多的證據表明,資料是訓練強大語言模型的第一個生產力。

ShareGPT 是一個 ChatGPT 資料分享網站,使用者會上傳自己覺得有趣的 ChatGPT 答案。 ShareGPT 上的資料是開放但瑣碎的,需要研究者自行收集整理。如果能夠有一個高品質的,涵蓋廣泛的資料集,開源社群在對話模型研發方面將會事半功倍。

基於此,最近一個名為 UltraChat 的專案就係統建立了一個超高品質的對話資料集。專案作者嘗試用兩個獨立的 ChatGPT Turbo API 進行對話,從而產生多輪對話資料。

- 專案網址:https://github.com/thunlp/UltraChat

- 資料集位址:http://39.101.77.220/

- 資料集互動位址:https://atlas. nomic.ai/map/0ce65783-c3a9-40b5-895d-384933f50081/a7b46301-022f-45d8-bbf4-98107eabdbac

- ##家項目!在建立一個開源、大規模、多輪的基於Turbo APIs 的對話數據,方便研究者開發具有通用對話能力的強大語言模型。此外,考慮到隱私保護等因素,該項目不會直接使用網路上的資料作為提示。為了確保產生資料質量,研究者在生成過程中採用了兩個獨立的 ChatGPT Turbo API,其中一個模型扮演使用者角色來產生問題或指令,另一個模型產生回饋。

- 如果直接使用ChatGPT 基於一些種子對話和問題讓其自由生成,容易出現話題單一、內容重複等問題,從而難以保證數據本身的多樣性。為此,UltraChat 對對話資料覆蓋的主題和任務類型進行了系統的分類和設計,也對使用者模型和回復模型進行了細緻的提示工程,它包含三個部分:

關於世界的問題(Questions about the World):這部分對話來自於對現實世界中的概念、實體和物件相關的廣泛詢問。所涉及的主題涵蓋科技、藝術、金融等多個領域。

######寫作與創作(Writing and Creation):這部分對話資料著重於指示AI 從頭進行創作一個完整的文本材料,並在此基礎上進行後續的提問或進一步指導以完善寫作,撰寫的材料內容類型包括文章、部落格、詩歌、故事、戲劇,電子郵件等等。 ############對於現有資料的輔助改寫(Writing and Creation):此對話資料是基於現有資料產生的,指令包括但不限於改寫、續寫、翻譯、歸納、推理等,涵蓋主題同樣非常多元。 ###############這三部分資料涵蓋了大部分使用者對於 AI 模型的要求。同時,這三類資料也會面臨不同的挑戰,為此需要不同的構造方法。 ######例如,第一部分的資料主要挑戰在於如何在總量為數十萬組對話中盡量廣泛地涵蓋人類社會中的常見知識,為此研究者從自動生成的主題和來自於Wikidata的實體兩個面向進行了篩選和建構。

第二、三部分的挑戰主要來自於如何模擬使用者指令,並在後續對話中讓使用者模型的生成盡量多樣化的同時又不偏離對話的最終目標(按照要求生成材料或改寫材料),為此研究者對使用者模型的輸入提示進行了充分的設計和實驗。在構造完成之後,作者也對資料進行了後處理以削弱幻覺問題。

目前,該專案已經發布了前兩部分的數據,數據量為 124 萬條,應該是目前開源社群內規模最大的相關數據集。內容包含在現實世界中豐富多彩的對話,最後一部分數據將在未來發布。

世界問題資料來自30 個具有代表性和多樣性的元主題,如下圖所示:

- 基於以上元主題,該專案產生了1100 子主題用於資料建構;

- 對於每個子主題,最多產生10 個具體問題;

- 然後使用Turbo API 為10 個問題中的每一個產生新的相關問題;

- 對於每個問題,如上所述迭代地使用兩個模型產生3~7 輪對話。

此外,專案從維基資料中收集了最常用的10000 個命名實體;使用ChatGPT API 為每個實體產生5 元問題;對於每個元問題,產生10 個更具體的問題和20 個相關但一般的問題;採樣20w 個特定問題和25w 個一般問題以及5w 個元問題,並為每個問題產生了3~7 輪對話。

接下來我們來看一個具體的例子:

我們在UltraChat 平台上測試了數據搜尋效果。例如,輸入「音樂(music)」,系統會自動搜尋出10000 組與音樂相關的ChatGPT 對話數據,並且每組都是多輪對話

#輸入關鍵字「數學(math)」的搜尋結果,有3346 組多輪對話:

目前,UltraChat 涵蓋的資訊領域已經非常多,包括醫療、教育、運動、環保等多個議題。同時,筆者嘗試使用開源的LLaMa-7B 模型在UltraChat 上進行監督的指令微調,發現僅訓練10000 步後就有非常可觀的效果,一些例子如下:

三段论:鲸鱼是鱼吗?

假设问题:证明成龙比李小龙更出色

总体来说,UltraChat 是一个高质量、范围广的 ChatGPT 对话数据集,可以和其它数据集结合,显著地提升开源对话模型的质量。目前 UltraChat 还只放出了英文版,但也会在未来放出中文版的数据。感兴趣的读者快去探索一下吧。

以上是使用多個ChatGPT API實現清華UltraChat多輪對話的詳細內容。更多資訊請關注PHP中文網其他相關文章!

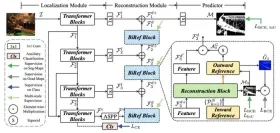

RF-DER:橋接速度和對象檢測的準確性Apr 24, 2025 am 10:40 AM

RF-DER:橋接速度和對象檢測的準確性Apr 24, 2025 am 10:40 AM歡迎讀者,簡歷課程重新參加了會議!迄今為止,我們以前已經在我以前的博客中研究了30種不同的計算機視覺模型,每個博客都從快速檢測技巧中帶來了自己的獨特優勢

Agent SDK vs Crewai vs Langchain:哪個何時使用?Apr 24, 2025 am 10:39 AM

Agent SDK vs Crewai vs Langchain:哪個何時使用?Apr 24, 2025 am 10:39 AM本文比較了建立AI代理的三個流行框架:OpenAI的Agent SDK,Langchain和Crewai。 每個都為自動化任務和增強決策提供了獨特的優勢。 這篇文章指導您選擇最佳幀

使用Pydantic構建結構化研究自動化系統Apr 24, 2025 am 10:32 AM

使用Pydantic構建結構化研究自動化系統Apr 24, 2025 am 10:32 AM在學術研究的動態領域,有效的信息收集,綜合和演示至關重要。 文獻綜述的手動過程是耗時的,阻礙了更深入的分析。 多代理研究助理系統BUI

10 GPT-4O圖像生成會提示今天嘗試!Apr 24, 2025 am 10:26 AM

10 GPT-4O圖像生成會提示今天嘗試!Apr 24, 2025 am 10:26 AMAI世界中發生了絕對野生的事情。 Openai的本地形像生成現在很瘋狂。我們正在談論令人jaw目結舌的視覺效果,可怕的細節和拋光的輸出

用帆板編碼的氛圍指南Apr 24, 2025 am 10:25 AM

用帆板編碼的氛圍指南Apr 24, 2025 am 10:25 AM毫不費力地將您的編碼願景帶入Codeium's Windsurf,這是您的AI驅動的編碼伴侶。 Windsurf簡化了整個軟件開發生命週期,從編碼和調試到優化,將過程轉換為INTU

使用RMGB v2.0探索圖像背景刪除Apr 24, 2025 am 10:20 AM

使用RMGB v2.0探索圖像背景刪除Apr 24, 2025 am 10:20 AMBraiai的RMGB v2.0:強大的開源背景拆卸模型 圖像分割模型正在徹底改變各個領域,而背景刪除是進步的關鍵領域。 Braiai的RMGB v2.0是最先進的開源M

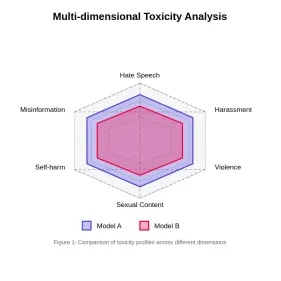

評估大語模型中的毒性Apr 24, 2025 am 10:14 AM

評估大語模型中的毒性Apr 24, 2025 am 10:14 AM本文探討了大語言模型(LLM)中的毒性至關重要問題以及用於評估和減輕它的方法。 LLM,為從聊天機器人到內容生成的各種應用程序提供動力,需要強大的評估指標,機智

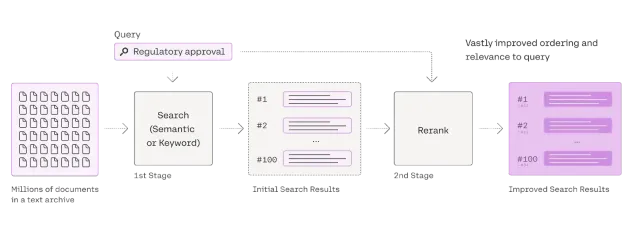

Rag Reranker的綜合指南Apr 24, 2025 am 10:10 AM

Rag Reranker的綜合指南Apr 24, 2025 am 10:10 AM檢索增強發電(RAG)系統正在轉換信息訪問,但其有效性取決於檢索到的數據的質量。 這是重讀者變得至關重要的地方 - 充當搜索結果的質量過濾器,以確保僅確保

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

Video Face Swap

使用我們完全免費的人工智慧換臉工具,輕鬆在任何影片中換臉!

熱門文章

熱工具

SublimeText3漢化版

中文版,非常好用

SublimeText3 英文版

推薦:為Win版本,支援程式碼提示!

SublimeText3 Linux新版

SublimeText3 Linux最新版

WebStorm Mac版

好用的JavaScript開發工具

mPDF

mPDF是一個PHP庫,可以從UTF-8編碼的HTML產生PDF檔案。原作者Ian Back編寫mPDF以從他的網站上「即時」輸出PDF文件,並處理不同的語言。與原始腳本如HTML2FPDF相比,它的速度較慢,並且在使用Unicode字體時產生的檔案較大,但支援CSS樣式等,並進行了大量增強。支援幾乎所有語言,包括RTL(阿拉伯語和希伯來語)和CJK(中日韓)。支援嵌套的區塊級元素(如P、DIV),