段落排序是資訊檢索領域中十分重要且具有挑戰性的議題,受到了學術界和工業界的廣泛關注。段落排序模型的有效性能夠提高搜尋引擎使用者的滿意度並且對問答系統、閱讀理解等資訊檢索相關應用有所助益。在這一背景下,例如 MS-MARCO,DuReader_retrieval 等一些基準資料集被建構用於支援段落排序的相關研究工作。然而常用的資料集大部分都關注英文場景,對於中文場景,已有的資料集在資料規模、細粒度的使用者標註和假負例問題的解決上有其限制。在這一背景下,我們基於真實搜尋日誌,建立了一個全新的中文段落排序基準資料集:T2Ranking。

T2Ranking由超過30 萬的真實查詢和200 萬的網路段落構成,並且包含了由專業標註人員提供的4 級細粒度相關性標註。目前數據和一些 baseline 模型已經公佈在 Github,相關研究工作已作為 Resource 論文被 SIGIR 2023 錄用。

- #論文資訊:Xiaohui Xie, Qian Dong, Bingning Wang, Feiyang Lv , Ting Yao, Weinan Gan, Zhijing Wu, Xiangsheng Li, Haitao Li, Yiqun Liu, and Jin Ma. T2Ranking: A large-scale Chinese Benchmark . SIGIR 2023.

- 論文網址:https://arxiv.org/abs/2304.03679

- Github 網址:https://github.com/THUIR/T2Ranking

背景與相關工作

段落排序任務的目標是基於給定的查詢詞,從一個大規模段落集合中召回並排序候選段落,依照相關性從高到低的順序得到段落清單。段落排序一般由段落回想和段落重新排序兩個階段組成。

為了支援段落排序任務,多個資料集合被建構用於訓練和測試段落排序演算法。廣泛使用的資料集大多聚焦於英文場景,例如最常用的有 MS-MARCO 資料集,該資料集包含了 50 多萬個查詢詞和 800 多萬個段落,其中,每一個查詢詞都具有問題屬性。對於每一個查詢詞,MS-MARCO 資料發布團隊招募了標註人員提供了標準答案,根據給定段落是否包含人工提供的標準答案判斷這個段落是否與查詢詞相關。

在中文場景中,也有一些資料集被建構用來支援段落排序任務。例如mMarco-Chinese 是MS-MARCO 資料集的中文翻譯版本,DuReader_retrieval 資料集採用了和MS-MARCO 相同的範式生成段落標籤,即從人工提供的標準答案中來給定查詢詞- 段落對的相關性評分。 Multi-CPR 模型包含了來自三個不同領域(電子商務、娛樂影片和醫藥)的段落檢索資料。基於搜狗搜尋的日誌數據,Sogou-SRR,Sogou-QCL 和 Tiangong-PDR 等數據集也相繼被提出。

圖1:段落排序任務中常用資料集的統計資訊

#雖然已有資料集推進了段落排序應用的發展,我們也需要關注幾個限制:

1)這些資料集不是大規模的或相關性標籤不是人工標註的,特別是在中文場景下。 Sogou-SRR 和 Tiangong-PDR 僅包含了少量的查詢資料。雖然 mMarco-Chinese 和 Sogou-QCL 規模較大,但前者基於機器翻譯,後者採用的相關性標籤為使用者的點擊資料。最近,Multi-CPR 和 DuReader_retrieval 兩個規模相對較大的資料集被相繼建構和發布。

2)已有数据集缺乏细粒度的相关性标注信息。大部分数据集采用了二值相关性标注(粗粒度),即相关或者不相关。已有工作表明细粒度的相关性标注信息有助于挖掘不同实体之间的关系和构建更加精准的排序算法。然后已有数据集不提供或者仅提供少量的多级细粒度标注。例如 Sogou-SRR 或者 Tiangong-PDR 仅提供不超过 10 万个的细粒度标注。

3)假负例问题影响了评价的准确性。已有数据集受到了假负例问题的影响,即有大量相关文档被标记为不相关文档。这一问题是由于大规模数据中人工标注数量过少引起的,会显著影响评价的准确性。例如在 Multi-CPR 中,对于每一个查询词只有一个段落会被标记为相关,而其他都会被标记为不相关。DuReader_retrieval 尝试让标注者人工检查并且重新标注靠前的段落集合来缓解假负例问题。

为了能够更好地支持段落排序模型进行高质量的训练和评测,我们构建并且发布了一个新的中文段落检索基准数据集 - T2Ranking。

数据集构建流程

数据集的构建流程包括查询词采样,文档召回,段落提取和细粒度相关性标注。同时我们也设计了多个方法用于提升数据集质量,包括采用基于模型的段落切分方法和基于聚类的段落去重方法保证了段落的语义完整性和多样性,采用基于主动学习的标注方法提升标注的效率和质量等。

1)整体流程

- 查询词采样:我们从搜狗搜索引擎的搜索日志中采样了真实用户提交的查询词,经过去重和归一化处理后得到了初始查询词集合。接着,我们使用意图分析算法去除了色情查询,非疑问查询,资源申请类查询和可能包含用户信息的查询,保证最终查询数据集合仅包含高质量、具有问题属性的查询。

- 文档召回:基于采样得到的查询词,我们从搜狗、百度和谷歌等多个主流搜索引擎召回了文档候选集合,充分综合了这些搜索引擎在索引和排序文档方面的能力。因为这些搜索引擎能够覆盖互联网数据的不同部分并且能够返回多样化的文档结果,因此能够提高文档候选集合的完整性,并且在一定程度上缓解假负例问题。

- 段落提取:段落提取步骤涉及到段落分割和去重。不同于采用启发式方法在文档中分割段落(例如常规地通过换行符确定段落的开始和结束),我们训练了段落语义模型来进行段落分割,尽可能地保证每个段落的语义完整性。此外,我们还引入了一种基于聚类的技术来提高标注的效率并且保证了标注段落的多样性,这个技术能够有效地移除高度相似的段落。

- 细粒度相关性标注:所聘请的标注人员均为搜索相关标注任务的专家,并且长期从事标注工作。对于每一个查询词 - 段落对,至少 3 名标注人员会提供标注。如果 3 名标注人员的标注结果均不一致,我们会引入额外的标注者进行标注,如果 4 名标注者的结果均不一致,我们倾向于认为这个查询词 - 段落对太过于模糊,质量较低且不太能够确定所需要的信息,从而将该查询词 - 段落对排除在数据集外。我们通过多数投票的方式来确定最终的相关性标签。我们采用的 4 级相关性标注指南与 TREC 基准一致。

- 级别 0:查询词与段落内容之间完全不相关

- 级别 1:段落内容与查询词相关,但不符合查询词的信息需求

- 级别 2:段落内容与查询词相关,能够部分满足查询词的信息需求

- 级别 3:段落内容能够完全满足查询词的信息需求,并且包含了准确答案。

圖 2:維基百科頁面範例。所展示的文檔包含了清晰定義的段落。

2)基於模型的段落分割方法

在現有資料集中,段落通常是根據自然段落(換行符)或透過固定長度的滑動視窗從文件中分割得到的。然而,這兩種方法可能都會導致段落的語義不完整或因為段落過長而導致段落包含了多個不同的主題。在這項工作中,我們採用了基於模型的段落分割方法,具體而言,我們使用搜狗百科、百度百科和中文維基百科作為訓練數據,因為這部分文檔的結構是比較清晰的,並且自然段落也都得到了較好的定義。我們訓練了一個分割模型來判斷一個給定的單字是否需要作為分割點。我們利用了序列標註任務的思想,將每一個自然段的最後一個單字作為正例來訓練模型。

3)基於聚類的段落去重方法

#對高度相似的段落進行標註是冗餘和無意義的,對於段落排序模型而言,高度相似的段落內容帶來的資訊增益有限,因此我們設計了一個基於聚類的段落去重方法來提高標註的效率。具體而言,我們採用了一個層次化聚類演算法 Ward 對相似文件進行無監督聚類。在同一個類別中的段落被認為是高度相似的,我們從每一個類別中採樣一個段落進行相關性標註。需要注意的是,我們只在訓練集中進行這個操作,對於測試集,我們會對所有提取的段落進行完整標註,減少假負例的影響。

圖3:基於主動學習的取樣標註流程

4)基於主動學習的資料取樣標註方法

在實務中,我們觀察到並不是所有的訓練樣本都能夠進一步提升排序模型的效能。對於模型能夠準確預測的訓練樣本,對於後續模型的訓練效益有限。因此,我們借鑒了主動學習的想法,讓模型能夠選擇更有資訊量的訓練樣本進行進一步的標註。具體而言,我們先基於已有的訓練數據,訓練了一個以交叉編碼器為框架的查詢詞- 段落重排序模型,接著我們用這個模型對其他數據進行預測,去除過高置信分數(信息量低)和過低置信分數(雜訊資料)的段落,對保留的段落進行進一步標註,並迭代此流程。

資料集統計資料

T2Ranking 由超過 30 萬的真實查詢和 200 萬的網路段落構成。其中,訓練集包含約 25 萬個查詢詞,測試集包含約 5 萬個查詢詞。查詢詞長度最長為 40 個字符,平均長度在 11 個字符左右。同時,資料集中的查詢詞涵蓋了多個領域,包括醫藥、教育、電商等,我們也計算了查詢詞的多樣性分數(ILS),與已有資料集相比,我們的查詢多樣性更高。採樣的 230 多萬個段落來自 175 萬個文檔,平均每個文檔被分割為了 1.3 個段落。在訓練集中,平均每個查詢詞有 6.25 個段落被人工標註,而在測試集中,平均每個查詢詞有 15.75 個段落被人工標註。

圖4:資料集中查詢詞的領域分佈情況

圖5:相關性標註分佈情況

常用模型的實驗結果

我們在所得到的資料集上,測試了一些常用的段落排序模型的性能,我們同時評測了已有方法在段落召回和段落重排序兩個階段上的效能。

1)段落回想實驗

#已有的段落回想模型可以大致分為稀疏回想模型和稠密召回模型。

- 稀疏召回模型著重精確匹配訊號來設計相關性評分函數,例如 BM25 就是最具代表性的基準模型。

- 稠密召回模型則採用深度神經網路來學習低維度的稠密向量用於表徵查詢詞和段落。

我們測試了以下召回模型的表現:

- #QL(query likelihood):QL 是具有代表性的統計語言模型,根據段落產生給定查詢詞的機率來評估相關性。

- BM25:常用的稀疏召回基準模型。

- DE w/ BM25 Neg:即DPR 模型,雙塔編碼器結構(Dual-Encoder),該模型是第一個利用預訓練語言模型作為骨幹框架的段落召回模型。

- DE w/Mined Neg:雙塔編碼器結構(Dual-Encoder),透過從全量語料中召回難負例來增強 DPR 模型的效能。

- DPTDR:第一個採用提示微調(prompt tunning)的段落回想模型。

在這些模型中,QL 和 BM25 是稀疏召回模型,其他模型為稠密召回模型。我們採用MRR,Recall 等常用指標來評估這些模型的效能,實驗結果如下表所示:

圖6:段落召回模型在測試集上的表現

從實驗結果可以看出,相較於傳統的稀疏排序模型,稠密檢索模型取得了更好的表現。同時引入了難負例對於模型性能的提升也是有幫助的。值得一提的是,這些實驗模型在我們資料集上的召回表現比在其他資料集上的表現差,例如BM25 在我們的資料集上的Recall@50 是0.492,而在MS-Marco 和Dureader_retrieval上是0.601 和0.700。這可能是由於我們有更多的段落被進行了人工標註,在測試集中,平均每個查詢詞下我們有4.74 個相關文檔,這使得召回任務更加具有挑戰性且一定程度上降低了假負例的問題。這也說明了 T2Ranking 是一個具有挑戰的基準資料集,對未來的召回模型而言有較大的提升空間。

2)段落重新排序實驗

#相比於段落回想階段,重新排序階段需要考慮的段落規模較小,因此大多數方法傾向於使用交互編碼器(Cross-Encoder)作為模型框架,在本工作中,我們測試了交互編碼器模型在段落重排序任務上的性能,我們採用MRR 和nDCG作為評估指標,實驗效果如下:

#圖7:交互編碼器在段落重新排序任務上的表現

實驗結果表明,在雙塔編碼器(Dual-Encoder)召回的段落基礎上進行重排效果比在BM25 召回的段落基礎上重排能夠取得更好的效果,這與已有工作的實驗結論一致。與召回實驗類似,重排序模型在我們資料集上的表現比在其他資料集上的表現差,這可能是由於我們資料集採用了細粒度標註且具有更高的查詢詞多樣性造成,也進一步說明了我們的資料集是具有挑戰性的,並且能夠更精確地反映模型效能。

資料集發布團隊介紹

該資料集由清華大學電腦系資訊檢索課題組(THUIR)和騰訊公司QQ 瀏覽器搜尋技術中心團隊共同發布,得到了清華大學天工智能計算研究院的支持。 THUIR 主題小組聚焦搜尋與推薦方法研究,在使用者行為建模和可解釋學習方法等方面取得了典型成果,主題組成果實獲得了包括WSDM2022 最佳論文獎、SIGIR2020 最佳論文提名獎和CIKM2018 最佳論文獎在內的多項學術獎勵,並獲得了2020 年中文資訊學會「錢偉長中文資訊處理科學技術獎」 一等獎。 QQ 瀏覽器搜尋技術中心團隊是騰訊PCG 資訊平台與服務線負責搜尋技術研發的團隊,依托騰訊內容生態,透過使用者研究驅動產品創新,提供使用者圖文、資訊、小說、長短影片、服務等多方位的資訊需求滿足。

以上是發布中文段落排序基準資料集:依據30萬真實查詢、200萬網路段落。的詳細內容。更多資訊請關注PHP中文網其他相關文章!

![如何在任务栏上显示互联网速度[简单步骤]](https://img.php.cn/upload/article/000/465/014/169088173253603.png) 如何在任务栏上显示互联网速度[简单步骤]Aug 01, 2023 pm 05:22 PM

如何在任务栏上显示互联网速度[简单步骤]Aug 01, 2023 pm 05:22 PM互联网速度是决定在线体验结果的重要参数。无论是文件下载或上传,还是只是浏览网页,我们都需要一个体面的互联网连接。这就是为什么用户寻找在任务栏上显示互联网速度的方法。将网络速度显示在任务栏中允许用户快速监控事物,无论手头的任务是什么。任务栏始终可见,除非您处于全屏模式。但是Windows不提供在任务栏中显示互联网速度的本机选项。这就是为什么您需要第三方工具的原因。继续阅读以了解有关最佳选择的所有信息!如何在Windows命令行中运行速度测试?按+打开“运行”,键入电源外壳,然后按++。Window

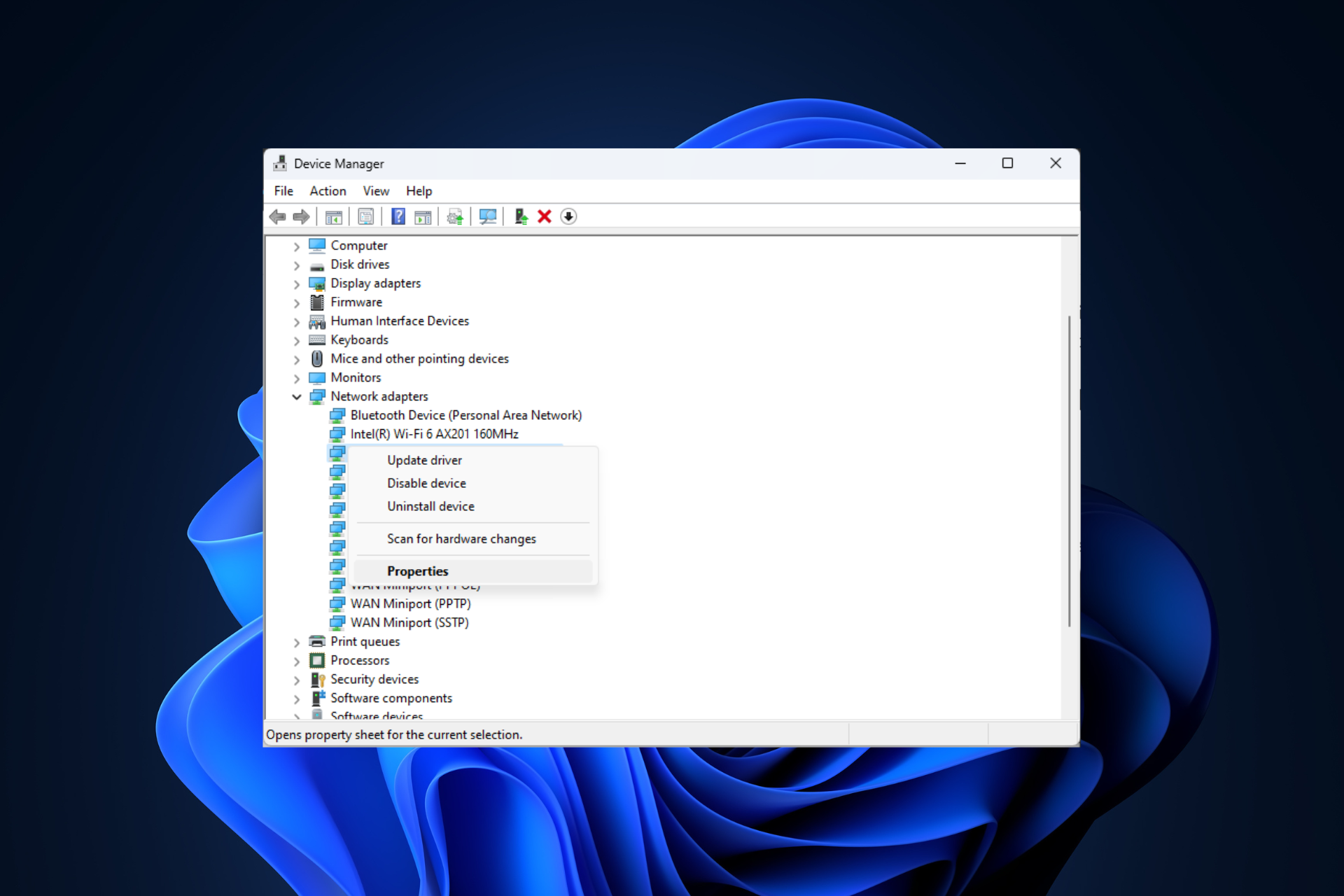

修复问题:在 Windows 11 安全模式下无法访问互联网的网络连接问题Sep 23, 2023 pm 01:13 PM

修复问题:在 Windows 11 安全模式下无法访问互联网的网络连接问题Sep 23, 2023 pm 01:13 PM在具有网络连接的安全模式下,Windows11计算机上没有互联网连接可能会令人沮丧,尤其是在诊断和排除系统问题时。在本指南中,我们将讨论问题的潜在原因,并列出有效的解决方案,以确保您在安全模式下可以访问互联网。为什么在带网络连接的安全模式下没有互联网?网络适配器不兼容或未正确加载。第三方防火墙、安全软件或防病毒软件可能会干扰安全模式下的网络连接。网络服务未运行。恶意软件感染如果互联网无法在Windows11的安全模式下使用网络,我该怎么办?在执行高级故障排除步骤之前,应考虑执行以下检查:请确保使

在因特网上的每一台主机都有唯一的地址标识称为什么Aug 22, 2022 pm 03:24 PM

在因特网上的每一台主机都有唯一的地址标识称为什么Aug 22, 2022 pm 03:24 PM每一台主机都有唯一的地址标识称为“IP地址”。IP地址是IP协议提供的一种统一的地址格式,它为互联网上的每一个网络和每一台主机分配一个唯一的逻辑地址,以此来屏蔽物理地址的差异。由于有这种唯一的地址,才保证了用户在连网的计算机上操作时,能够高效而且方便地从千千万万台计算机中选出自己所需的对象来。

Roblox不起作用:如何修复它Jul 28, 2023 pm 06:23 PM

Roblox不起作用:如何修复它Jul 28, 2023 pm 06:23 PMRoblox不起作用:原因是什么?凭借其广泛的游戏选择和活跃的社区,著名的在线游戏平台Roblox赢得了全球数百万粉丝。但是,Roblox可能偶尔会遇到技术问题,就像任何复杂的数字平台一样。下面,我们将研究一些可能修复您的Roblox无法正常工作错误的修复程序。让我们切入正题,从第一件事开始!检查Roblox服务器状态由于Roblox是一款在线游戏,如果服务中断,您可能会遇到启动它时遇到的困难。使Roblox的当前服务器状态和操作正常运行。如果服务器脱机进行维护,请等待服务器端的问题得到解决。有

微软新出热乎论文:Transformer扩展到10亿tokenJul 22, 2023 pm 03:34 PM

微软新出热乎论文:Transformer扩展到10亿tokenJul 22, 2023 pm 03:34 PM当大家不断升级迭代自家大模型的时候,LLM(大语言模型)对上下文窗口的处理能力,也成为一个重要评估指标。比如明星大模型GPT-4支持32ktoken,相当于50页的文字;OpenAI前成员创立的Anthropic更是将Claude处理token能力提升到100k,约75000个单词,大概相当于一键总结《哈利波特》第一部。在微软最新的一项研究中,他们这次直接将Transformer扩展到10亿token。这为建模非常长的序列开辟了新的可能性,例如将整个语料库甚至整个互联网视为一个序列。作为比较,普

互联网思维的核心是什么Sep 14, 2022 pm 05:31 PM

互联网思维的核心是什么Sep 14, 2022 pm 05:31 PM互联网思维的核心是“用户思维”。人是互联网时代的核心,用户思维自然也成为互联网思维的核心,而其他思维,都是围绕这个思维展开的;用户思维是互联网思维的基石,没有用户思维就不会有其他的互联网思维。

已连接但无法访问互联网怎么解决Aug 30, 2023 pm 12:04 PM

已连接但无法访问互联网怎么解决Aug 30, 2023 pm 12:04 PM已连接但无法访问互联网解决方法:1、检查网络连接是否正常,尝试重新启动我们的路由器或调制解调器,以确保它们正常工作;2、检查设备是否正确连接到网络,并且是否配置了正确的IP地址和DNS服务器;3、使用其他设备连接到同一网络,如果能正常访问,那么可以尝试更新设备的操作系统或重置设备的网络设置来解决问题;4、如果以上方法都没有解决问题,可以联系互联网服务提供商寻求帮助。

ChatGPT使用方法和常见问题总结Apr 11, 2023 pm 10:43 PM

ChatGPT使用方法和常见问题总结Apr 11, 2023 pm 10:43 PM哈喽,大家好。关注渡码的老读者都能体会到,渡码公众号的文章从去年中旬开始转向人工智能的方向。因为当时我认定了人工智能就是未来,逻辑也很简单,互联网时代把人们从看报纸、看电视的场景中解放出来,PC时代把人们从机房、网吧场景中解放出来,移动互联网把人们从电脑桌上解放出来。而人工智能天然地会把人们从各种各样的场景中解放出来。今天要写的是最近爆火的ChatGPT,大家看完文章可以亲手试试,看看有哪些场景可以被它解放了。准备了 6 个 chatgpt 账号,大家可以免费使用,获取方式放在文末了。1. 注册

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

SublimeText3漢化版

中文版,非常好用

SAP NetWeaver Server Adapter for Eclipse

將Eclipse與SAP NetWeaver應用伺服器整合。

VSCode Windows 64位元 下載

微軟推出的免費、功能強大的一款IDE編輯器

Dreamweaver CS6

視覺化網頁開發工具

SublimeText3 Mac版

神級程式碼編輯軟體(SublimeText3)