GPT4發佈在即堪比人腦,多位圈內大佬坐不住了!

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-14 18:58:041910瀏覽

作者 | 徐傑承

審校 | 雲昭

#100萬億,這個數字究竟有多大?假如你擁有每天都能中500萬彩票的超能力,那麼在不吃不喝存下所有錢的情況下,你還需要擁有約5500年的壽命,才能夠攢下100萬億的財產。然而,今天想要和大家聊的這100萬億,背後並不是「RMB」、「Dollor」這些令人垂涎的單位。這裡的100萬億,指的是由許多矽谷科技大亨共同創立的人工智慧研究公司OpenAI即將發布的第四代生成式預訓練Transformer——GPT-4所擁有的參數量。

為了方便大家更直覺的理解這個數據,我們可以用人腦與GPT-4做比較。一般情況下,一個正常人類的大腦約有800—1000億個神經元,以及約100兆個突觸。而這些神經元與突觸,幾乎直接控制一個人百年人生中的所有思想、判斷及行為,而GPT-4擁有與人腦突觸一樣多的參數。那麼,如此龐大規模的密集神經網路究竟具備著怎樣的潛力;GPT-4的出現將會為我們的帶來哪些驚喜;我們又是否已經真的具備製造人腦的能力了呢?

在探索這些令人興奮的問題之前,我們不妨先來了解GPT-4幾位「前輩」的發展歷史。

1、GPT:不鳴則已,一鳴驚人

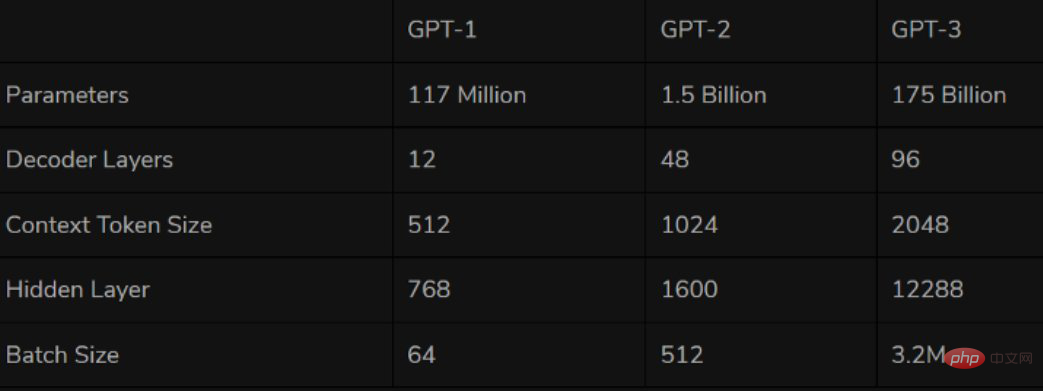

#首個GPT系列模型GPT-1誕生於2018年,也就是我們常說的NLP預訓練模型元年。 GPT-1作為第一個基於Transformer的預訓練模型,採取了預訓練FineTuning兩個階段,以Transformer的decoder作為特徵抽取器,共堆疊12層,擁有1.1億參數,預訓練階段則採用「單向語言模型”作為訓練任務。

性能方面,GPT-1有著一定的泛化能力,能夠用於和監督任務無關的NLP任務中。其常用任務包括:

- 自然語言推理:判斷兩句的關係(包含、矛盾、中立)

- 問答與常識推理:輸入文章及若干答案,輸出答案的準確率

- 語意相似度辨識:判斷兩個句子語意是否相關

- 分類:判斷輸入文字是指定的哪個類別

雖然GPT-1在未經調試的任務上有一些效果,但其泛化能力遠低於經過微調的有監督任務,因此GPT-1只能算得上一個還算不錯的語言理解工具而非對話式AI。

在GPT-1問世一年後,GPT-2也於2019年如期而至。相較於老大哥GPT-1,GPT-2並沒有對原有的網路進行過多的結構創新與設計,只使用了更多的網路參數與更大的資料集:最大模型共48層,參數量達15億,學習目標則使用無監督預訓練模型做有監督任務。

圖源:推特

#在效能方面,OpenAI的大力似乎真的帶來了一些奇蹟。除了理解能力外,GPT-2在生成方面第一次展現了強大的天賦:閱讀摘要、聊天、續寫、編故事,甚至產生假新聞、釣魚郵件或在網路上扮演他人通通不在話下。在「變得更大」之後,GPT-2的確展現出了一些列普適而強大的能力,並在多個特定的語言建模任務上實現了彼時的最佳性能。也難怪當時OpenAI曾表示「GPT-2 was too dangerous to release」。

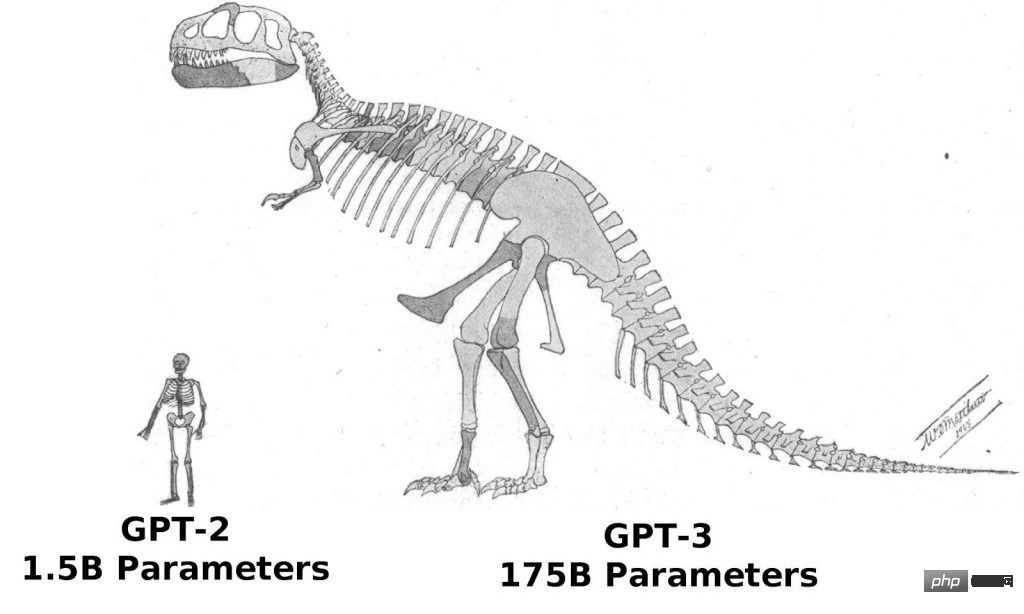

自GPT-2取得成功以來,OpenAI對「大力士教」的信仰愈發堅定,2020年放出的GPT-3繼續沿用微創新、猛擴大的發展思路。除了GPT-3中的Transformer應用了Sparse結構外,GPT-3與GPT-2的結構幾乎沒有差異。而在「大力」方面,GPT-3的模型上到了96層,訓練參數則是達到了1750億個(GPT-2的10倍以上)。

而GPT-3也再次證明了OpenAI的眼光,由於GPT-3更強的性能和明顯更多的參數,它包含了更多的主題文本,顯然優於前代的GPT-2。作為目前最大的密集神經網絡,GPT-3能夠將網頁描述轉換為相應代碼、模仿人類敘事、創作客製化詩歌、生成遊戲劇本,甚至模仿已故的各位哲學家——預測生命的真諦。而GPT-3不需要微調,在處理文法難題方面,它只需要一些輸出類型的樣本(少量學習)。可以說GPT-3似乎已經滿足了我們對語言專家的一切想像。

2、全面通過圖靈測試學習和商用門檻降低

說到這裡,相信大家一定會有一個相同的疑問——GPT-3已經非常強大了,那GPT-4還有哪些值得我們期待的地方呢?

眾所周知,測試一個AI系統智能性的最核心方式便是圖靈測試,在我們還無法用科學的可量化標準對人類智慧這一概念進行定義時,圖靈測試是目前少數的、可行的、能夠確定對方是否具備人類智慧的測試方法。用一句諺語來說:如果一個東西長的像鴨子,走路像鴨子,叫起來像鴨子,那它就是鴨子。因此,如果AI系統能夠順利通過圖靈測試,那麼就意味著這個系統已具備人類思維並有可能在某些方面取代人類。而根據韓國IT媒體報道,自11月開始,業界已經傳出了GPT-4全面通過了圖靈測試的說法。韓國Vodier AI公司高層南世東在日前接受韓國《經濟新聞》採訪時表示:「雖然GPT-4通過圖靈測試的消息尚未正式確認,但這個消息應該相當可信。」

技術人出身,現任OpenAI CEO的Sam Altman似乎也在其Twitter中證實了這個訊息。 Altman在11月10日模仿電影《星際大戰》中角色達斯維德的經典台詞,發出了一條推文:“不要為你製造的這種技術恐慌感到驕傲。通過圖靈測試的能力在'原力'面前也無能為力」。

圖源:推特

#一位AI新創公司的高階主管分析稱「如果GPT-4真的完美通過了圖靈測試,那麼它的影響足以在AI界引發'技術恐慌',因此Altman才會藉由達斯維德的角色來公佈這個信息”。

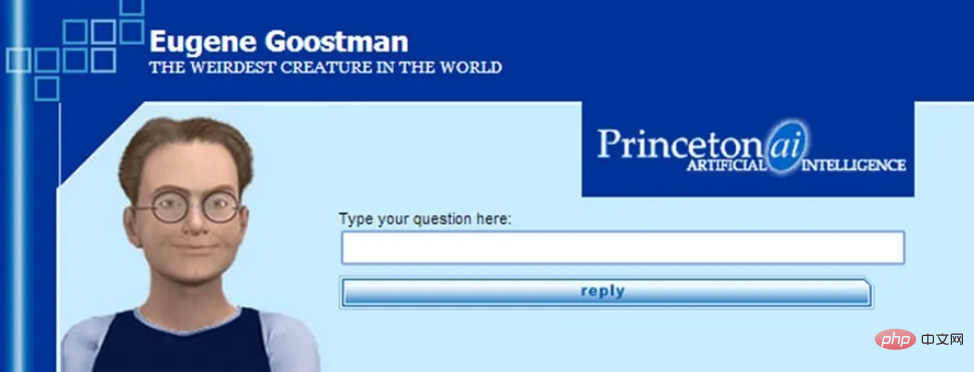

如果GPT-4在沒有任何限制的情況下通過圖靈測試,這的確將會創造歷史。雖然先前一些AI模型也曾聲稱通過圖靈測試,但都未曾得到AI業界的一致認可。這是由於圖靈測試的標準和規則並不明確,因此許多模型在測試中巧妙地利用了一些「盲點」。英國雷丁大學在2014年推出的AI模型「尤金」就是一個典型的例子,當時雷丁大學對評審聲稱,該模型是一位13歲的烏克蘭男孩,因此當演算法無法給出很好的答案時,評審會認為這是由於受測者是外國兒童的緣故。

圖源:網路

#雖然圖靈測試並不是AI技術的絕對參考點,但作為迄今為止最久遠、最廣為人知的AI技術測試,圖靈測試仍有很大的象徵意義。如果GPT-4真的正式且肯定的通過了圖靈測試,那麼它將極有可能創造迄今為止AI界最大的一座里程碑。

除此之外,與GPT-3不同的是,GPT-4將很有可能不隻隻是一個語言模型。 OpenAI首席科學家Ilya Sutskever曾在其撰寫的多模態相關文章中暗示過這一點——「文字本身即可表達關於這個世界的大量信息,但畢竟是不完整的,因為我們也生活在視覺世界之中。」因此,業界部分專家認為GPT-4將會是多模態的,可以接受音頻、文本、圖像甚至是視頻輸入,並預測OpenAI的Whisper的音頻數據集將用於創建GPT-4所需的文字資料。這也意味著GPT-4對於外在訊息的接收與處理將不會再有任何限制。

#而產業界關注GPT-4的原因,則很有可能是由於GPT-4的實際商用門檻將比傳統GPT-3更低。先前因巨額費用和基礎設施原因而未能使用相關技術的企業也將有望使用GPT-4。目前GPT-4已進入上市的最後階段,將於今年12月至明年2月期間發表。劍橋AI研究公司分析師Alberto Garcia通發表了部落格並預測:「GPT-4將更專注於優化數據處理,因此GPT-4的學習成本預計將低於GPT-3。GPT-4的每集學習成本將可能由GPT-3的數百萬美元將至100萬美元左右」。

3、殊道同歸:模擬人腦或來得更快

#如果以上資訊全部屬實,那麼此刻我們可以預見,隨著GPT-4的發布,明年深度學習研究領域將迎來一輪新的熱潮;各行業中將可能出現大量更加高級、更加自然且幾乎無法辨別其身份真偽的聊天服務機器人;在此基礎上,也將會有更多高品質的個人化AI服務從不同的傳統業務中誕生;我們也將極有可能第一次實現與認知智能的無障礙交流。

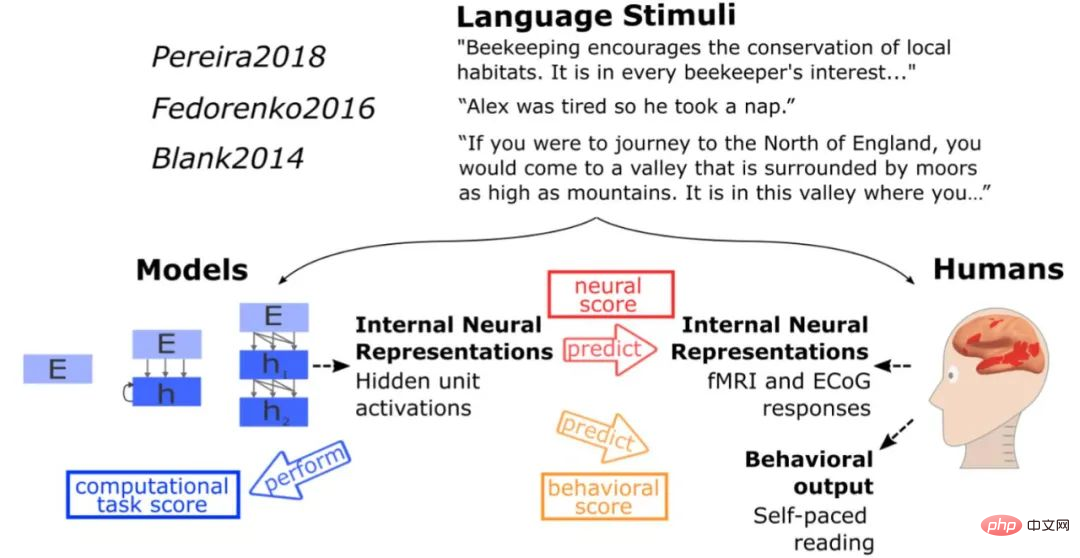

再說回開篇提到的製造人腦或說模擬人腦的問題。根據MIT的研究顯示,雖然GPT-3中的神經網路並沒有試圖直接模仿人類大腦,但GPT-3所呈現的語言處理方式與人類大腦進化過程所得到的解決方案存在一定的相似性,當向模型輸入與測試人腦相同的刺激時,模型獲得了與人腦同類型的激活,且在40餘種語言模型測試中,GPT-3幾乎做出了完美的推斷,這些模型的基本功能的確類似人類大腦語言處理中心的功能。對此,史丹佛大學心理學和電腦科學助理教授Daniel Yamins也表示:「人工智慧網路並沒有直接模仿大腦,但最終看起來卻像大腦一樣,這在某種意義上表明,人工智慧和自然之間似乎發生了某種趨同演化」。

圖源:網路

#由此可見,雖然GPT系列模型並沒有直接採用藍腦計畫項目中的模擬大腦結構的設計思路,但其呈現的效果似乎比藍腦計畫項目更接近我們的期望。因此,如果這項研究方向真的切實可行,且GPT-4能夠在GPT-3的基礎上實現某些方面的跨越性突破,那麼我們距離模擬人腦的部分功能的目標將更進一大步。

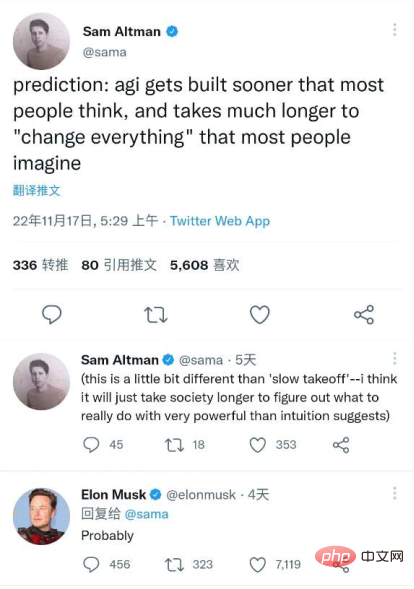

最後,我想引用OpenAI CEO Sam Altman近期在Twitter上發表的一段文字作為結尾,而這段話也得到了「矽谷鋼鐵人」Elon Musk的認可—— 「通用人工智慧的建立會比大多數人想像的更快,並且它會通過很長的時間來『改變』大多數人想像中的一切」。

圖片來源:推特

參考連結:

https:/ /dzone.com/articles/what-can-you-do-with-the-openai-gpt-3-language-mod

https://analyticsindiamag.com/gpt-4-is-almost- here-and-it-looks-better-than-anything-else/

https://analyticsindiamag.com/openais-whisper-might-hold-the-key-to-gpt4/

以上是GPT4發佈在即堪比人腦,多位圈內大佬坐不住了!的詳細內容。更多資訊請關注PHP中文網其他相關文章!