推理速度比Stable Diffusion快2倍;視覺Transformer統一圖像文本

- WBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWBOYWB轉載

- 2023-04-13 23:55:011653瀏覽

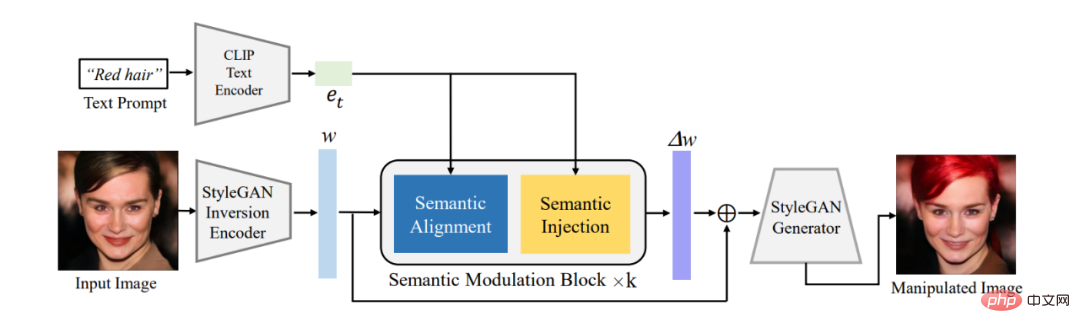

論文1:One Model to Edit Them All: Free-Form Text-Driven Image Manipulation with Semantic Modulations

- 作者:Yiming Zhu 、 Hongyu Liu 等

- 論文網址:https://arxiv.org/pdf/2210.07883.pdf

#摘要:本文首先利用已有的編碼器將需要編輯的影像轉換到StyleGAN 的W^ 語意空間中的潛在編碼w,再透過提出的語意調製模組對此隱編碼進行自適應的調變。此語義調製模組包括語義對齊和語義注入模組,首先透過注意力機制對齊文字編碼和GAN 的隱編碼之間的語義,再將文字訊息注入到對齊後的隱編碼中,從而保證該隱編碼擁有文本資訊從而達到利用文字編輯圖像能力。

不同於經典的StyleCLIP 模型,我們的模型不需要對每個文字單獨訓練一個模型,一個模型就可以響應多個文字從而對圖像做有效的編輯,所以我們的模型成為FFCLIP-Free Form Text-Driven Image Manipulation。同時我們的模型在經典的教堂,人臉以及汽車資料集上都取得了非常好的效果。

#圖1:整體框架圖

推薦:

文字圖片編輯新範式,單一模型實現多文字引導影像編輯。

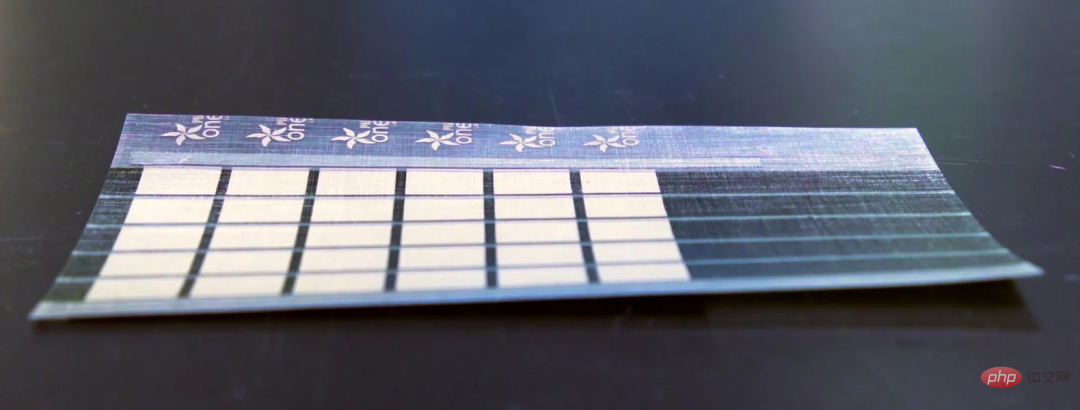

論文2:Printed Organic Photovoltaic Modules on Transferable Ultra-thin Substrates as Additive Power Sources- #作者:Mayuran Saravanapavanantham、Jeremiah Mwaura 等

- 論文地址:https://onlinelibrary.wiley.com/doi/10.1002/smtd.202200940

摘要:

麻省理工學院的研究人員已經開發出一種可擴展的製造技術,可以生產超薄、輕質的太陽能電池,這種電池可以鋪設在任何表面上。

MIT 的研究人員製造了比人類頭髮還薄的太陽能板,該板每公斤提供的能量是目前玻璃和矽基太陽能板的 18 倍。這些太陽能板的重量只有傳統光電電池的百分之一。

這種超薄太陽能板也可以安裝到船帆、無人機機翼和帳篷上。它們在偏遠地區和救災行動中尤其有用。

#推薦:

MIT 造出薄如紙的太陽能板。

論文3:A Survey of Deep Learning for Mathematical Reasoning- 作者:Pan Lu、 Liang Qiu 等

- 論文網址:https://arxiv.org/pdf/2212.10535.pdf

#摘要:###在近期發布的一篇報告中,來自UCLA 等機構的研究者係統回顧了深度學習在數學推理方面的進展。 ######

具體而言,本文討論了各種任務和資料集(第2 節),並研究了神經網路(第3 節)和預訓練語言模型(第4 節)在數學領域的進展。另外也探討了大型語言模型的脈絡學習在數學推理中的快速發展(第 5 節)。文章進一步分析了現有的基準,發現對多模態和低資源環境的關注較少(第 6.1 節)。基於實證的研究表明,目前的計算能力表徵是不充分的,深度學習方法在數學推理方面也是不一致的(第 6.2 節)。隨後,作者建議在概括性和魯棒性、可信推理、從回饋中學習和多模態數學推理方面改進目前的工作(第 7 節)。

建議:深度學習如何慢慢推開數學推理的閘。

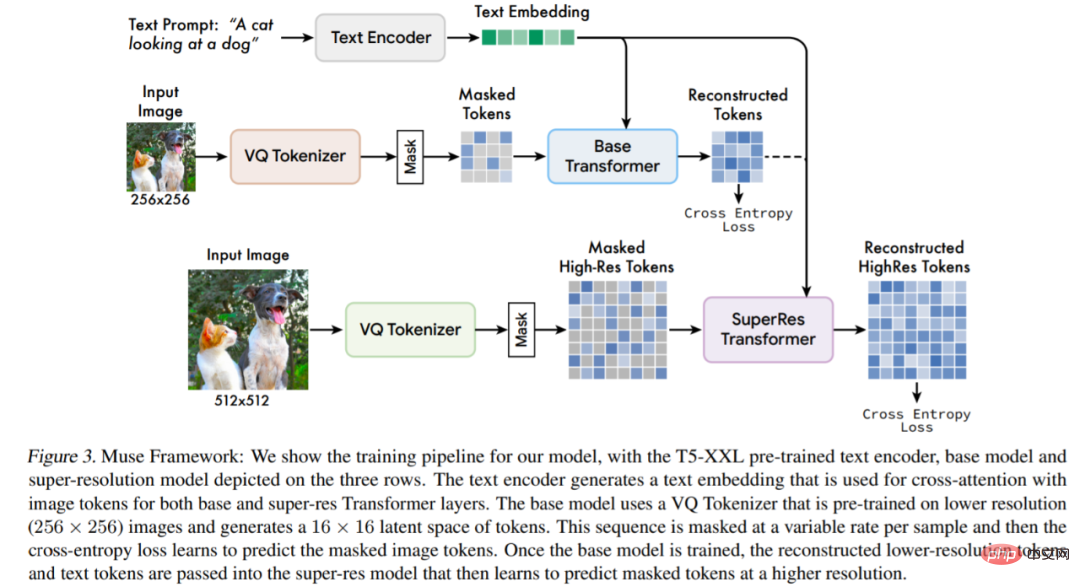

論文4:Muse: Text-To-Image Generation via Masked Generative Transformers

- #作者:Huiwen Chang 、 Han Zhang 等

- #論文網址:https://arxiv.org/pdf/2301.00704v1.pdf

#摘要:該研究提出了一種使用掩碼圖像建模方法進行文字到圖像合成的新模型,其中的圖像解碼器架構以來自預訓練和frozen T5-XXL 大型語言模型(LLM) 編碼器的嵌入為條件。

與建立在級聯像素空間(pixel-space)擴散模型上的Imagen (Saharia et al., 2022) 或Dall-E2 (Ramesh et al., 2022) 相比,Muse 由於使用了離散token,效率顯著提升。與 SOTA 自回歸模型 Parti (Yu et al., 2022) 相比,Muse 因使用平行解碼而效率更高。

基於在TPU-v4 上的實驗結果,研究者估計Muse 在推理速度上比Imagen-3B 或Parti-3B 模型快10 倍以上,比Stable Diffusion v1.4 (Rombach et al., 2022) 快2 倍。研究者認為:Muse 比 Stable Diffusion 推理速度更快是因為 Stable Diffusion v1.4 中使用了擴散模型,在推理時明顯需要更多迭代。

模型體系架構概述。

推薦:推理速度比 Stable Diffusion 快 2 倍,產生、修復圖片Google一個模型搞定。

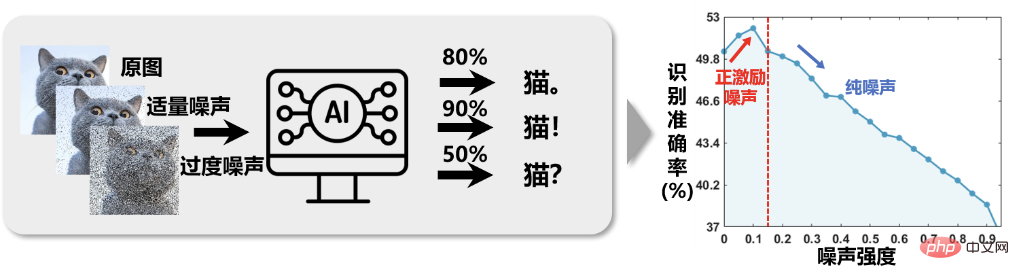

論文5:Positive-Incentive Noise

- 作者:李學龍

- #論文網址:https://ieeexplore.ieee.org/document/10003114

摘要:在各式各樣的科學研究的方方面面中,噪聲大量存在,如儀器精度不足導致的儀器誤差、人為操作中的失誤導致的偏差、極端環境等外界幹擾導致的信息失真等。研究者普遍認為噪音通常會對執行的任務產生不良影響,這已成為一個約定俗成的假設。因此,圍繞著 「降噪」 這項核心任務產生了大量的研究工作。然而,西北工業大學李學龍教授團隊在執行訊號探測和處理任務時經過實驗觀察驗證,對這一假設產生了質疑:科學研究中的噪音真的總是有害的嗎?

正好如圖 1 所示,在一個影像智慧分類系統中,對影像加入適量的雜訊後再訓練,辨識準確率反而上升了。這給我們帶來一點啟發:圖像中加入一些噪聲,而不是去除,再執行圖像分類任務,可能效果會更好。只要噪音對目標的影響遠小於噪音對背景的影響,產生 「傷敵(背景噪音)一千,自(目標訊號)損八百」 的效果就有意義,因為任務追求的是高信噪比。從本質上來說,面對傳統分類問題,在特徵後隨機加上適度的噪聲,相當於升高了特徵維度,某種意義上說,類似是給特徵增加了一個核函數,實際上完成了一種低維度空間到高維度空間的映射,使資料更可分,從而提高了分類效果。

圖 1 影像辨識準確度隨影像雜訊強度的增加而 「反直覺」 地呈現出 「先增後減」 的關係。

推薦:西工大李學龍教授提出基於任務熵的數學分析架構。

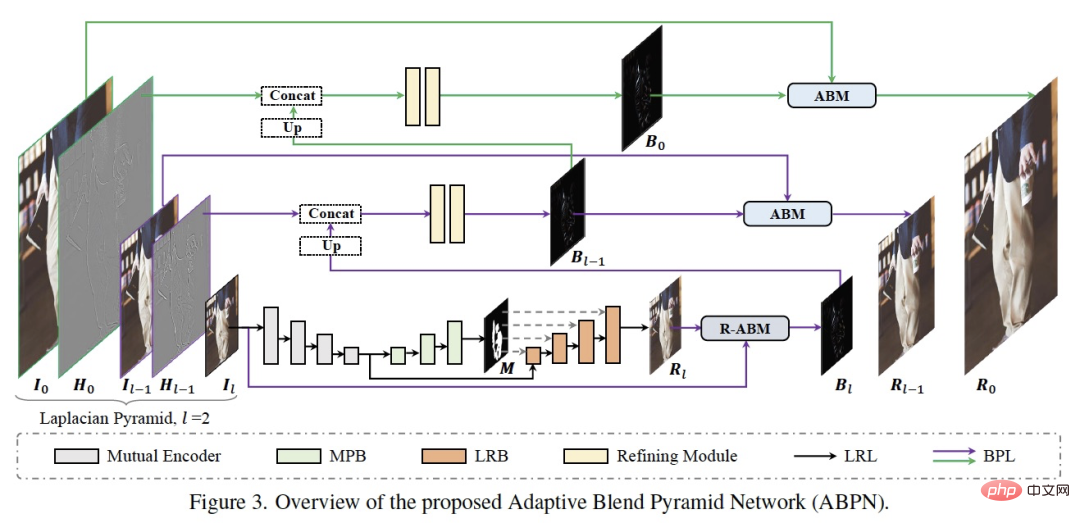

論文6:ABPN: Adaptive Blend Pyramid Network for Real-Time Local Retouching of Ultra High-Resolution Photo

- 作者:Biwen Lei 、 Xiefan Guo 等

- 論文地址:https://openaccess.thecvf.com/content/CVPR2022/ papers/Lei_ABPN_Adaptive_Blend_Pyramid_Network_for_Real-Time_Local_Retouching_of_CVPR_2022_paper.pdf

#來自開度,研發了一套高清影像的超精細局部修圖演算法ABPN,在超清影像中的美膚與服飾去皺任務中都實現了很好的效果與應用。

如上圖所示,網路結構主要由兩個部分組成:上下文感知的局部修飾層(LRL)和自適應混合金字塔層(BPL)。其中 LRL 的目的是對降採樣後的低解析度影像進行局部修飾,產生低解析度的修飾結果圖,充分考慮全局的上下文資訊以及局部的紋理資訊。進一步,BPL 用於將 LRL 中產生的低解析度結果逐步向上拓展到高解析度結果。其中,我們設計了一個自適應混合模組(ABM)及其逆向模組(R-ABM),利用中間混合圖層Bi,可實現原圖與結果圖之間的自適應轉換以及向上拓展,展現了強大的可拓展性和細節保真能力。我們在臉部修飾及服飾修飾兩個資料集中進行了大量實驗,結果顯示我們的方法在效果和效率上都大幅領先了現有方法。值得一提的是,我們的模型在單卡 P100 上實現了 4K 超高解析度影像的即時推理。

建議:一鍵抹去瑕疵、褶皺。

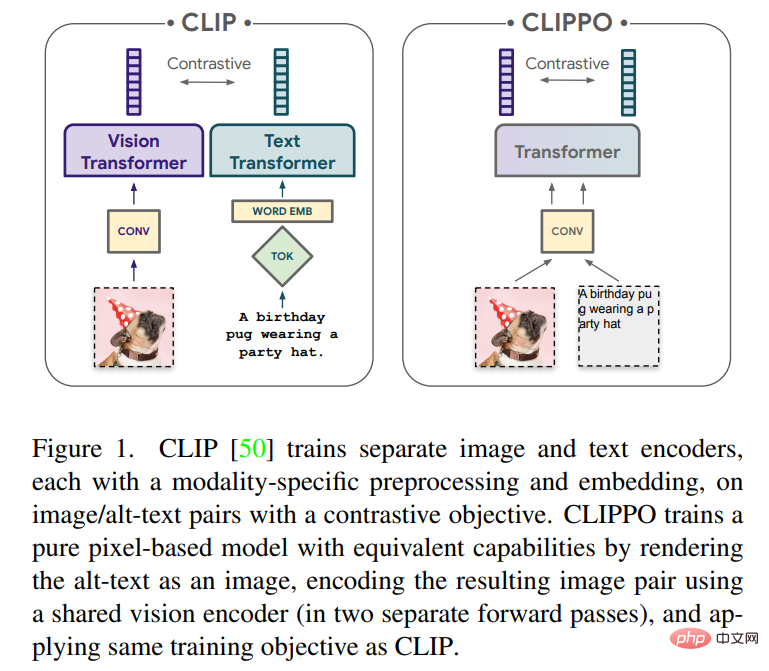

論文7:Image-and-Language Understanding from Pixels Only

- 作者: Michael Tschannen、Basil Mustafa 等

- 論文網址:https://arxiv.org/pdf/2212.08045.pdf

#摘要:發展一個可以處理任何模態或模態組合的單一端對端模型,將是多模態學習的重要一步。本文中,來自谷歌研究院(Google大腦團隊)、蘇黎世的研究者將主要關注圖像和文字。

本文將對使用純基於像素的模型進行文字和圖像的多模態學習進行探索。該模型是一個單獨的視覺 Transformer,它處理視覺輸入或文本,或兩者一起,所有都呈現為 RGB 圖像。所有模態都使用相同的模型參數,包括低階特徵處理;也就是說,不存在特定於模態的初始卷積、tokenization 演算法或輸入嵌入表。此模型僅用一個任務訓練:對比學習,如 CLIP 和 ALIGN 所推廣的。因此模型被稱為 CLIP-Pixels Only(CLIPPO)。

推薦:參數減半、與 CLIP 一樣好,視覺 Transformer 從像素入手實現圖像文字統一。

ArXiv Weekly Radiostation

機器之心聯合由楚航、羅若天發起的ArXiv Weekly Radiostation,在7 Papers 的基礎上,精選本週更多重要論文,包括NLP、CV 、ML領域各10 篇精選,並提供音訊形式的論文摘要簡介,詳情如下:

10 NLP Papers音訊:#00:0020:02

#本週10 篇NLP 精選論文是:

1. Rethinking with Retrieval: Faithful Large Language Model Inference. (from Hongming Zhang , Dan Roth)

2. Understanding Political Polarisation using Language Models: A dataset and method. (from Bhiksha Raj)

3. Towards Table-to-Text Generation with Pretrained Language Model: A Table Structure Understanding and Text Deliberating Approach. (from Hui Xiong)

4. Examining Political Rhetoric with Epistemic Stance Detection.##4. Examining Political Rhetoric with Epistemic Stance Detection.

##4. Examining Political Rhetoric with Epistemic Stance Detection.(from Brendandan O'Connor)

5. Towards Knowledge-Intensive Text-to-SQL Semantic Parsing with Formulaic Knowledge. (from Min-Yen Kan)

#6. Leveraging World Knowledge in Implicit Hate Speech Detection. (from Jessica Lin)

7. Neural Codec Language Models are Zero-Shot Text to Speech Synthesizers. (from Furu

8. EZInterviewer: To Improve Job Interview Performance with Mock Interview Generator. (from Tao Zhang)

#9. Memory Augmented Lookup Dictionary based Language Modeling for Automatic Speech Recognition. (from Yuxuan Wang)

10. Parameter-Efficient Fine-Tuning Design Spaces. (from Diyiyi Yang)

#n

10 CV Papers音訊:

##00:0021:06

#本週10 篇CV 精選論文是:

### ###1. CA$^2$T-Net: Category-Agnostic 3D Articulation Transfer from Single Image. (from Jitendra Malik)############2. Mapping smallholder cashew plantations to inform sustainable###2. Mapping smallholder cashew plantations to inform sustainable###2. Mapping smallholder cashew plantations to inform sustainable###2.) tree crop expansion in Benin. (from Vipin Kumar)############3. Scale-MAE: A Scale-Aware Masked Autoencoder for Multiscale Geospatial Representation Learning. (from Trevor Darrell)#### ########4. STEPs: Self-Supervised Key Step Extraction from Unlabeled Procedural Videos. (from Rama Chellappa)############5. Muse: Text-To-Image Generation via Masked Generative Transformers. (from Ming-Hsuan Yang, Kevin Murphy, William T. Freeman)############6. Understanding Imbalanced Semantic Segmentation Through Neural Collapse. (from Xiangyu Zhang, Jiaya Jia) ############7. Cross Modal Transformer via Coordinates Encoding for 3D Object Dectection. (from Xiangyu Zhang)#############8. Learning Road Scene-level Representations via Semantic Region Prediction. (from Alan Yuille)############9. Learning by Sorting: Self-supervised Learning with Group Ordering Constraints. (from Bernt Schiele)#####10。 AttEntropy:使用語意分割變壓器的空間注意力熵來分割複雜場景中的未知物件。 (來自 Pascal Fua)

10 ML 論文音訊:00:0023:15

#本週第10 篇ML 精選論文是:

##1.相關資訊原理的自組織保留圖結構學習。 (來自 Philip S. Yu)

2。透過產生對抗網路修改查詢擴展,用於電子商務中的資訊擷取。 (來自阿爾坦·卡基爾)

3。透過尋找相關子空間來解開神經網路預測的解釋。 (來自克勞斯-羅伯特·穆勒)

4。 L-HYDRA:多頭物理資訊神經網路。 (來自喬治·艾姆·卡尼亞達基斯)

5。關於 Transformer 改造強化學習:發展軌跡。 (摘自陶大成)

6.增強神經網路來反編譯最佳化的二進位。 (陳凱)

7. NeuroExplainer:細粒度注意力解碼揭示早產兒的皮質發育模式。 (來自沉定剛)

8.類人小樣本學習理論。 (來自李明)

9.具有壓縮更新的時差學習:錯誤回饋與強化學習的結合。 (來自喬治·J·帕帕斯)

10。透過逆多邊際最優傳輸從聚合資料估計潛在人口流。 (查宏遠)

以上是推理速度比Stable Diffusion快2倍;視覺Transformer統一圖像文本的詳細內容。更多資訊請關注PHP中文網其他相關文章!