清北聯合出品!一篇Survey整明白「Transformer+強化學習」的來龍去脈

- PHPz轉載

- 2023-04-13 14:01:031159瀏覽

Transformer模型自發布後,很快就成了自然語言處理和電腦視覺領域在有監督學習設定下的主流神經架構。

雖然Transformer的熱潮已經開始席捲強化學習領域,但由於RL本身的特性,例如需要進行獨特的特徵、架構設計等,目前Transformer與強化學習的結合並不順利,其發展路線也缺乏相關論文進行貫穿性地總結。

最近來自清華大學、北京大學、騰訊的研究人員聯手發表了一篇關於Transformer與強化學習結合的研究論文,系統性地回顧了在強化學習中使用Transformer的動機和發展歷程。

論文連結:https://arxiv.org/pdf/2301.03044.pdf

文章中對現有的相關工作成果進行分類,並對每個子領域進行深入討論,最後也總結了該研究方向的未來前景。

Transformer配RL

強化學習(RL)為序列決策(sequential decision-making)提供了一個數學化的形式,可以讓模型自動獲得智慧行為。

RL為基於學習的控制提供了一個通用框架,隨著深度神經網路的引入,深度強化學習(DRL)的通用性在近年來也取得了巨大的進展,但樣本效率問題阻礙了DRL在現實世界中的廣泛應用。

為了解決這個問題,一個有效的機制是在DRL框架中引入inductive bias,其中比較重要的是函數近似器架構的選擇(the choice of function approximator architectures),例如DRL智能體的神經網路的參數化。

然而,與監督學習(SL)中的架構設計相比,在DRL中選擇架構設計的問題仍然沒有得到充分的探討,大多數現有的關於RL架構的工作是由(半)監督學習社群的成功所激發的。

例如,處理DRL中基於影像的高維度輸入的常見做法是引入卷積神經網路(CNN);處理部分可觀察性的另一種常見做法是引入遞歸神經網路(RNN)。

近年來,Transformer架構在廣泛的SL任務中徹底改變了學習範式,並表現出比CNN和RNN更優越的效能,例如Transformer架構能夠對較長的依賴關係進行建模,並具有出色的可擴展性。

受SL成功啟發,業界對在強化學習中應用Transformer的興趣激增,最早可以追溯到2018年的一篇論文,其中自註意機制被用於結構化狀態表示的關係推理。在

之後,許多研究人員開始試圖將自註意力應用於表示學習,以提取實體之間的關係,從而可以更好地進行策略學習。

除了狀態表示學習外,先前的工作還用Transformer來捕捉多步驟的時間依賴性,以處理部分可觀察性問題。

最近,離線RL由於其利用離線大規模資料集的能力而受到關注,相關研究結果也表明,Transformer架構可以直接作為序列決策的模型,並可推廣到多個任務和領域。

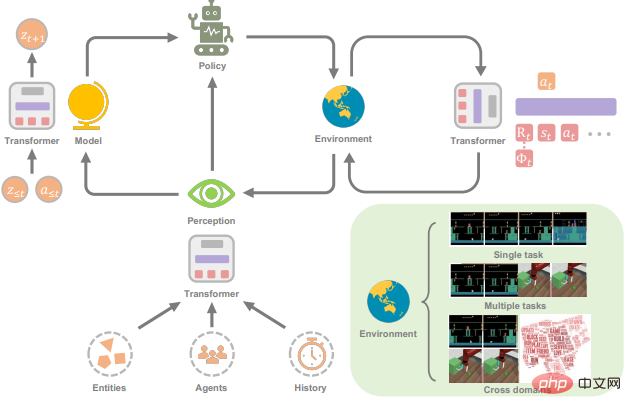

這篇研究論文的目的是介紹Transformers in Reinforcement Learning領域(TransformRL)。

儘管Transformer已經被認為是目前大多數SL研究的基礎模型,但它在RL社群的探索仍然較少。事實上,與SL領域相比,在RL中使用Transformer作為函數近似器需要解決一些不同的問題:

1. RL智能體的訓練資料通常是當前策略的函數,這在Transformer學習的過程中會造成不平穩性(non-stationarity)。

2. 現有的RL演算法通常對訓練過程中的設計選擇高度敏感,包括網路架構和容量等。

3. 基於Transformer的架構經常受到高運算和記憶體成本的影響,也就是說訓練和推理起來既慢又貴。

例如在一些遊戲中的人工智慧案例中,樣本生成的效率在很大程度上影響了訓練效能,取決於RL策略網路和價值網路的運算成本。

TransformRL的未來

論文中簡要回顧了Transformers for RL的進展情況,其優點主要包括:

1. Transformers可以作為RL中的一個powerful模組,例如作為一個表示模組或世界模型;

2. Transformer可以作為序列決策器;

3. Transformer可以提升跨任務和領域的泛化效能。

鑑於Transformer在更廣泛的人工智慧社群中都表現出強大的性能,研究人員認為將Transformer和RL結合起來是一個有前途的研究方向,以下是一些關於該方向的未來前景和開放性問題。

結合強化學習和(自)監督學習

追溯TransformRL的發展,可以發現其訓練方法同時涵蓋了RL和(自)監督學習。

當作為一個在傳統RL框架下訓練的表示模組時,Transformer架構的最佳化通常是不穩定的。當使用Transformer透過序列建模來解決決策問題時,(自)監督學習範式可以消除deadly triad problem。

在(自)監督學習的框架下,策略的效能深受離線資料品質的約束,利用(exploitation)和探索(exploration)之間的明確權衡不復存在,因此在Transformer學習中結合RL和(自)監督學習時,可能會學到更好的策略。

有些工作已經嘗試了監督預訓練和RL參與的微調方案,但在相對固定的策略下,探索會受到限制,這也是有待解決的瓶頸問題之一。

另外,沿著這條路線,用於效能評估的任務也相對簡單,Transfomer是否可以將這種(自)監督學習擴展到更大的資料集、更複雜的環境和現實世界的應用也值得進一步探索。

此外,研究人員希望未來的工作能提供更多的理論和經驗見解,以確定在哪些條件下這種(自)監督學習有望表現良好。

透過Transformer連接線上與離線學習

踏入離線RL是TransformRL的一個里程碑,但實際上,利用Transformer來捕捉決策序列中的依賴關係並抽像出策略,主要是與所使用的相當多的離線資料的支援分不開的。

然而,對於一些決策任務來說,在實際應用中擺脫線上框架是不可行的。

一方面,在某些任務中獲得專家資料並不那麼容易;另一方面,有些環境是開放式的(如Minecraft),這意味著策略必須不斷調整,以處理在線互動過程中未見的任務。

因此,研究人員認為把線上學習和離線學習連結在一起是必要的。

Decision Transformer之後的大多數研究進展都集中在離線學習框架上,一些工作試圖採用離線預訓練和線上微調的範式。然而,在線微調中的分佈轉變仍然存在於離線RL演算法中,研究人員期望透過對Decision Transformer進行一些特殊設計來解決這個問題。

此外,如何從頭開始訓練一個線上Decision Transformer是一個有趣的開放性問題。

為Decision-making問題量身訂做的Transformer結構

目前Decision Transformer系列方法中的Transformer結構主要是vanilla Transformer,它最初是為文字序列設計的,可能具有一些不適合決策問題的性質。

例如,對軌跡序列採用vanilla的自註意力機制是否適合?決策序列中的不同元素或同一元素的不同部分是否需要在位置embedding中區分?

此外,由於在不同的Decision Transformer演算法中,將軌跡表示為序列的變體有很多,如何從中選擇,仍缺乏系統的研究。

例如,在業界部署此類演算法時,如何選擇穩健的hindsight資訊?

並且vanilla Transformer也是一個計算成本巨大的結構,這使得它在訓練和推理階段都很昂貴,而且內存佔用率很高,也限制了它捕獲依賴關係的長度。

為了緩解這些問題,NLP中的一些工作改進了Transformer的結構,但類似的結構是否可以用於決策問題也值得探討。

用Transformer實作更多的通用智能體

論文中對通用智能體(generalist agents)Transformers的回顧已經顯示了Transformers作為通用策略的潛力。

事實上,Transformer的設計允許使用類似處理blocks的方式來處理多種模態(如圖像、視訊、文字和語音),並展示了對超大容量網路和巨大數據集的出色可擴展性。

最近的工作也在訓練能夠執行多模態和跨領域任務的智能體上取得了重大進展。

不過,鑑於這些智能體是在大規模的資料集上進行訓練的,目前還不能確定它們是否只是記住了資料集,以及它們是否能進行有效的泛化。

因此,如何學習到一個能夠在沒有強假設(strong assumption)的情況下對未見過的任務進行泛化的智能體仍然是一個值得研究的問題。

此外,研究人員也很好奇,Transformer是否足夠強大到可以用來學習一個可用於不同任務和場景的通用世界模型。

RL for Transformers

#雖然文章中已經討論了RL如何從Transformer模型中受益,但反過來說,用RL來提升Transformer訓練仍然是一個有趣的開放性問題,還沒有被很好地探索過。

可以看到,最近來自人類回饋的強化學習(RLHF)可以學習到一個獎勵模型,並使用RL演算法對Transformer進行微調,以使語言模型與人類意圖相一致。

在未來,研究人員認為RL可以成為一個有用的工具,進一步完善Transformer在其他領域的表現。

以上是清北聯合出品!一篇Survey整明白「Transformer+強化學習」的來龍去脈的詳細內容。更多資訊請關注PHP中文網其他相關文章!