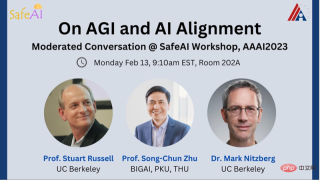

Mark Nitzberg:今天我們很榮幸邀請到兩位人工智慧的頂尖專家來參與本次 SafeAI 研討會。

他們分別是:Stuart Russell,加州大學柏克萊分校電腦科家,類別相容人工智慧中心(CHAI)主任,人工智慧研究實驗室指導委員會(BAIR)成員。世界經濟論壇人工智慧和機器人委員會副主席,AAAS Fellow,AAAI Fellow。

朱松純,北京通用人工智慧研究院院長,北京大學講席教授,北京大學智能學院、人工智慧研究院院長,清華大學基礎科學講席教授。

Mark Nitzberg:什麼是 "通用人工智慧"?是否有一個定義明確的測試可以確定我們何時創造了它?

Stuart Russell:通用人工智慧被描述為可以完成人類能夠完成的所有任務,但這只是一個大概的說法。我們希望通用人工智慧能夠做到人類無法做到的事情,例如總結所有知識或模擬複雜的粒子相互作用等等。

為了研究通用人工智慧,我們可以從具體任務的基準(Benchmarks) 轉向任務環境的一般屬性,例如部分可觀察性、長時程、不可預測性等等,並問自己是否有能力為這些屬性提供完整的解決方案。如果我們有這種能力,通用人工智慧就應該能夠自動地完成人類可以完成的任務,並且還有能力完成更多的任務。雖然有一些測試(例如BigBench) 聲稱可以測試通用性,但它們並沒有包含那些人工智慧系統無法接近的任務,例如「你能發明一個重力波的探測器嗎?」

朱松純:幾年前,很多人認為實現通用人工智慧是一個遙不可及的目標,然而最近ChatGPT 的火爆讓大家又充滿了期待,覺得通用人工智慧似乎觸手可及了。當我在中國組成北京通用人工智慧研究院 (BIGAI) 這一新型研發機構時,特別決定將 AGI 作為機構名稱的一部分,以區別於專用的人工智慧。通院的 「通」 字正是由 「A」「G」「I」 三個字母組成。根據「通」字發音,我們也把通用人工智慧稱為TongAI。

通用人工智慧是人工智慧研究的初心和終極目標。目標是實現具有自主性的感知、認知、決策、學習、執行和社會協作能力,符合人類情感、倫理與道德觀念的通用智能體。然而,在過去的 20-30 年中,人們用海量的分門別類的資料來一個個解決人臉辨識、目標偵測、文字翻譯等任務,這帶來了一個問題,那就是完成多少任務才算是通用?

我認為實作通用人工智慧需要滿足三個關鍵要求。 1)通用智能體能夠處理無限任務,包括那些在複雜動態的物理和社會環境中沒有預先定義的任務;2)通用智能體應該是自主的,也就是說,它應該能夠像人類一樣自己產生並完成任務;3)通用智能體應該具有一個價值系統

###############因為它的目標是由價值定義的。智慧系統是由具有價值系統的認知架構所驅動的。 ##################Mark Nitzberg:你們認為大型語言模型(LLMs)以及其他基礎型能夠實現通用人工智慧嗎?史丹佛大學教授最近撰寫的一篇論文聲稱,語言模型可能具有與 9 歲兒童相當的心理狀態。你們對這種說法有什麼看法? #####################朱松純:###雖然大型語言模型已經取得了一些驚人的進展,但如果我們比較上述三個標準,就會發現大型語言模型還不符合通用人工智慧的要求。 ######

1) 大型語言模型在處理任務方面的能力有限,它們只能處理文本領域的任務,無法與物理和社會環境互動。這意味著像 ChatGPT 這樣的模型不能真正 “理解” 語言的含義,因為它們沒有身體來體驗物理空間。中國的哲學家早就認識到 「知行合一」 的理念,即人對世界的 「知」 是建立在 「行」 的基礎上的。這也是通用智能體能否真正進入實體場景和人類社會的關鍵。只有將人工智慧體放置在真實的物理世界和人類社會中,它們才能切實了解並習得真實世界中事物之間的物理關係和不同智能體之間的社會關係,從而做到“知行合一” 。

2) 大型語言模型也不是自主的,它們需要人類來具體定義好每一個任務,就像一隻"巨鸚鵡",只能模仿被訓練過的話語。真正自主的智能應該類似於 “烏鴉智能”,烏鴉能夠自主完成比現如今的 AI 更加智能的任務,當下的 AI 系統還不具備這種潛能。

3) 雖然ChatGPT 已經在不同的文本資料語料庫上進行了大規模訓練,包括隱含人類價值的文本,但它並不具備理解人類價值或與人類價值保持一致的能力,即缺乏所謂的道德指南針。

關於論文發現語言模型可能具有與9 歲兒童相當的心理狀態這件事,我認為這有些誇大其詞了,這篇論文透過一些實驗測試發現,GPT-3.5可以正確回答93% 的問題,相當於9 歲兒童等級。但是,如果一些基於規則的機器也可以通過類似的測試,那我們可以說這些機器就有心智理論了嗎?即使GPT 能夠通過這個測試,也只是體現了它具備通過這個心智理論測試的能力,並不能說明它具有心智理論,同時我們也要反思:用這些傳統測試任務來驗證機器是否發展出心智理論的做法是否嚴謹合法?為何機器可以不用心智理論就能完成這些任務?

Stuart Russell:在 1948 年的一篇論文中,圖靈提出了從一個巨大的查找表中生成智能為的問題。這並不實際,因為如果要產生 2000 個單詞,就需要一個包含約 10^10000 個條目的表來儲存所有的可能序列,就像利用 transformer 的大型語言模型的視窗大小一樣。這樣的系統看起來可能非常聰明,但實際上它缺乏心理狀態和推理過程(經典人工智慧系統的基本意義)。

實際上,並沒有證據顯示 ChatGPT 有任何心理狀態,更不用說類似 9 歲孩子的心理狀態了。 LLMs 缺乏學習和表達複雜概括的能力,這就是為什麼它們需要大量的文字數據,遠遠超過任何 9 歲孩子所能接受的範圍,而且它們仍然會產生錯誤。這就好像一個下棋程序,透過辨識先前大師級比賽中的相似棋步序列(如 d4、c6、Nc3 等),然後輸出該序列中的下一步棋。儘管大多數情況下你會認為它是一個大師級的棋手,但是它會偶爾下出違規的棋步,因為它並不知道棋盤和棋子,也不知道目標是把對手將死。

在某種程度上,ChatGPT 在每個領域都是如此。我們不確定是否有任何領域是它真正理解的。有些錯誤可能會被修正,但這就像修正對數函數值表中的錯誤一樣。如果一個人只理解 "log" 是指 "第 17 頁表格中的數值",那麼修正錯字並不能解決這個問題。這張表還沒有涵蓋 "對數" 的含義和定義,因此它根本無法推斷。用更多的數據擴大表的規模並不能解決這個問題的根本。

Mark Nitzberg:Stuart,你是最早警告我們通用人工智慧給人生存帶來風險的人之一,認為它像核能源。為什麼你會這樣認為?我們怎樣才能防止這種情況?松純,你最關心的來自人工智慧的風險是什麼?

#Stuart Russell:事實上,圖靈是最早提出警告的人之一。他在1951 年說:「一旦機器開始思考,很快就能超越我們。因此,在某個時候,我們應該期望機器能夠被掌控。」因為當一個比人類更強大的智能體出現時,人類很難維持權力,特別是當這些智能體具有不正確或不完整的目標時。

如果有人認為現在考慮這些風險是危言聳聽,你可以直接問他們:你如何在比人類更強大的智能體面前永遠保持權力?我很想聽聽他們的回答。此外,在人工智慧領域,還有一些人試圖迴避這個問題,否認 AGI 的可實現性,卻沒有提供任何證據。

歐盟人工智慧法案中定義了一種標準的人工智慧系統,它們能夠根據人類定義的目標,實現這些目標。有人告訴我,這個標準來自經合組織,經合組織的人告訴我這來自我的教科書早期版本。現在,我認為標準的人工智慧系統這個定義從根本上是有缺陷的,因為我們無法完全準確地說明我們希望人工智慧在現實世界中做什麼,也無法準確地描述我們希望未來是什麼樣子。一個追求不正確目標的人工智慧系統將會帶來我們不想要的未來。

社群媒體中的推薦系統提供了一個例子—— 推薦系統試圖最大限度地提高點擊率或參與度,它們已經學會了透過操縱人類來做到這一點,透過一連串的提示將人類變成更可預測的、顯然是更極端的自己的版本。讓人工智慧變得 「更好」 只會讓人類的結果變得更糟。

相反,我們需要建立人工智慧系統,1)只以人類利益為目標,2)明確它們不知道這意味著什麼。由於人工智慧不了解人類利益的真正意義,它必須對人類的偏好保持不確定性,以確保我們對它保持控制。當機器不確定人類的偏好時,機器應該可以關閉。一旦人工智慧的目標不再有任何不確定性,人類就成了犯錯的人,機器就不會再被關閉。

朱松純:如果通用人工智慧成為現實,從長遠來看,它們可能會對人類的生存成威脅。我們可以透過回顧漫長的智慧進化史推測到,通用人工智慧的誕生幾乎是不可避免的。

現代科學研究表明,地球上的生命體不斷進化,從無機物到有機物、單細胞、多細胞生物,再到植物、動物,最後進化到人類這樣的智慧生物。這揭示了從 “物理” 到 “智能” 是一個連續的演化過程。從無生命的物體到有生命的智能,邊界在哪裡?這個問題非常重要,因為它關乎如何理解與定義未來社會與我們共存的“智能體”,我認為這個答案和“生命度” 相關,從無生命到簡單生命體再到復雜智能體,“生命度」 越來越大,「智能」 也越來越複雜,這是一個連續的頻譜,我們沒有理由認為人類會是這個進化頻譜的終點,這也預示了未來通用智能體超過人類是有可能的。

為了預防未來的通用人工智慧為人類帶來威脅,我們可以逐步放開通用智能體的能力空間和價值空間。 就像我們面對機器人一樣,一開始把它關在 “籠子” 裡,慢慢打開權限,現在特定路段已經出現了無人駕駛車輛。我們可以先將人工智慧系統的適用場合和行動空間限制在特定區域內。隨著我們對機器的信任的增加,確認 AI 系統安全可控後,再逐步給予它們更大的空間。另外,我們應該促進演算法決策過程的透明度。如果我們能夠外顯地表示通用人工智慧的認知架構,從而知道它是如何運作的,就能更好地控制它。

Mark Nitzberg:Stuart,在你的研究工作中,有哪些方向可以視為對齊研究?

Stuart Russell:我們在CHAI 的核心目標是為了實現上述的願景,即建構一個能夠處理目標不確定性的人工智慧系統 。已有的方法,可能除了模仿學習,都向人工智慧系統事先假定了一個固定已知的目標,所以這些方法可能需要被重新設計。

簡言之,我們正在嘗試模擬一個多人和多機器互動的系統。由於每個人都有自的偏好,但機器可以影響多人,因此我們將機器的效用函數定義為人的效用函數的總和。但是,我們面臨三個問題。

第一個問題是如何將不同人的偏好聚合起來,以便機器能夠理解和滿足大多數人的需求。有人提出加法可能是一個好的聚合函數,因為每個人都享有相同的權重,並且具有很好的形式感,這在經濟學家 John Harsanyi 和其他人的工作中被很好地論證。但肯定還有別的觀點。

第二個問題是我們如何表徵偏好結構的豐富性,即對宇宙的所有可能未來的分佈的排序,這些是非常複雜的數據結構,在人腦和機器都沒有被外顯地表徵。因此,我們需要一些方法來對偏好進行有效地排序、分解和組合。

目前有一些AI 研究試圖利用所謂的「CP nets」來表徵一些複雜的效用函數,CP Nets 對多屬性效用函數的分解方式與貝葉斯網對複雜的多變量機率模型的分解方式大致相同。然而,人工智慧並沒有真正研究人類幸福感的內容,鑑於該領域聲稱要幫助人類,這一點令人驚訝。在經濟學、社會學、發展學等領域,確實有研究人類幸福感的學術社區,他們傾向於編制諸如健康、安全、住房、食物等因素的清單,這些清單主要是為了與其他人類溝通優先事項和公共政策,可能沒有捕捉到許多" 顯而易見" 的未說明的偏好,如“想要腿腳健全”。據我所知,這些研究人員還沒有發展出一種科學理論來預測人類行為,但是對於人工智慧來說,我們需要完整的人類偏好結構,包括所有可能的未說明偏好;如果我們錯過了任何重要的東西,可能會導致問題。

第三個問題是如何從人類行為推論偏好,並表徵人類偏好的可塑性。 如果偏好隨著時間的推移而改變,那麼人工智慧是為誰工作 —— 今天的你還是明天的你?我們不希望人工智慧改變我們的偏好,以符合容易實現的世界狀態,這會導致世界失去多樣性。

除了這些基本的研究問題,我們還在思考如何在更廣泛的基礎上重建所有那些假定人工智慧系統在前期被賦予完全已知目標的人工智慧技術(搜尋演算法、規劃演算法、動態程式演算法、強化學習等等)。新系統的關鍵屬性是系統運作時從人類流向機器的偏好資訊。 這在現實世界中是非常正常的。例如,我們要求計程車司機 "帶我們去機場"。這實際上是一個比我們的真實目標更廣泛的目標。當我們在一英里之外時,司機會問我們需要哪個航站樓。當我們越來越接近時,司機可能會問哪家航空公司,以便把我們送到正確的門口。 (但不是確切的離門多少毫米!) 所以我們需要定義最適合於某一類演算法的不確定性和偏好轉移的形式;例如,搜尋演算法使用一個成本函數,所以機器可以假設該函數的界限,並詢問人類兩個行動序列中哪一個比較合適,從而完善該界限。

一般來說,機器總是有關於人類偏好的大量不確定性;由於這個原因,我認為在這個領域經常使用的術語"對齊" 可能會產生誤導,因為人們傾向於認為它意味著"首先完全對齊機器和人類的偏好,然後選擇做什麼"。可能事實上並不是如此。

Mark Nitzberg:松純,請介紹你們所做的價值對齊研究。

朱松純:談論價值對齊,首先要探討 “價值”,我認為當下的人工智慧研究應該由數據驅動轉變為價值驅動。人的各種智能行為是由價值所驅動的,人能夠快速理解和學習價值。例如,當你坐在椅子上時,我們可以透過椅子和身體接觸的受力分析,觀察平衡態,從而隱含地推斷出 “舒適性” 這一價值。這一價值人可能無法用語言來準確描述,但和椅子互動卻可以表達。我們也可以透過摺衣服的方式來了解人的美學價值。

此外我認為價值系統有一套統一的表徵,目前偏好的豐富性是因為統一的價值在不同條件上的映射。 我們的價值會隨著情況的不同而改變,舉個例子,一輛公車到站,如果你在等車,你可能希望公車停留時間長一點,讓你上去;而如果你在車上,你可能希望門立刻關上。人工智慧系統必須能夠快速地適應我們偏好的改變,因此,價值驅動的認知架構對人工智慧而言是必不可少的。

為達到人類認知水平的通用智能,我們在 BIGAI 的研究中納入了價值對齊這一要素,並構建了包含四個對齊的人機交互系統。 第一個對齊是一個共享的表徵,包括對世界的共同理解。第二個對齊是共享的核心知識,如物理常識、因果鍊和邏輯等。第三個對齊是共享的社會規範,規定了 AI 要遵循人類社會的規範,並保持適當的行為。第四個對齊是共享的價值觀,即 AI 需要與人類的道德原則保持一致。

我們發表了即時雙向人機價值對齊研究(Bidirectional human-robot value alignment)。這項研究提出了一個可解釋的人工智慧系統。在這個系統中,一組機器人透過與用戶的即時互動並透過用戶的回饋來推斷用戶的價值目標,同時透過 「解釋」 將其決策過程傳達給用戶,讓用戶了解機器人做出判斷的價值依據。此外,該系統透過推測使用者的內在價值偏好,並預測了最佳的解釋方式,產生使用者更容易理解的解釋。

Mark Nitzberg:AI 系統的哪些特徵讓我們判斷它們不會通往通用人工智慧?

朱松純:我們如何判斷一個 AI 是否是通用人工智慧,其中一個重要的因素就是我們對它的信任程度。 信任有兩個層次:一是對 AI 能力的信任,二是對 AI 是否對人的情感和價值有益的信任。 例如,現在的人工智慧系統可以很好地識別圖片,但要建立信任,它們必須是可解釋和可理解的。有些技術很厲害,但是不能被解釋,也會被認為是不可信的。這在武器或航空系統等領域尤其重要,因為在這些領域犯錯的代價很嚴重。在這種情況下,信任的情感維度更為重要,AI 需要解釋它們是如何做出決策的,才能被人類信任。因此我們需要通過人機之間的迭代、交流、協作增進互相理解,進而達成共識,產生 「有依據的信任」(Justified Trust)。

進一步思考,追問什麼是通用人工智慧本質上就是在追問什麼是 「人」?每個人都是一個通用智能體。我們提出了一套 UV 雙系統驅動的理論來解釋通用人工智慧體。 U 系統是位能函數,包含了智能體所掌握的客觀物理定律、社會規範;V 系統包含了智能體的價值函數的集合,參考了馬斯洛的需求層次理論和發展心理學的研究,我們將價值進行了大致分類。基於 UV 雙系統,我們嘗試對通用人工智慧的發展程度進行評估,形成 L1 到 L5 的不同標準,這套測試系統將於今年發布。

Stuart Russell:目前的人工智慧系統沒有通用性,因為電路無法很好地捕捉通用性。我們已經在大型語言模型很難學習算術的基本規則中看到了這一點。我們最新的研究發現,儘管有數百萬個例子,之前擊敗人類的人工智慧圍棋系統還是無法正確理解「大龍」 和「死活」 的概念,我們作為業餘圍棋選手的研究員開發出了一套策略,戰勝了圍棋程序。

如果我們有信心人工智慧對人類有益,那麼我們就需要知道它是如何運作的。我們需要要將人工智慧系統建立在一個語意上可組合的基質(substrate) 上,該基質由明確的邏輯和機率理論支持,從而作為一個良好的基礎,以將來實現通用人工智慧。創建這種系統的一個可能方法是機率編程,也是我們在 CHAI 最近希望探索的。看到松純也在 BIGAI 探索相似的方向,讓我感到很受鼓舞。

以上是關於AGI與ChatGPT,Stuart Russell與朱松純這麼看的詳細內容。更多資訊請關注PHP中文網其他相關文章!

最新的最佳及時工程技術的年度彙編Apr 10, 2025 am 11:22 AM

最新的最佳及時工程技術的年度彙編Apr 10, 2025 am 11:22 AM對於那些可能是我專欄新手的人,我廣泛探討了AI的最新進展,包括體現AI,AI推理,AI中的高科技突破,及時的工程,AI培訓,AI,AI RE RE等主題

歐洲的AI大陸行動計劃:Gigafactories,Data Labs和Green AIApr 10, 2025 am 11:21 AM

歐洲的AI大陸行動計劃:Gigafactories,Data Labs和Green AIApr 10, 2025 am 11:21 AM歐洲雄心勃勃的AI大陸行動計劃旨在將歐盟確立為人工智能的全球領導者。 一個關鍵要素是建立了AI Gigafactories網絡,每個網絡都有大約100,000個高級AI芯片 - 2倍的自動化合物的四倍

微軟的直接代理商故事是否足以創造更多的粉絲?Apr 10, 2025 am 11:20 AM

微軟的直接代理商故事是否足以創造更多的粉絲?Apr 10, 2025 am 11:20 AM微軟對AI代理申請的統一方法:企業的明顯勝利 微軟最近公告的新AI代理能力清晰而統一的演講給人留下了深刻的印象。 與許多技術公告陷入困境不同

向員工出售AI策略:Shopify首席執行官的宣言Apr 10, 2025 am 11:19 AM

向員工出售AI策略:Shopify首席執行官的宣言Apr 10, 2025 am 11:19 AMShopify首席執行官TobiLütke最近的備忘錄大膽地宣布AI對每位員工的基本期望是公司內部的重大文化轉變。 這不是短暫的趨勢。這是整合到P中的新操作範式

IBM啟動具有完整AI集成的Z17大型機Apr 10, 2025 am 11:18 AM

IBM啟動具有完整AI集成的Z17大型機Apr 10, 2025 am 11:18 AMIBM的Z17大型機:集成AI用於增強業務運營 上個月,在IBM的紐約總部,我收到了Z17功能的預覽。 以Z16的成功為基礎(於2022年推出並證明持續的收入增長

5 Chatgpt提示取決於別人並完全相信自己Apr 10, 2025 am 11:17 AM

5 Chatgpt提示取決於別人並完全相信自己Apr 10, 2025 am 11:17 AM解鎖不可動搖的信心,消除了對外部驗證的需求! 這五個CHATGPT提示將指導您完全自力更生和自我感知的變革轉變。 只需複制,粘貼和自定義包圍

AI與您的思想危險相似Apr 10, 2025 am 11:16 AM

AI與您的思想危險相似Apr 10, 2025 am 11:16 AM人工智能安全與研究公司 Anthropic 最近的一項[研究]開始揭示這些複雜過程的真相,展現出一種令人不安地與我們自身認知領域相似的複雜性。自然智能和人工智能可能比我們想像的更相似。 窺探內部:Anthropic 可解釋性研究 Anthropic 進行的研究的新發現代表了機制可解釋性領域的重大進展,該領域旨在反向工程 AI 的內部計算——不僅僅觀察 AI 做了什麼,而是理解它在人工神經元層面如何做到這一點。 想像一下,試圖通過繪製當有人看到特定物體或思考特定想法時哪些神經元會放電來理解大腦。 A

龍翼展示高通的邊緣動力Apr 10, 2025 am 11:14 AM

龍翼展示高通的邊緣動力Apr 10, 2025 am 11:14 AM高通的龍翼:企業和基礎設施的戰略飛躍 高通公司通過其新的Dragonwing品牌在全球範圍內積極擴展其範圍,以全球為目標。 這不僅僅是雷布蘭

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Safe Exam Browser

Safe Exam Browser是一個安全的瀏覽器環境,安全地進行線上考試。該軟體將任何電腦變成一個安全的工作站。它控制對任何實用工具的訪問,並防止學生使用未經授權的資源。

記事本++7.3.1

好用且免費的程式碼編輯器

Dreamweaver CS6

視覺化網頁開發工具

MinGW - Minimalist GNU for Windows

這個專案正在遷移到osdn.net/projects/mingw的過程中,你可以繼續在那裡關注我們。 MinGW:GNU編譯器集合(GCC)的本機Windows移植版本,可自由分發的導入函式庫和用於建置本機Windows應用程式的頭檔;包括對MSVC執行時間的擴展,以支援C99功能。 MinGW的所有軟體都可以在64位元Windows平台上運作。

PhpStorm Mac 版本

最新(2018.2.1 )專業的PHP整合開發工具