在自動駕駛技術不斷迭代的當下,車輛的行為和軌跡預測對高效率、安全駕駛有著極為重要的意義。動力學模型推演、可及性分析等傳統的軌跡預測的方法雖然有著形式明晰、可解釋性強的優點,但在複雜的交通環境中,其對於環境和物體交互的建模能力較為有限。因此,近年來大量研究和應用都基於各種深度學習方法(例如LSTM、CNN、Transformer、GNN 等),各類資料集例如BDD100K、nuScenes、Stanford Drone、ETH/UCY、INTERACTION、ApolloScape 等也紛紛湧現,為訓練和評估深度神經網路模型提供了強力支持,不少SOTA 模型例如GroupNet、Trajectron 、MultiPath 等都表現出了良好的性能。

以上模型和資料集都集中在正常的道路行駛場景下,並充分利用車道線、交通燈等基礎設施和特徵輔助預測過程;由於交通法規的限制,絕大多數車輛的運動方式也較為明確。然而,在自動駕駛的「最後一公里」— 自動停車場景下,我們將面對不少新的困難:

- 停車場內的交通規則和車道線要求並不嚴格,車輛也經常隨意行駛「抄近路」

- 為了完成泊車任務,車輛需要完成較為複雜的泊車動作,包括頻繁的倒車、停車、轉向等。在駕駛經驗不足的情況下,泊車可能成為一個漫長的過程

- 停車場內障礙物較多且雜亂,車間距離較近,稍不留神就可能導致碰撞和剮蹭

-

停車場內行人往往隨意穿行,車輛需要更多的避讓動作

在這樣的場景下,簡單套用現有的軌跡預測模型難以達到理想的效果,而重新訓練模型又缺乏對應資料的支持。當下基於停車場景的資料集例如 CNRPark EXT 和 CARPK 等,都僅為空閒停車位偵測而設計,圖片來自提供監控相機第一人稱視角、取樣率低、且遮擋較多,無法用於軌跡預測。

在2022 年10 月剛結束的第25 屆IEEE 智慧交通系統國際會議(IEEE ITSC 2022) 中,來自#加州大學柏克萊分校的研究者發布了首個針對停車場景的高清視頻& 軌跡數據集,並在此數據集的基礎上,利用CNN 和Transformer 架構提出了名為“ParkPredict ” 的軌跡預測模型 。

- #論文連結:https://arxiv.org/abs/2204.10777

- 資料集主頁、試用和下載申請:https://sites.google.com/berkeley.edu/dlp-dataset (如無法訪問,可嘗試備用頁面https://www.php.cn/link/966eaa9527eb956f0dc8788132986707 )

- 數據集Python API:https://github.com/MPC- Berkeley/dlp-dataset

資料集資訊

資料集由無人機進行採集,總時長為3.5 小時,視訊分辨率為4K,取樣率25Hz。視野範圍涵蓋了約 140m x 80m 的停車場區域,共約 400 個停車位。資料集經過精確標註,共採集到 1216 輛機動車、3904 輛自行車和 3904 位行人的軌跡。

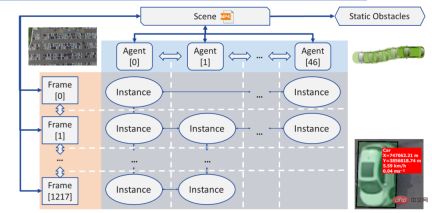

經過重新處理後,軌跡資料可以JSON 的形式讀取,並載入為連接圖(Graph)的資料結構:

- 個體(Agent):每個個體(Agent)即為一個在當前場景(Scene)下運動的物體,具備幾何形狀、類型等屬性,其運動軌跡被儲存為一個包含實例(Instance)的鍊錶(Linked List)

- 實例(Instance):每個實例(Instance)即為一個個體(Agent)在一幀(Frame)中的狀態,包含其位置、轉角、速度和加速度。每個實例都包含指向該個體在前一幀和後一幀下實例的指標

- #幀(Frame):每一幀(Frame)即為一個採樣點,其包含目前時間下所有可見的實例(Instance),和指向前一幀和後一幀的指針

- 障礙物(Obstacle):障礙物即為在此次記錄中完全沒有移動的物體,包含各個物體的位置、轉角和幾何尺寸

- 場景(Scene):每個場景(Scene)對應於一個錄製的視頻文件,其包含指針,指向該錄製的首幀和尾幀、所有個體(Agent)和所有障礙物(Obstacle)

資料集提供兩種下載格式:

僅JSON(建議):JSON 檔案包含所有個體的類型、形狀、軌跡等訊息,可以透過開源的Python API 直接讀取、預覽、並產生語意影像(Semantic Images)。如果研究目標僅為軌跡和行為預測,JSON 格式可以滿足所有的需求。

原始影片與標註:如果研究是基於相機原影像(Raw Image)的目標偵測、分隔、追蹤等機器視覺領域主題,那麼可能會需要下載原始影片和標註。如有此需要,需要在資料集申請中明確描述該研究需求。另外,標註文件需自行解析。

行為與軌跡預測模型:ParkPredict

作為應用範例,在IEEE ITSC 2022 的論文《ParkPredict : Multimodal Intent and Motion Prediction for Vehicles in Parking Lots with CNN and Transformer》中,研究團隊利用此資料集,基於CNN 和Transformer 架構實現了在停車場場景下車輛的意圖(Intent)和軌跡(Trajectory)預測。

團隊利用 CNN 模型,透過建構語意影像(Semantic Images),實現了對於車輛意圖(Intent)分佈機率的預測 。該模型僅需要建立車輛局部的環境訊息,且可根據當前環境,不斷變化可供選擇的意圖數量。

團隊透過改進Transformer 模型,將意圖(Intent)預測結果、車輛的運動歷史、週邊環境的語意圖作為輸入提供,實現了多模態(Multi-modal)的意圖和行為預測。

總結

- 作為首個針對泊車場景的高精度資料集,Dragon Lake Parking (DLP) 資料集可為該場景下大規模目標識別和追蹤、空閒車位偵測、車輛和行人的行為和軌跡預測、模仿學習等研究提供數據和API 支援

- 透過使用CNN 和Transformer 架構,ParkPredict 模型在泊車場景下的行為和軌跡預測中展現除了良好的能力

- Dragon Lake Parking (DLP) 資料集已開放試用和申請,可透過存取資料集主頁https://sites.google.com/ berkeley.edu/dlp-dataset 了解詳細資訊(如無法訪問,可嘗試備用頁面 #https://www.php.cn/link/966eaa9527eb956f0dc8788132986707 )

以上是柏克萊開源首個泊車場景下的高清資料集和預測模型,支援目標辨識、軌跡預測的詳細內容。更多資訊請關注PHP中文網其他相關文章!

使用AI代理創建個性化的新聞摘要Apr 12, 2025 am 11:18 AM

使用AI代理創建個性化的新聞摘要Apr 12, 2025 am 11:18 AM介紹 大語言模型(LLM)的功能正在迅速發展。它們使我們能夠構建各種LLM應用程序。這些範圍從任務自動化到工作流優化。一個令人興奮的應用程序是

美國AI政策從'安全”到'安全”急劇旋轉Apr 12, 2025 am 11:15 AM

美國AI政策從'安全”到'安全”急劇旋轉Apr 12, 2025 am 11:15 AM總統唐納德·特朗普(Donald Trump)在他的任期的第一天取消了前總統喬·拜登(Joe Biden)的AI行政命令(披露:我在拜登政府期間擔任國土安全部AI的高級顧問),副總統JD VA

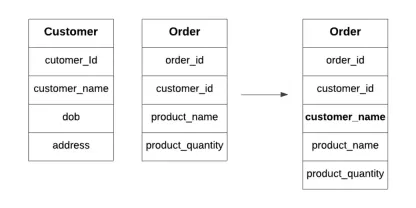

什麼是數據庫中的典型化?Apr 12, 2025 am 11:10 AM

什麼是數據庫中的典型化?Apr 12, 2025 am 11:10 AM介紹 想像一下,經營一個繁忙的咖啡館,其中每一秒鐘都很重要。您沒有不斷檢查單獨的庫存和訂單列表,而是將所有關鍵詳細信息整合到一個易於閱讀的板上。這類似於Denormaliza

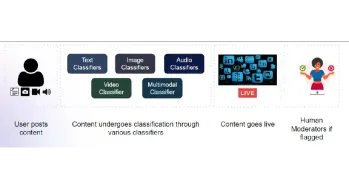

構建用於內容審核的多模式模型Apr 12, 2025 am 10:51 AM

構建用於內容審核的多模式模型Apr 12, 2025 am 10:51 AM介紹 想像一下,當一條進攻性帖子突然出現時,您正在瀏覽自己喜歡的社交媒體平台。在您點擊報告按鈕之前,它已經消失了。那是內容主音

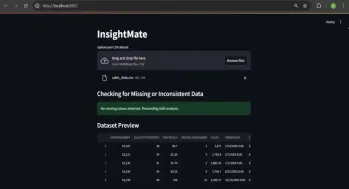

與洞察員自動化數據見解Apr 12, 2025 am 10:44 AM

與洞察員自動化數據見解Apr 12, 2025 am 10:44 AM介紹 在當今數據繁多的世界中,處理龐大的數據集可能會令人不知所措。這就是洞察力的來源。它旨在使探索您的數據變得輕而易舉。只需上傳您的數據集,您就會獲得Instan

什麼是補充代理? |入門指南-Analytics VidhyaApr 12, 2025 am 10:40 AM

什麼是補充代理? |入門指南-Analytics VidhyaApr 12, 2025 am 10:40 AM介紹 想像一下,開發與對話相同的應用程序。將沒有復雜的開發環境可以設置,也無需查看配置文件。將概念轉換為有價值的應用程序

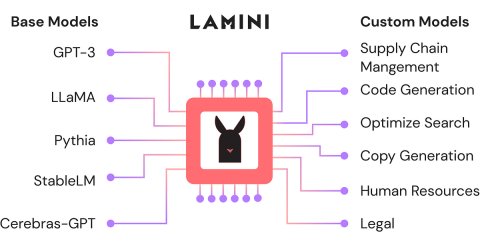

使用Lamini-Analytics Vidhya微調開源LLMApr 12, 2025 am 10:20 AM

使用Lamini-Analytics Vidhya微調開源LLMApr 12, 2025 am 10:20 AM最近,隨著大語言模型和AI的興起,我們看到了自然語言處理方面的無數進步。文本,代碼和圖像/視頻生成等域中的模型具有存檔的人類的推理和P

熱AI工具

Undresser.AI Undress

人工智慧驅動的應用程序,用於創建逼真的裸體照片

AI Clothes Remover

用於從照片中去除衣服的線上人工智慧工具。

Undress AI Tool

免費脫衣圖片

Clothoff.io

AI脫衣器

AI Hentai Generator

免費產生 AI 無盡。

熱門文章

熱工具

Atom編輯器mac版下載

最受歡迎的的開源編輯器

SecLists

SecLists是最終安全測試人員的伙伴。它是一個包含各種類型清單的集合,這些清單在安全評估過程中經常使用,而且都在一個地方。 SecLists透過方便地提供安全測試人員可能需要的所有列表,幫助提高安全測試的效率和生產力。清單類型包括使用者名稱、密碼、URL、模糊測試有效載荷、敏感資料模式、Web shell等等。測試人員只需將此儲存庫拉到新的測試機上,他就可以存取所需的每種類型的清單。

DVWA

Damn Vulnerable Web App (DVWA) 是一個PHP/MySQL的Web應用程序,非常容易受到攻擊。它的主要目標是成為安全專業人員在合法環境中測試自己的技能和工具的輔助工具,幫助Web開發人員更好地理解保護網路應用程式的過程,並幫助教師/學生在課堂環境中教授/學習Web應用程式安全性。 DVWA的目標是透過簡單直接的介面練習一些最常見的Web漏洞,難度各不相同。請注意,該軟體中

SublimeText3 Linux新版

SublimeText3 Linux最新版

EditPlus 中文破解版

體積小,語法高亮,不支援程式碼提示功能